- 学習可能なルーター(Learnable Router)がアテンション計算ごとにスパース/線形分岐を動的選択することで、固定ルールに依存していた従来手法の課題を解決

- 97%のアテンションスパース性を達成しながらVBenchスコアでフルアテンション(63.67)を上回る品質(66.64)を維持し、18.6倍の注意演算高速化と9.3倍のエンドツーエンド推論高速化を実現

- 量子化認識ファインチューニング(QAT)による低ビットアテンションの導入でさらなる精度劣化を抑制。ICML 2025採択論文でGitHubにコード公開済み

研究の背景

高品質なAI動画生成モデルは、数秒のクリップを生成するだけでも膨大な計算を必要とします。その計算の中核を担うのがアテンション機構(入力中の重要な位置に注目して情報を集約する仕組み)です。動画はフレーム数×解像度という巨大なシーケンス長を持つため、アテンション計算のコストは入力長の2乗に比例して爆発的に増大します。

この問題に対し、計算量を削減する手法としてスパースアテンション(重要な位置の組み合わせのみ計算する方式)と線形アテンション(行列近似で計算量を線形に抑える方式)を組み合わせたSLA(Sparse Linear Attention)が提案されていました。しかし従来のSLAはアテンション重みの大きさに基づく静的なヒューリスティック(経験則による固定ルール)で分岐先を割り当てており、モデルの状況に応じた柔軟な選択ができないという根本的な問題がありました。

また、近年注目される量子化(モデルの数値精度を下げてメモリや演算を節約する技術)をアテンション計算に適用しようとすると、精度劣化が生じやすいという課題もあります。UC BerkeleyとTsinghua University(清華大学)の共同チームは、これら2つの問題を同時に解決するSLA2を提案しました。

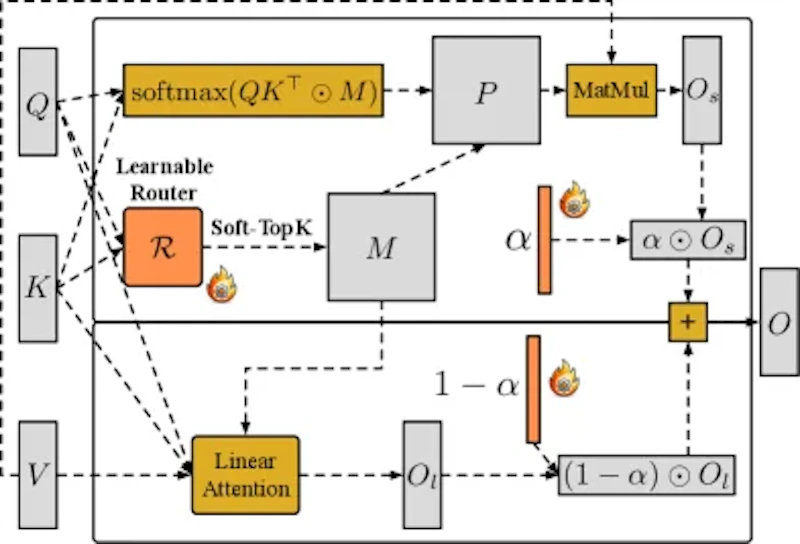

提案手法:SLA2のアーキテクチャ

SLA2の核心は3つのコンポーネントから構成されます。

① Learnable Router(学習可能なルーター)は、アテンションヘッドごとにスパース分岐と線形分岐のどちらを使うかを動的に決定します。入力のクエリとキーに平均プーリングを適用してから学習可能な投影層を通し、Top-k操作で上位k%のエントリを選択する設計です。重要なのは「ルーター自体が学習によって最適化される」点で、固定のヒューリスティックに依らず、タスクやモデルの状態に応じた最適な分岐選択が可能になります。

② 学習可能な重み付き統合では、スパース出力(Oₛ)と線形出力(Oₗ)を学習可能なベクトルαで動的に合成します。O = α⊙Oₛ + (1−α)⊙Oₗという形で、両分岐の寄与を柔軟に調整できる設計です。これにより従来のSLAが抱えていた「スパースアテンションと線形アテンションの分解が数学的に不一致」という問題を解消し、より整合性の高い近似が実現されます。

③ 量子化認識ファインチューニング(QAT)は、LLMの量子化で広く議論される量子化誤差を最小化するための工夫です。フォワードパスではクエリ・キー・バリューを低ビット精度に量子化して高速計算を行い、バックワードパスは完全なFP16精度で実行します。これにより学習中の勾配が正確に伝播し、量子化によるモデル性能の劣化を大幅に抑えることができます。

実験結果

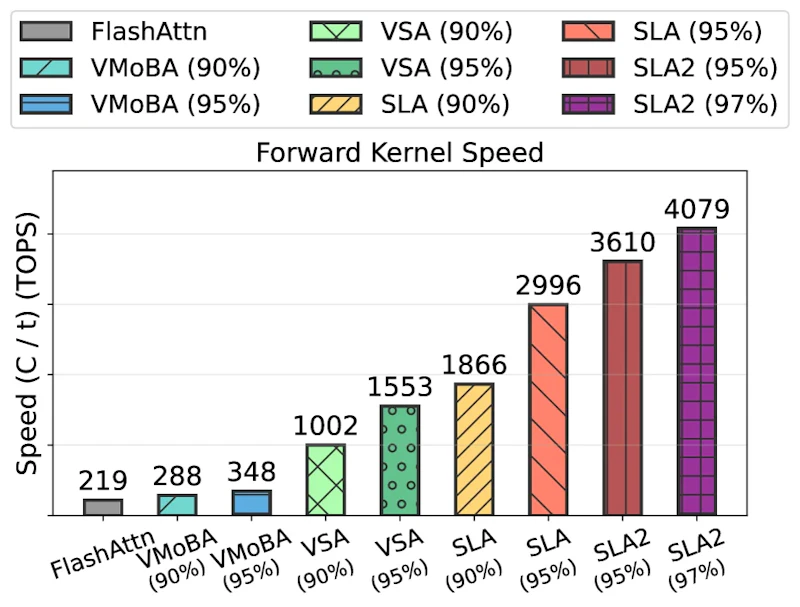

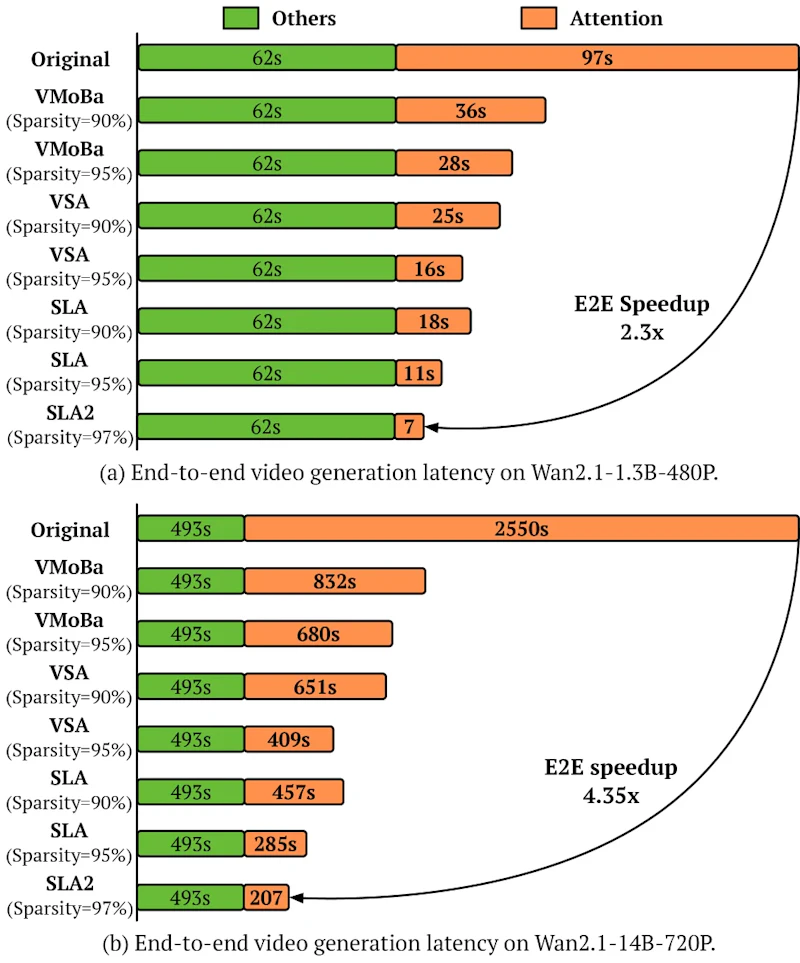

評価には動画生成モデルWan2.1の2バリアント(1.3B/480PおよびBI14B/720P)を用い、3,000本の動画データセットでファインチューニングを実施しました。比較対象はフルアテンション、SLA、VSA、VMoBAの4種類です。

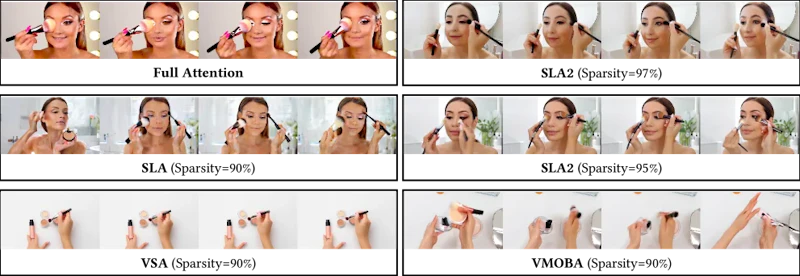

速度面では、97%のアテンションスパース性において18.6倍のアテンション演算高速化と9.3倍のエンドツーエンド推論高速化を達成しました。注目すべきは品質面で、97%という極端なスパース性にもかかわらず、VBenchのImaging Qualityスコアがフルアテンション(63.67)を上回る66.64を記録しています。さらにOverall Consistencyも20.27から21.42へと向上しており、単に高速化するだけでなく生成品質も改善されるという驚きの結果です。

アブレーション研究でも各コンポーネントの有効性が確認されています。Learnable Routerを固定Top-kルーターに置き換えるとAesthetic Qualityスコアが64.62から62.65に低下し、QATを外すと61.85まで落ちることが示されました。3つのコンポーネントがそれぞれ独立した貢献をしていることが実証されています。

まとめと今後の展望

SLA2は、ビデオ拡散モデルの実用化を妨げていた2つの障壁(スパースアテンションの静的ルール依存と量子化誤差)を学習ベースのアプローチで同時に解決した研究です。97%スパース性で品質を落とさず18.6倍の高速化を達成した結果は、より長尺・高解像度のビデオ生成や、リソース制約の大きい環境での高品質動画生成への道を開くものといえます。

一方で課題もあります。ファインチューニングにはWan2.1という特定のモデルを使用しており、他のアーキテクチャへの汎用性は今後の検証が必要です。また3,000本の学習データで十分かどうか、スパーシティと品質のトレードオフがより大規模なモデルでも同様に成立するかについても更なる研究が求められます。ICML 2025に採択されたこの研究は、GitHubでコードが公開されており、研究コミュニティによる検証・応用が期待されます。