- llama.cppの生みの親Georgi Gerganov氏とGGMLチームがHugging Faceに合流。プロジェクトの独立性・オープンソース方針は完全維持

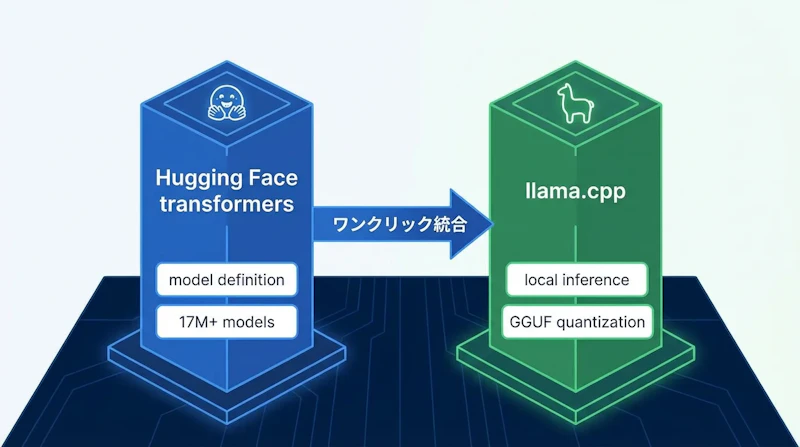

- transformers(HFのモデル定義標準)とllama.cpp(ローカル推論エンジン)を「天国のマッチ」として統合し、ワンクリックでのローカル実行を目指す

- HFが長期的なリソースを提供することで、コミュニティ主導のローカルAI推論エコシステムの持続可能性を確保

GGMLチームがHugging Faceに合流

2026年2月20日、Hugging Faceはローカル推論ライブラリllama.cppの作者であるGeorgi Gerganov氏と、その開発チーム(GGMLプロジェクト)が同社に参加したことを正式に発表した。llama.cppはCPU・GPUを問わず動作する高速な推論エンジンとして、開発者コミュニティで広く使われているオープンソースプロジェクトだ。

同発表でHugging Faceは、すでにllama.cppのコア貢献者であるXuan-Son Nguyen氏(ngxson)とAleksander Grygier氏(allozaur)が同社チームに在籍していることも明かした。Georgi氏の参加によって、llama.cppの中心的な開発者3名がHugging Face内で協力できる体制が整ったことになる。

「天国のマッチ」が意味するもの

Hugging Faceは今回の統合を 「match made in heaven(天国のマッチ)」 と表現している。その背景には、2つのプロジェクトが相互補完的な役割を担っている点がある。

- transformers: HFが開発するモデル定義の業界標準ライブラリ。1,700万以上のモデルが登録されるリポジトリ上でモデルの「信頼できる唯一の情報源」として機能する

- llama.cpp: C++で書かれた高速ローカル推論エンジン。CPU・GPUのリソースを最大限に活用し、量子化フォーマット(GGUFなど)でモデルをエッジデバイス上でも実行可能にする

現状ではtransformersで定義された最新モデルをllama.cppで実行するまでに、手動での変換・量子化作業が必要になる場面がある。今回の統合によって、この工程を大幅に簡略化し、最終的にはほぼワンクリックで新しいモデルをローカル環境で動かせるようにすることが目標として示された。量子化フォーマットの詳細についてはLLMの量子化とは?GPTQ・AWQ・GGUFの違いと選び方をわかりやすく解説も参照されたい。

オープンソース性と独立性は完全維持

コミュニティが最も気にしていた点、すなわち「買収によってllama.cppがクローズドになるのではないか」という懸念については、公式声明が明確に否定している。

声明では「Georgiおよびチームは引き続き100%の時間をllama.cppのメンテナンスに費やし、技術的方向性とコミュニティに関する完全な自律性とリーダーシップを持つ」と明記された。llama.cppは今後もMITライセンスのオープンソースプロジェクトとして維持される。HFが提供するのはリソースと長期的なサポートであり、プロジェクトの意思決定権はGergorgi氏チームに留まる。

ロードマップと今後の展開

統合によって実現が見込まれる具体的な改善点は3つある。第一に、transformersを「信頼できる唯一の情報源」として扱い、新しいモデルアーキテクチャをllama.cppへほぼ自動で取り込める仕組みの構築だ。第二に、GGMLベースのソフトウェアのパッケージング改善によって、開発者以外の一般ユーザーがローカルAIを簡単にデプロイできるようにする。第三に、クラウド推論と競合できる水準の推論スタック最適化を進め、llama.cppを「どこでも動く」インフラとして整備していく。

両組織の共同声明には「オープンソース超知能のビルディングブロックを世界中のコミュニティに提供する」という長期ビジョンが掲げられている。クラウドに依存しないローカル推論の重要性が増す中、その基盤を担うllama.cppの持続可能な開発体制が確立されたことは、開発者コミュニティにとって大きな意義を持つ。

コミュニティの反応

発表に対するコミュニティの反応は概ね好意的だ。llama.cppが単一の開発者に依存するプロジェクトから、組織的なサポートを受けた持続可能な体制へと移行することを歓迎する声が多い。一方で、過去のオープンソースプロジェクトがM&Aを経て方針転換した事例を引き合いに、長期的な独立性を懸念する意見も一部に存在する。

Georgi氏自身はこれまで単独で巨大なコードベースを維持してきた実績があり、今回の合流によってそのリソース的負担が軽減されることで、むしろ技術的な進化のペースが上がる可能性が高い。ローカルAI推論の標準として事実上機能しているllama.cppと、モデル配布のデファクトプラットフォームであるHugging Faceが一体となって動く体制は、オープンソースAIエコシステムにとって重要な一歩といえる。