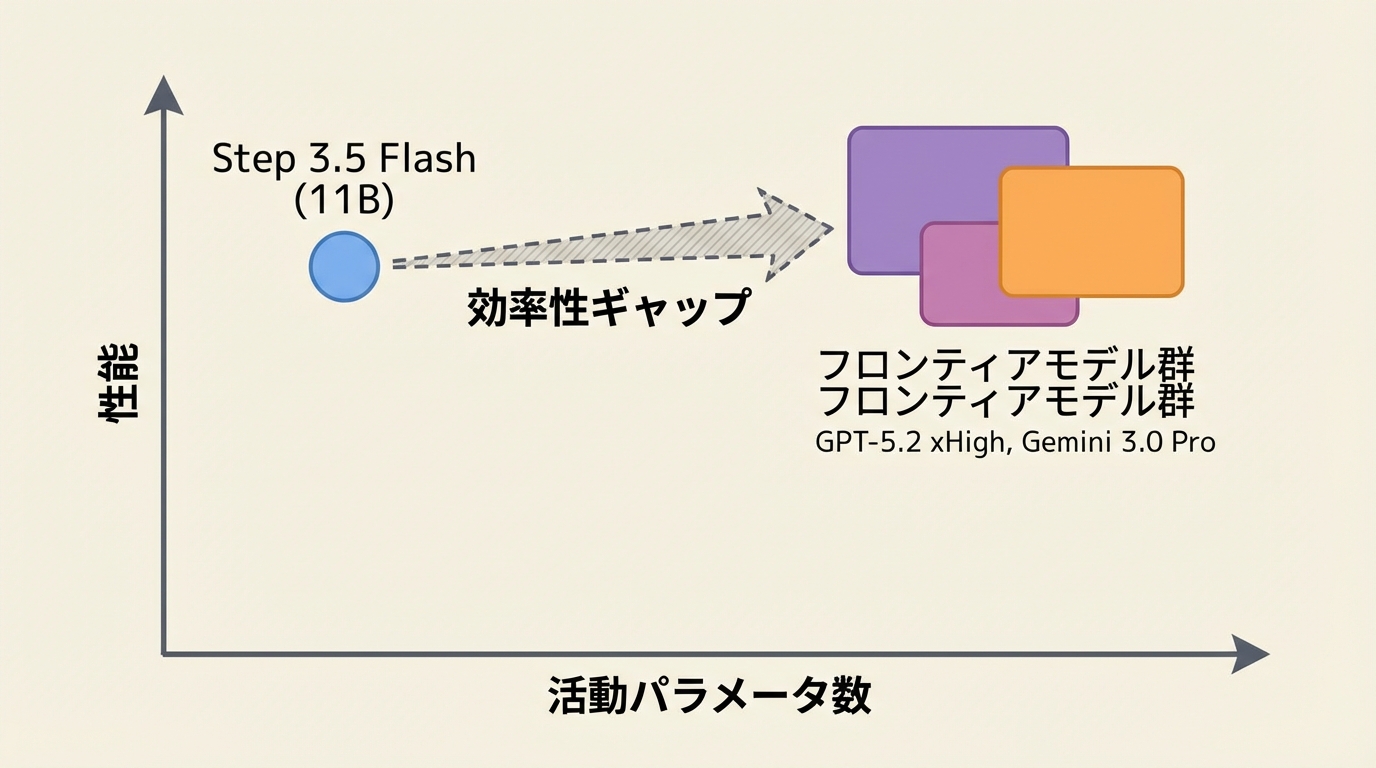

- 総パラメータ196Bのうち110億のみを推論時に使用するMixture-of-Experts設計で、GPT-5.2 xHighやGemini 3.0 Proに匹敵する性能を達成

- 強化学習と検証可能な信号を組み合わせた独自のフレームワークにより、数学・コーディング・ツール活用の各領域で高い推論能力を実現

- オープンモデルとして公開予定であり、産業利用可能なエージェント向けLLMとして大きな注目を集めている

研究の背景

大規模言語モデル(LLM)の能力は年々向上していますが、最先端の性能を実現するには通常、数千億から1兆を超えるパラメータが必要とされてきました。GPT-5.2やGemini 3.0 Proといったフロンティアモデルは極めて高い推論能力を持つ一方、その巨大なサイズが推論コストやデプロイの障壁となっています。

こうした課題に対し、Mixture-of-Experts(MoE、混合エキスパート)アーキテクチャが注目を集めています。MoEとは、多数の「専門家」ネットワークを用意しておき、入力に応じて一部の専門家だけを選択的に活性化する仕組みです。これにより、モデル全体の知識量を維持しながら、推論時の計算コストを大幅に削減できます。

Step 3.5 Flashは、まさにこのMoEアーキテクチャを活用し、フロンティアレベルの知能を効率的に実現することを目指した研究です。215名以上の研究者による大規模な共同プロジェクトとして2026年2月に発表され、HuggingFace Daily Papersで1,250票以上を獲得するなど、コミュニティから爆発的な反響を呼んでいます。

モデルアーキテクチャ

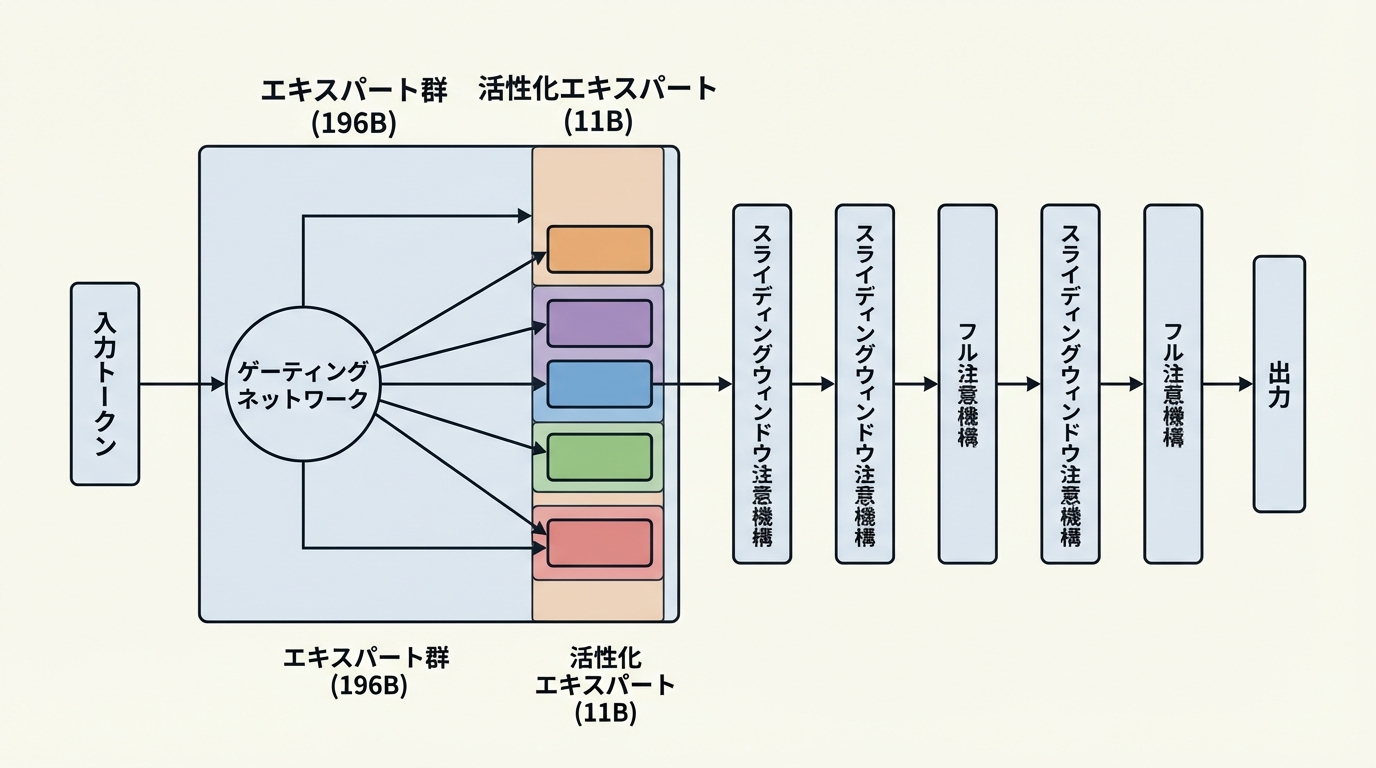

Step 3.5 Flashの最大の特徴は、総パラメータ数196B(約1,960億)という大規模な基盤を持ちながら、推論時に活性化するパラメータをわずか11B(約110億)に抑えたスパースMoE設計にあります。つまり、推論時にはモデル全体の約5.6%のパラメータしか使用しないため、計算コストが大幅に削減されます。

アテンション機構(入力の各部分間の関連性を計算する仕組み)には、スライディングウィンドウ注意とフル注意を3:1の比率で交互に配置するインターリーブ方式を採用しています。スライディングウィンドウ注意は近傍のトークンのみに注目することで計算効率を高め、フル注意は長距離の依存関係を捉える役割を担います。この組み合わせにより、効率性と表現力のバランスを実現しました。

さらに、Multi-Token Prediction(MTP-3)と呼ばれる手法も導入されています。これは一度に複数のトークンを予測する技術で、特にエージェント的なワークフロー(複数回のやり取りを伴うタスク)において、レイテンシの大幅な低減に貢献しています。

強化学習による推論能力の強化

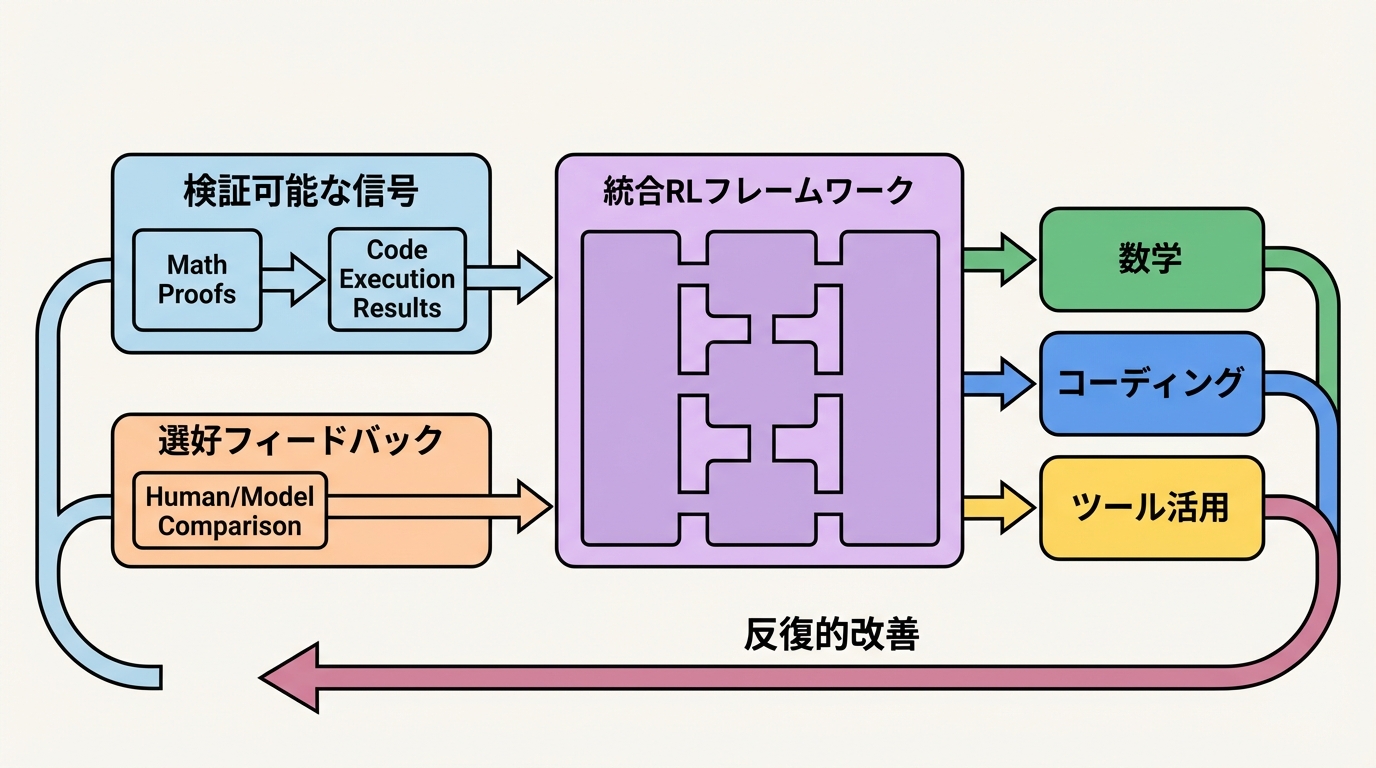

Step 3.5 Flashのもう一つの革新は、スケーラブルな強化学習(RL)フレームワークの設計です。このフレームワークは、2種類の学習信号を巧みに組み合わせています。

- 検証可能な信号(Verifiable Signals):数学の証明やコードの実行結果のように、正解かどうかを自動で検証できるフィードバック

- 選好フィードバック(Preference Feedback):人間やモデルによる応答品質の比較評価に基づくフィードバック

この2つの信号を統合することで、数学的推論、コーディング、ツール活用といった多様なドメインにおいて、反復的にモデルの能力を向上させることが可能になりました。特筆すべきは、大規模なオフポリシー学習(モデル自身が生成したデータではないデータからの学習)においても安定した訓練を実現している点です。

ベンチマーク結果

Step 3.5 Flashは、わずか110億の活動パラメータという制約にもかかわらず、複数の主要ベンチマークでフロンティアモデルに匹敵する成績を収めています。

ベンチマーク | スコア | 評価対象 |

|---|---|---|

IMO-AnswerBench | 85.4% | 数学オリンピックレベルの数学的推論 |

LiveCodeBench-v6 | 86.4% | 実践的なプログラミング問題解決 |

tau2-Bench | 88.2% | エージェント的タスク実行能力 |

BrowseComp | 69.0% | コンテキスト管理とブラウジング |

Terminal-Bench 2.0 | 51.0% | ターミナル操作タスク |

これらの結果は、GPT-5.2 xHighやGemini 3.0 Proといったフロンティアモデルと同等の水準と報告されています。特にtau2-Benchで88.2%という高いスコアを達成しており、複数ステップにわたるエージェント的なタスク実行において優れた能力を示しています。LiveCodeBench-v6での86.4%も印象的で、実用的なコーディングタスクへの高い適応力がうかがえます。

エージェント用途への最適化

Step 3.5 Flashの設計思想には、「鋭い推論と、速く信頼性の高い実行」という明確なビジョンがあります。近年、LLMをツールとして活用し、複数のステップを自律的に実行する「エージェント」的な利用が急速に広がっていますが、このモデルはまさにそうしたユースケースを主要ターゲットとしています。

MTP-3によるマルチトークン予測は、エージェントワークフローにおける複数回のやり取りでレイテンシを削減し、スライディングウィンドウ注意機構は長い対話コンテキストの効率的な処理を可能にします。これらの設計上の工夫が組み合わさることで、産業環境でのデプロイに適した実用的なモデルとなっています。

まとめと今後の展望

Step 3.5 Flashは、スパースMoEアーキテクチャと革新的な強化学習フレームワークの組み合わせにより、110億の活動パラメータでフロンティアレベルの性能を達成した画期的なモデルです。オープンモデルとしての公開が予定されており、研究者や開発者が実際に利用できる形でフロンティア級の能力が民主化される可能性を秘めています。

一方で、いくつかの留意点もあります。総パラメータ数は196Bと依然として大きいため、モデル全体のメモリフットプリントは軽量とは言い切れません。また、BrowseCompやTerminal-Bench 2.0のスコアにはまだ改善の余地があり、特定のタスクではフロンティアモデルとの差が残る可能性もあるでしょう。

それでも、活動パラメータ数を劇的に削減しながらトップクラスの性能を維持するというアプローチは、今後のLLM開発における重要な方向性を示しています。計算効率と性能の両立は、LLMの広範な社会実装に向けた最大の課題の一つであり、Step 3.5 Flashの成果はその解決への大きな一歩と言えるでしょう。