- AWSが新推論エンジン「Project Mantle」を発表し、DeepSeek V3.2やQwen3 Coder Nextなど6つのオープンウェイトモデルに対応

- 開発者はAWSのインフラ上で多様なオープンウェイトモデルを統一的に利用可能になり、モデル選択の自由度が向上

- 主要クラウドプラットフォームによるオープンモデル対応の拡大は、AI開発の民主化をさらに加速させる

Project Mantleとは何か

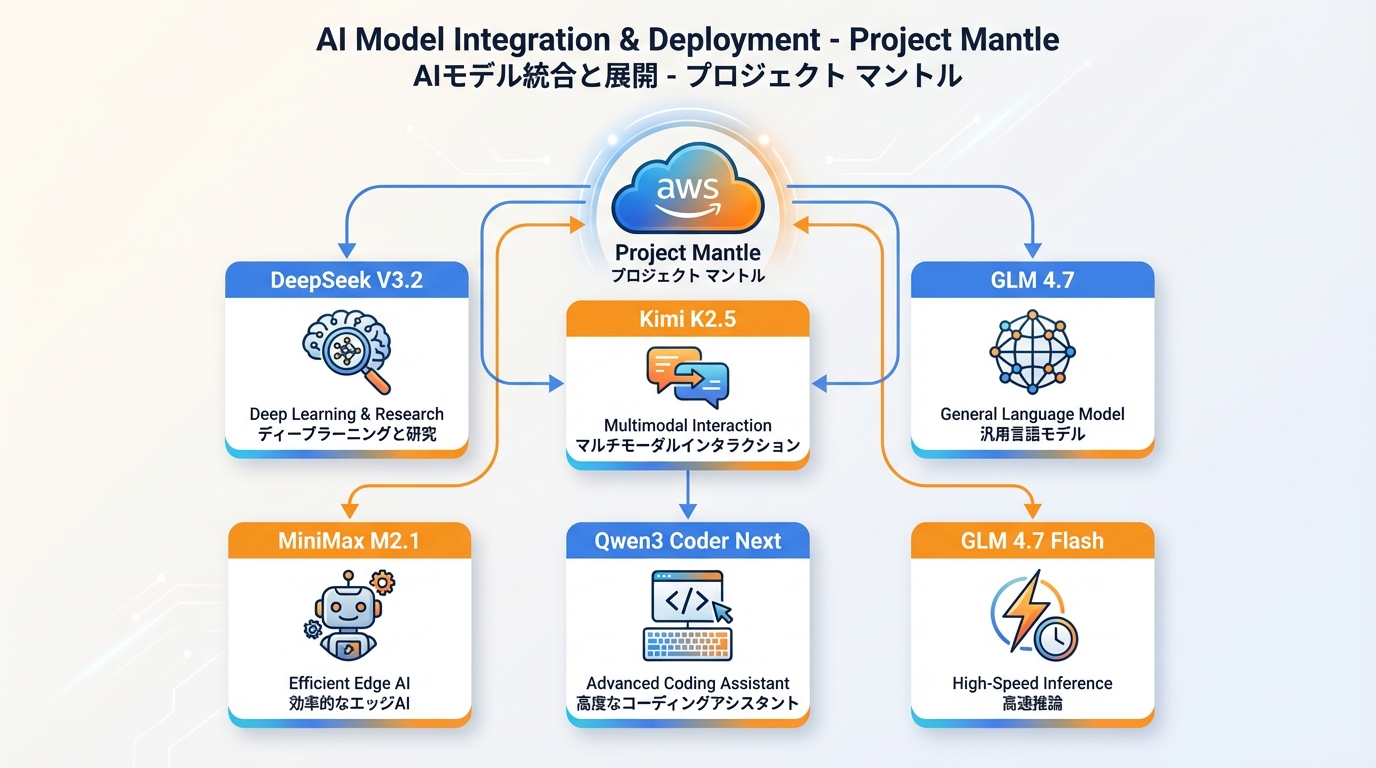

AWSは2月10日、新たな推論エンジン「Project Mantle」を発表しました。Project Mantleは、オープンウェイトモデル(重みが公開されたAIモデル)をAWSのクラウドインフラ上で効率的に実行するための基盤技術です。今回の発表では、DeepSeek V3.2、Kimi K2.5、GLM 4.7、MiniMax M2.1、Qwen3 Coder Next、GLM 4.7 Flashの6モデルがサポート対象として明らかにされました。

これまでAWSのAIサービスであるAmazon Bedrockでは、Anthropic ClaudeやMeta Llamaといった主要モデルを提供してきました。Project Mantleの導入により、アジア発を含む多様なオープンウェイトモデルへのアクセスが大幅に拡大することになります。開発者は自社のユースケースに最適なモデルを、統一されたインフラ上で比較・選択できるようになるでしょう。

サポートされる6つのモデルの特徴

今回対応が発表された6モデルは、それぞれ異なる強みを持っています。

- DeepSeek V3.2 — 中国のDeepSeek社が開発した大規模言語モデル。コーディングや数学的推論で高い性能を示し、オープンウェイトモデルの中でもトップクラスの評価を受けている

- Kimi K2.5 — Moonshot AI(月之暗面)が開発。長文脈処理に強みを持ち、大量のドキュメント解析やナレッジベース構築に適している

- GLM 4.7 / GLM 4.7 Flash — 清華大学発のZhipu AI(智譜AI)が開発するGLMシリーズの最新版。Flashは軽量・高速版で、レイテンシを重視するアプリケーション向け

- MiniMax M2.1 — MiniMax社が開発した多目的モデル。テキスト生成に加え、マルチモーダル処理にも対応

- Qwen3 Coder Next — Alibaba Cloud(阿里雲)が開発するQwenシリーズのコーディング特化版。ソフトウェア開発支援やコード生成で実用的な成果を出している

注目すべきは、これらのモデルの多くがアジア圏の企業・研究機関から生まれている点です。AWSがこれらを公式にサポートすることで、グローバルな開発者がこれらのモデルにアクセスしやすくなります。

クラウド各社のオープンモデル対応競争

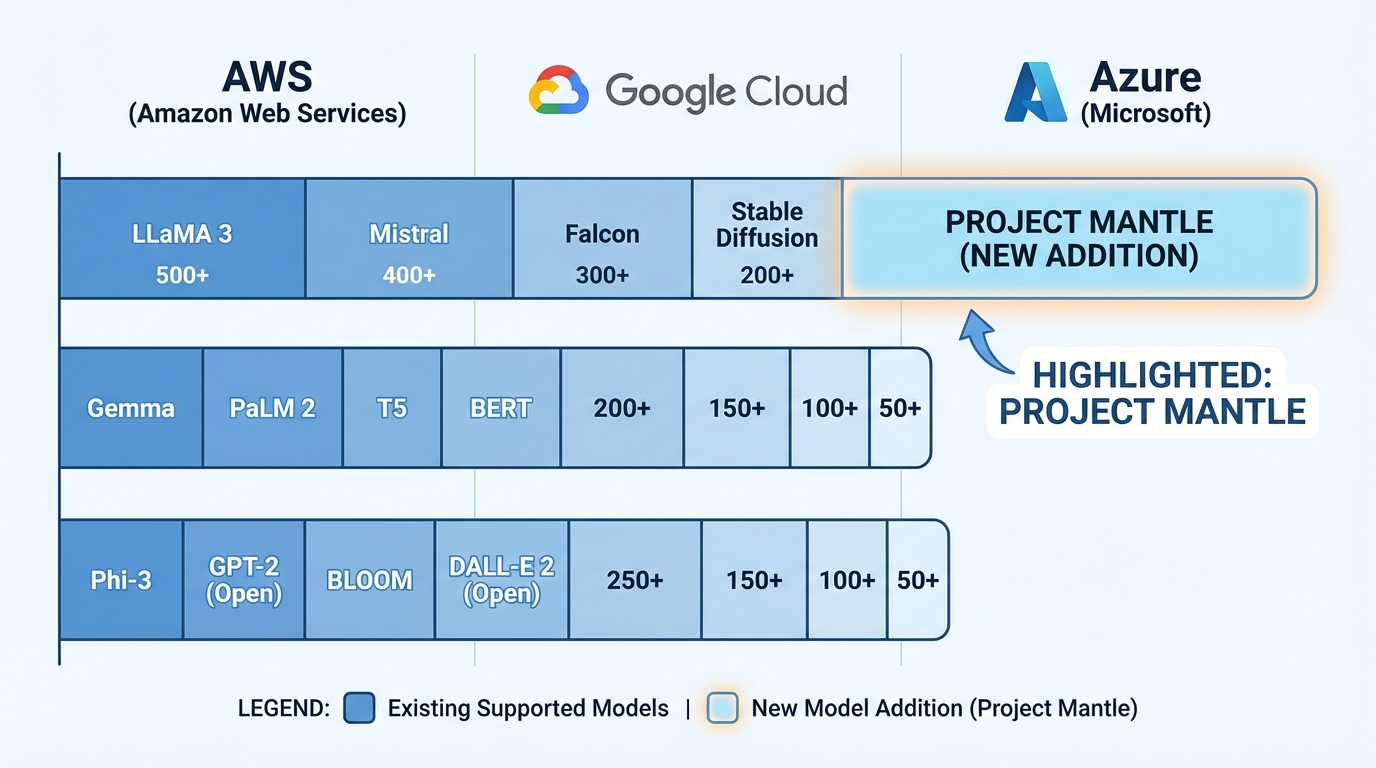

Project Mantleの発表は、クラウドプラットフォーム間でのオープンウェイトモデル対応競争が激化している背景を映し出しています。Google CloudはVertex AI Model Gardenで多数のオープンモデルを提供し、Microsoft AzureもAzure AI Model Catalogを通じて幅広いモデルへのアクセスを実現してきました。AWSは今回のProject Mantleにより、この競争に本格的に参入した形です。

開発者にとっては、モデルの選択肢が増えること自体が大きなメリットとなります。用途に応じて最適なモデルを選べるだけでなく、特定のベンダーへの依存を避けるマルチモデル戦略を取りやすくなるためです。たとえばコーディング支援にはQwen3 Coder Nextを、長文処理にはKimi K2.5を、低レイテンシが求められる場面ではGLM 4.7 Flashを使うといった使い分けが可能になります。

AI開発の民主化への影響

オープンウェイトモデルの最大の利点は、開発者が自由にモデルを検証・カスタマイズできる点にあります。プロプライエタリモデル(商用非公開モデル)ではブラックボックスとなる内部構造が透明であるため、ファインチューニングや特定ドメインへの適応がしやすくなります。

一方で、オープンウェイトモデルを実運用するには高性能なGPUインフラが必要であり、個人開発者や中小企業にとってはハードルが高いという課題がありました。AWSのProject Mantleのようなマネージド推論エンジンは、こうしたインフラの壁を取り除く役割を果たします。開発者はインフラの構築・運用を意識することなく、モデルの性能評価やアプリケーション開発に集中できるようになるでしょう。

今回のAWSの動きは、オープンウェイトモデルのエコシステムが成熟期に入りつつあることを示しています。モデル開発者がオープンに重みを公開し、クラウドプラットフォームがそれを効率的に提供し、開発者がビジネスに活用する——この循環が加速することで、AI技術の恩恵がより幅広い開発者に届くことが期待されます。