- AnthropicのClaude Sonnet 5がSWE-Benchで82.1%を記録し、コーディングベンチマークの最高スコアを更新

- OpenAIはGPT-5.3 Codexを発表し、前世代比25%の高速化とエージェンティック機能を強化

- OpenAIが初めてサイバーセキュリティリスクを「High」に分類し、AI安全性の議論に新たな一石を投じた

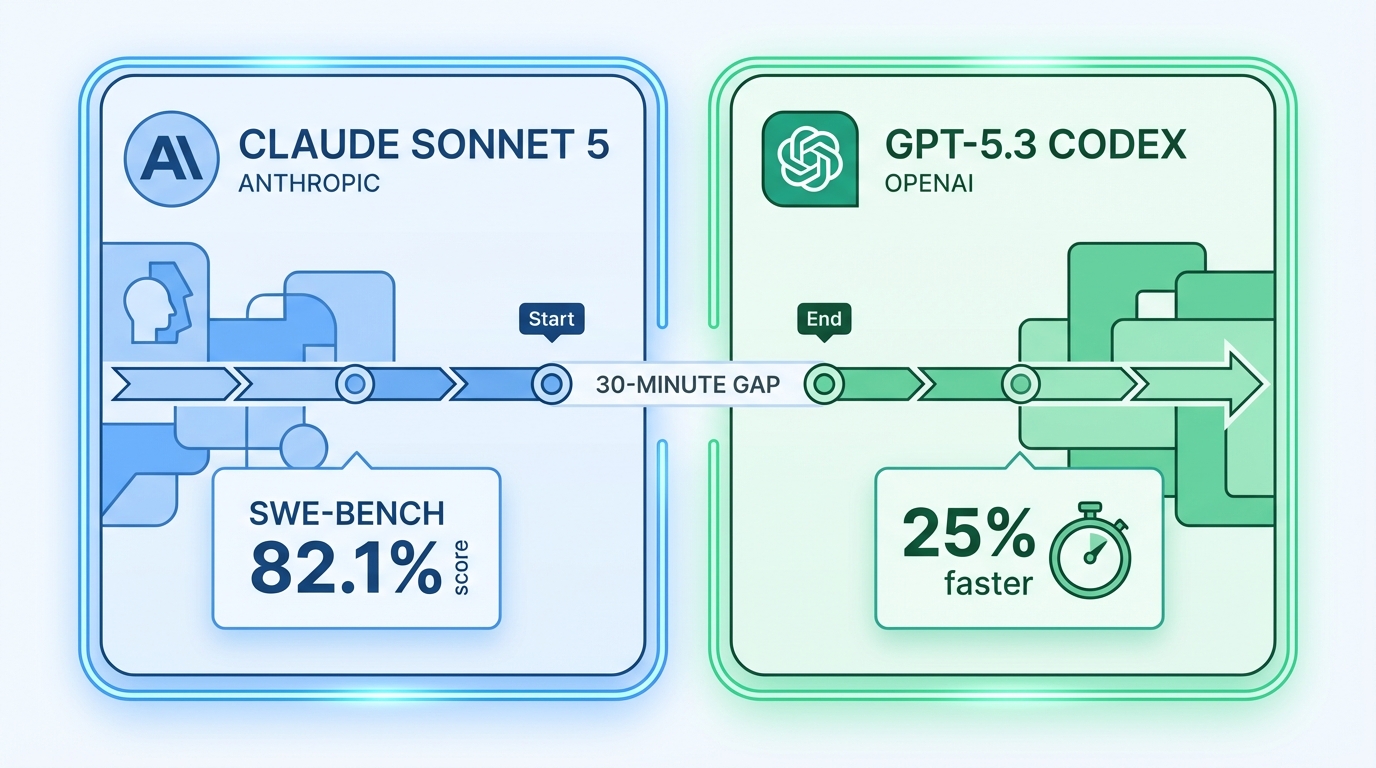

30分差の同時発表が示すAI競争の現在地

2026年2月3日から5日にかけて、AI業界の二大勢力であるAnthropicとOpenAIが、わずか30分差で次世代コーディング特化AIモデルを相次いで発表しました。TechCrunchの報道によれば、OpenAIの新モデルはAnthropicの発表直後にリリースされたもので、両社の激しい競争を象徴する出来事となっています。

Anthropicが発表したClaude Sonnet 5は、ソフトウェアエンジニアリングの自動化能力を測るベンチマーク「SWE-Bench」で82.1%という記録的なスコアを達成しました。SWE-Benchは、GitHubの実際のイシューを解決する能力を評価する指標で、実用的なコーディング性能を反映するものとして開発者コミュニティで広く参照されています。

一方、OpenAIはGPT-5.3 Codexを発表しました。同社が今週初めにリリースしたエージェンティックコーディングツール「Codex」の性能を加速させることを目的としたモデルで、前世代と比較して25%の推論速度向上を実現したとされています。

エージェンティックAIへの注力

両社のモデルに共通するのは、「エージェンティック」な能力への強い注力です。エージェンティックAIとは、単にコードを生成するだけでなく、開発環境を操作し、テストを実行し、バグを修正するといった一連の作業を自律的に遂行できるAIを指します。

OpenAIのCodexは、リポジトリ全体を理解した上でコード変更を提案し、プルリクエストの作成まで自動で行う機能を備えています。GPT-5.3はこのCodexの基盤モデルとして、より高速かつ正確な推論を実現することで、開発ワークフロー全体の効率化を目指しています。

AnthropicのClaude Sonnet 5も同様に、複雑なソフトウェアエンジニアリングタスクの自動化に焦点を当てています。SWE-Benchでの82.1%というスコアは、実際のGitHubイシューの約5件中4件以上を正しく解決できることを意味しており、実務レベルでの活用が視野に入る水準といえるでしょう。

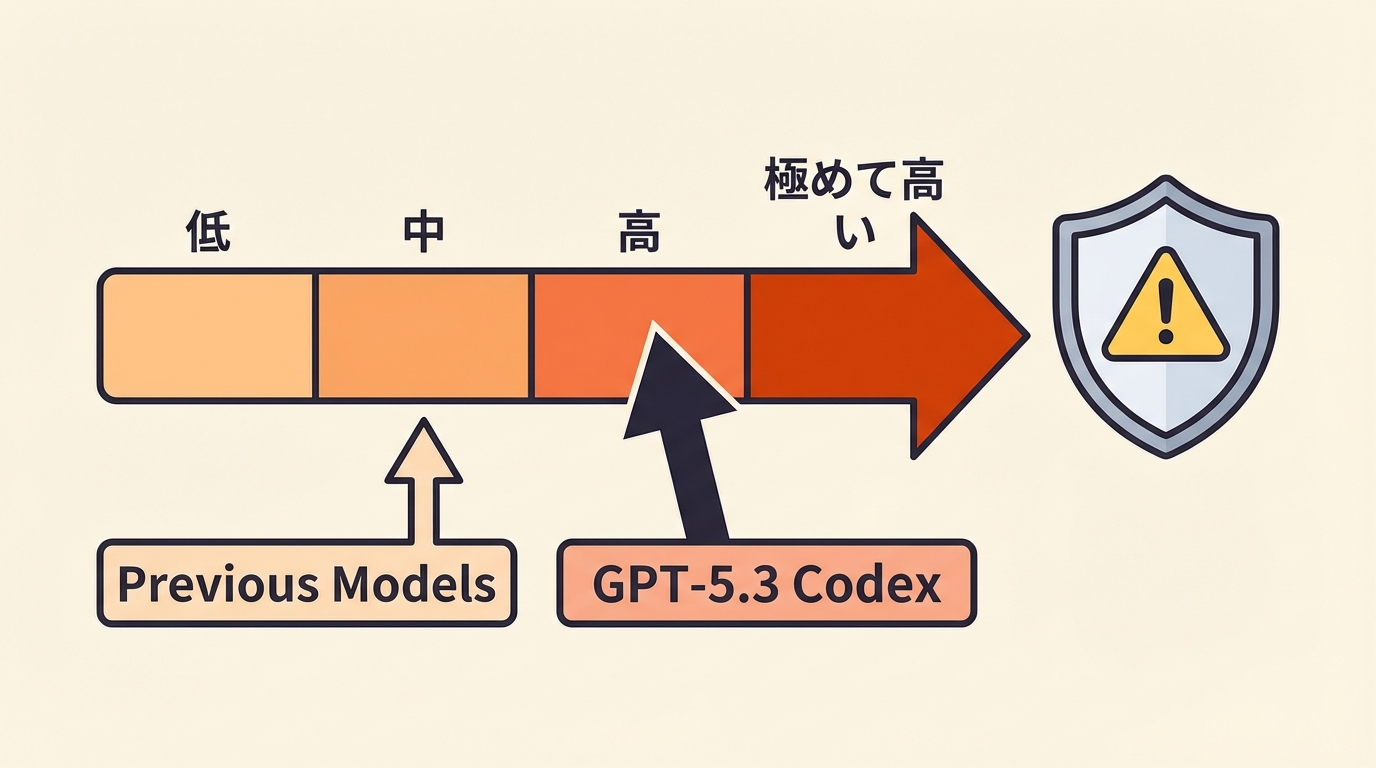

OpenAIが初適用した「High」リスク分類の意味

今回の発表で注目すべきもう一つのポイントは、OpenAIがGPT-5.3に対して初めてサイバーセキュリティリスクを「High」に分類したことです。これは同社の安全性評価フレームワークにおいて、モデルがサイバー攻撃に悪用される可能性について高いリスクがあると判断したことを示しています。

従来、OpenAIのモデルは「Medium」以下のリスク分類にとどまっていました。今回の「High」分類は、モデルのコーディング能力が向上するほど、脆弱性の発見やエクスプロイトコードの生成といった悪用リスクも高まるというトレードオフを、同社が正面から認めた形です。

この分類自体はモデルのリリースを阻止するものではありませんが、追加の安全対策が講じられていることを意味します。AIモデルの能力向上と安全性確保のバランスは、業界全体が今後も向き合い続ける課題となるでしょう。

開発者コミュニティへの影響と今後の展望

両社の競合リリースは、AIコーディングアシスタント市場の成熟と競争激化を如実に物語っています。GitHub Copilot、Cursor、Clineといったツールが普及する中、基盤モデルの性能差がそのまま開発者体験の差につながる時代に突入しました。

開発者にとっての実質的な影響は以下の通りです。

- コーディングAIの選択肢が増え、用途に応じた使い分けが可能になる

- ベンチマークスコアの向上により、より複雑なタスクの自動化が現実的になる

- エージェンティック機能の進化で、AIが開発プロセスのより広い範囲をカバーする

- 安全性に関する透明性が向上し、リスクを理解した上での活用判断ができる

30分差という劇的なタイミングでの競合リリースは偶然ではないでしょう。両社がともに相手の動向を注視し、市場のリーダーシップを争っていることは明らかです。今後もコーディングAI分野では急速な進化が続くと見られ、開発者の生産性向上に直結する技術革新が加速していくことが予想されます。