- Mixture-of-Expertsモデルの専門家間の負荷を均等化するLoad-balancing Lossを提案

- LBLがトークンの専門家利用を均等にし、モデルの性能とリソース分配を改善

- 実験でLBLがモデル性能を向上させ、効率的な学習プロセスを実現

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

この論文では、Mixture-of-Experts (MoE) モデルの学習における「Load-balancing Loss (LBL)」を提案し、その有効性を検証しています。MoEモデルは、大規模な言語モデルにおいて計算効率を向上させるために設計されていますが、専門家(experts)の使用に偏りが生じることでパフォーマンスの低下が問題となります。LBLは、このバランスの欠如を是正するため、各専門家の負荷を均等化する正則化目的関数を導入します。

具体的には、LBLは各トークンがすべての専門家を均等に利用するよう促すことで、特殊な専門家への負荷の集中を抑制します。LBLは、トークンごとの専門家使用頻度を平坦化することで専門家間の効率的なリソース分配を実現し、モデル性能を引き上げます。また、LBLの計算を効率化するため、「Global-Each Method」という新しい手法が提案されており、通信や計算コストを削減しながらも同等の効果を得ることができます。

実験では、LBLの有無や様々なバランス設定に基づいて、モデルの学習性能を評価しました。その結果、LBLを導入した場合、タスクにおけるモデル性能が著しく向上し、トレーニングプロセスも効率的になることが確認されました。また、専門家によるトークン処理傾向のばらつきが小さくなり、各専門家がより均等に使われるようになったことが示されました。

さらに、LBLによって専門家の特殊化が進み、モデルの表現力も向上したことが観察されました。この研究は、MoEモデルにおける計算効率を高めるだけでなく、タスク性能の向上と学習の安定性を両立させる可能性を示しています。

図表の解説

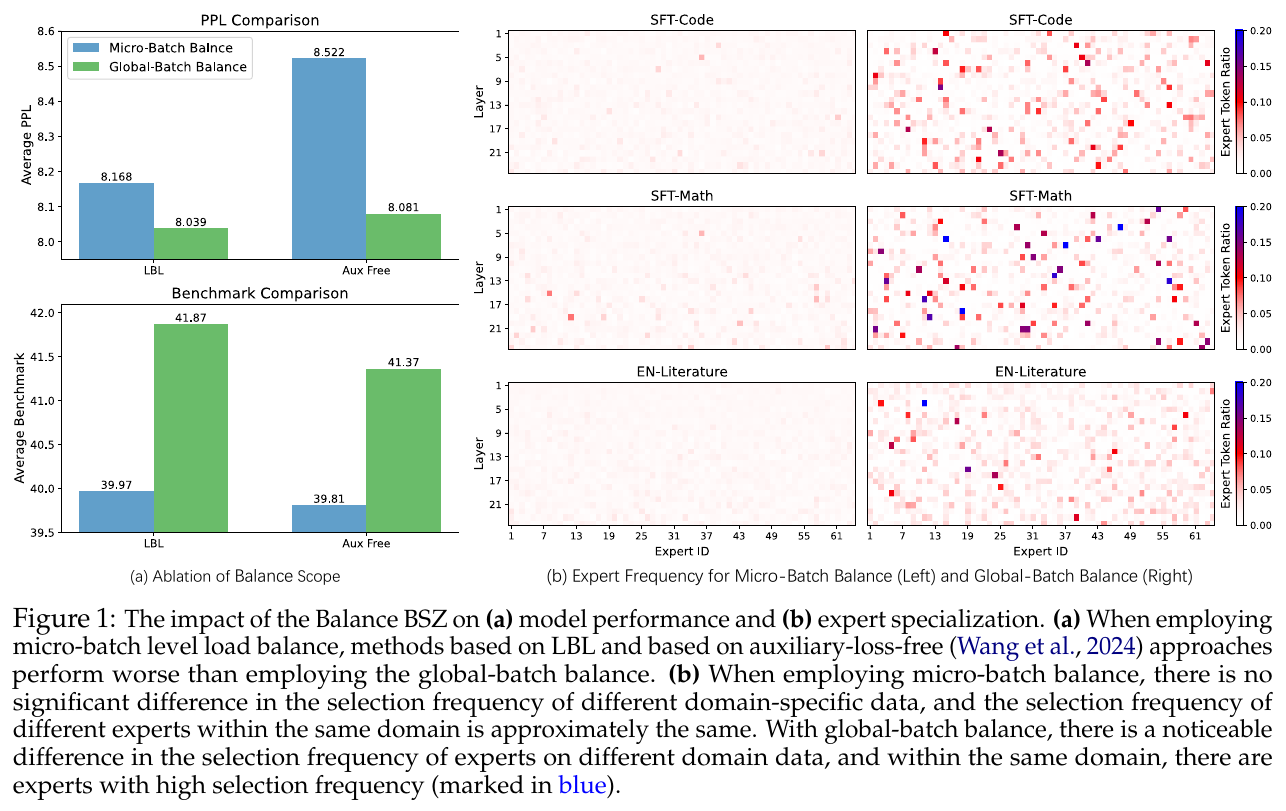

この画像は論文におけるバッチサイズの効果に関する実験結果を示しています。 左側は「PPL Comparison」と「Benchmark Comparison」で、それぞれモデル性能の違いを表しています。マイクロバッチのバランス(青い棒)は、グローバルバッチのバランス(緑の棒)より性能が劣っていることが分かります。 右側では、「SFT-Code」「SFT-Math」「EN-Literature」といったデータドメインにおける専門家(エキスパート)の選択頻度を示しています。マイクロバッチのバランス(左側の図)では専門家の選択頻度に大きな違いはありませんが、グローバルバッチのバランス(右側の図)では特定の専門家が頻繁に選ばれる傾向が見られます(青で示されています)。この結果から、グローバルバッチのバランスが専門家の専門性を高める助けとなることが示されています。

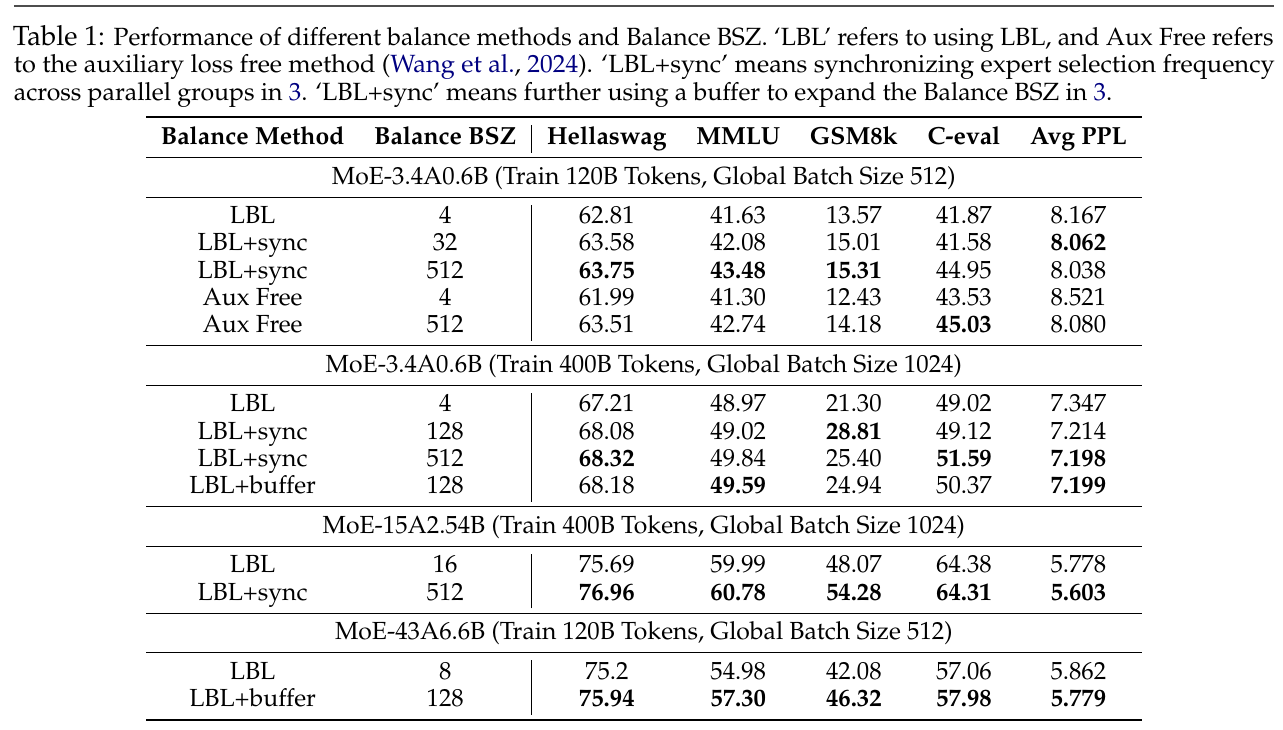

この図は、異なるバランス方法によるモデルの性能を示しています。MoEモデルを訓練する際の「負荷分散損失(LBL)」の使用方法がテーマです。表は様々なバランス方法を取り上げ、LLaMAなどのモデルでのパフォーマンスを、「Hellaswag」「MMLU」などのタスクで比較しています。 「LBL」は従来の方法で、「LBL+sync」はエキスパートの選択頻度を同期させる方法、「Aux Free」は補助損失を使わない方法です。結果から見ると、エキスパートの同期を行う「LBL+sync」は他の方法と比べてより良いパフォーマンスを発揮し、特に大きなバランスサイズ(Balance BSZ)でその効果が顕著です。 つまり、エキスパート間での同期がモデルの専門化や性能向上に貢献することが示されています。

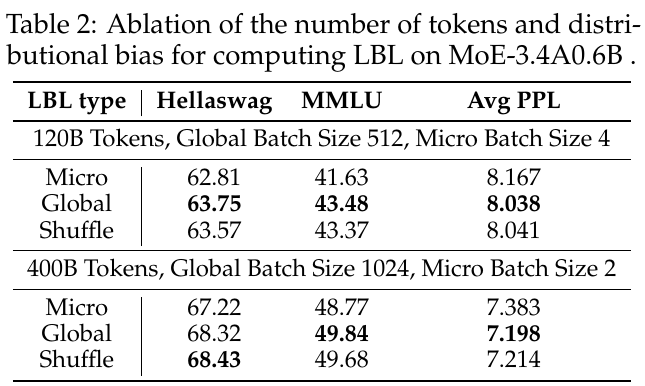

この表は、MoE-3.4A0.6BモデルでのLBL(負荷分散損失)を計算する際に、トークン数と分布バイアスの影響を検証した結果を示しています。具体的には、LBLの計算方法を微視的(Micro)、全体的(Global)、およびシャッフル(Shuffle)の3つに分けて比較しています。 上段は120Bトークン、下段は400Bトークンでモデルをトレーニングした場合です。全体的に、グローバルLBLで計算した場合のほうが、モデルの平均パープレキシティ(Avg PPL)が低く、性能が向上していることがわかります。この結果は、グローバルバッチでのLBL計算が専門性を向上させることを示唆しており、より多様なトークンを活用することで、専門家(エキスパート)の効果的な利用が可能となることを示しています。

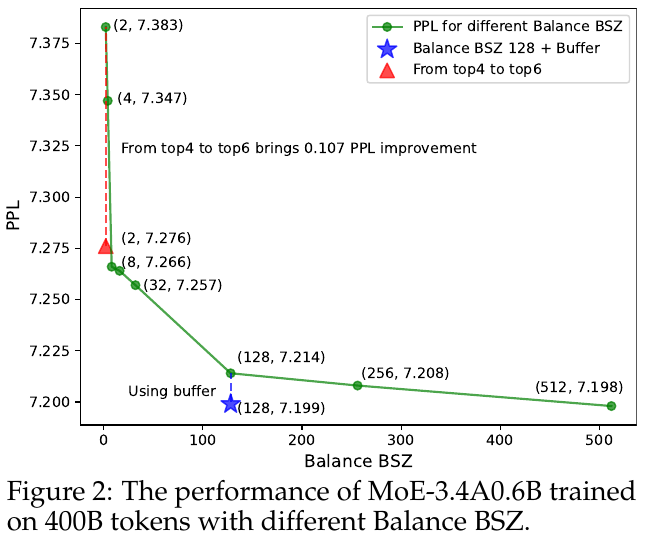

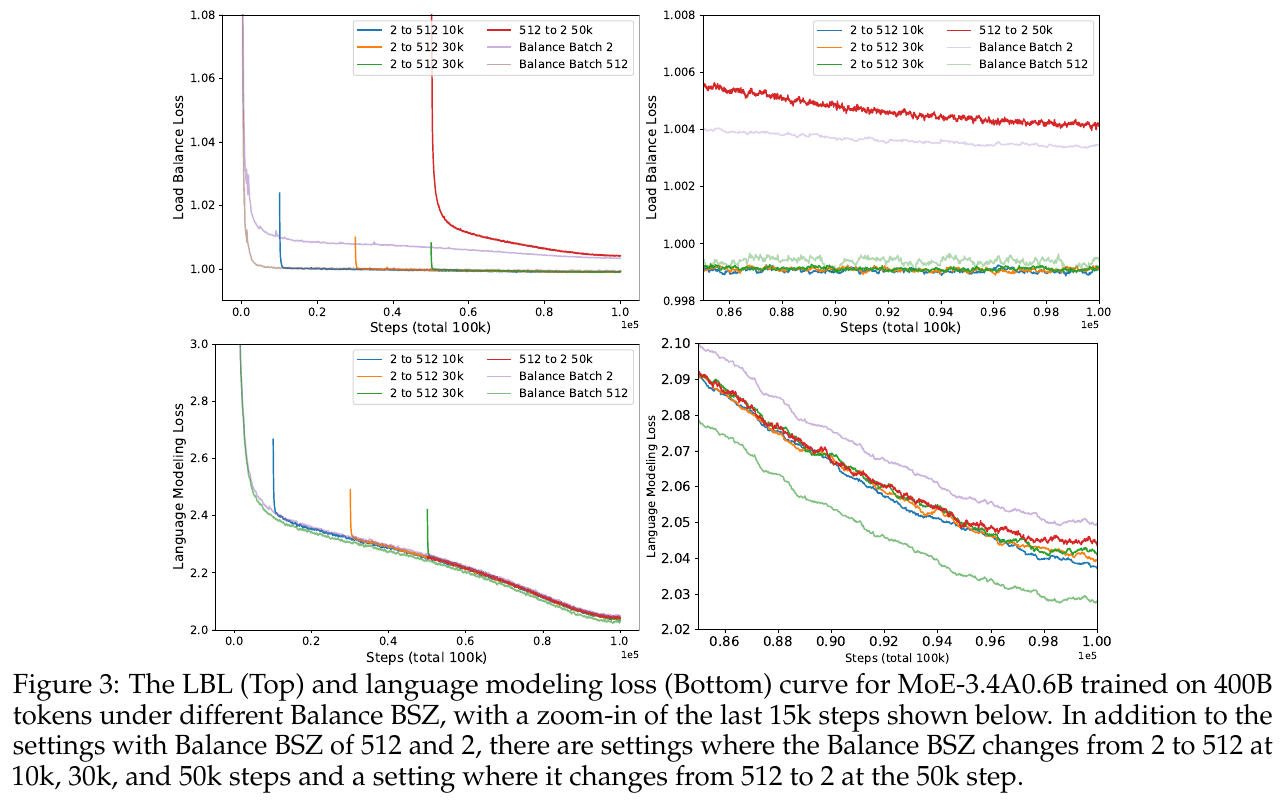

図2は、異なるバランスBSZ(バッチサイズ)でMoE-3.4A0.6Bモデルを400Bトークン上で訓練した際の性能を示しています。縦軸がPPL(Perplexity)、横軸がバランスBSZを表しています。PPLは言語モデルの性能を評価する指標で、値が低いほど良い性能を示します。図では、バランスBSZが増加するにつれてPPLが減少していることがわかります。これは、より大きなバランスBSZがより効果的な専門家選択(ドメイン特化)を促進し、モデル性能を向上させることを示しています。また、バランスBSZ128を使用してバッファを加えることで、さらにPPLが改善されています。

この画像は、訓練中にBalance BSZ(バッチサイズ)を変更した際の言語モデルのパープレキシティ(PPL)の変化を示しています。表では、最初に使用するバッチサイズを2から512に切り替えるタイミング(ステップ数)とその結果のPPLが記載されています。 バッチサイズ2ではPPLが7.383ですが、512では最も低い7.199で、最も効率的です。バッチサイズを途中で変更する場合、早い段階で変更するとPPLが低くなる傾向があります。具体的にバッチサイズを10kステップで変更した場合、PPLは7.283と改善されます。全体的に、より大きなバッチサイズがモデルのパフォーマンスを向上させることが示されています。

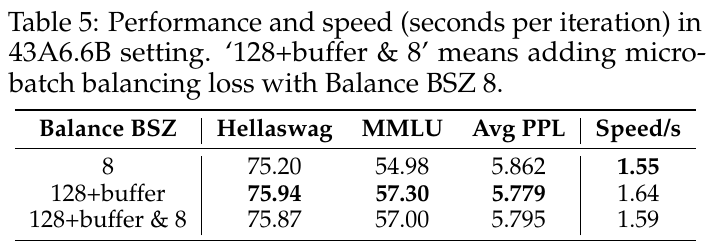

この図は、Mixture-of-Experts (MoE) モデルの学習におけるロードバランスロス (LBL) と言語モデリングロスの変化を示しています。左の上部と下部の図は、4000億トークンを使って学習した際のステップ数ごとのロスの減少を表しており、異なるバランス設定での挙動を示しています。右側のズームインした部分では、最終15,000ステップでの詳細な変化が示されています。「2から512」や「512から2」といった設定は、バランスを調整するタイミングを示しており、これにより単語やトークンがどのように専門化されるかが大きく影響されることがわかります。グローバルバッチでのバランス調整がより良い結果をもたらすことが示されています。

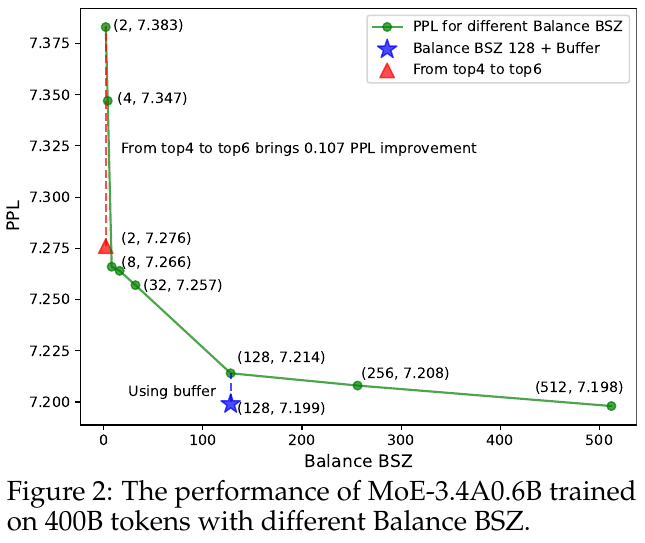

この表は、MoEモデルにおける「43A6.6B設定」において、異なるバランスBSZのパフォーマンスと速度を示しています。「128+buffer & 8」は、マイクロバッチバランシング損失を追加した設定を意味します。 表を見ると、バランスBSZを増やすとHellawagとMMLUのスコアが改善される一方で、平均PPL(予測を評価する指標)も減少します。速度は、グローバルバッチバランスを導入するとわずかに遅くなりますが、パフォーマンス的には向上します。具体的には、128+buffer設定はバランスBSZ 8の設定よりもわずかに遅いですが、全体の性能はより高く保たれています。このことは、モデルの専門化と性能向上において、グローバルバッチバランスが有効であることを示しています。

この図は、MoE(Mixture-of-Experts)モデルの性能を示しています。特に、パラメータ「Balance BSZ」によるPPL(Perplexity)の変化を分析しています。横軸はBalance BSZ(バランスバッチサイズ)を示し、縦軸はPPLを示します。 図によると、Balance BSZが増加するにつれて、PPLが低下し、モデルの性能が向上していることがわかります。特に、128のBalance BSZにバッファを追加することで、PPLが7.199まで下がっています。さらに、トップ4の専門家からトップ6に切り替えると、PPLが0.107の改善を見せています。 このデータは、バランスの取れた専門家の利用がモデル性能に如何に影響するかを示しており、より多くの専門家を活用することが専門性と精度の向上につながることを示しています。