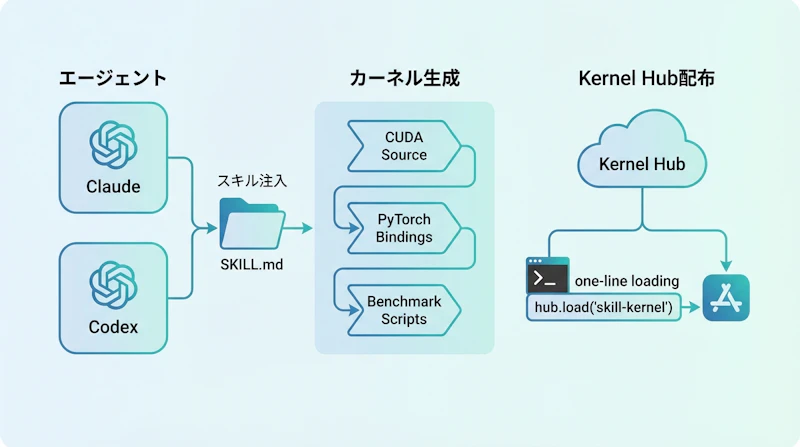

- Claude CodeやCodexなどのAIエージェントに約550トークンの専門知識を付与し、本番品質のCUDAカーネルを自動生成させる仕組み

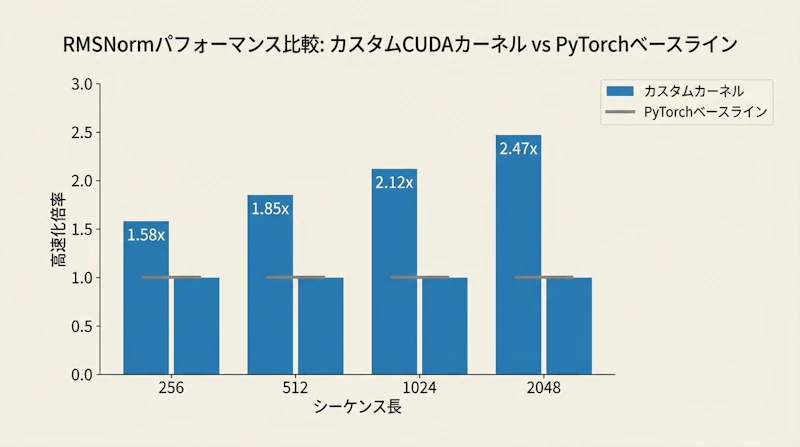

- RMSNormカーネルでPyTorch比最大2.47倍の高速化を達成し、LTX-VideoやQwen3-8Bで実証済み

- 生成したカーネルはHugging Face Kernel Hubで配布でき、ユーザーはコンパイル不要の1行読み込みで利用可能

Agent Skillとは何か

Hugging Faceが公開した「Agent Skill」は、AIコーディングエージェントにCUDAカーネル開発の専門知識を体系的に付与するオープンソースツールです。Claude Code、Codex、OpenCodeといった主要エージェントに対応しており、kernels skills add cuda-kernels --claudeのようなコマンド一つでセットアップが完了します。

このスキルの核となるのは、わずか約550トークンに凝縮された構造化ガイダンスと、リファレンス資料・スクリプト群で構成されるナレッジパッケージです。H100・A100・T4といったGPUアーキテクチャの仕様、BF16/FP16/FP32のベクトル化メモリアクセスパターン、PyTorchバインディングの生成方法、さらにはdiffusersやtransformersライブラリとの統合パターンまでが含まれています。従来であれば数年のGPUプログラミング経験が必要だった領域を、エージェントが即座に習得できるようになりました。

カーネル生成の仕組み

Agent Skillを導入したエージェントに「Qwen3-8B向けのRMSNormカーネルをH100用に作って」と指示すると、エージェントはスキル内のテンプレートとGPUアーキテクチャガイドを参照しながら、完全なプロジェクト構造を自動生成します。出力にはCUDAカーネルのソースコード、PyTorch C++バインディング、ベンチマークスクリプト、ビルド設定ファイルが含まれ、そのまま実行可能な状態で納品されるのが特徴でしょう。

生成されるカーネルの種類はRMSNormにとどまりません。3次元回転位置埋め込み(RoPE 3D)、GEGLU活性化関数、AdaLN(Adaptive Layer Normalization)など、現代のTransformerアーキテクチャで頻出する演算をカバーしています。エージェントはベンチマーク工程まで一貫して担当するため、生成されたカーネルが本当に高速かどうかを数値で検証した上で提出する流れになっています。

ベンチマーク結果

公開されたベンチマークは、H100 80GB・BFloat16環境で取得されたものです。動画生成モデルLTX-Videoに対するRMSNormカーネルでは、入力形状に応じて1.64倍から2.26倍の高速化を記録し、平均で1.88倍のスピードアップを達成しました。H100の理論帯域幅(3,350 GB/s)に対して34.7%の効率を実現しており、メモリバウンドな演算として妥当な水準といえます。

LTX-Videoのエンドツーエンド(49フレーム・30ステップ)評価では、カーネル単体で6%、torch.compileとの併用で43%の高速化が得られています。RMSNormが全体の計算量に占める割合は約5%であるため、6%のエンドツーエンド改善はカーネル単体の性能向上と整合する結果です。

大規模言語モデルQwen3-8Bでの結果はさらに印象的でしょう。シーケンス長128トークンで1.58倍、8192トークンでは2.47倍と、入力が長くなるほど高速化率が伸びる傾向が確認されました。Qwen3-8Bは32層にわたって65個のRMSNormモジュールを持つため、カーネル最適化の恩恵が累積的に効いてきます。長文コンテキスト推論でのレイテンシをおよそ半減させるという結果は、実運用上の価値が高いと考えられます。

Kernel Hubによる配布モデル

生成したカーネルの配布にも工夫が凝らされています。Nixフレーク(Nix flake)を用いた再現可能なマルチバリアントビルドでカーネルをコンパイルし、Hugging Face Kernel Hubにアップロードする仕組みが整備されました。利用する側はfrom kernels import get_kernelの1行でカーネルを読み込むだけで、Python・PyTorch・CUDAのバージョンに合ったバイナリが自動検出・ダウンロードされます。

この「開発はエージェント、配布はHub」という二層構造により、CUDAカーネルの専門知識を持たない開発者でも最適化の恩恵を受けられるようになるでしょう。コミュニティHub(kernels-community)も用意されており、誰でもカーネルを公開・共有できるエコシステムが形づくられつつあります。

AIがAI基盤を最適化する時代へ

今回のAgent Skillが示す最も重要な意味合いは、AIエージェントがAI自身の実行基盤を最適化するというパラダイムの出現にあります。これまでCUDAカーネルの開発は、GPU アーキテクチャへの深い理解とC++/CUDAの低レベルプログラミング能力を併せ持つ、ごく限られたエンジニアにしか手の届かない領域でした。

約550トークンの構造化された知識パッケージが、その専門性の壁を実質的に取り払ったことになります。Hugging Faceは以前にもLLM学習スキルを公開しており、今回のCUDAカーネルスキルはその延長線上に位置付けられるものです。エージェントに付与する専門知識の粒度や構造化手法として、他のドメインにも応用可能な設計パターンを提示した点も見逃せません。

リポジトリはGitHubでオープンソース公開されており、LTX-VideoとQwen3-8Bのサンプルプロジェクトも同梱されています。GPU最適化の民主化がどこまで進むのか、今後のコミュニティの動向から目が離せません。

参考元 https://huggingface.co/blog/custom-cuda-kernels-agent-skills