この論文では、多数の会話を含む新しいベンチマーク「CORAL」を提案し、検索拡張生成(RAG)システムの性能を評価しています。Wikipediaの階層構造を活用して自動的に会話データを生成し、複数ターンの対話における検索・生成・引用の精度を測定できるようになりました。これにより、実用的なRAGシステムの開発と評価が容易になります。

論文:CORAL: Benchmarking Multi-turn Conversational Retrieval-Augmentation Generation

GitHub:https://github.com/Ariya12138/CORAL

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

この研究のポイントは?

本論文は、多数の会話を含む検索拡張生成(RAG)システムの評価のための新しいベンチマーク「CORAL」を提案する研究です。

実験から、会話履歴の圧縮が応答生成の質を維持しながら引用の精度を向上させることも明らかになりました。

概要

近年、検索拡張生成(RAG)システムは外部知識を活用してLLMの性能を向上させる重要な手法として注目を集めています。しかし、実際のアプリケーションでは複数回のやり取り(マルチターン)が必要なのに対し、学術研究の多くは1回限りのやり取りに焦点を当てているという課題があります。

この研究では、マルチターンの会話型RAGシステムを評価するための新しいベンチマーク「CORAL」を提案しています。

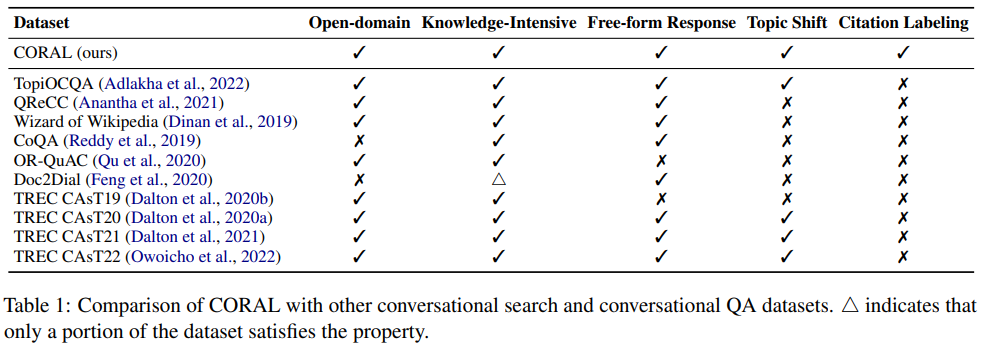

CORALはWikipediaから自動的に生成された8,000の情報探索型の会話を含み、幅広い分野をカバーしながら、知識集約的で自由形式の応答生成や話題の転換にも対応しています。特に重要な点は、以下の3つの基本タスクを統合的に評価できることです:

- 会話型パッセージ検索 – 複数回のやり取りの文脈を考慮した情報検索

- 応答生成 – 正確で文脈に即した回答の生成

- 引用ラベリング – 情報源の透明性を確保するための出典表示

また、実験から会話履歴の圧縮が応答生成の質を維持しながら引用の精度を向上させることも明らかになりました。この研究は、実用的な会話型RAGシステムの開発と評価を容易にする重要な貢献といえます。

提案手法

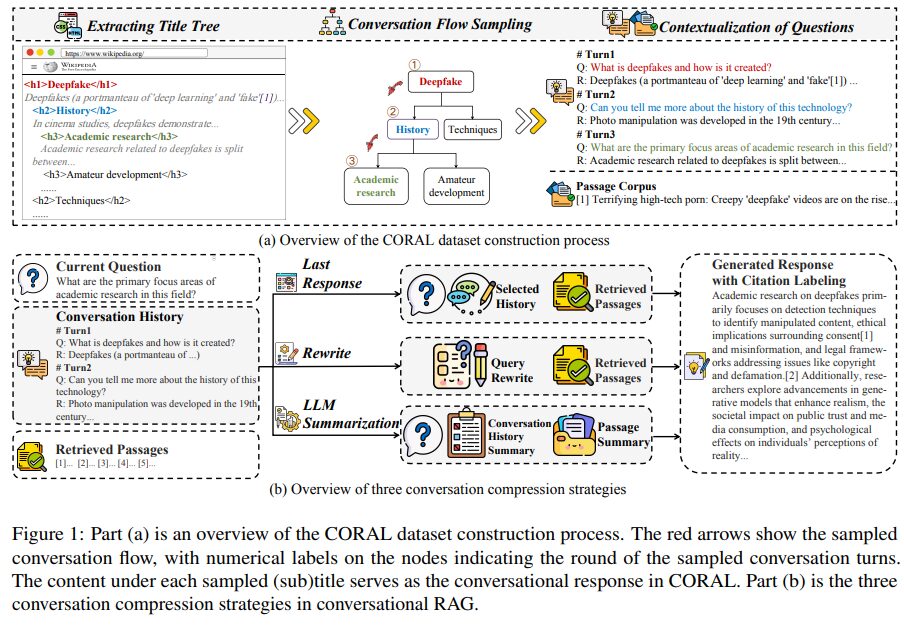

CORALは、Wikipediaのページ構造を活用して会話型RAGシステムを評価する新しい手法を提案しています。まず、Wikipediaのページから見出し階層を抽出し、それを基に会話の流れを4つの戦略で生成します。

具体的には、親子関係に沿って進む「線形降下サンプリング」、兄弟ノード間の移動を含める「兄弟包含降下サンプリング」、双方向のエッジを持つ「単一木ランダムウォーク」、そして関連する別の木への遷移を可能にする「二重木ランダムウォーク」を用意しました。

次に、GPT-4を使って見出しを自然な会話形式の質問に変換し、その下の本文を回答として扱います。この方法で8,000の情報探索型会話を自動生成しました。

さらに、会話履歴の圧縮方法として「最後の応答戦略」「書き換え戦略」「LLM要約戦略」を導入し、入力の長さを短縮しながら応答の質を維持することに成功しています。

実験

実験では、会話型検索拡張生成(RAG)システムの3つの主要タスクについて評価を行いました。

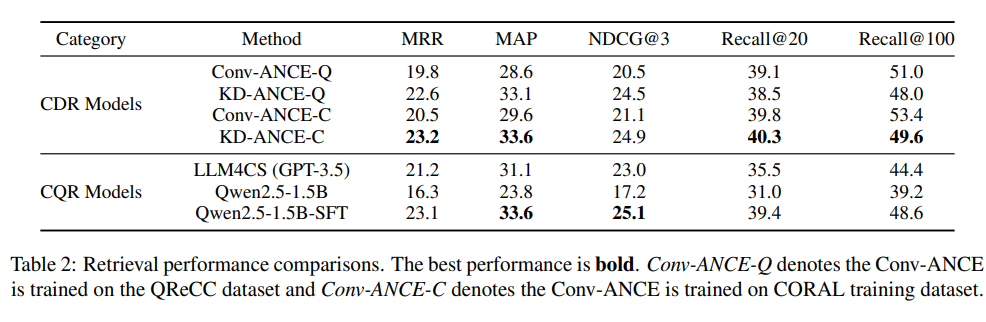

まず、会話型パッセージ検索タスクでは、会話の文脈を考慮した情報検索の性能を測定しました。KD-ANCEやConv-ANCEなどの密な検索モデルと、GPT-3.5やQwen2.5などを用いた質問書き換えモデルを比較したところ、微調整したQwen2.5が最も高い性能を示しました。

次に、応答生成と引用ラベリングのタスクでは、会話履歴の圧縮方法による影響を調査しました。生の文脈、最後の応答のみ、質問の書き換え、LLMによる要約の4つの方法を比較した結果、入力を短くしても応答の質は維持され、むしろ引用の精度は向上することが分かりました。

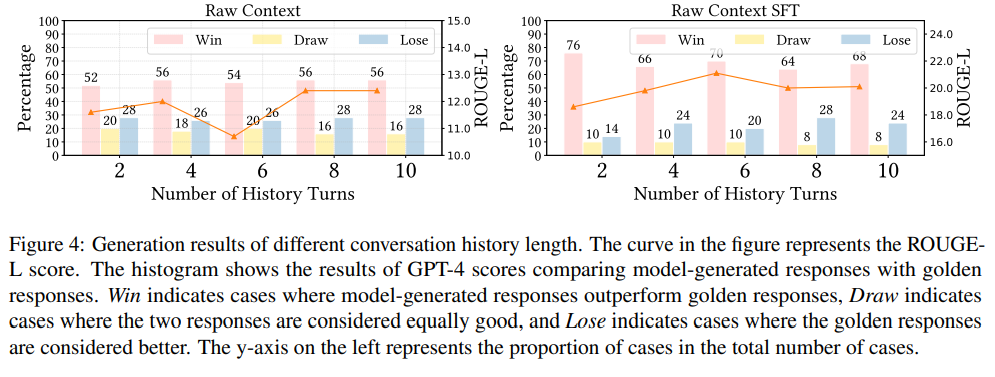

また、会話履歴の長さを変えた実験では、6ターン程度までは性能が向上し、それ以上では低下することが示されました。

結論

本研究では、マルチターン会話型検索拡張生成(RAG)システムの評価に関する包括的なベンチマーク「CORAL」を提案しました。

本研究は、実用的な会話型RAGシステムの開発と評価を容易にする重要な貢献となっています。今後の課題として、より細かな会話履歴のモデリングや、訓練データの重複による汚染の問題に取り組む必要性が指摘されています。