- ユーザー個別の嗜好を構造化された評価チェーンに変換し、パーソナライズされた報酬スコアを生成する新手法P-GenRMを提案

- テスト時にユーザー類似度を活用するスケーリング機構により、従来手法を平均2.77%上回る精度を達成

- 8Bパラメータのモデルが70B規模のベースラインを凌駕し、効率的なパーソナライゼーションの実現可能性を示した

研究の背景

大規模言語モデル(LLM)を人間の好みに合わせて調整するRLHF(人間フィードバックによる強化学習)は、現在のAI開発において不可欠な技術となっています。しかし、従来のRLHFには根本的な問題がありました。すべてのユーザーの好みを単一の報酬関数で表現しようとするため、多様な価値観や嗜好を十分に反映できないのです。

例えば、ある人は簡潔な回答を好み、別の人は詳細な説明を求めるかもしれません。技術者は正確さを重視し、初学者はわかりやすさを優先するでしょう。こうした個人差を無視して「平均的な好み」に最適化すると、誰にとっても中途半端な応答になりかねません。

さらに既存のパーソナライゼーション手法には、新しいユーザーへの汎化が難しいという課題もありました。フィードバックデータが少ないユーザーに対して、適切な報酬を推定することが困難だったのです。Alibaba Groupの研究チームは、これらの課題を同時に解決する新たなアプローチとしてP-GenRMを提案しました。

提案手法

P-GenRM(Personalized Generative Reward Model)の核心は、ユーザーの嗜好シグナルを「構造化された評価チェーン」に変換するという発想にあります。従来の報酬モデルが単純なスカラー値(数値スコア)を出力するのに対し、P-GenRMはシナリオに応じたペルソナ、評価基準、重み付きルーブリック(採点指針)をテキストとして生成します。

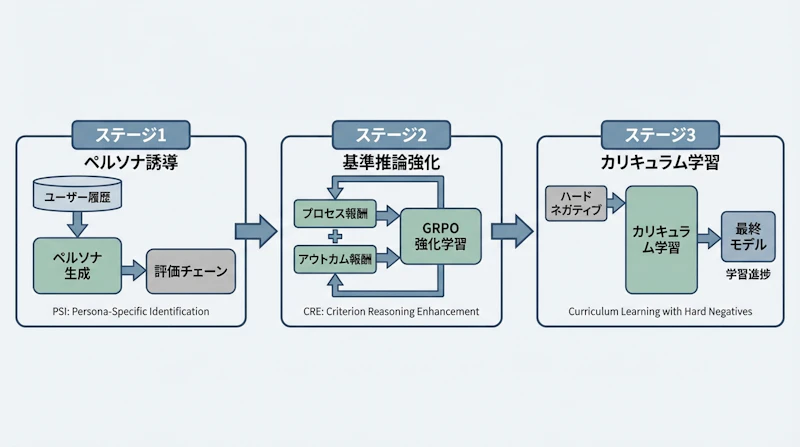

学習は3段階で進みます。第1段階のペルソナ誘導スコアリング(PSI)では、ユーザーの対話履歴や暗黙的なシグナルからペルソナを合成し、それに基づく評価チェーンを生成する能力を教師あり学習で獲得します。

第2段階の基準ベース推論強化(CRE)では、GRPOアルゴリズム(強化学習の一手法)を用いてモデルの推論能力を高めます。ここでは「プロセス報酬」と「アウトカム報酬」という2種類の報酬シグナルを組み合わせることで、評価基準をどれだけカバーしたかと最終スコアの正確さの両方を最適化しています。

第3段階ではハードネガティブ対応カリキュラム学習を行い、判断が難しい事例を段階的に取り入れることで、モデルの識別力をさらに向上させます。

テスト時ユーザーベーススケーリング

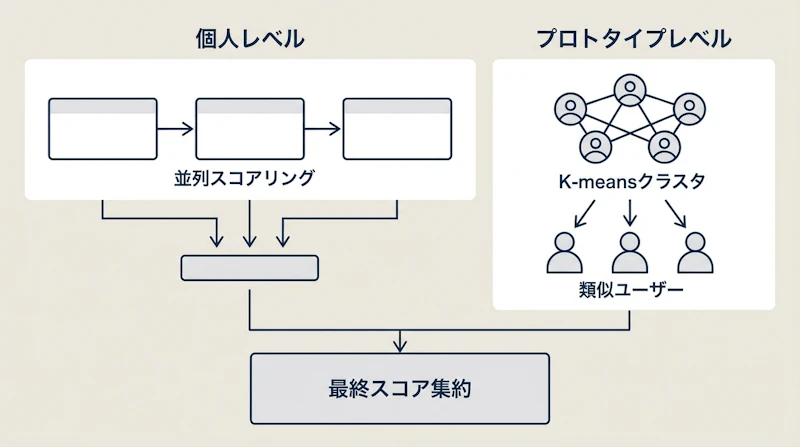

P-GenRMのもう一つの重要な貢献は、推論時(テスト時)にユーザー情報を活用するスケーリング機構です。この仕組みは2つの粒度で動作します。

まずオフラインのプロトタイプ初期化として、全ユーザーの嗜好分析結果を埋め込みベクトルに変換し、K-meansクラスタリングで50個の代表的なプロトタイプ(ユーザー群の典型パターン)を特定します。推論時には個人レベルで現在のユーザーの嗜好を反映した複数の並列スコアリングを実行し、同時にプロトタイプレベルで同じクラスタ内の類似ユーザーの嗜好も取り込みます。

この二重構造により、フィードバックの少ない新規ユーザーでも類似ユーザー群の情報を借りることで合理的な報酬推定が可能になります。個々のノイズを抑えながら、個人の特性も反映できるバランスの取れた設計といえるでしょう。

実験結果

実験はPersonalRewardBench(Chatbot Arena-Personalizedの131ユーザーとPRISM-Personalizedの720ユーザー)およびLaMP-QA(分布外データセット)で実施されました。

モデル | Chatbot Arena(8B) | PRISM(8B) |

|---|---|---|

従来最高手法 | 69.78% | 62.84% |

P-GenRM(基本) | 72.68% | 65.32% |

P-GenRM + スケーリング | 75.92% | 68.06% |

P-GenRMは8Bモデルで従来の最高性能を平均2.77%上回りました。テスト時スケーリングを加えるとさらに約3%の改善が得られています。特筆すべきは、P-GenRMで学習した8Bモデルが、DPO/GRPOによるポリシー学習後にスコア3.316〜3.354を達成し、70B規模のベースライン(3.156〜3.214)を95%信頼区間で明確に上回った点です。

コールドスタート環境(ユーザーデータがほとんどない状況)のLaMP-QAでは、スピアマン相関0.638を記録し、パラメータ数が大幅に多いQwen3-235Bモデル(0.619)をも超える結果となりました。わずか3組の過去の嗜好ペアがあれば信頼性の高いパーソナライゼーションが実現でき、それ以上のデータ追加による改善は限定的であることも示されています。

マイノリティグループへの公平性についても検証が行われており、プロトタイプ単位のマクロ精度(65.21%)とサンプル単位の精度(65.32%)がほぼ同等であることから、ユーザー分布の偏りによる性能格差は小さいと報告されています。

まとめと今後の展望

P-GenRMは、ユーザーの多様な嗜好を構造化された評価チェーンとして表現し、テスト時のデュアル粒度スケーリングで個人適応を実現するという、パーソナライズドAIの新たな方向性を示しました。ICLR 2026でOral発表に採択されたことからも、この研究の重要性がうかがえます。

一方で課題も残っています。評価チェーンの生成はスカラー値の直接予測と比べて計算コストが高く、推論時間はスケーリング適用時に約1.6倍に増加します。また、最低3組の嗜好データが必要なため、完全なゼロショットのパーソナライゼーションには対応できません。

今後の発展として、より効率的な評価チェーン生成手法の開発や、マルチモーダルな嗜好シグナル(テキスト以外の行動データなど)の統合が考えられるでしょう。AIアシスタントが一人ひとりの好みを理解し、それに合わせた応答を返すという理想に向けて、本研究は重要な一歩を踏み出しています。