- テンソル積による効率的な注意メカニズムを提案

- TPAがメモリ効率を向上し計算負荷を軽減

- 既存のTransformerと統合が容易で計算資源の節約に貢献

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

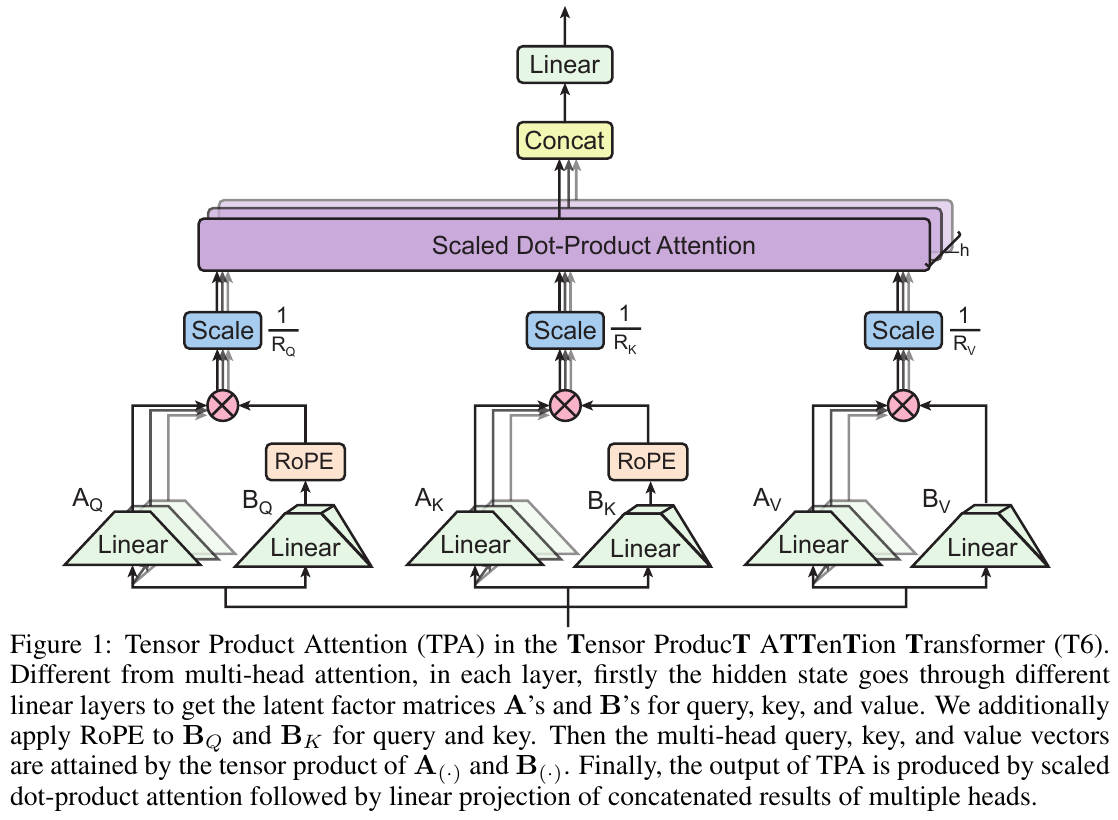

この論文は、Transformerモデルの注意メカニズムを再設計するための新しいアプローチ「Tensor Product Attention (TPA)」を提案しています。この手法は、従来のScaled Dot-Product AttentionやMulti-Head Attentionから着想を得ており、特に効率性とメモリ消費量の削減を目指しています。

TPAでは、まず注意機構におけるクエリ(Q)、キー(K)、値(V)のテンソルを特殊な形に分解し、再構成することで、これらの操作を効率化します。また、この分解手法により、キャッシュメモリの使用効率が向上し、計算負荷を削減できます。特に、事前に定義したテンソルの因子分解を用いることで、計算コストを抑えつつも高い性能を維持することができます。この仕組みは、ロータリー位置埋め込み(Rotary Position Embedding: RoPE)のような時間依存の仕組みとも互換性を持つよう設計されています。

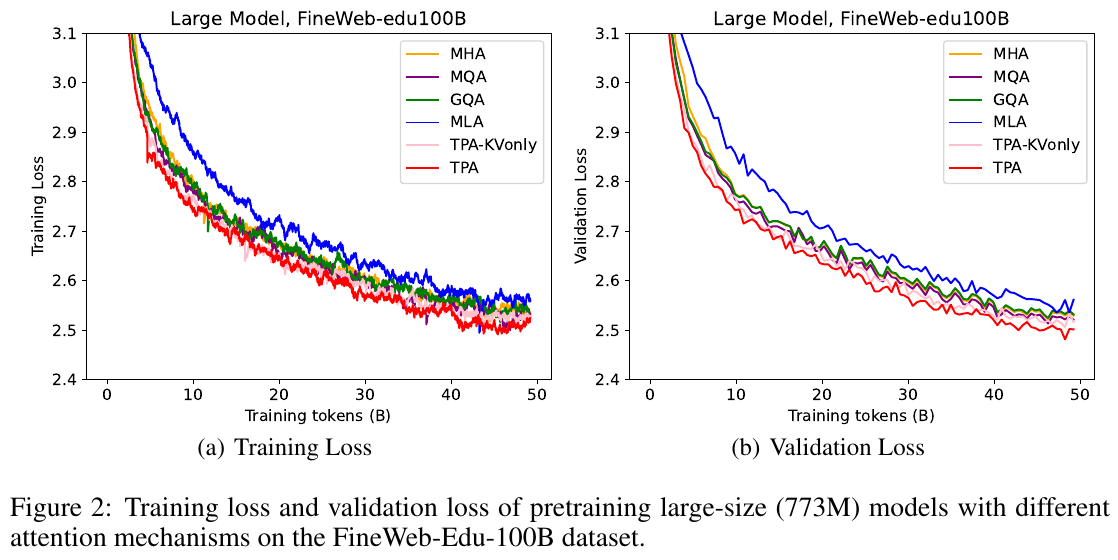

実験では、LLMにおける言語モデリングタスクを通じてTPAの有効性を検証しました。FineWeb-Eduデータセットを用いて訓練されたモデルで、TPAは従来のMulti-Head Attention (MHA)や他の代替注意メカニズム(例えば、Grouped Query Attention (GQA))と比較されました。その結果、TPAを採用したモデルは、学習効率と推論性能の両面で競争力のある結果を示しました。特に、従来モデルではメモリ使用上の制約が問題となる大規模データや長シーケンスの処理において、TPAが優れたパフォーマンスを発揮しました。

さらに、TPAを導入することで必要となる追加の計算コストは最小限に抑えられ、既存のTransformerアーキテクチャと容易に統合可能である点も強調されています。このアプローチは、特に計算資源が限られる環境や、大規模なモデル導入が求められる領域において有用と期待されます。

図表の解説

この図は、Tensor ProducT ATTEnTion Transformer(T6)における「Tensor Product Attention(TPA)」の仕組みを示しています。このモデルは、従来のマルチヘッドアテンションとは異なり、まず各レイヤーで隠れ状態が線形層を通過して、クエリ(Q)、キー(K)、バリュー(V)の各行列の潜在因子AとBを取得します。Bに対してRoPE(Rotary Position Embedding)を適用し、これらの因子のテンソル積を用いてマルチヘッドクエリ、キー、バリューを形成します。最終的に、TPAの出力は、スケールされたドット積のアテンションと線形結合により得られます。これにより、メモリ効率が向上し、長いシーケンスの処理が可能になります。

この図は、FineWeb-Edu100Bデータセットを使用した大規模モデル(773Mパラメータ)の学習と検証時の損失を示しています。図2の左側(a)はトレーニング損失、右側(b)は検証損失を示しています。線の色は異なる注意メカニズムを表し、TPA(Tensor Product Attention)が他の手法(MHA、MQA、GQA、MLAなど)に比べてより低い損失を達成していることがわかります。このことは、TPAがメモリ効率を向上させながらモデルの質を改善するための有効なアプローチであることを示しています。グラフの傾向から、TPAは他の手法よりも高い収束速度と低い最終的な損失を達成していることが明らかです。

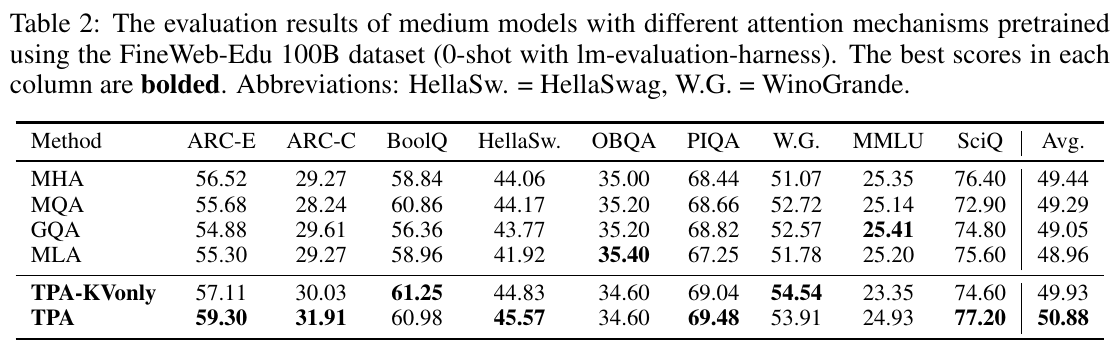

この表は、異なる注意メカニズムを持つ中規模モデルの評価結果を示しており、FineWeb-Edu 100Bデータセットを使用して事前訓練されています。表には、0ショットでの性能が記載されています。使用された注意メカニズムは、MHA、MQA、GQA、MLA、TPA-KVonly、およびTPAです。各評価基準(ARC-E、ARC-C、BoolQ、HellaSwagなど)において最も高いスコアは太字で示されています。この結果から、TPAが他の注意メカニズム(例えばMHAやMQA)を上回るかどうかを確認できます。TPA-KVonlyやTPAが多くの評価基準で良好な性能を示しています。興味深いことに、TPAは平均スコアで最も高く、TPAが効率的なメモリ利用と高い性能を両立していることが示唆されています。

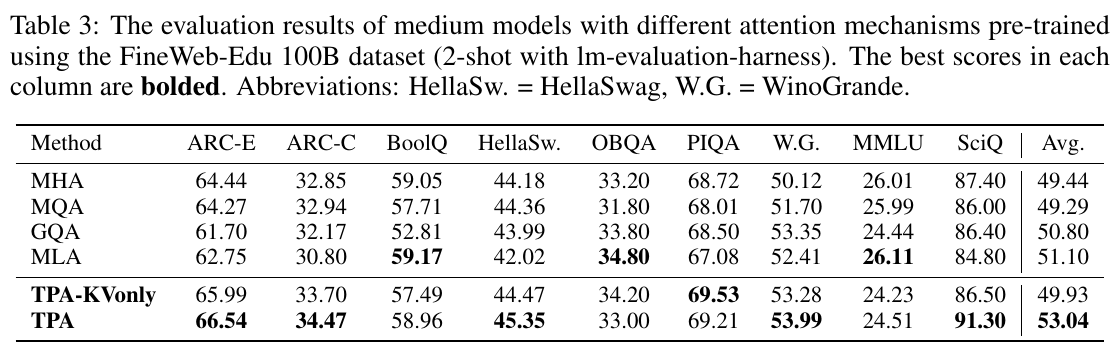

テーブル3は、FineWeb-Edu 100Bデータセットを使って事前学習した中規模モデルの評価結果を示しています。ここでは、異なるアテンションメカニズムが比較されており、各評価項目での最高スコアが太字で示されています。具体的には、TPA(Tensor Product Attention)とその派生型であるTPA-KVonlyが、多くのベンチマークで従来のMHA(Multi-Head Attention)、MQA(Multi-Query Attention)、GQA(Grouped Query Attention)、MLA(Multi-head Latent Attention)を上回るパフォーマンスを見せています。特にSciQでTPAが最高の91.30のスコアを達成し、平均でも他のメカニズムを上回っています。研究は、TPAがメモリ効率を高めながら性能を改善できることを示唆しています。

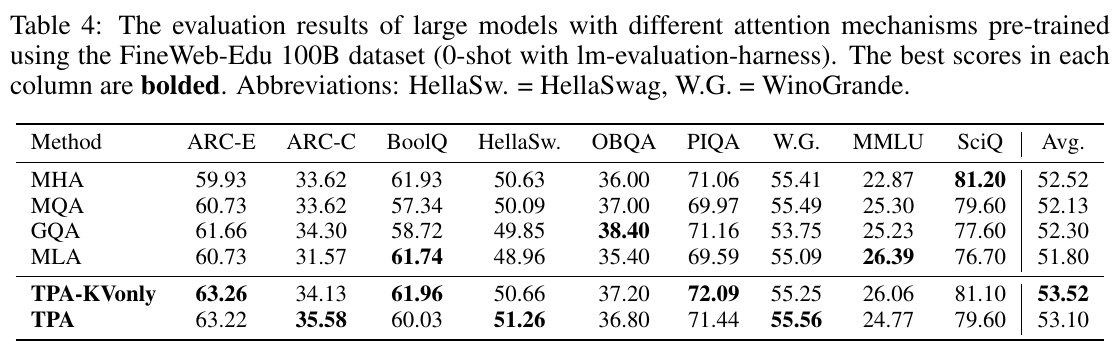

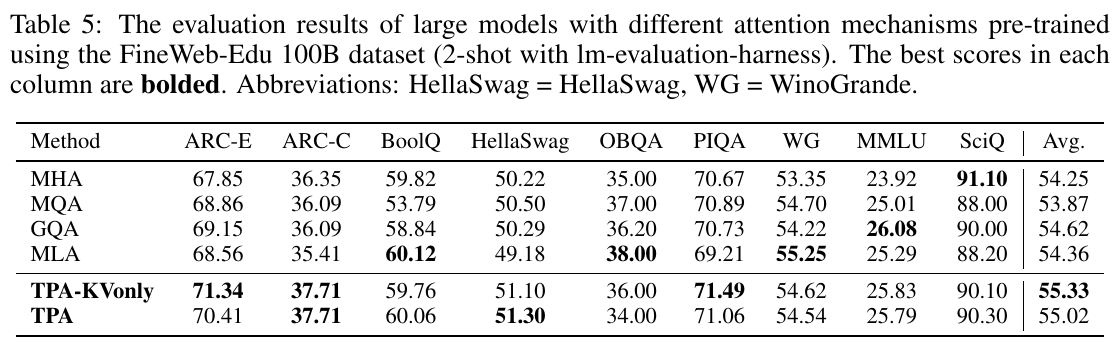

この表は、大規模モデルの異なるアテンションメカニズムを比較した結果を示しています。実験はFineWeb-Edu 100Bデータセットを用い、0ショット評価を行いました。各列での最高スコアは太字で示されています。 表には、MHA、MQA、GQA、MLA、TPA-KVonly、TPAという6つの方法が記載されています。ARC-E、ARC-C、BoolQ、HellaSwag、OBQA、PIQA、WinoGrande(W.G.)、MMLU、SciQといったデータセットに対するスコアがそれぞれ示されており、最後に全体の平均スコア(Avg.)が記載されています。 TPA-KVonlyとTPAは、多くのタスクで他の方法を上回っており、特にSciQやPIQAで高い成果を上げています。これらの結果から、TPAを用いることで、メモリ効率を改善しつつ、モデルの性能を向上できることが示唆されています。全体として、TPAとTPA-KVonlyは、他の従来の手法に対して優れた結果を示しました。

表5は、FineWeb-Edu 100Bデータセットを使って大規模なモデルを異なるアテンションメカニズムで事前学習した結果を示しています。各方法の結果が、多くの評価ベンチマークに対して示されています。表には、ARC-E、ARC-C、BoolQ、HellaSwag、OBQA、PIQA、WinoGrande、MMLU、SciQといった評価項目がリストアップされていて、各方法の平均値も示されています。 この表は、TPA-KVonlyとTPAが他の方法(MHA, MQA, GQA, MLA)に対して多くのタスクで優れた性能を示していることを示しています。特に、TPA-KVonlyは、平均的に最高のスコアを達成しており、メモリ効率とパフォーマンスが向上したことが確認されます。これは、TPAがテンソル分解を用いることでキーと値のメモリ使用量を削減しつつ、より良い表現能力を持つためです。

この表は、異なるアテンションメカニズムを比較したものです。主に多頭アテンション(MHA)、多問アテンション(MQA)、グループ化問い合わせアテンション(GQA)、多頭潜在アテンション(MLA)、および提案されたテンソル積アテンション(TPA)の比較を行っています。各手法は、KVキャッシュのサイズ、パラメータ数、クエリヘッドとKVヘッドの数によって特徴付けられています。TPAは、メモリ使用量を削減できる新しい手法であり、従来の方法と比較して性能も向上させています。TPAには、異なる変種があり、それぞれ異なる文脈での柔軟性と効率性を提供します。

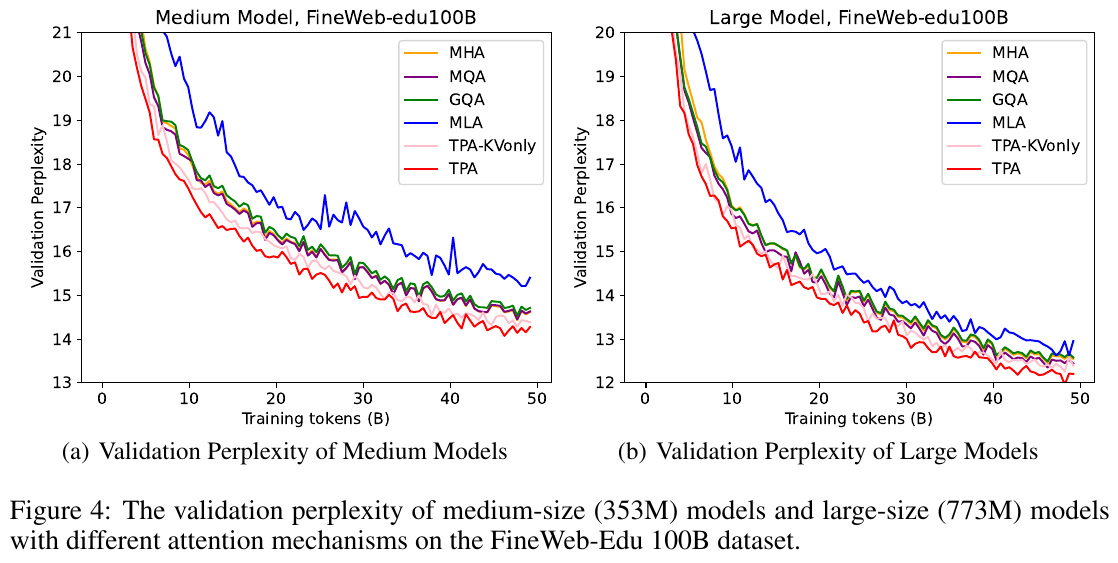

この図は、FineWeb-Edu 100Bデータセットを用いて異なる注意メカニズムを持つ中規模モデル(353M)と大規模モデル(773M)の検証パープレキシティの変化を示しています。図4の左側(a)は中規模モデル、右側(b)は大規模モデルについてで、それぞれ縦軸はパープレキシティ、横軸はトレーニングのトークン数です。TPA(Tensor Product Attention)とその変種であるTPA-KVonlyは、他の注意機構(MHA, MQA, GQA, MLA)と比較して、訓練の進行に伴って一貫して低いパープレキシティを示し、より効果的に性能を向上させることを示しています。これは、TPAがモデルの記憶効率と性能を両方向上させることができることを意味します。