言語・LLM

言語・LLM ユーザー適応型LLM:新手法TPOで再学習不要

ユーザーの好みに合わせてLLMの出力を調整する新手法TPOを提案テスト時にユーザーのフィードバックを活用し、損失関数を用いた出力の最適化TPOは再トレーニング不要でコスト削減を実現しながら競争力を持つ性能論文:Test-Time Prefe...

言語・LLM

言語・LLM  言語・LLM

言語・LLM  言語・LLM

言語・LLM  ニュース

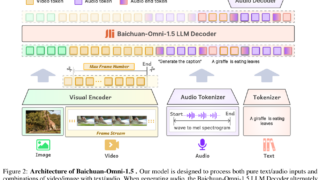

ニュース  マルチモーダル

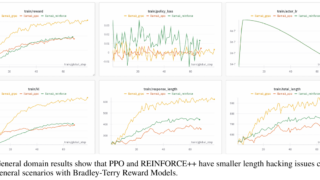

マルチモーダル  強化学習

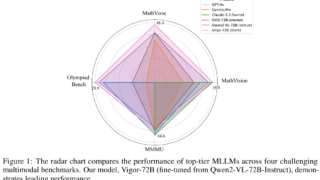

強化学習  マルチモーダル

マルチモーダル  強化学習

強化学習  動画

動画  言語・LLM

言語・LLM