- SSMの直近情報依存と情報均一化問題の明確化

- 情報を活用するための極性化手法の提案

- 長期依存性タスクでの性能向上を実証

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

この論文では、State Space Models(SSM)における情報の再現性や長期的依存関係の限界を克服するための新しい分析視点として「Recency」と「Over-smoothing」を利用し、潜在的な性能向上の可能性を引き出す手法を提案しています。SSMはTransformerなどと並ぶ効果的な一連のモデルとして注目されていますが、長期にわたる情報の保存や活用が十分でないという問題が指摘されています。

研究では、SSMの「Recency」(直近の情報に過度に依存する性質)と「Over-smoothing」(時間軸で情報が均一化されすぎる性質)を理論的に明らかにし、これらの現象がモデルの長期依存関係を制限し、性能低下の原因となっていることを示しました。具体的には、モデルが直近のデータに優先的な重みを与えすぎるため、過去の情報が適切に組み込まれないことが課題であると述べています。

この問題を解決するために、著者らは「極性化(polarization)」手法を提案しました。極性化では、モデルの特性の一部を操作して、Recencyを低減しつつOver-smoothingを緩和する工夫を加えています。このアプローチは、モデルが時間を超えてより長期間にわたる情報を活用する能力を向上させ、性能を効率的に最適化することを目的としています。

実験では、提案手法が既存のSSMやTransformerと比較して長期的な文脈情報をより効果的に捉え、精度を向上することが示されています。具体的には、想定される長期依存性タスクや分類タスクにおいて、提案手法が優れた性能を発揮しており、RecencyとOver-smoothingという課題を克服した意義が確認されました。また、「Needle in a Haystack」テストや画像分類タスク(CIFAR-10)を通じた評価により、モデルの知識保持能力とロバスト性が強化されたことが明らかになりました。

図表の解説

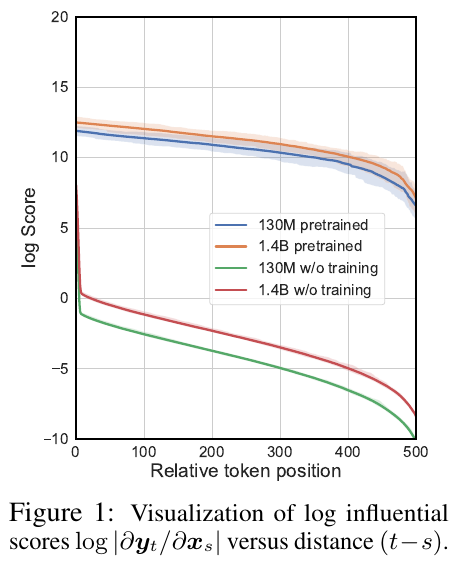

図1は、SSMにおける影響力のスコアを示しています。影響力のスコアとは、ある出力トークンがどれだけ前の入力トークンから影響を受けているかを表し、スコアが大きいほどその影響は大きいことを意味します。この図では、モデルサイズと訓練の有無で異なる線が描かれており、特にSSMは近接するトークンに対するバイアスが強く、遠くのトークンからの影響が指数関数的に減少する様子が視覚的に示されています。これは、記憶の偏りがあり、長距離依存性を捉える能力が制限されていることを示唆しています。

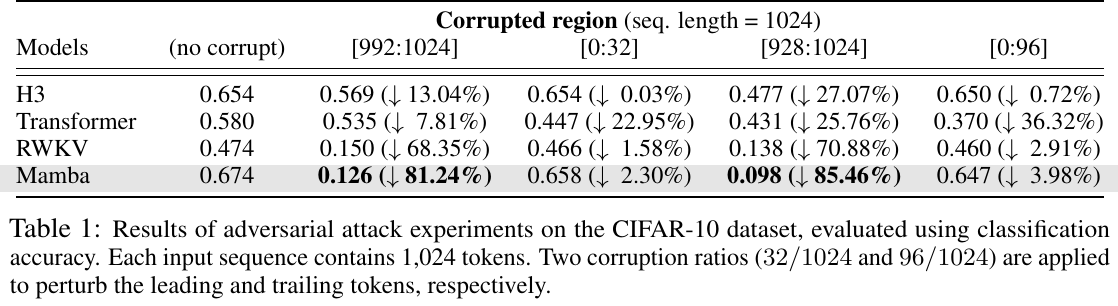

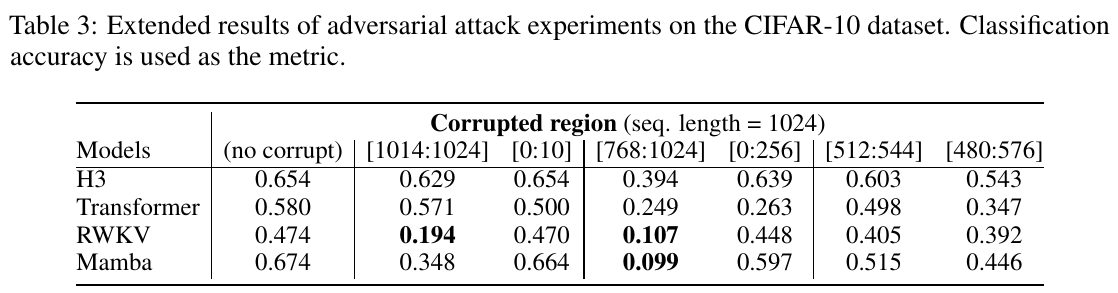

この表は、「CIFAR-10」データセットを使用したモデルの分類精度を示しています。各モデルは異なる区間に対する攻撃を受けた場合の精度の変化を示しています。特に、モデル「Mamba」は先頭32トークンにノイズを付加された場合、81.24%の精度低下を示し、末尾のトークンを操作するとさらに大きな影響を受けています。これは、Mambaが近隣のトークンに対するローカルバイアスを持っていることを示唆しています。他のモデルとの差も含め、Mambaの特徴的なローカルバイアスが明らかです。

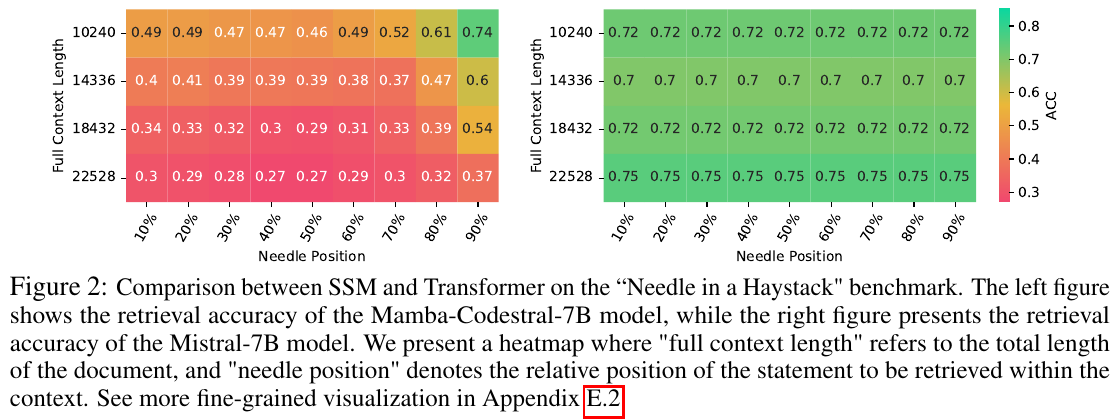

図2は、SSM(状態空間モデル)とTransformerを「針を見つける」ベンチマークで比較した図です。左のヒートマップは、Mamba-Codestral-7Bモデルの検索精度を示し、右はMistral-7Bモデルの精度を示しています。「フルコンテキスト長」は文書全体の長さ、「ニードルポジション」は文中の特定文の相対位置を表します。SSMは文の後半で精度が高く、Transformerは位置に関わらず安定していることが見て取れます。これは、SSMがより最近の情報に偏りがある可能性を示唆しています。

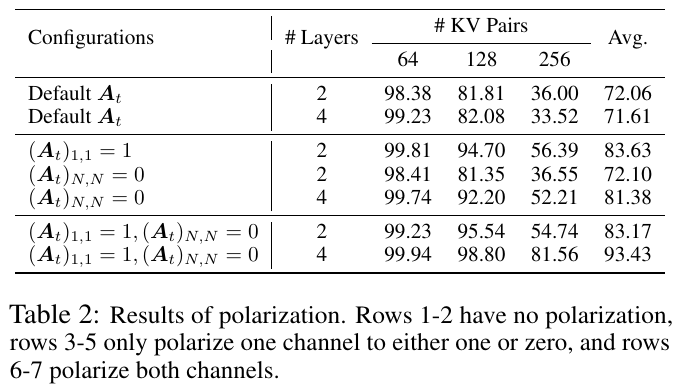

この表は論文の実験結果を示しており、構成の異なる状態空間モデル(SSMs)の極性化による影響を検証しています。行1-2では極性化をしておらず、行3-5では片方のチャネルのみを極性化、行6-7では両方のチャネルを極性化しています。極性化の結果、特定の組み合わせで長いコンテキストからの情報検索精度が向上し、さらに深いモデル設計からも性能向上が得られたことを確認しています。

画像は、CIFAR-10データセットで「馬」クラスを対象にした攻撃実験の結果を示しています。(a)と(b)のグラフは、異なる攻撃比率下での攻撃成功率を示しています。青と赤のバーは、それぞれ異なる攻撃範囲を示しており、低い成功率はそれぞれの攻撃範囲におけるより高いロバスト性を示唆しています。この実験は、異なるモデルの頑健性を比較し、攻撃範囲におけるモデルの弱点を明らかにするものです。

この表は、CIFAR-10データセットに対する対抗的攻撃実験の拡張結果を示しています。分類精度が指標として使用されています。異なるモデル(H3、Transformer、RWKV、Mamba)の精度が、さまざまな破損領域(例えば[1014:1024]や[0:10]など)にわたって評価されています。破損がない場合、すべてのモデルは比較的高い精度ですが、特にRWKVとMambaは、重要な領域が破損されたときに精度が大幅に低下しています。これはこれらのモデルが局所的な情報に依存しやすく、頑強性の問題があることを示唆しています。

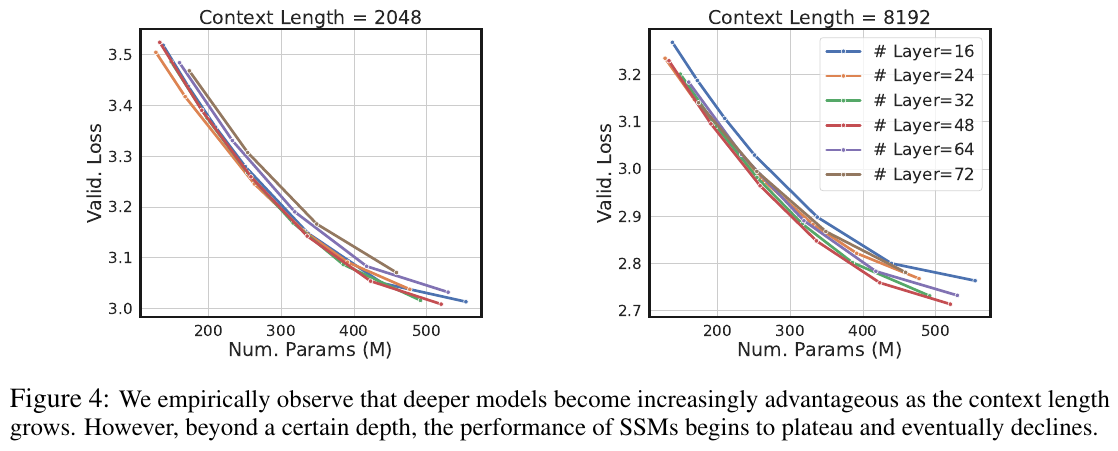

図4は、異なるコンテキスト長におけるモデルの深さと性能の関係を示しています。コンテキスト長が2048および8192のとき、モデルのパラメータ数が増えると検証損失が減少しますが、ある深さを超えると性能が向上しなくなり、むしろ低下することがわかります。つまり、モデルの深さを増やすことが必ずしも性能向上に繋がらない場合があることを示唆しています。

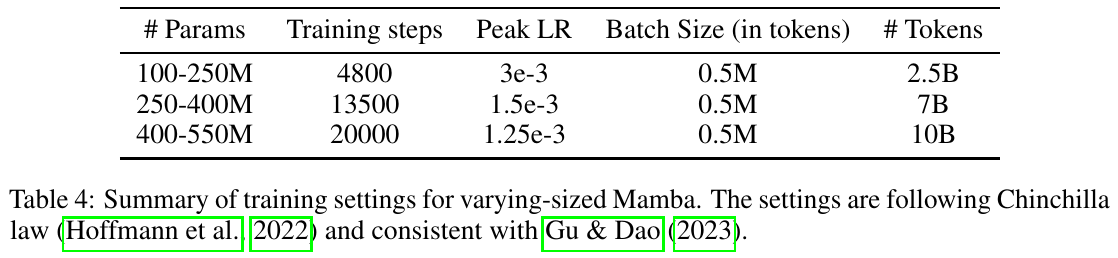

この表は、Mambaモデルの異なるサイズに対するトレーニング設定を示しています。モデルのパラメータ数に応じて、トレーニングステップ数やピーク学習率が設定されています。すべての場合において、バッチサイズは0.5Mトークンで一定です。「Chinchilla法則」に基づいて、モデルは効率的にトークンを処理するよう設計されています。この結果、Mambaモデルは様々な規模において一貫したトレーニングが可能になります。