この論文では、自己蒸留を用いた新しい言語モデルの高速化手法「Self-Distillation Through Time (SDTT)」を提案しています。従来の自己回帰型モデルと異なり、32トークンを同時に生成できるため、KVキャッシュを使用する従来手法と比べて最大8倍の高速化を実現。さらに、テキスト品質も向上し、自然言語理解のベンチマークでも優れた性能を示しました。

論文:Beyond Autoregression: Fast LLMs via Self-Distillation Through Time

GitHub:https://github.com/jdeschena/sdtt

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

この研究のポイントは?

本論文は、言語モデルの生成速度を改善する「Self-Distillation Through Time (SDTT)」という新しい手法を提案しています。

つまり、高速かつ高品質な文章生成を実現し、大規模言語モデルの実用性を大きく向上させた研究と言えます。

背景

近年、LLMは様々なタスクで優れた性能を示していますが、1トークンずつ生成する自己回帰型の処理方式では、生成速度が遅いという課題がありました。

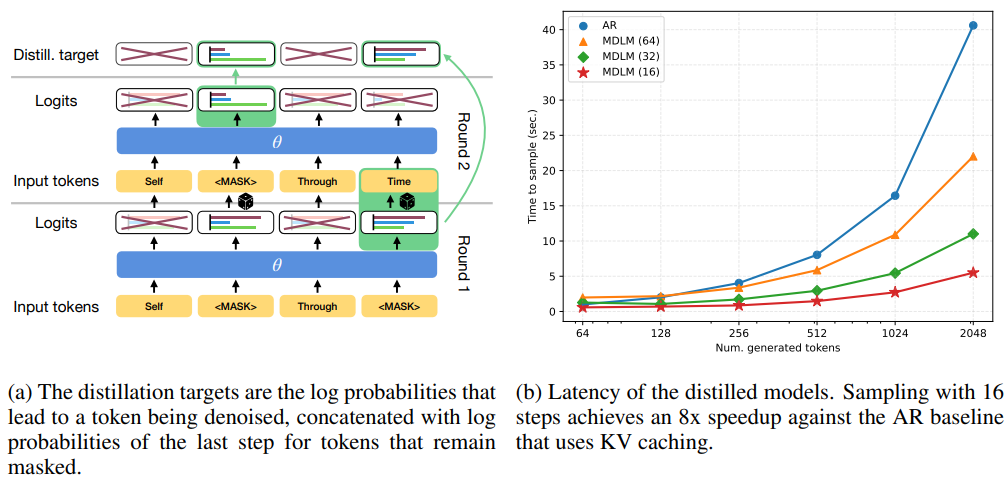

この論文では、「Self-Distillation Through Time (SDTT)」という新しい手法を提案しています。SDTTは離散拡散モデルを用いて、32個のトークンを同時に生成することを可能にしました。従来のKVキャッシュを使用する手法と比較して、最大8倍の高速化を実現しています。

さらに、テキスト生成の品質面でも向上が見られ、LAMBADAなどの自然言語理解ベンチマークでも優れた性能を示しました。特に注目すべき点は、32ステップでの生成でも、教師モデルが1024ステップで生成した場合よりも低い生成パープレキシティを達成したことです。

この研究の重要性は、高速な推論を必要とする定理証明やコード生成、アライメントなどの応用分野で、より効率的な探索や計画立案が可能になった点にあります。また、860Mパラメータまでのモデルでスケーリング実験を行い、手法の有効性も実証されています。

提案手法

本研究では、「Self-Distillation Through Time (SDTT)」という新しい蒸留手法を提案しています。SDTTは離散拡散モデルを用いて、複数のトークンを同時に生成することを可能にします。

具体的な手法として、まず教師モデルを使って多数のステップ(例:1024ステップ)でテキストを生成し、その過程で得られる確率分布を生徒モデルに蒸留します。生徒モデルは少ないステップ数(例:32ステップ)で教師モデルの出力を模倣するように学習されます。

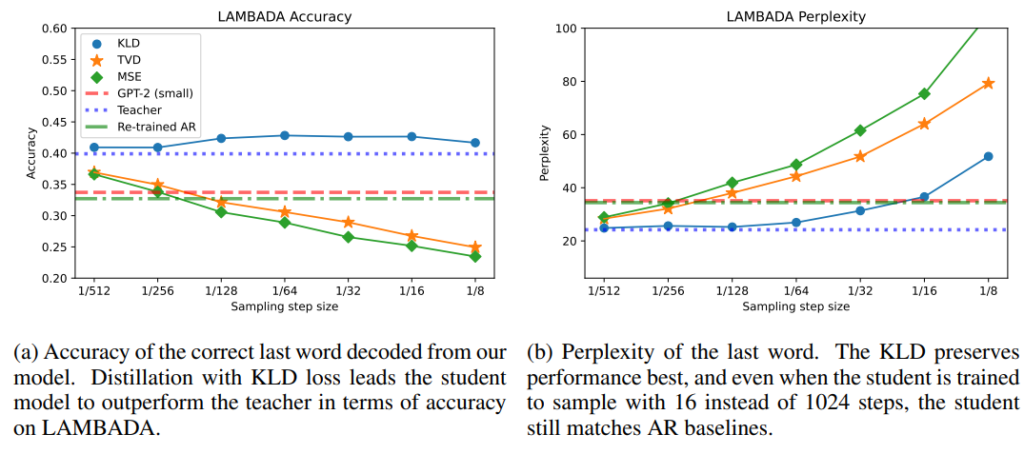

特筆すべき点は、KLダイバージェンスを損失関数として使用することで、生徒モデルが教師モデルよりも優れた性能を発揮できることです。LAMBADAベンチマークでは精度が向上し、生成テキストの品質も改善されました。

また、SDTTは段階的に適用することができ、各段階で生成ステップ数を半分に削減していきます。実験では860Mパラメータまでのモデルでスケーリング性も実証されています。

結果として、KVキャッシュを使用する従来の自己回帰モデルと比較して最大8倍の高速化を達成し、かつテキスト品質も向上させることに成功しました。

実験

実験は主に4つの観点から行われています。

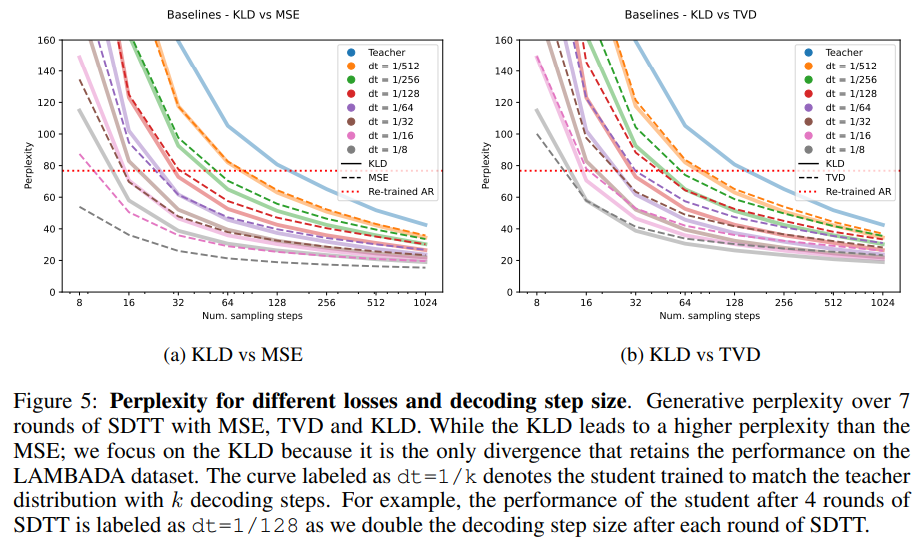

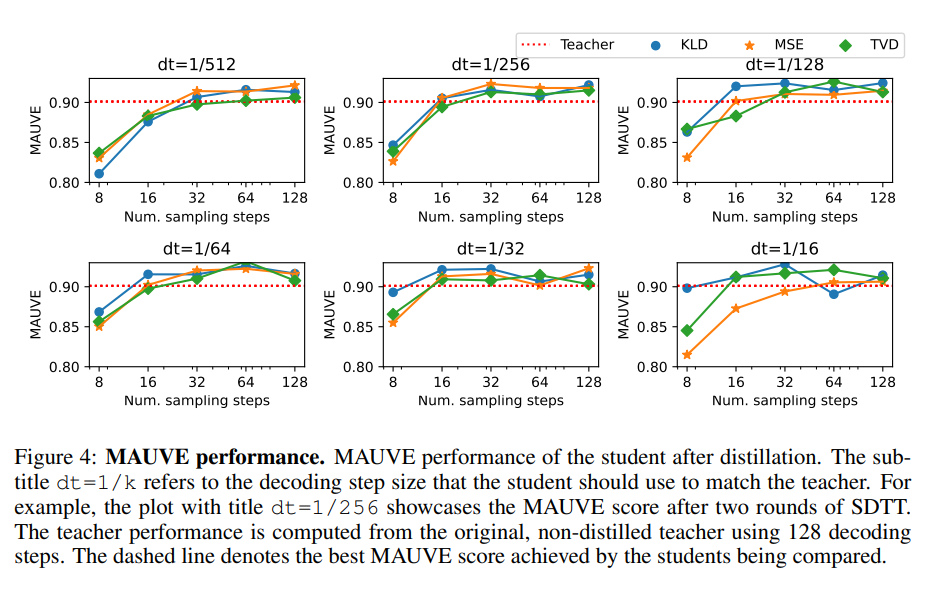

まず、蒸留手法の評価として、KLダイバージェンス(KLD)、平均二乗誤差(MSE)、全変動距離(TVD)の3つの損失関数を比較しました。

KLDを用いた場合が最も優れた結果を示し、LAMBADAベンチマークでは教師モデルを上回る精度を達成しました。

次に、SDTTの反復回数に関する実験を行いました。各ラウンド10,000ステップで7回の反復を行い、生成ステップ数を段階的に削減していきました。その結果、32ステップまで削減しても高い性能を維持できることが分かりました。

3つ目は、モデルのスケーリング実験です。169M、424M、863Mパラメータの3つのサイズのモデルでSDTTの有効性を検証しました。興味深いことに、169Mの小規模モデルでも64ステップ以上の生成で、より大きなモデルと同等以上の性能を示しました。

最後に、推論速度の比較実験を実施しました。KVキャッシュを使用する従来の自己回帰モデルと比較して、16ステップでの生成で最大8倍の高速化を達成。さらにキャッシュ機能を追加することで、さらなる速度向上の可能性も示唆されています。

結論

本研究では、Self-Distillation Through Time (SDTT)という新しい蒸留手法を提案し、その有効性を実証しました。

実験の結果、SDTTを用いることで従来の自己回帰型モデルと比較して最大8倍の高速化を達成しました。特に、32トークンを同時に生成できる能力を獲得し、テキストの品質も向上したことが重要な成果です。

LAMBADAベンチマークでは、教師モデルを上回る精度を示し、生成テキストの品質も改善されました。また、KLダイバージェンスを損失関数として使用することで、少ないステップ数でも高品質な生成が可能になりました。

さらに、860Mパラメータまでのモデルでスケーリング実験を行い、手法の有効性を確認しました。興味深いことに、169Mという小規模なモデルでも、64ステップ以上の生成で大きなモデルと同等以上の性能を発揮しました。

SDTTは理論証明やコード生成、アライメントなどの応用分野で、より効率的な探索や計画立案を可能にする重要な進展となりました。今後は、キャッシュ機能の追加によってさらなる速度向上が期待できます。