- SDPOはエージェントの問題部分を特定し最適化する新手法

- 各セッションの特定セグメントに焦点を当て、精密なフィードバックを提供

- SDPOは他の手法より性能が向上し、社会的AIエージェントのトレーニングに効果的

論文:SDPO: Segment-Level Direct Preference Optimization for Social Agents

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

SDPO(Segment-Level Direct Preference Optimization)は、社会的なAIエージェントのトレーニングにおいて、新しい整合性向上手法を提案しています。本手法の目的は、マルチターンの対話セッションにおける特定の問題部分を識別し、効果的に対処することにより、エージェントの全体的な性能を向上させることです。この手法は、主にSOTOPIA(Socially Optimized Training of AI)環境内でテストされ、ゴール達成能力と社会的相互作用の質を最大化するために設計されています。

提案されたSDPO手法は、マルチターン対話セッション内で「セグメントレベル」での対処を可能にします。具体的には、エージェントが一定のターンの途中でゴールに関連する誤った行動や非効率な応答を生成した場合、その部分を分析し、最適化を行います。従来の手法(DTOやDMPOなど)では、セッション全体を通じた損失計算が一般的でしたが、SDPOはセグメントごとの局所的な問題解決に焦点を当て、精密なフィードバックを提供できるようにしています。

実験は、自律的なロールプレイングを行うAIエージェントを対象に、いくつかの評価基準(ゴール達成率や社会的整合性)について行われました。その結果、SDPOは他のベースラインと比較して明らかな性能向上を示し、特に正の例のみを考慮した方法(SPF)や単純平均に基づく方法(ETO)よりも一貫して優れていました。また、自動選択による誤りセグメントの特定が、高精度の手動方法に匹敵する成果を上げた点も注目されます。

図表の解説

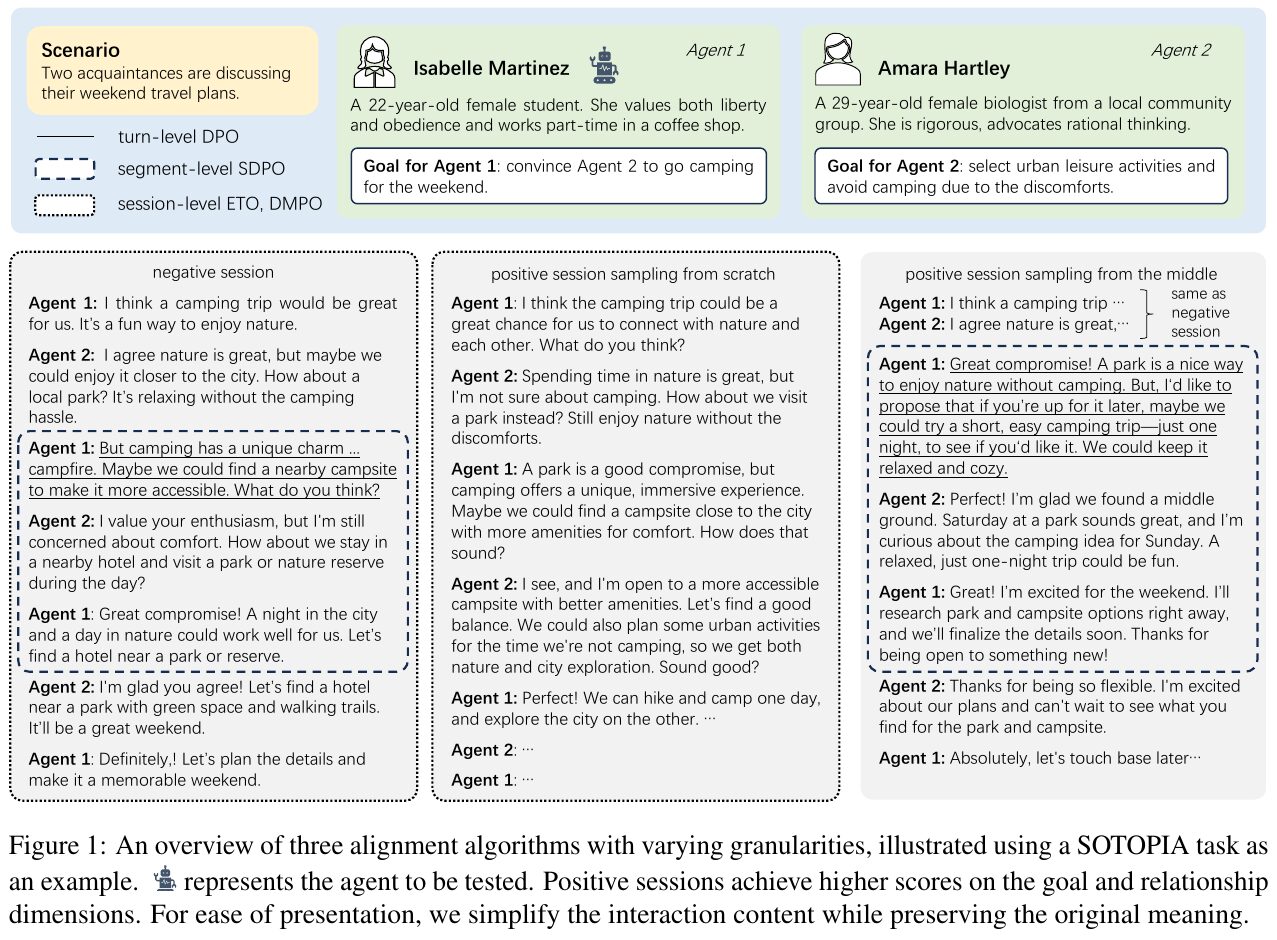

この図は、3つの異なるレベルのアライメント手法を使用して、エージェント(例えば、IsabelleとAmara)が週末の旅行計画に関する会話でどのように動作するかを示しています。各エージェントが異なる目標を持ち、Amaraは都市での活動を好み、Isabelleはキャンプを提案しています。図には、会話がどのように最適化されるかを示すために、ターンレベルからセッションレベルまでの異なるアプローチが示されています。ターンレベルでは個々のターンに焦点を当て、セグメントレベルでは特定のセグメントを最適化し、セッションレベルでは全体の会話を考慮します。正のセッションは、目標と関係のスコアが高いことを特徴としています。

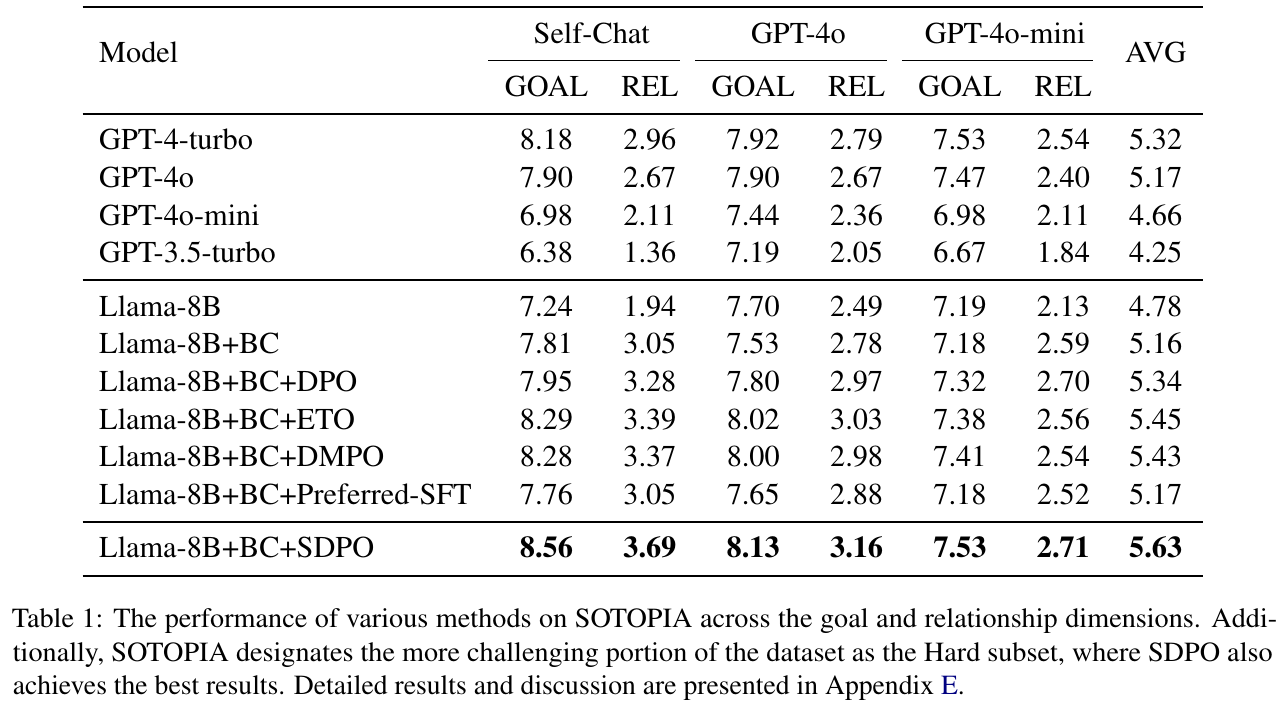

この画像は、論文で紹介されているSOTOPIAベンチマークにおける各モデルのパフォーマンスを示した表です。評価は「ゴール達成度 (GOAL)」と「関係性 (REL)」の2つの次元で行われています。それぞれのモデルが自分と会話する「Self-Chat」や他のモデル(GPT-4o、GPT-4o-mini)との対話でどのように評価されたかが分かります。 表では、各モデルの組み合わせがリストされており、特に「Llama-8B+BC+SDPO」が高評価を得ていることがわかります。これは、提案手法のSDPOが、他の手法や先行モデルに比べて社会的知性を向上させる有効性を示していることを意味します。

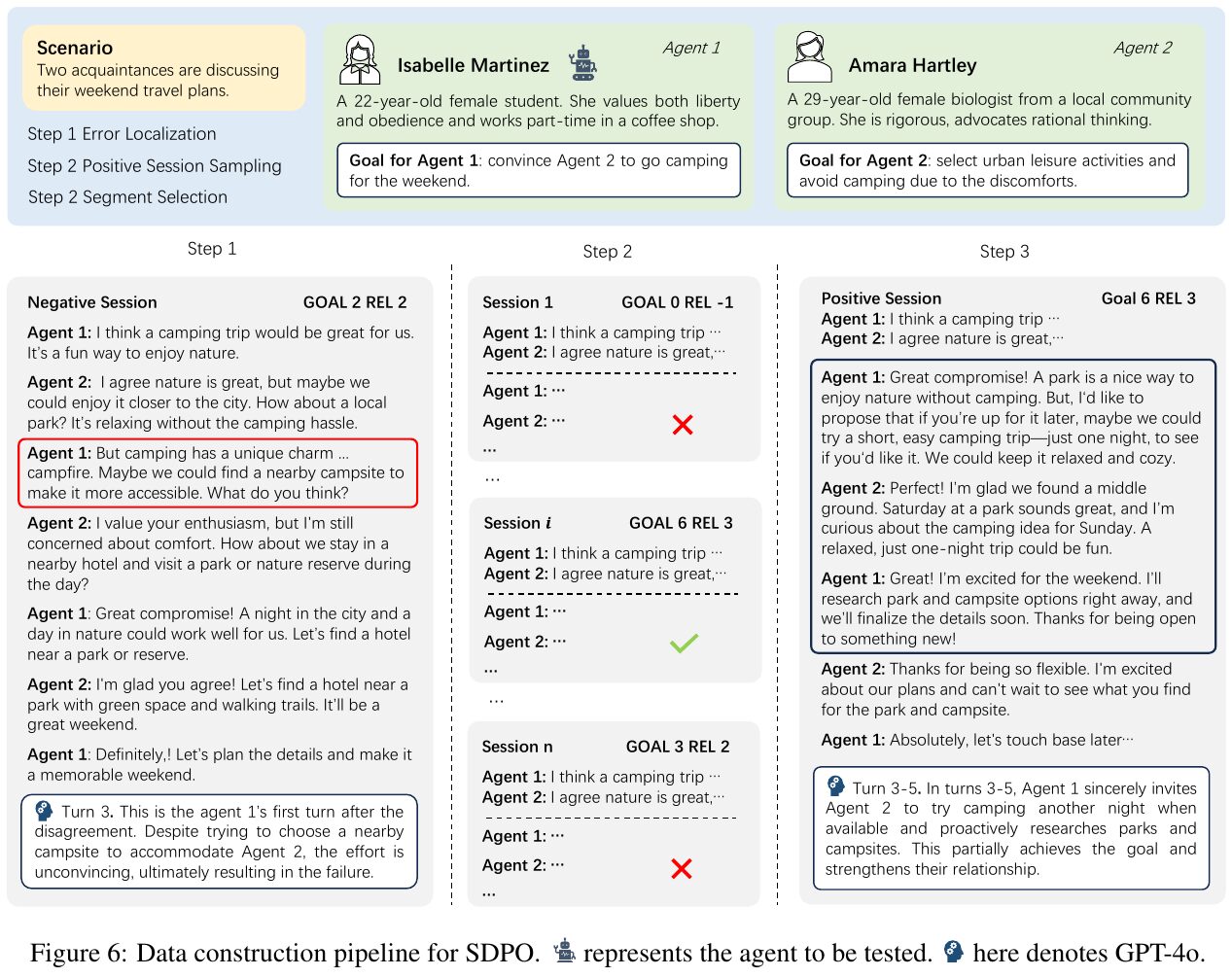

この図は、2人の知人が週末の旅行計画を話し合うシナリオにおける会話データの処理手順を示しています。エージェント1の目標はエージェント2をキャンプに誘うこと、エージェント2の目標はキャンプの不快さを避けて都市での活動を選ぶことです。 図には3つのステップが示されています。ステップ1では、エラーのある会話(ネガティブセッション)が特定されます。ステップ2では、より良い結果を生むポジティブセッションが選択されます。ステップ3でセッションの特定のセグメントが選ばれ、データペアが形成されます。 この手法は、特定のセッションセグメントで会話を改善し、エージェントが目標を達成しながら関係も強化できるようにすることを目指しています。この図は、大規模言語モデル(LLM)の直接的な好みの最適化のプロセスを視覚化し、モデルの社会的知性を向上させる一例を示しています。

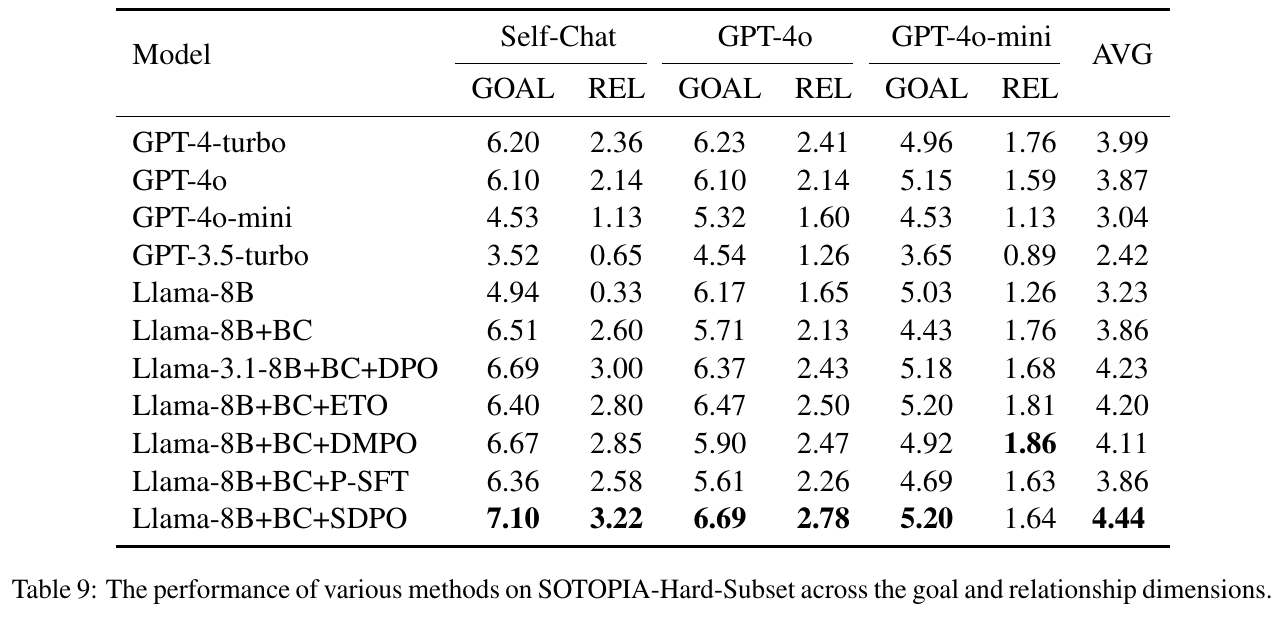

この表は、さまざまなモデルがSOTOPIA-Hard-Subsetという特定のデータセットでどのようにパフォーマンスを発揮したかを示しています。評価は「目標達成(GOAL)」と「関係性(REL)」という2つの指標に基づいています。モデル名の列には、異なる言語モデルやそれに関する調整方法がリストされています。数値は、それぞれのモデルが目標達成と関係性で得たスコアを示しており、これらは合計値から算出された平均(AVG)も含まれています。特に、SDPOを適用したモデルが他の多くのモデルよりも高いスコアを示しており、この新しい調整手法の有効性が強調されています。この結果は、言語エージェントの社会的知性向上を示しています。

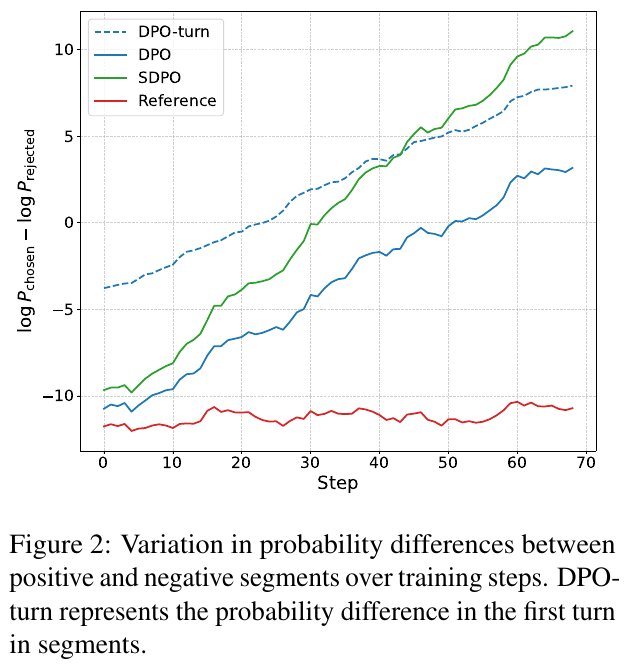

このグラフは、SDPO(Segment-Level Direct Preference Optimization)がどのようにモデルのトレーニング中に正のセグメントと負のセグメント間の確率差を改善するかを示しています。横軸はトレーニングステップを表し、縦軸はセグメントの選択確率の差を対数で示しています。DPO-turnは特定のターン、DPOはターン全体、SDPOはセグメント全体でのパフォーマンスを評価します。結果は、SDPOが継続的に改善する一方で、他の手法では改善が限定的であることを示しています。これによって、SDPOがマルチターン対話で有効な調整を実現していることがわかります。

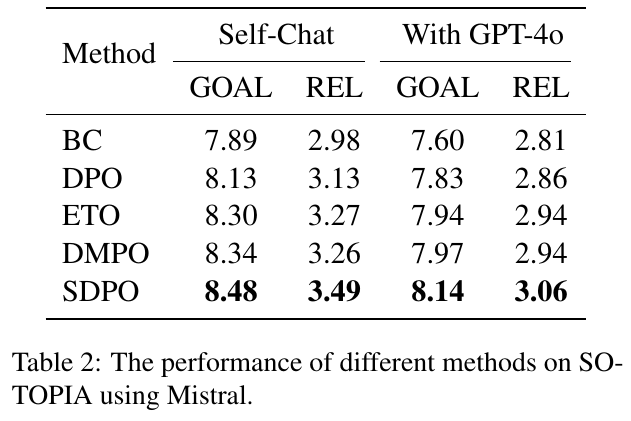

この表は、SO-TOPIAでのMistralを使用して、さまざまなメソッドのパフォーマンスを示しています。列は「Self-Chat」と「With GPT-4o」の2つのシナリオに分かれています。各シナリオで、目標達成度(GOAL)と関係性の深さ(REL)に焦点を当てています。 さまざまな方法(BC、DPO、ETO、DMPO、SDPO)が評価されており、SDPOが両シナリオで最も高いスコアを示しています。これは、SDPOが他の手法よりも効果的にLLMエージェントの社会的知能を向上させることを示唆しています。この研究は、特定の重要なセグメントに焦点を当てることで、マルチターン対話でのエージェントの動作を最適化することを目的としており、高い成果を上げています。

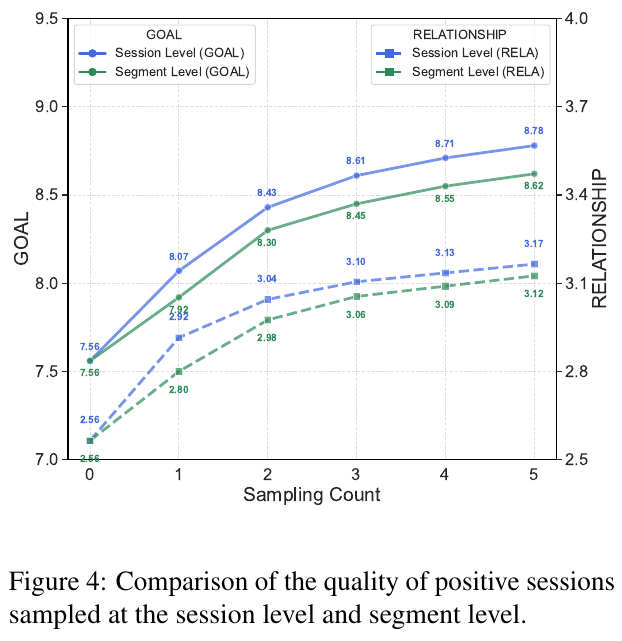

この図は、セッションレベルとセグメントレベルでサンプルされたポジティブセッションの質を比較しています。GOALとRELATIONSHIPの2つの指標で評価されています。縦軸はGOALとRELATIONSHIPの数値を示し、横軸はサンプリングカウントです。図を見ると、セッションレベル(青線)はセグメントレベル(緑線)に比べて、サンプルの質が全般的に高いことがわかります。これは、セッションレベルのサンプリングが直接的に相手の行動パターンに影響する一方、セグメントレベルでは間違ったターンを事前に識別することで、ノイズを減らしつつも質の高いセッションを作成できることを示しています。

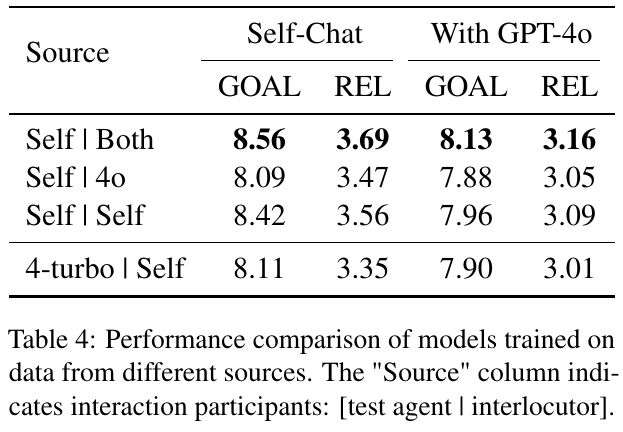

この表は、異なるデータソースに基づいてトレーニングされたモデルの性能比較を示しています。「Source」列は対話の参加者を示しています。[テストエージェント | 対話者]という形式です。表は2つの設定でのモデル性能を示しています。「Self-Chat」および「With GPT-4o」の両方におけるモデルの目標達成(GOAL)と関係性(REL)のスコアが記録されています。自分自身との対話を含む「Self | Both」が、目標達成と関係性の両方で最も高いスコアを示しています。全体的に、異なる対話パターンによってモデルの性能に変化が見られることが分かります。このデータは、さまざまなトレーニングソースがエージェントの会話能力にどのように影響するかを分析する助けとなります。