- 科学的実験とモデル発見を支援するフレームワーク「Boxing Gym」を提案

- エージェントが実験設計や結果解釈、新しい仮説の提案を学習する環境を提供

- 言語モデルの活用で科学データ解釈や知見説明を支援しつつ、エージェントの限界を報告

論文:BoxingGym: Benchmarking Progress in Automated Experimental Design and Model Discovery

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

この論文では、科学分野における自動化された実験設計とモデル発見を支援するフレームワーク「Boxing Gym」を提案しています。このフレームワークは、機械学習エージェントの能力を実践的かつシミュレーション環境で評価するために設計されました。「Boxing Gym」では、科学的なモデル作成プロセスにある重要な要素、すなわち実験の設計、実験からの結果の解釈、そして新しい仮説の提案を支援するためのベンチマーク環境が提供されます。

このフレームワークの主な特徴は、エージェントが以下のような行動を学習し、評価できる点にあります:

- モデルの精度を向上させるために情報価値を活用する能力(Expected Information Gain)。

- 言語ベースのインターフェースを通じて科学データを解釈し、新しい知見を言語で説明する能力。これは特に、LLM(大規模言語モデル)の活用を想定しています。

実験では、GPT-4などのLLMを基本としたエージェントの性能を測定し、「Box’s Apprentice」というプログラム合成能力を備えたエージェントと比較しています。その結果、エージェントが実験を重ねるごとに予測精度が向上するケースが確認されましたが、すべてのタスクで均一に効果が現れるわけではありませんでした。特に、科学的モデルにおける複雑な構造を扱う際にエージェントの限界が顕著になったと報告されています。

実験デザインに関しては、情報価値を最大化するような実験の選択が重要であるとされていますが、LLMはその過程で過剰適合(overfitting)を引き起こす可能性が指摘されています。一方、「Box’s Apprentice」を用いた場合、コード生成機能を通じてより具体的かつ明確なモデル評価が可能となり、より一貫した性能向上が見られました。

図表の解説

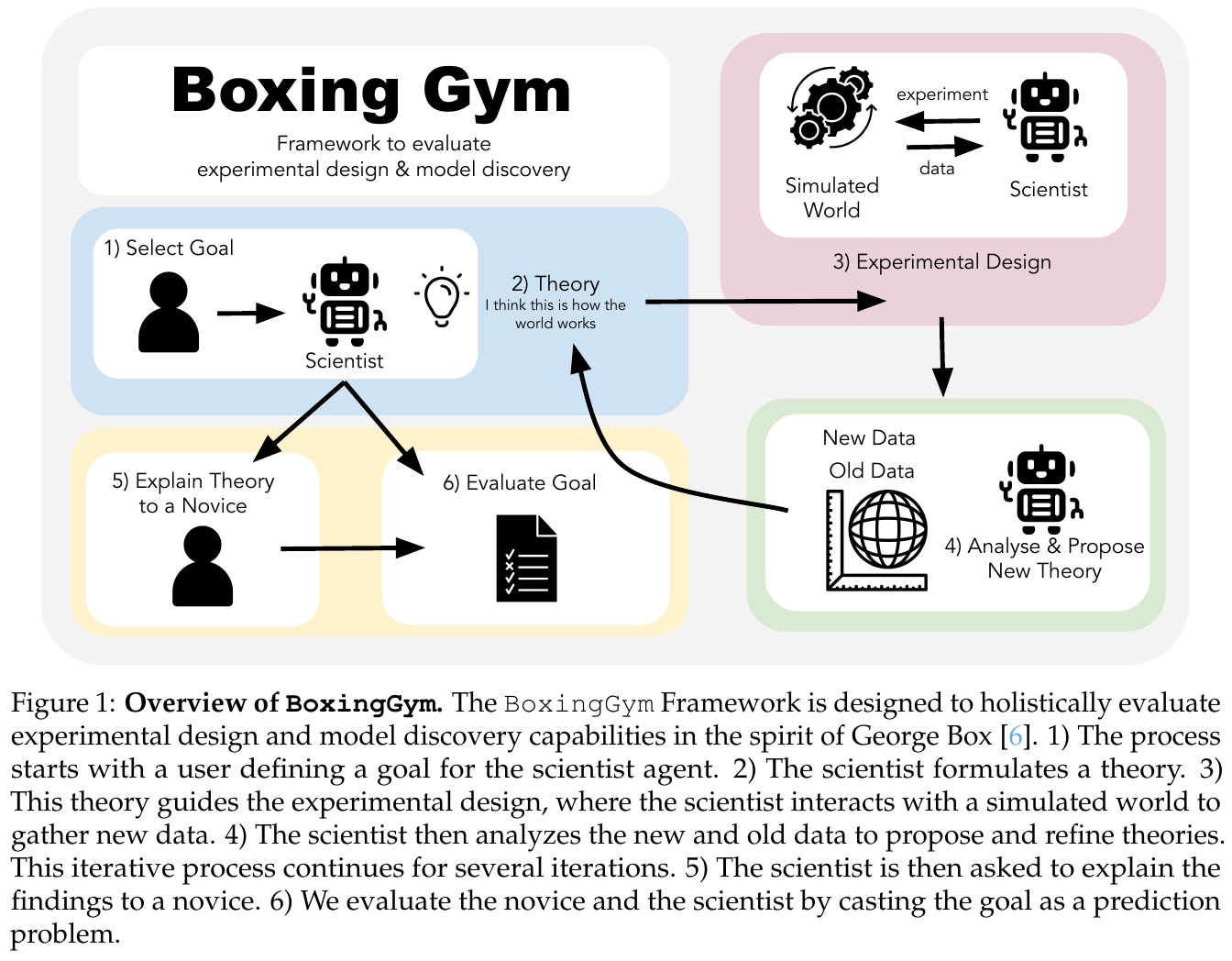

図に示されている「BoxingGym」フレームワークは、科学的な実験設計とモデル発見の能力を包括的に評価するために設計されています。まず、ユーザーが科学者エージェントに目標を設定します(1)。次に、科学者は理論を立て(2)、その理論に基づいて実験を計画します(3)。科学者はシミュレートされた世界と対話し、新しいデータを収集し、分析して新しい理論を提案します(4)。このプロセスは何度も繰り返されます。科学者はこの理論を初心者に説明し(5)、最後に設定した目標をもとにその理論の予測能力を評価します(6)。この図は、科学的変数の未確定項を減らし、新しいデータに基づいて理論を改善する反復的なプロセスの重要性を示しています。

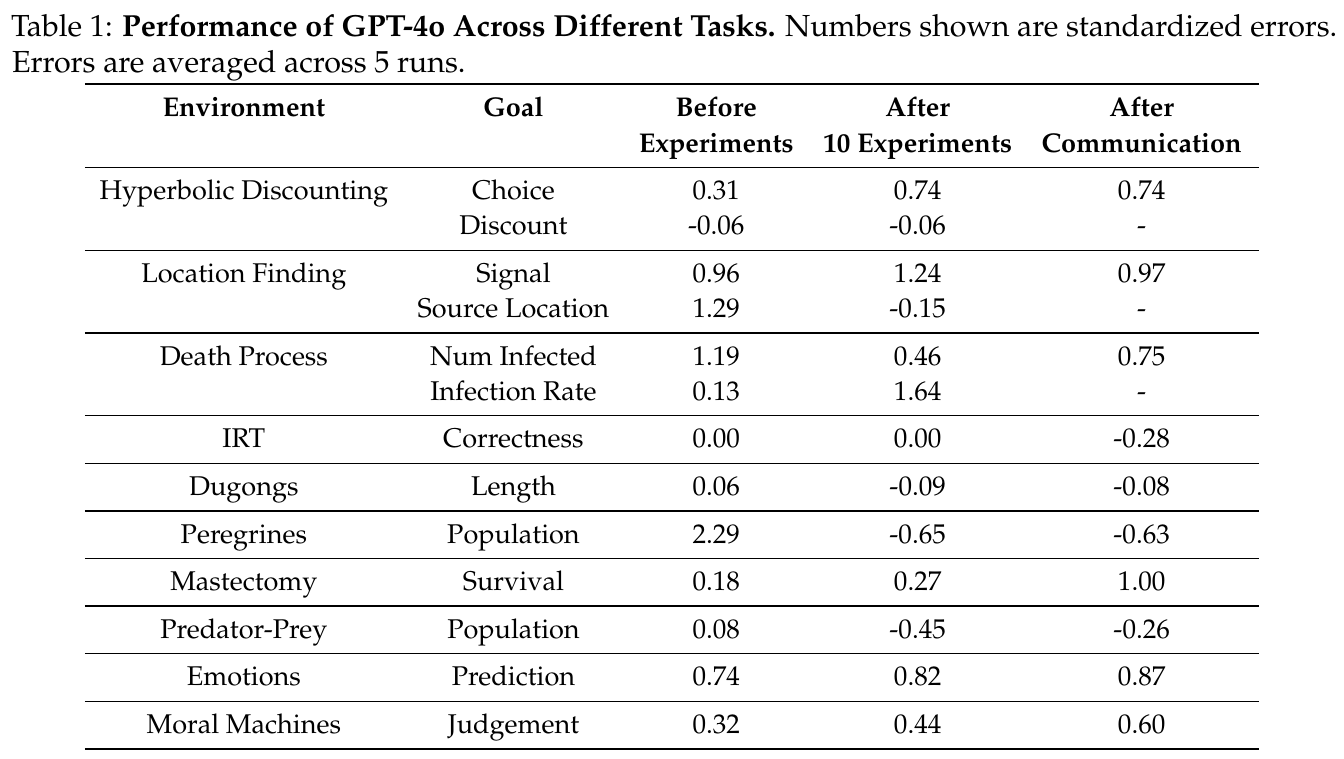

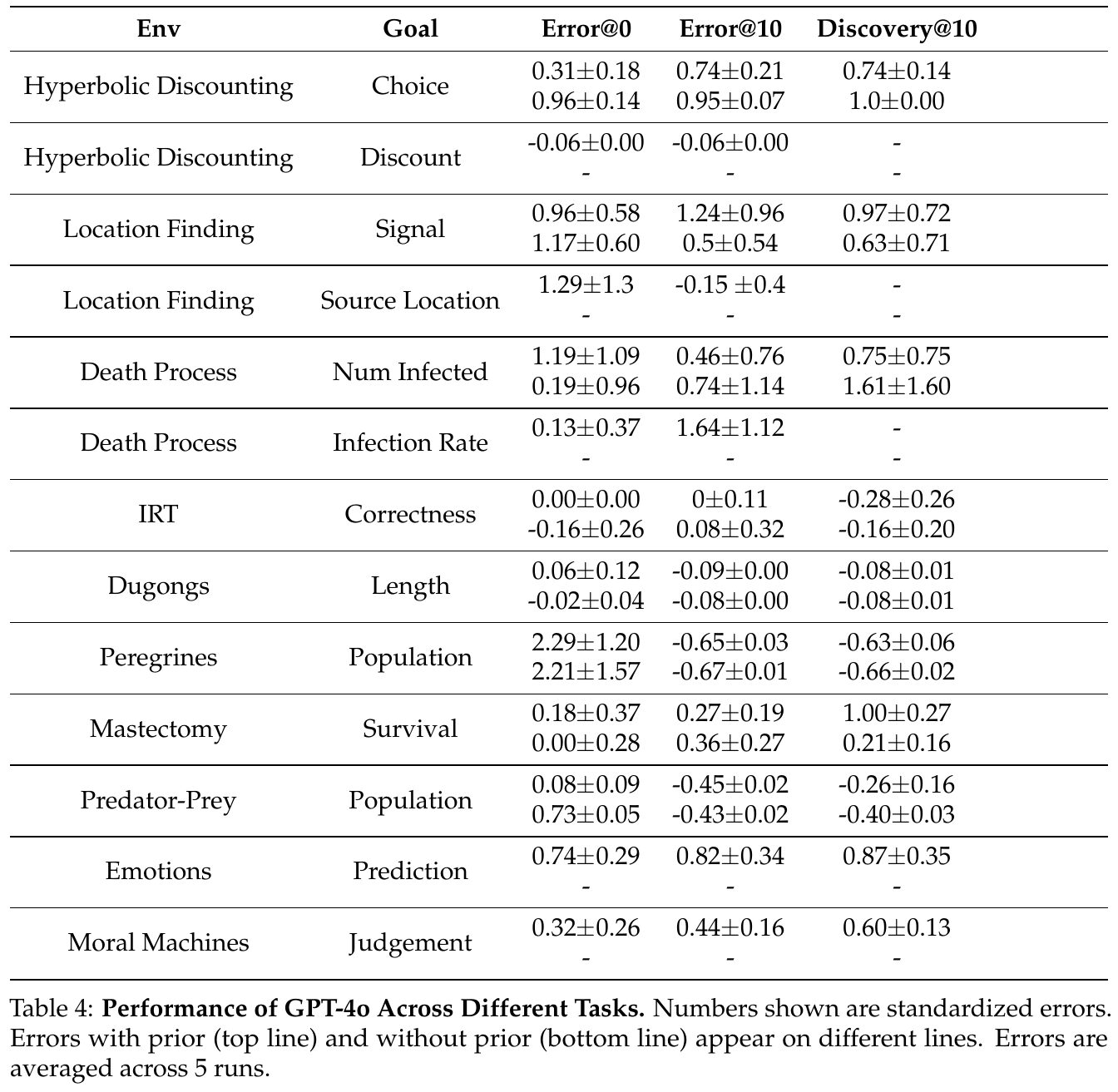

この表は、GPT-4oがさまざまな環境でどのようにパフォーマンスを発揮したかを示しています。評価は、実験前、10回の実験後、そしてコミュニケーション後の3段階に分かれています。数値は標準化された誤差を示し、5回の試行の平均です。 例えば、ハイパーボリック割引環境では、選択に関する誤差は実験前に0.31、実験後とコミュニケーション後に0.74となり、改善されています。一方、ロケーションファインディングでは、信号の誤差が実験前は0.96、実験後1.24で、その後0.97に改善されました。感染プロセスでは、感染者数の誤差が1.19から0.46、さらに0.75に改善されています。 これらの結果は、GPT-4oが各環境での学習やデータをもとにモデルを調整する方法を評価するためのものです。多くの場合、実験を通じて誤差は減少し、適切に情報を活用できたことを示しています。

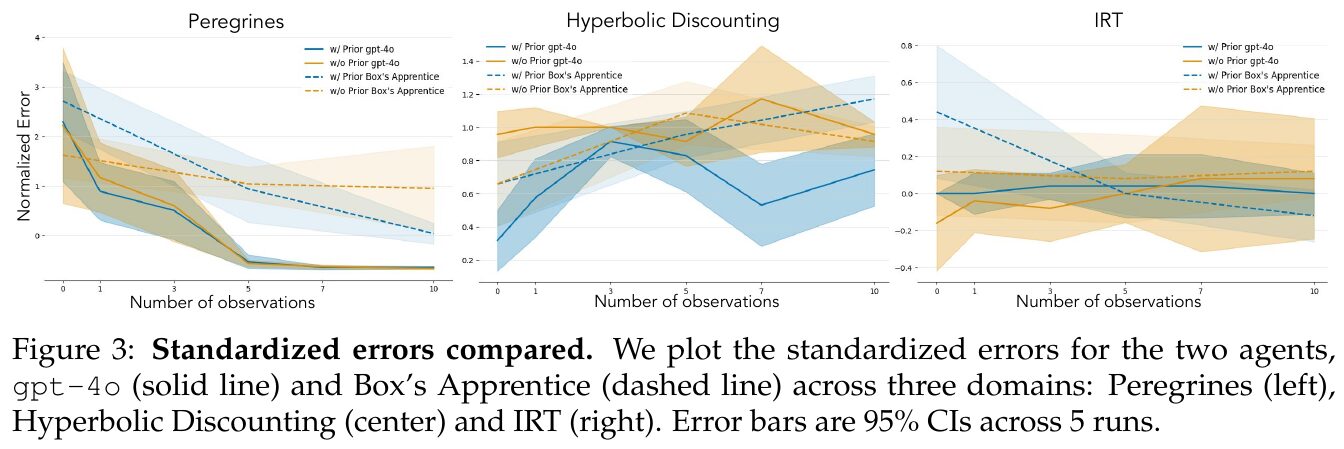

この図は、Peregrines、Hyperbolic Discounting、IRTという三つのドメインにおける、gpt-4o(実線)とBox’s Apprentice(破線)という二つのエージェントの標準化エラーを比較しています。エラーは、観測回数に応じて変化し、グラフでは5回の試行における95%信頼区間が示されています。Peregrinesドメインでは、観測が増えるにつれてエラーが減少し、特に既存の知識が適用される状況で誤差がより顕著に低下しています。Hyperbolic Discountingドメインでは、観測増加が必ずしも精度向上に寄与せず、むしろ誤った修正を引き起こすケースも見られます。IRTドメインでは、エージェントによる説明が他エージェントの予測を補助する効果がある一方で、試行数が少ない場合の観測不足が精度を制限しています。

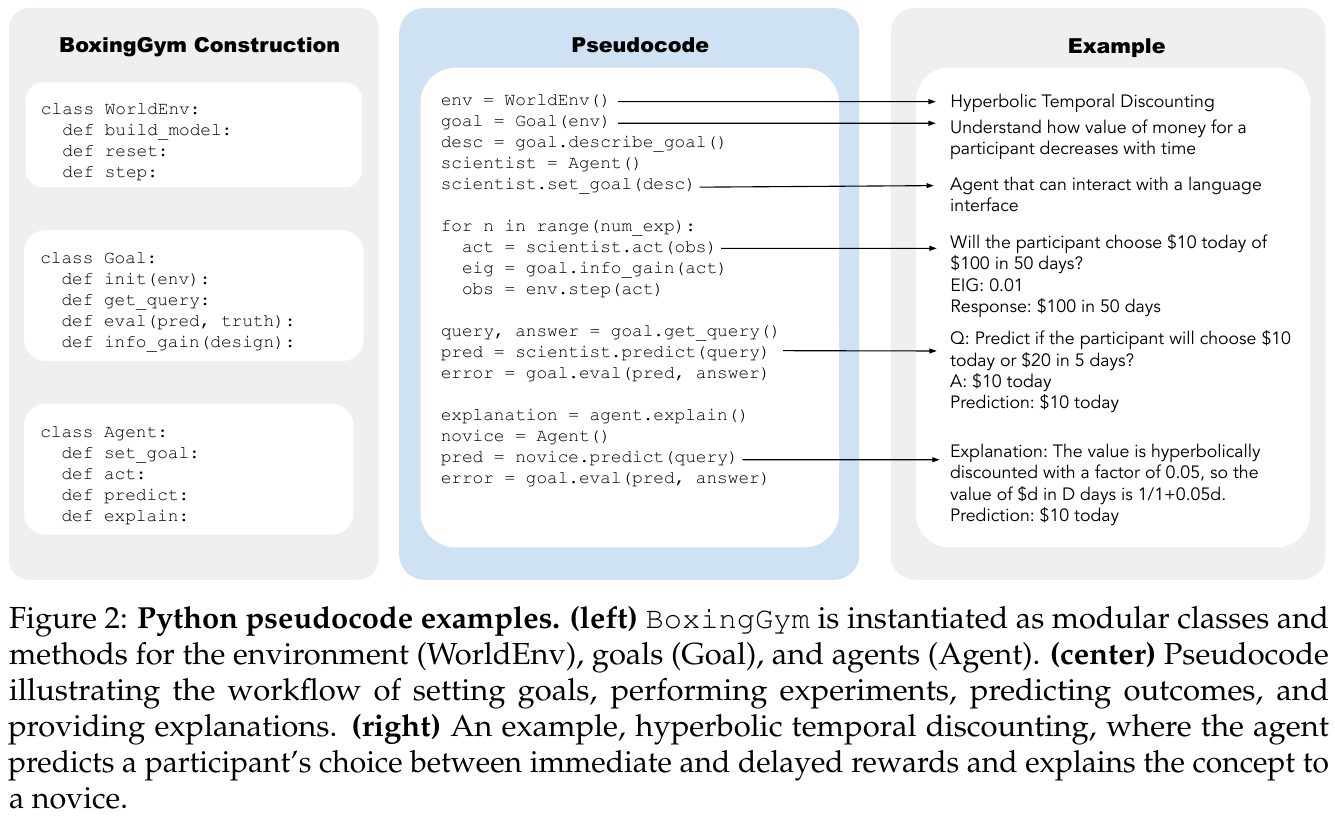

この画像は、BoxingGymというフレームワークにおけるPythonの擬似コード例を示しています。左側では、環境(WorldEnv)、目標(Goal)、エージェント(Agent)をモジュールクラスとして構築しています。中央の擬似コードは、目標設定、実験実施、結果予測、説明提供の流れを示しています。右側の例では、将来の報酬に対する選択を予測する「双曲割引」を用いて参加者の価値選択を解説しています。このフレームワークは、エージェントが目標に基づいて実験設計を行い、それを予測し説明するプロセスを扱います。これにより、初心者にもわかりやすい形で報酬選択の概念が伝わります。

この図は、GPT-4oが異なるタスクでどのようにパフォーマンスを発揮するかを示しています。各行は、異なる環境と目標を示し、それに対する平均エラーを3つの段階で示しています:「Error@0」は実験前、「Error@10」は10回の実験後、「Discovery@10」は知見をもとにした予測の正確さを示しています。それぞれの値は標準化されたエラーで、実験を5回行った結果を平均したものです。上段は事前情報を与えた条件、下段は事前情報なしの条件を示しています。エラーが小さいほど、モデルの予測が正確であることを意味します。この図を通して、GPT-4oの実験設計とモデル発見能力の限界や課題が浮き彫りになっています。

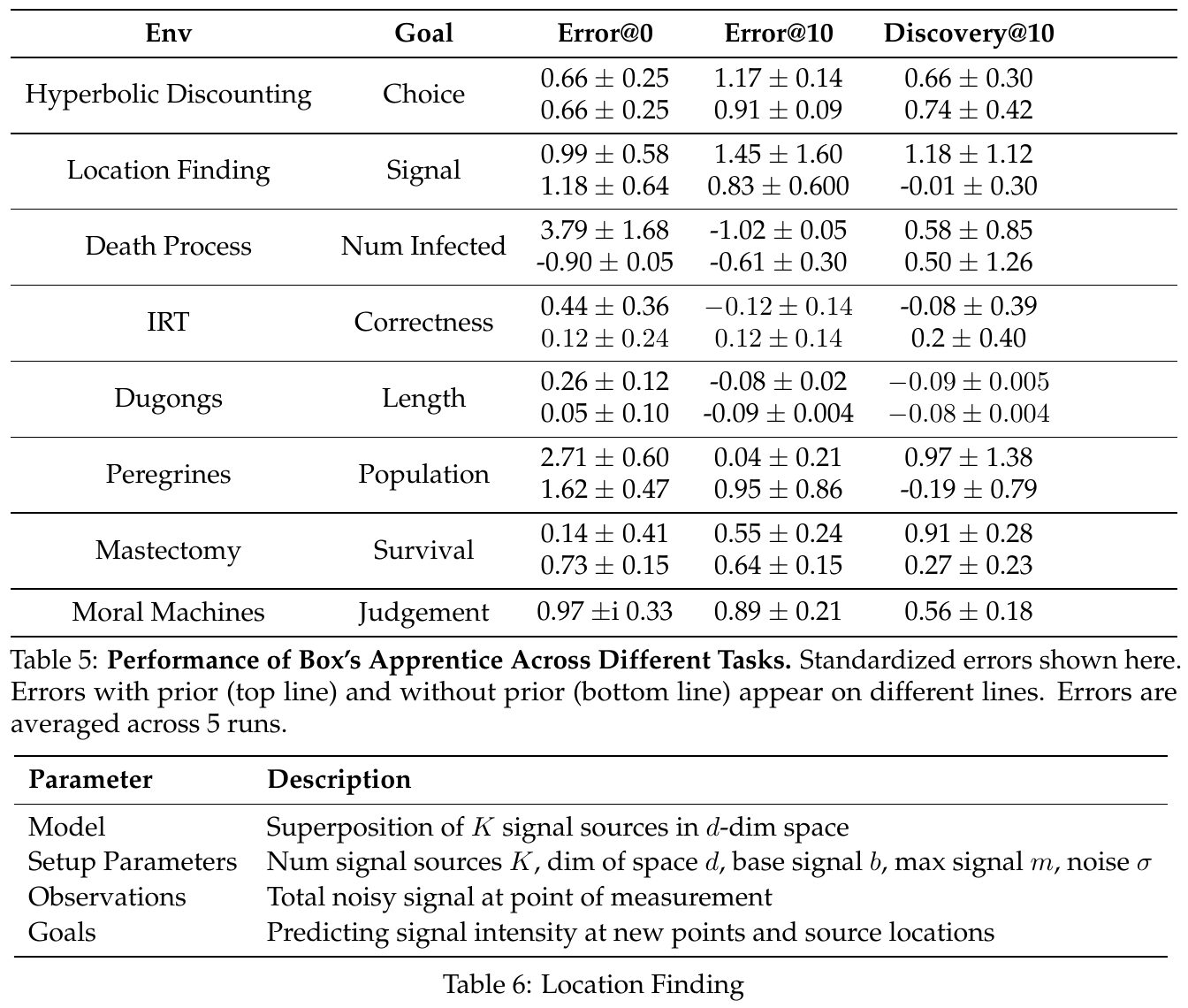

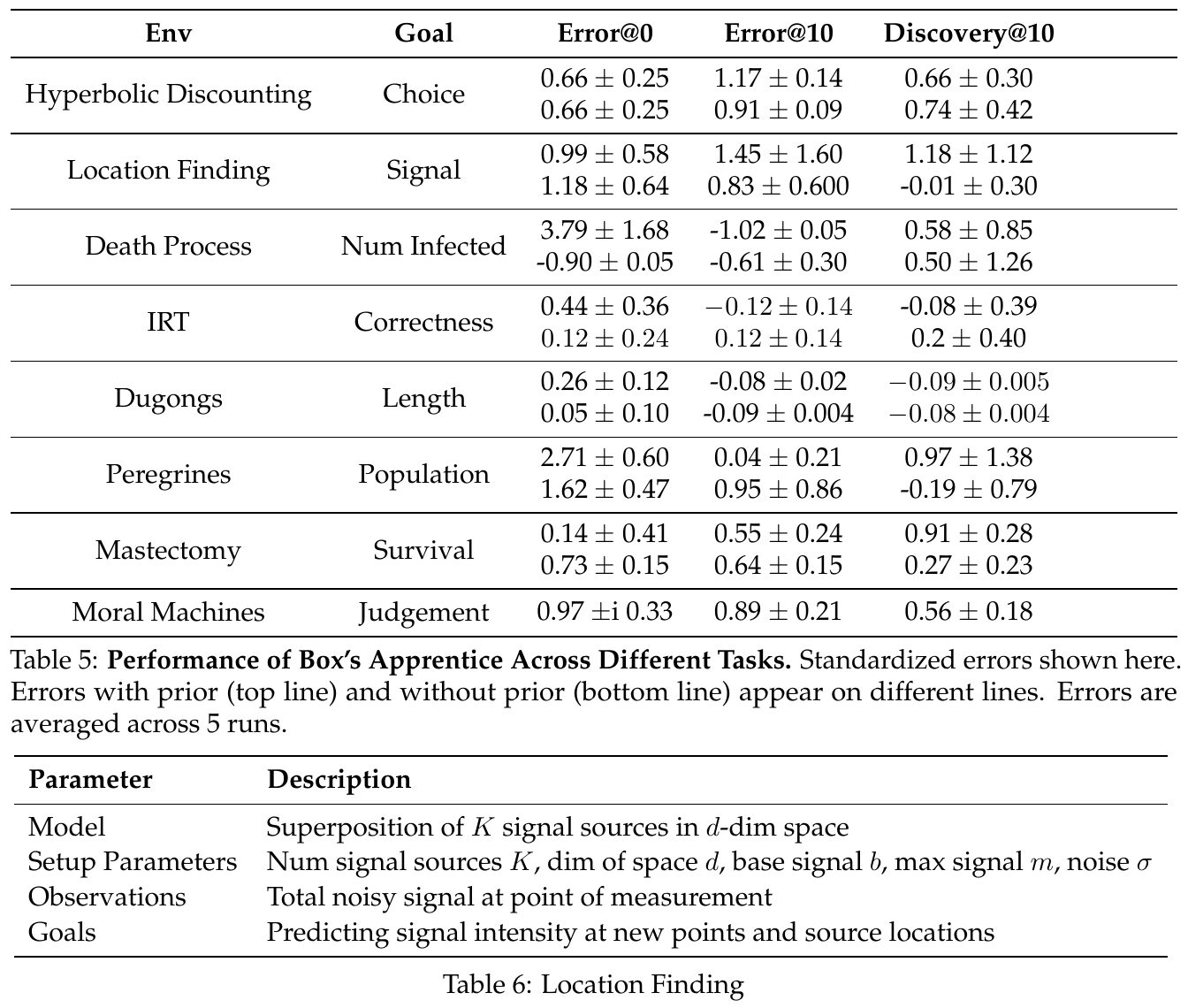

この画像は、論文の一部として示された表で、Box’s ApprenticeというAIエージェントの異なるタスクにおけるパフォーマンスを評価しています。表には、具体的な環境(Env)とその目標(Goal)、そして異なる条件下でのエラー率が記載されています。エラー率は、実験の回数(0回目、10回目)および10回目の発見率に基づいています。上の行は事前情報を使用した場合、下の行は事前情報なしの場合の結果を表しており、エラーは5回の試行の平均です。これにより、AIエージェントのタスク適応能力や情報活用の効果を検証しています。

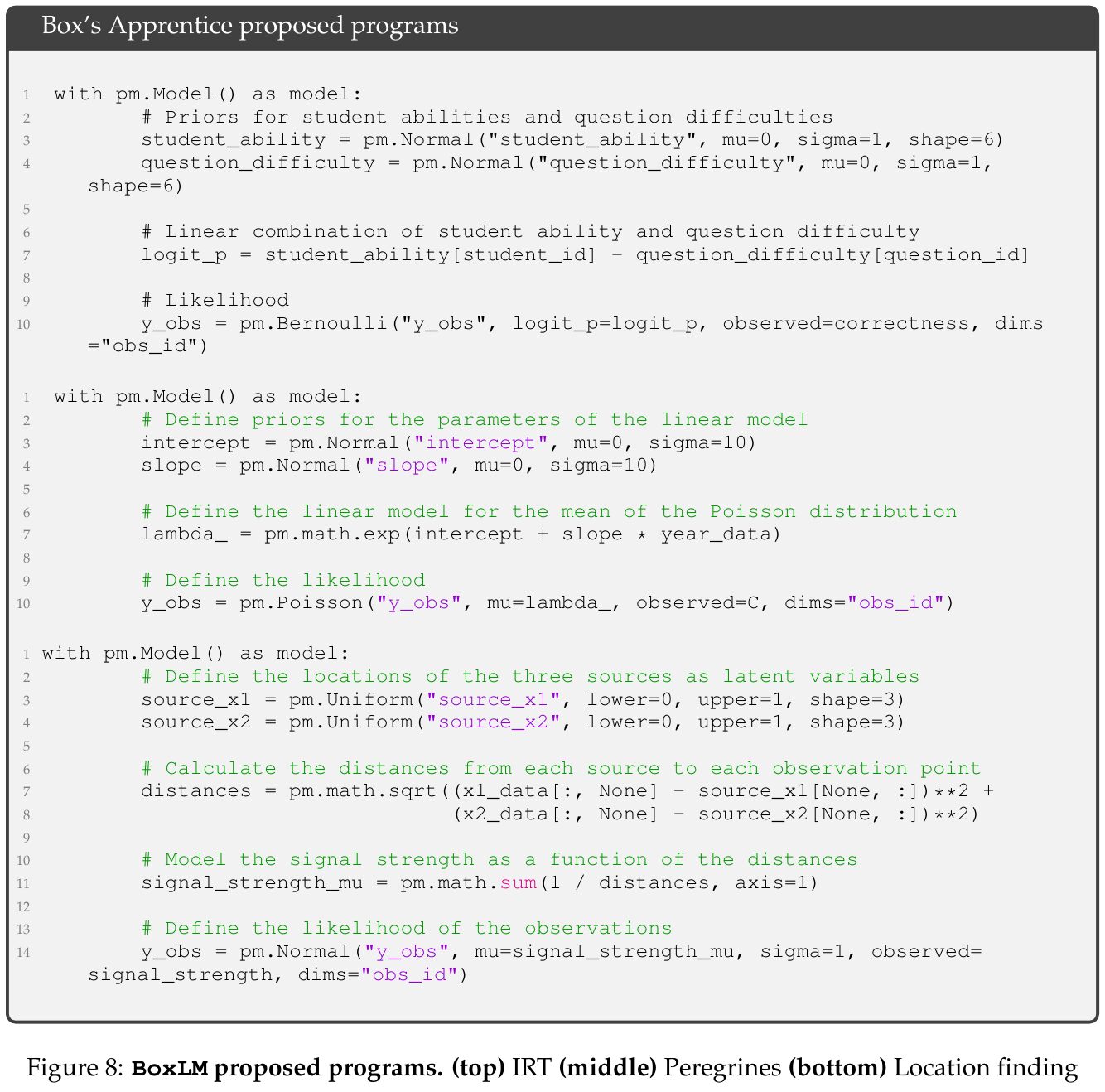

この図は、Box’s Apprenticeというプログラムによる3つのモデルの提案を示しています。まず、一つ目のモデルはIRT(項目応答理論)に基づき、学生の能力と問題の難易度を考慮して、学生が問題を正解する確率を分析します。次に、二つ目は線形モデルを用いてポアソン分布の平均を定義し、観測データに基づいた予測を行います。最後に、三つ目は信号の強さに基づいて信号源の位置を推定するモデルです。これらのモデルはそれぞれ異なる問題設定に適用され、科学的な実験設計およびモデル発見の評価に役立てられます。紙面に記載されている「BoxingGym」というフレームワークの一部として使用されます。

この図は、Box’s Apprenticeというモデルが異なる科学タスクにおけるパフォーマンスを示しています。このテーブルでは、異なる環境(Env)での目標(Goal)と、エラーが3つの異なる時点で計測されています:Error@0(初期エラー)、Error@10(10回の試行後のエラー)、Discovery@10(10回の試行後の発見の精度)。各エラーは標準化された値で示され、括弧内の数値は標準偏差を示しています。上段の行は事前情報を用いた結果を示し、下段の行は事前情報なしでの結果です。 異なる環境における Box’s Apprentice の比較パフォーマンスは、「事前情報あり」と「なし」で異なり、これが科学実験やモデル発見においてどの程度助けになるかを測定しています。また、Table 6は「Location Finding」の詳細を示し、信号強度を新しいポイントやソース位置で予測することを目指しています。