- LTX-Videoモデルは高品質な動画生成をリアルタイムで実現する技術

- Video-VAEによる潜在空間への圧縮で計算コストを削減する手法

- 視覚品質と計算効率を両立し、ハードウェア効率化も考慮された設計

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

論文「LTX-Video: Realtime Video Latent Diffusion」では、高品質な動画生成をリアルタイムで行うための新しいモデルを提案しています。このモデルは主に、テキストからの動画生成や静止画から動画への変換を目指しており、視覚的な精度や速度において優れた性能を発揮しています。

モデルの中心となる方法は、まず「Video-VAE」と呼ばれる潜在空間への圧縮技術を導入して、時間的および空間的に効率的なデータ処理を可能にしています。これにより、動画データをピクセル単位からより抽象的な潜在表現へと変換し、計算コストを大幅に削減しました。また、Transformerブロックを活用し、拡張したRoPE位置埋め込みや正規化手法を組み合わせることで、効率的な生成プロセスの実現を図っています。その結果、これまでのモデルに比べて生成速度が大幅に向上し、品質と計算効率のバランスが取れた性能を誇ります。

実験結果では、他の最新動画生成モデル(例:MovieGenやRunway Vid2Vid)と比較して高い評価を得ており、特にプロンプトへの忠実性、視覚品質、時間的一貫性の点で優位性を示しました。さらに、計算負荷を軽減するハードウェア効率化も考慮されており、消費資源が限られた環境でも動画生成を可能にしています。

本モデルはオープンソースとして公開されており、様々なアプリケーション(例えば、創作、映画制作、プロトタイピングなど)への応用が期待されています。

図表の解説

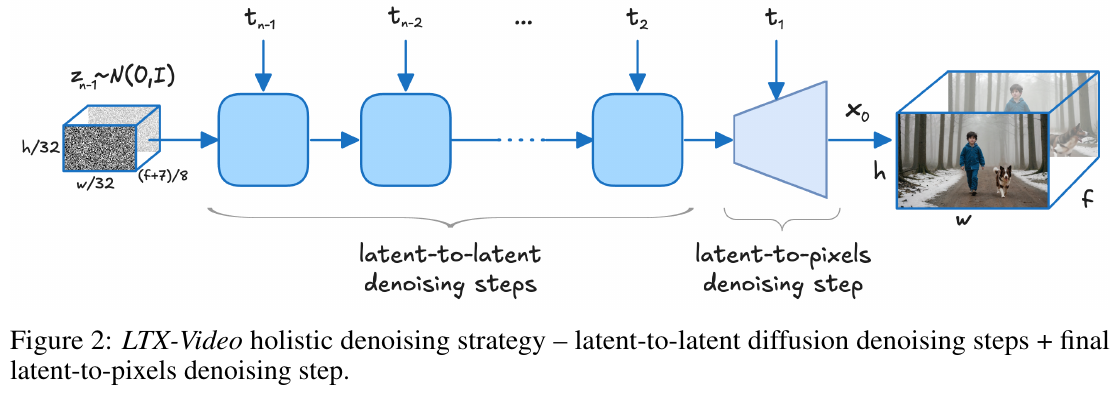

この図は、LTX-Videoの全体的な除去ノイズ戦略を示しています。まず、ランダムノイズから始まり、潜在空間内でノイズ除去を段階的に行う「潜在対潜在」のステップが続きます。その後、「潜在対ピクセル」の最終ステップで潜在空間からピクセル空間への変換を行い、クリーンな結果を得ます。この方法により、詳細を保持しつつ効率的に高品質の映像を生成することが可能です。

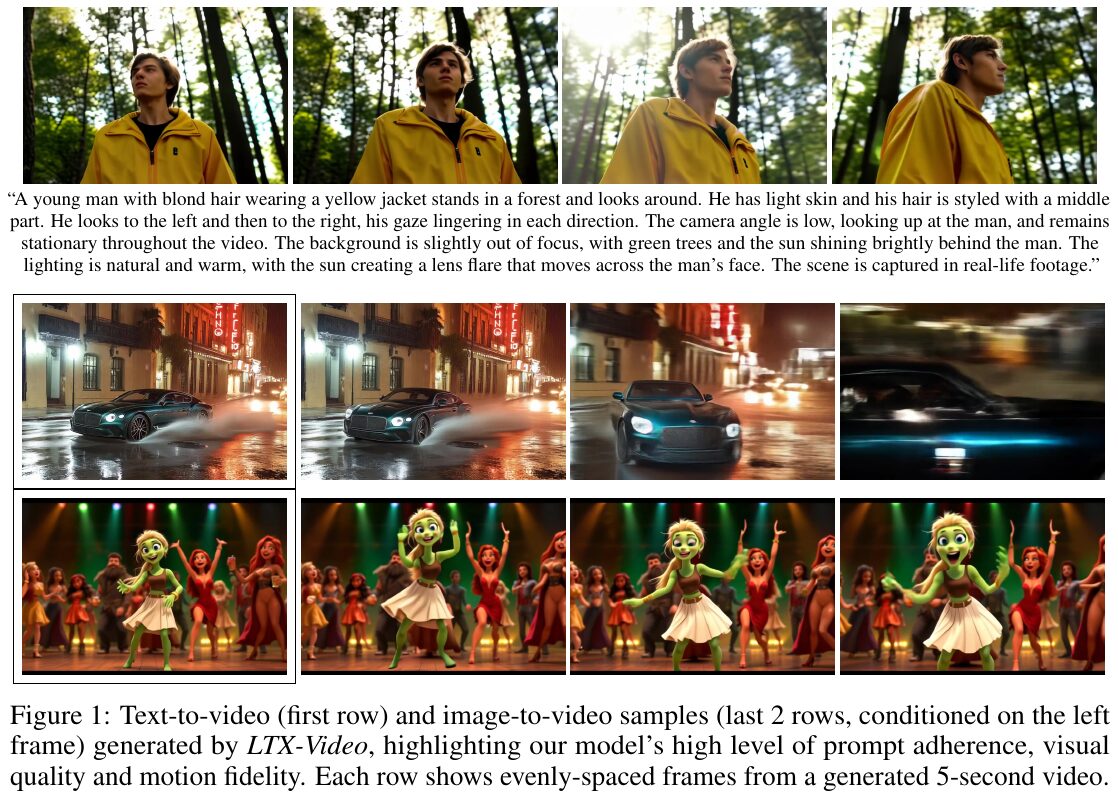

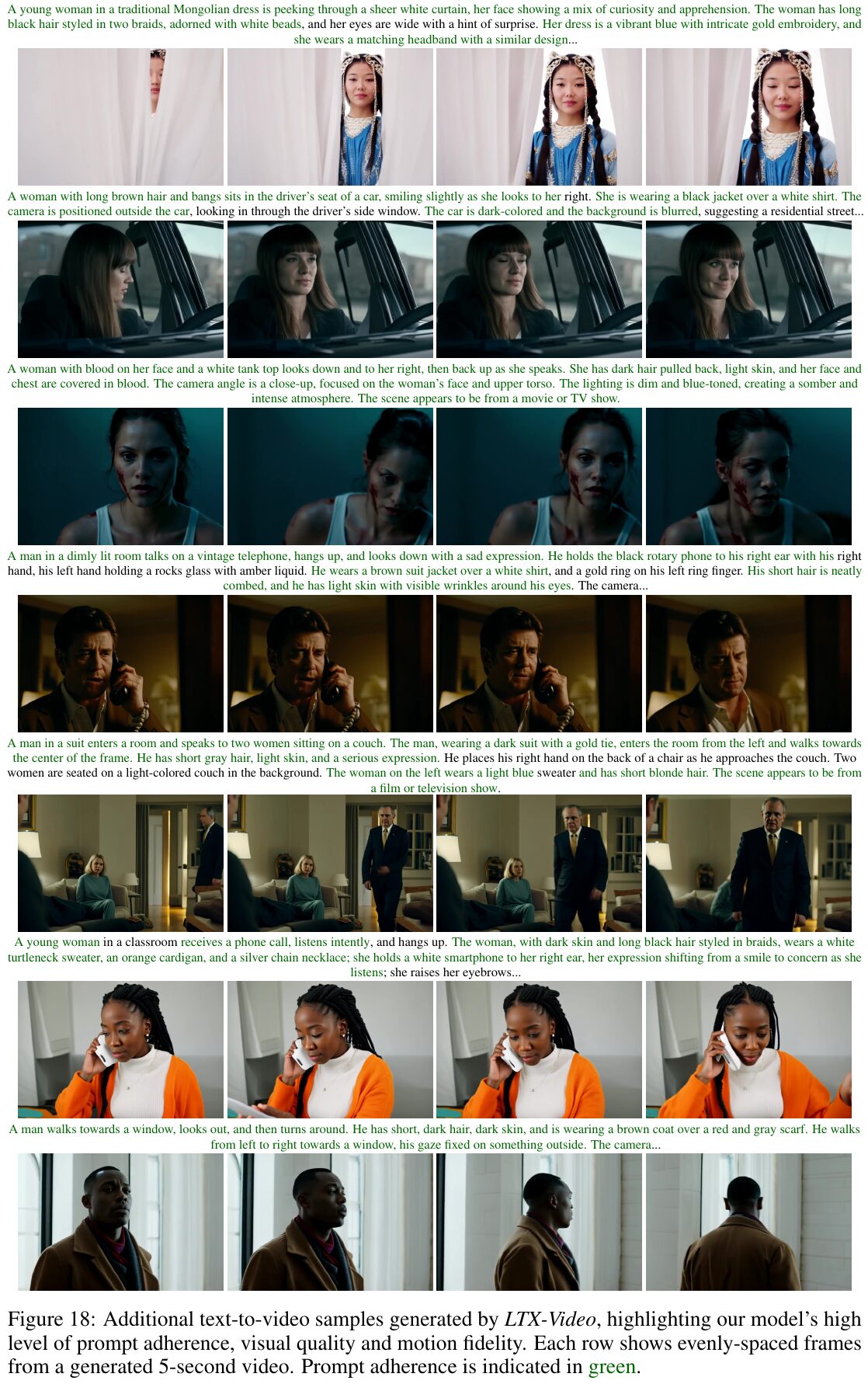

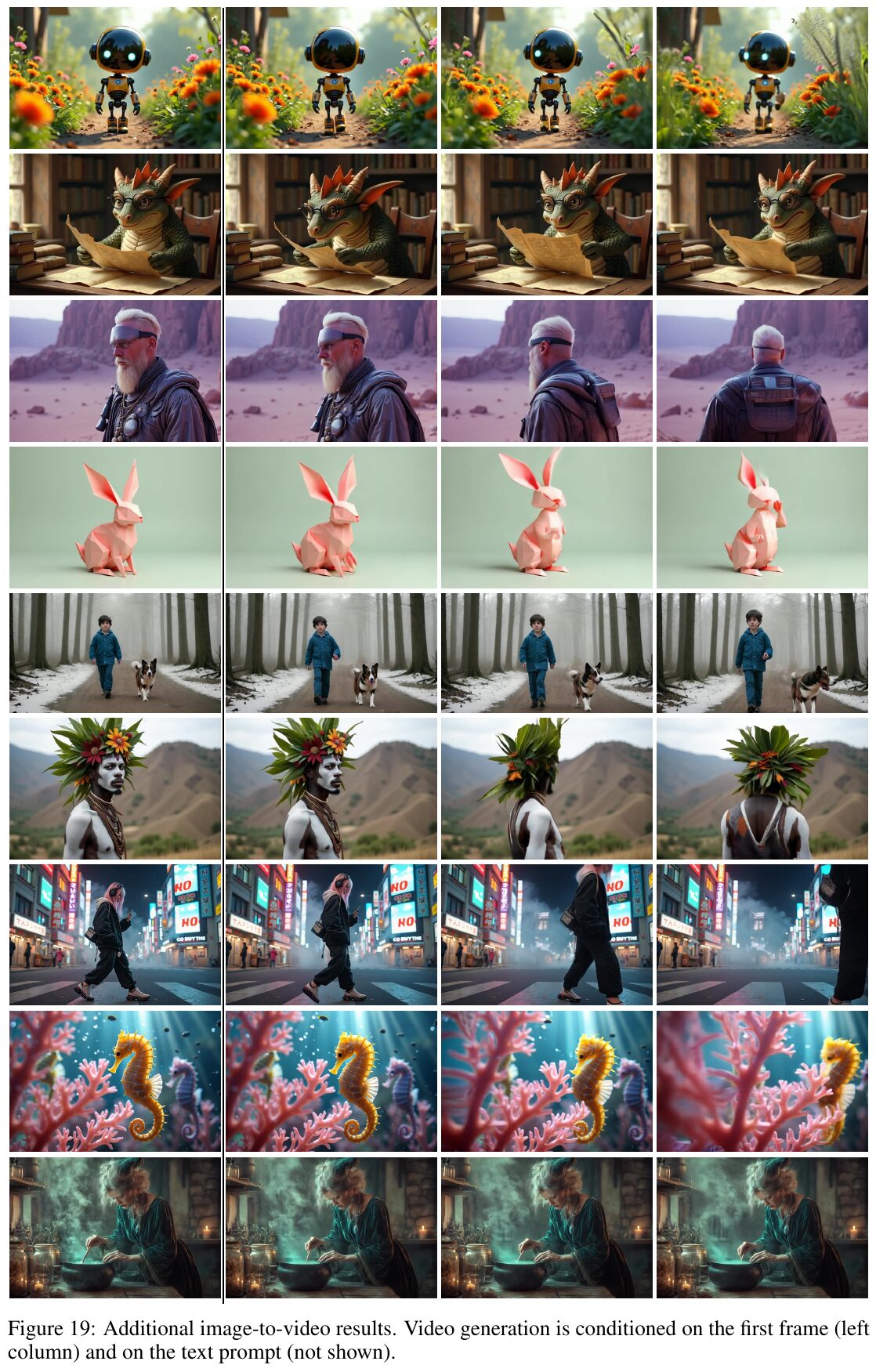

この画像は、LTX-Videoというモデルによって生成された映像サンプルを示しています。上段はテキストからビデオへの生成例、下段は画像を条件としたビデオ生成例です。これらのサンプルから、LTX-Videoモデルの高いプロンプトの追従性、視覚品質、動きの忠実度が確認できます。各行は、生成された5秒間のビデオから均等に間隔をあけたフレームを示しています。

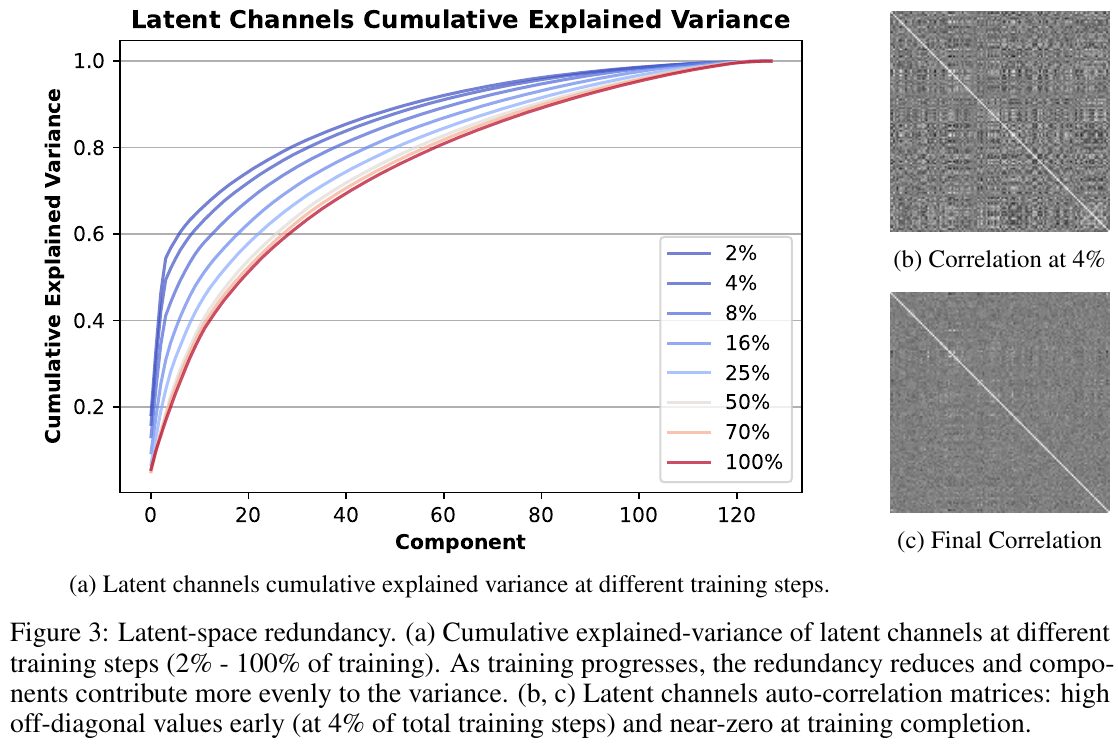

この図は、LTX-Videoモデルの学習過程における潜在空間の冗長性を示しています。(a)のグラフは、学習の異なるステップでの潜在変数が累積的に説明する分散を示しています。ステップが進むにつれて、冗長性が減少し、各成分が均等に分散に寄与するようになります。(b)と(c)の相関行列は、学習初期(4%)ではオフダイアゴナルの値が高く、学習が完了するとほぼゼロになることを示しています。

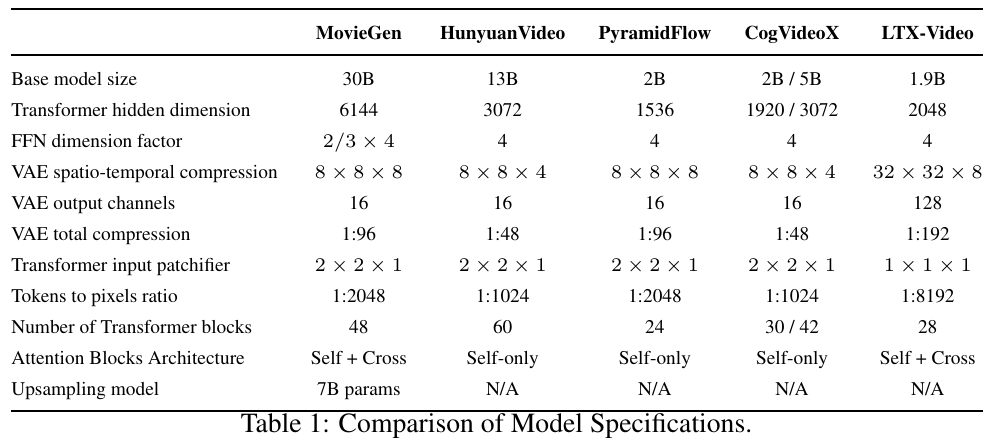

この表は、複数のビデオ生成モデルの仕様を比較しています。表ではMovieGen、HunyuanVideo、PyramidFlow、CogVideoX、LTX-Videoという5つのモデルを取り上げています。各モデルのベースモデルサイズ、変換器の隠れ次元、FFNの次元要因、VAEの圧縮率、変換器の入力パッチファイア、トークン対ピクセル比、変換器ブロックの数、注意ブロックのアーキテクチャなどが示されています。LTX-Videoは高圧縮率と高効率性に特化したモデルです。

この画像は、LTX-Videoを用いたテキストから動画生成のサンプルを示しています。各行は生成された5秒の動画のフレームを等間隔で並べたものです。これにより、モデルの命令に対する高い忠実度、視覚品質、そして動きの再現性が強調されています。各ケースは、多様なシナリオにおけるモデルの性能を示す例です。緑の文字はプロンプトの一部として提供された説明です。

この画像は、LTX-Videoというモデルが生成した「画像から動画」変換の結果を示しています。動画生成は、左の最初のフレームに基づいて行われ、未表示のテキストプロンプトも条件として使用されています。このモデルは、初期フレームを条件にすることで、入力画像を動画へと自然に拡張できることを示しています。結果は、モデルの高い視覚品質と忠実な動き表現を強調しています。

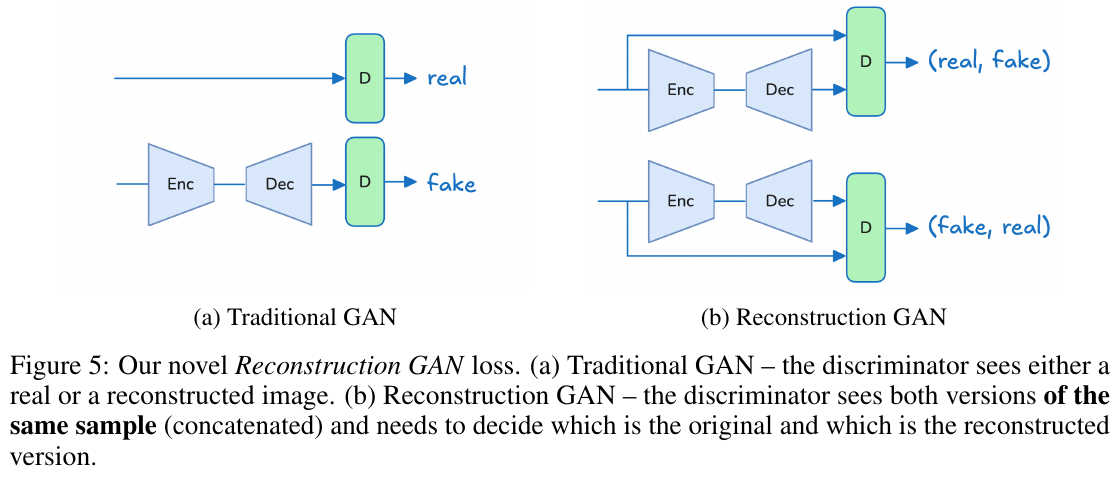

これは図5で、「Reconstruction GAN」に関する説明です。図(a)では、従来のGANが確実に本物か再構築された画像かを識別する方法を示しています。図(b)では「Reconstruction GAN」が示され、ここでディスクリミネーターは、同じサンプルの2つのバージョン(本物と再構築版)を同時に見て、それらを判別する必要があります。この手法は、再構築品質を向上させるための工夫です。

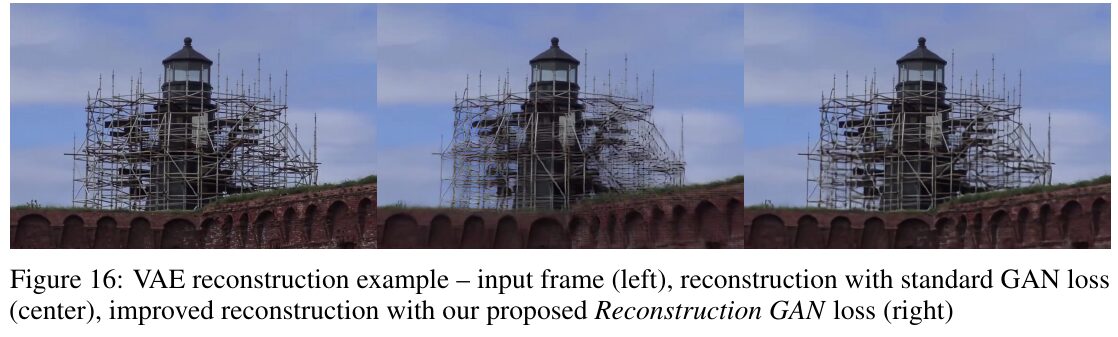

この画像は、VAE(変分オートエンコーダ)の再構築例を示しています。左側が入力フレームで、中央は標準的なGAN損失を使用した再構築です。右側が「Reconstruction GAN損失」を用いた改良された再構築です。この新しい損失関数によって、再構築の質が大幅に向上し、詳細がより鮮明に保存されていることが示されています。特に速い動きや細かいディテールがある状況で効果的です。