画像

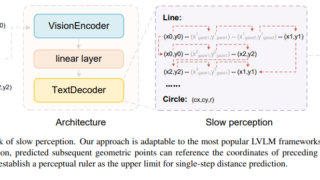

画像 複雑な幾何学図形を認識する「Slow Perception」の提案

複雑な幾何学的図形を認識できる「Slow Perception」を提案。図形を線と点で段階的に予測し、復元精度を向上させる。人間の視覚認識に近い逐次的認識プロセスを用いて、精度と理解性を向上させるモデルを構築。

画像

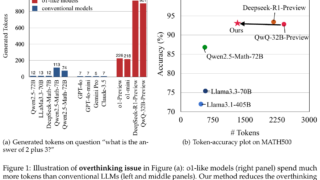

画像  言語・LLM

言語・LLM  言語・LLM

言語・LLM  言語・LLM

言語・LLM  画像

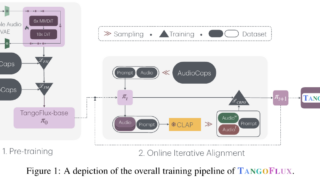

画像  論文解説

論文解説  ニュース

ニュース  ニュース

ニュース  ニュース

ニュース  ニュース

ニュース