- ロボットによる物体操作を改善する新アプローチ「OmniManip」の提案

- 視覚言語モデルを活用したタスク関連情報抽出とインタラクションプリミティブ生成

- 日常的なタスクにおける実験で高い成功率を示すOmniManipの評価

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

本研究では、ロボットが人の指示に基づいて一般的な物体操作を行う能力を向上させる新しいアプローチ「OmniManip」を提案しています。この手法は、視覚言語モデル(VLM)の自然言語理解能力を活用し、物体操作の精度を高めることを目的としています。既存の手法では、物理的な制約や特定のタスクへの最適化が課題であるため、本研究では「物体中心のインタラクションプリミティブ」を空間的な制約として活用する新たな枠組みを構築しました。

提案手法の核となるのは、まずVLMを活用してタスクに関連する物体情報を抽出し、各物体の目的に応じた「インタラクションプリミティブ」を生成することです。次に、それらのプリミティブに基づき、物体操作タスクを実行するための最適な軌道計画を行います。本手法は、閉ループ制御システムで動作し、リアルタイムでタスク進行を修正するため、高い精度が期待できます。このプロセスでは、VLMによるタスク分解や物体間の関係性解釈が重要な役割を果たします。

実験として、日常的な物体操作を模した複数のタスク(例:カップに水を注ぐ、ペンをホルダーに挿す)で性能を評価しました。本手法は、従来の手法(ReKePoやCoPaなど)と比較して、タスク成功率で大幅な向上を示しました。特にOmniManipは、多様な視点やタスクに対して頑健性を発揮し、閉ループ制御により失敗を最小限に抑えることが実証されました。

図表の解説

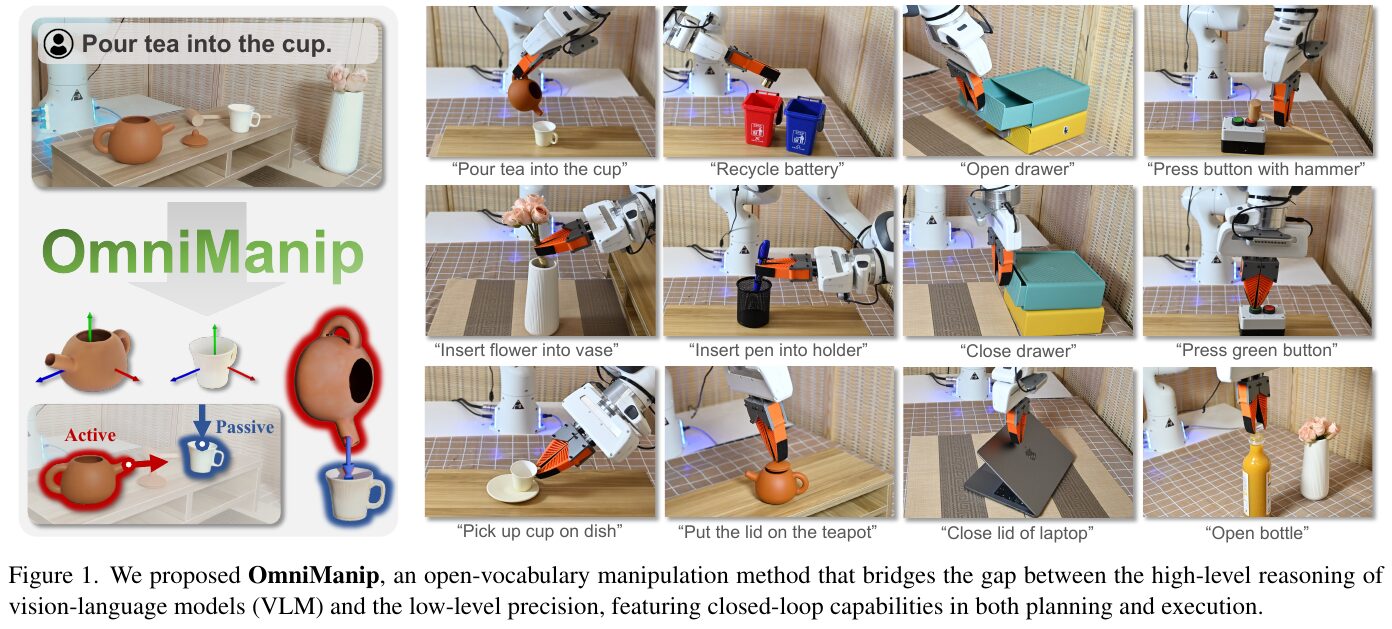

この画像は、ロボットマニピュレーション技術「OmniManip」の概要を示しています。OmniManipは、視覚と言語を扱うモデル(VLM)とロボットの低レベル制御をつなぐ手法です。この技術は、各種の物体との相互作用を通じて、3D空間での実行を精密に行うことを可能にします。 画像には、具体的なタスク例が示されています。例えば、「茶をカップに注ぐ」「バッテリーをリサイクルする」「引き出しを開ける」などのタスクをロボットが実行しています。OmniManipは、物体の機能に基づいた相互作用のポイントと方向を設定し、高度な計画と実行を両立させる閉ループシステムを提供します。これにより、リアルタイムでの制御が可能となり、多様なタスクにおいてロボットの汎用性を高めています。

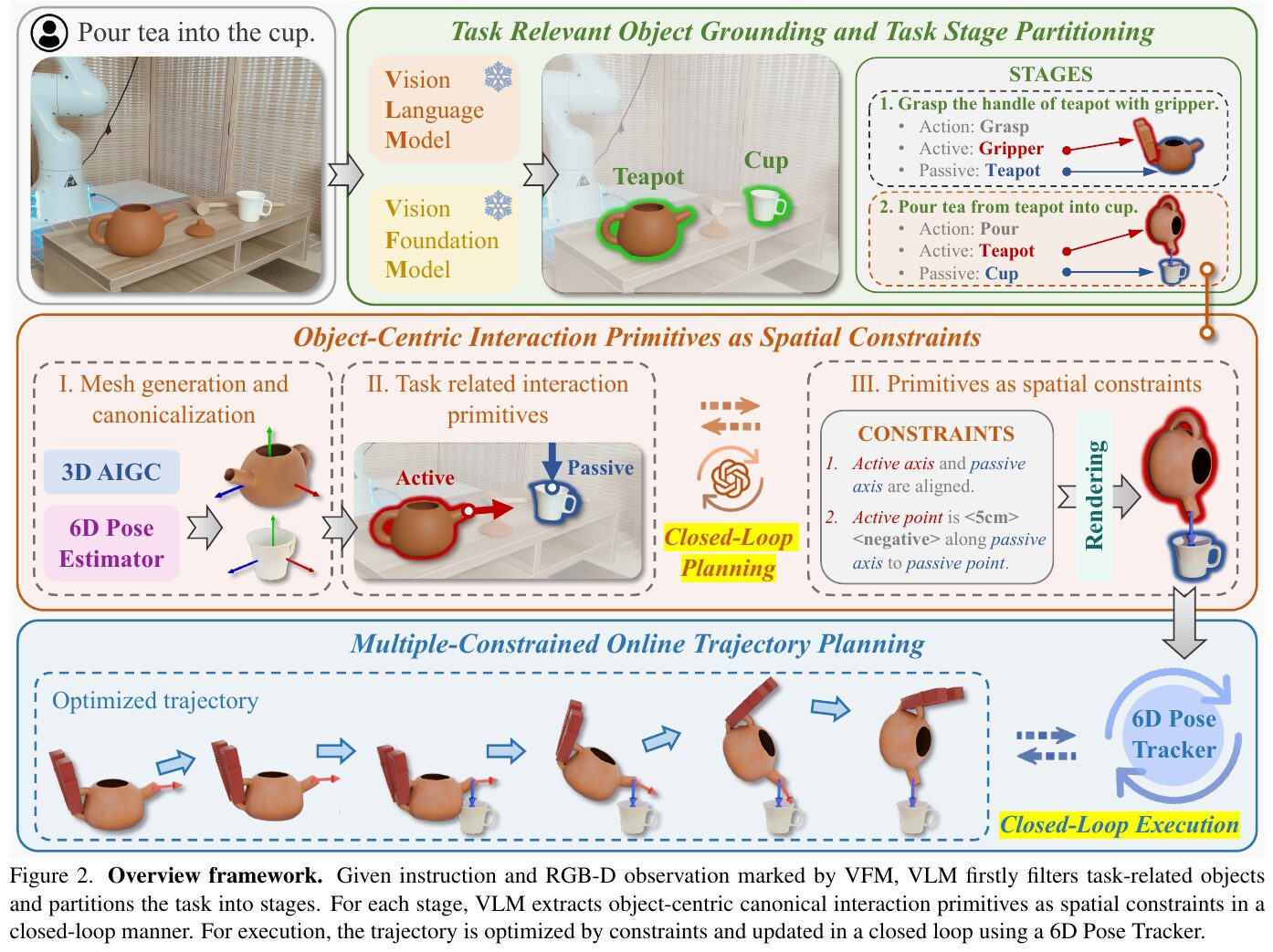

この図は、OmniManipというロボット操作システムのフレームワークを示しています。まず、視覚言語モデル(VLM)を使って、カップやティーポットといったタスク関連の物体を特定し、タスクを複数のステージに分割します。次に、3Dメッシュ生成や6Dポーズ推定を利用して、物体の標準化された空間におけるインタラクションプリミティブ(相互作用の要素)を抽出し、これを空間的制約として活用します。これらの制約に基づいて、最適な動作軌道を計画し、6Dポーズトラッカーを用いて実行中に動的に調整するクローズドループ制御を実現しています。この手法により、VLMの高度な推論能力を具体的な3D空間の操作に活かすことができます。

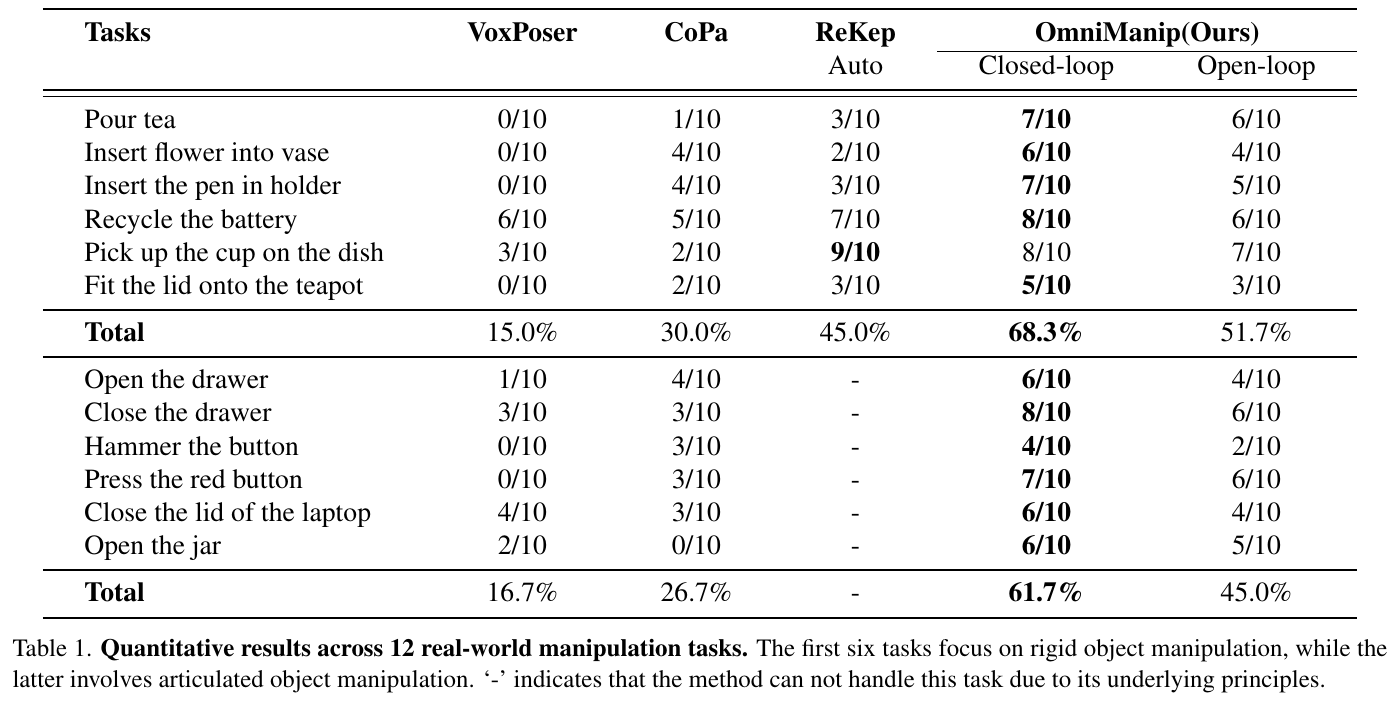

この表は、OmniManipというシステムを含む4つの異なるロボット操作手法の性能を、12の実際の操作課題で比較した結果を示しています。最初の6つの課題は、固体オブジェクトの操作に焦点を当てており、残りの課題は関節式オブジェクトの操作を含みます。OmniManipは閉ループと開ループの両方のモードでテストされ、特に他の手法よりも高い成功率を示しています。閉ループモードでは68.3%、開ループモードでも51.7%の成功率を達成しました。これに対し、他の手法の成功率は15%から45%の範囲にとどまりました。これにより、OmniManipの優れた一般化能力と精密な操作能力が強調されています。

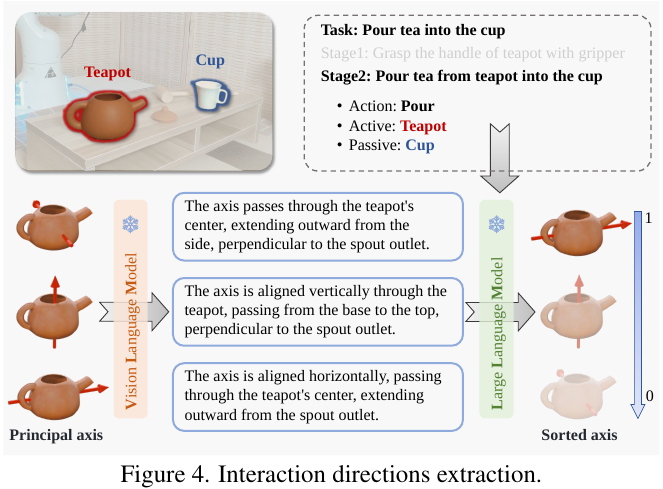

この図は、タスク「ティーカップにお茶を注ぐ」を例に、ロボットによる物体操作の方向性の抽出方法を示しています。図では、ティーポットとカップの関係を視覚化し、どのようにして物体間の相互作用の方向を特定するかを描写しています。具体的には、ティーポットの主要な軸(例えば、中心を通る軸やスポウトに垂直な軸など)が挙げられ、それぞれの軸がタスクにどのように関連するかを示しています。視覚言語モデル(VLM)はこれらの軸を定義し、大規模言語モデル(LLM)はそれらを評価してタスクに最も適した方向を決定します。この工程は、VLMの一般的な知識を活用して、実際の操作に必要な具体的な3D情報に変換しています。

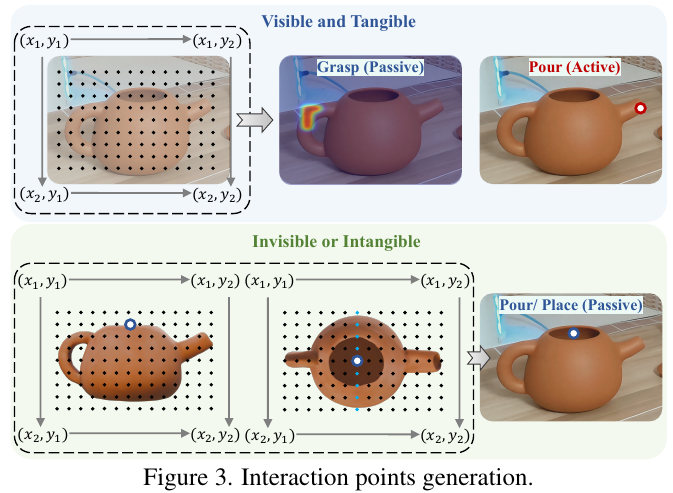

この図は、ロボットの操作に関するインタラクションポイントの生成方法を示しています。図は、オブジェクトが「見えるかつ触れることができる」または「見えないかつ触れない」場合に分かれています。 上半分では、視覚的に確認できる急須の一部を「Grasp(把握)」と「Pour(注ぐ)」というタスクに対応するポイントとして示しています。これは、物体の見える部分に対する直接の操作を指しています。 一方、下半分では、急須の口など目に見えない点を「Pour/Place(注ぐ/置く)」というタスクに対応するポイントとして設定しています。これにより、物体の見えない機能的部分への適応が可能となります。 このようにして、ロボットはそれぞれのタスクに応じたインタラクションポイントを生成し、より柔軟な操作を実現します。

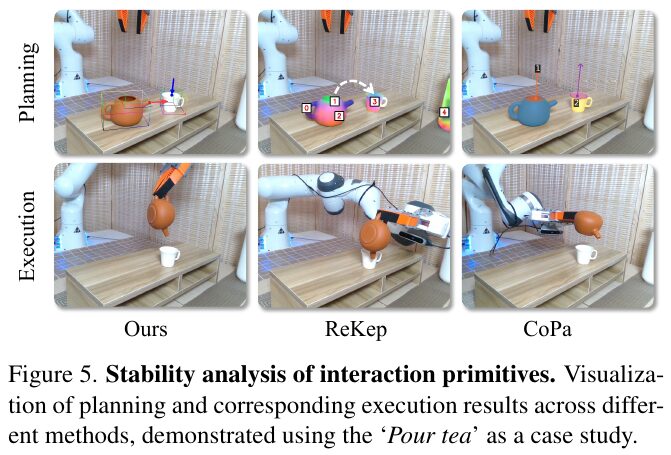

この図は、論文で紹介されている「Pour tea(お茶を注ぐ)」という操作をケーススタディとして、さまざまな方法の計画と実行の結果を示しています。上の行は計画段階、下の行は実行段階を表しています。 「Ours」は本研究の方法を示し、「ReKep」と「CoPa」は他の既存手法を示しています。本研究の方法は、より安定した操作を可能にし、他の二つの手法と比較して、お茶をしっかりとカップに注ぐことができています。この安定化は、オブジェクト中心の相互作用プリミティブと呼ばれる空間的制約に基づくシステムの導入によって達成されています。これにより、異なるシステム間での操作の計画と実行の違いが視覚化されています。

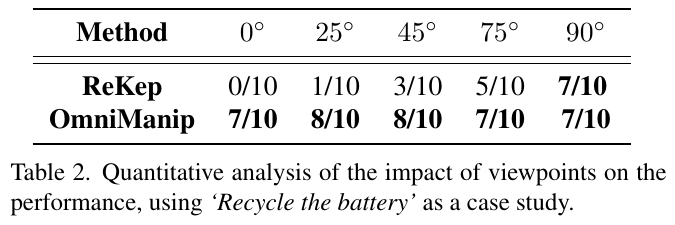

表2の画像は、「リサイクルの電池」というケーススタディを用いて、さまざまな視点が性能に与える影響を評価した結果を示しています。ReKepとOmniManipという2つの方法が比較されています。表の上部には異なる角度(0°, 25°, 45°, 75°, 90°)が示されており、それぞれの方法について特定の角度での成功回数が記されています。 結果から、OmniManipはほとんどの角度で高い成功率を示しており、視点の変化に対してほとんど影響を受けないことが分かります。一方、ReKepは角度が変わることによって成功率が変動しており、特に低角度では成功率が低いです。これにより、OmniManipが異なる視点での一貫性と高いパフォーマンスを維持し、さまざまな環境での利用に適していることが示唆されています。

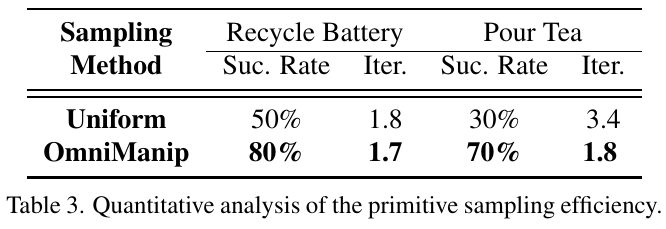

この表は「OmniManip」というロボットマニピュレーション手法の効率性を分析したものです。表は「Recycle Battery」と「Pour Tea」という2つのタスクの成功率(Suc. Rate)と必要な反復回数(Iter.)を示しています。 「Uniform」方式では、各タスクの成功率はそれぞれ50%と30%で、平均1.8回と3.4回の反復が必要でした。一方、「OmniManip」方式では、成功率が大幅に向上し、それぞれ80%と70%に達しました。必要な反復は1.7回と1.8回で、少ない反復でより高い成功率を示しました。これにより、OmniManipは効率的で効果的な方法であることが強調されています。