※ AIによる要約

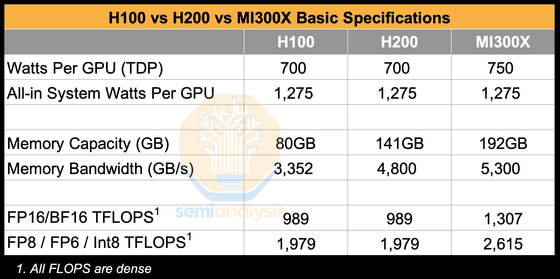

NVIDIAの「H100」「H200」およびAMDの新製品「Instinct MI300X」が、ベンチマークテストでその能力を比較されました。これらのテストはテクノロジー専門のメディア、Semianalysisによって実施。

「MI300X」は、12月にAMDが発表した最新モデルで、前世代に比べてコンピューティングユニットが40%増加、メモリ容量が1.5倍増加。また、ピークメモリ帯域幅も1.7倍に達しています。こうしたスペックが競争優位性を持つかが注目される中で、実際のテストでは興味深い結果が浮かび上がりました。

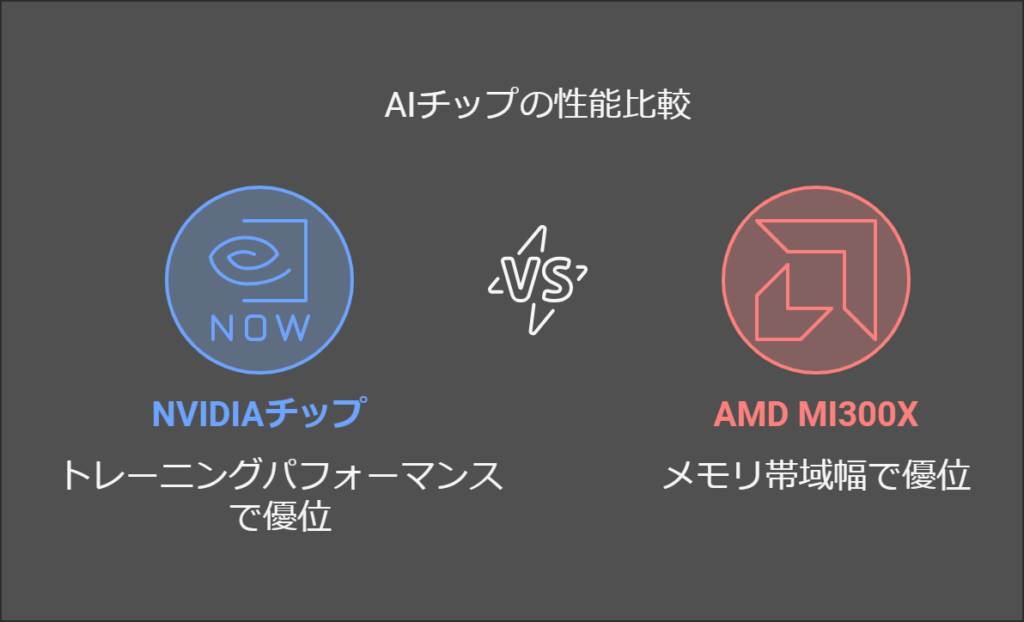

当該ベンチマークテストでは、特定の条件下でMI300Xは、NVIDIAのH100、H200を上回るメモリ帯域幅を備えていることが示されました。特に、Pytorchのテストでその強みがはっきりと確認されました。しかし、全体的なトレーニングパフォーマンスでは、NVIDIAのチップが優位。例えば、単一ノードでのテストではH100、H200が他のMI300Xのバージョンを凌ぎ、マルチノードトレーニングにおいても、H100がMI300Xより最大25%速い結果となりました。

また、NVIDIAの製品には、「FlexAttention」という性能最適化技術が導入されており、これが性能差に大きく寄与していると考えられます。一方、AMDは、この機能を完全に活用できていないため、MI300Xの性能を最大限に引き出せていないのが現状です。これについてSemianalysisは、AMDが今後もNVIDIAに競争を挑み続けるためには、ソフトウェア改良の必要性を指摘しています。

この比較は、AIインフラストラクチャーの未来を作り上げる企業にとって、競争のあり方を考える重要な指針となります。チップ性能を支える技術面だけでなく、ソフトウェアの最適化が、どれほど重要であるかが改めて浮き彫りになりました。