- 多言語埋め込みを強化する新手法LUSIFERの提案

- ファインチューニングとアライメントによる効果的な多言語学習のプロセス

- 低リソース言語にも強い適応性を持ち、コスト効率が良い手法

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

本論文では、LLM(Large Language Models)に基づく多言語埋め込み手法を改善するため、新しいアプローチ「LUSIFER」(Language Universal Space Integration for Enhanced Multilingual Embeddings)が提案されています。この手法は、英語を中心としたLLMを最低限のアライメントデータと教師なし学習に基づいて強化し、多言語対応能力を持つ普遍的な埋め込み表現を生み出します。

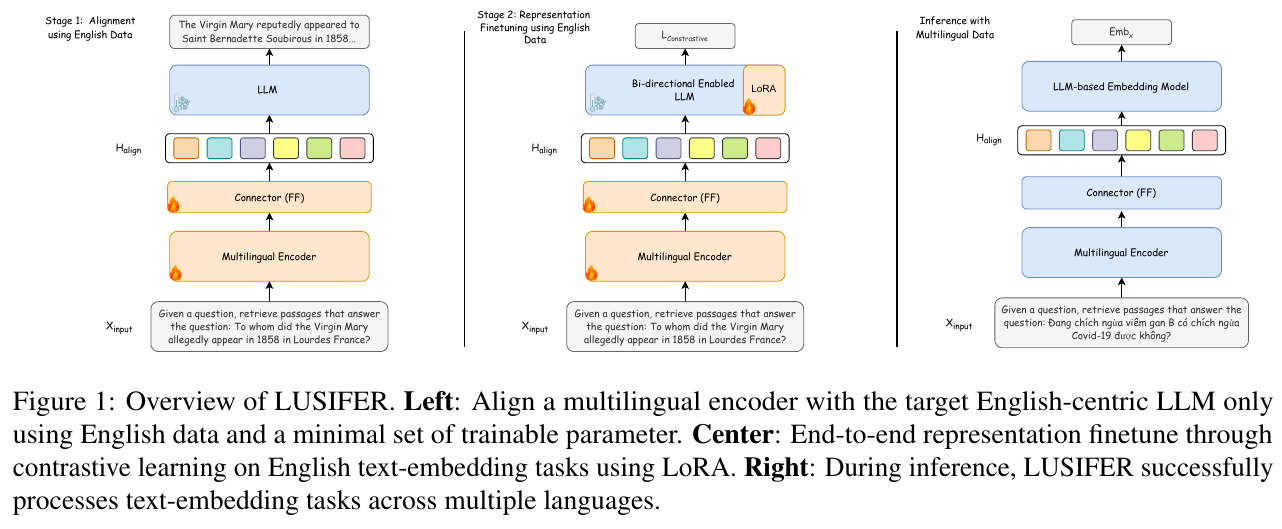

LUSIFERの主な手法は2つのステージで構成されています。第一ステージでは、ターゲット言語モデルと多言語コーパス間のデータアライメントを行い、言語間の表現ギャップを橋渡しします。第二ステージでは、コントラスト学習を用いてモデルをファインチューニングし、ポジティブ及びネガティブなサンプル間の区別を強化します。この2段階の学習過程により、LUSIFERは少ないリソースで多言語間のクロス言語的な意味表現を効果的に学習します。なお、トレーニングデータにはWikipediaや質問応答用のデータセットの一部が使用され、主に100以上の言語による評価が行われました。

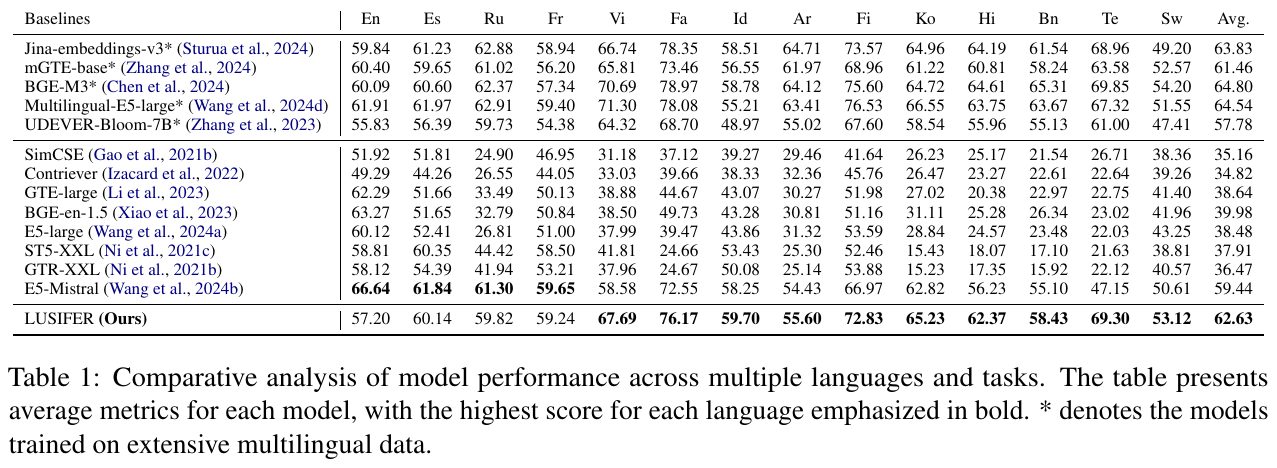

実験の結果、LUSIFERは分類、クラスタリング、検索タスク及び意味テキスト類似性(STS)タスクにおいて、既存のベースラインモデルを一貫して上回る性能を示しました。また、従来モデルが苦手としていた低リソースな言語および多様な言語間でのタスクにも優れた適応性を発揮しました。LUSIFERのアプローチによる利点として、外部翻訳システムを必要とせず、コスト効率が良いことが挙げられます。

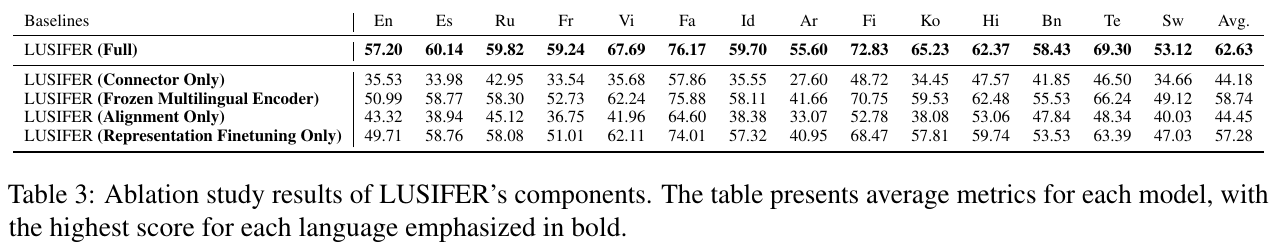

さらに、アブレーション研究により、各ステージの学習プロセスがモデルのパフォーマンス向上に寄与していることが確認されました。特に、アライメント学習と表現調整の組み合わせが全体的な改善の主要因となっています。

図表の解説

画像はLUSIFERという多言語埋め込みモデルの概要を示しています。このモデルは、英語中心の大規模言語モデル(LLM)を多言語エンコーダと組み合わせて多言語タスクに対応するために設計されています。左側では、英語データを使用して、多言語エンコーダと英語のLLMを最小限のパラメータで整列させます。中央部分は、英語のテキスト埋め込みタスクをLoRA技術で微調整します。右側では、LUSIFERが多言語の入力を処理する様子を示しており、主要な言語間でも埋め込みタスクを効果的に行えます。このモデルは多言語データなしでの適応を可能にしています。

この画像は、さまざまな多言語モデルのパフォーマンスを比較分析した表を示しています。表には、14の異なる言語とタスクにおける各モデルの平均スコアが示されており、最高スコアは太字で強調されています。多言語データで訓練されたモデルにはアスタリスク (*) が付されています。LUSIFERというモデルは、英語中心のモデルを多言語タスクに適用する新しいアプローチで、明示的な多言語の訓練データを必要としません。この表では、LUSIFERが多言語モデルとして優れた性能を発揮していることが示され、特に中・低リソース言語での改善が際立っています。平均スコアでLUSIFERは62.63を達成し、他の多くのベースラインを上回っています。

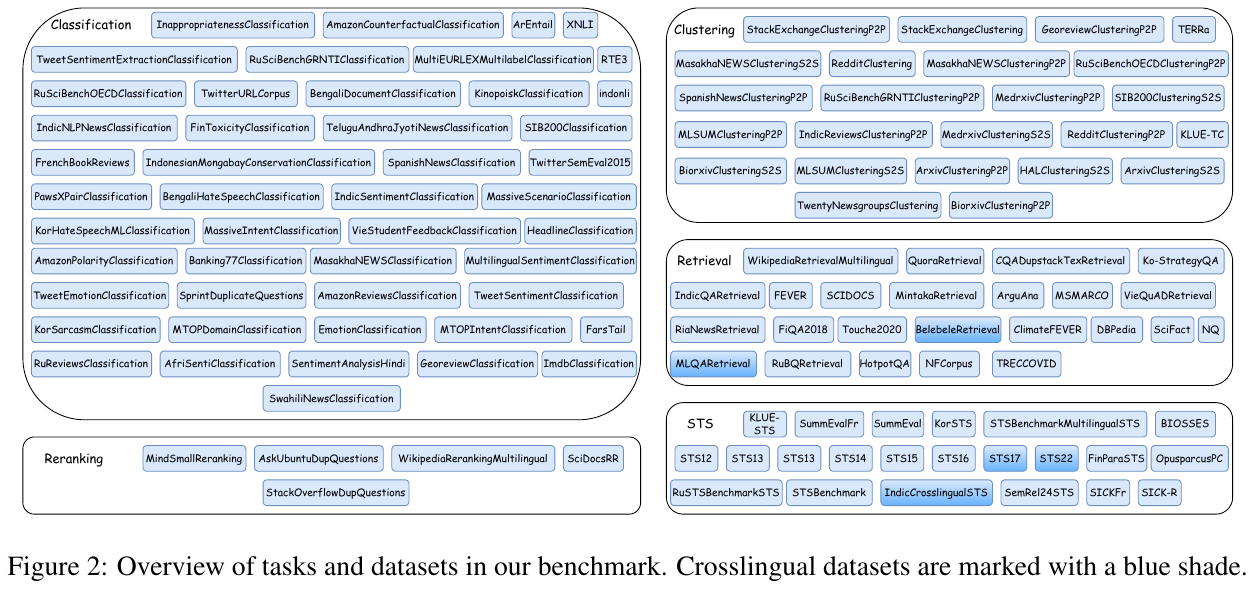

この画像は、LUSIFER研究で評価されるタスクとデータセットの概要を示しています。画像は、分類、クラスタリング、リランキング、検索、および意味テキスト類似性(STS)という5つの主要なタスクに分かれています。これらのタスクは、それぞれの枠内にリストされたデータセットによって表されており、青い背景で示されたものは多言語データセットを指します。 分類では、テキストの内容を特定のカテゴリに分類する様々なデータセットがあります。クラスタリングは、類似するテキストをグループ化するためのデータセットを扱います。リランキングは、情報のランキングを改善するためのタスクです。検索は、質問に対する最適な回答を見つけることを目的とし、STSはテキスト間の意味的類似性を評価します。データセットの多様性と言語の幅広いカバレッジが、多言語埋め込みモデルの性能を評価するために使用されています。

この画像は、LUSIFERというモデルの各コンポーネントに対するアブレーションスタディの結果を示しています。表には、英語(En)、スペイン語(Es)、ロシア語(Ru)、フランス語(Fr)、ベトナム語(Vi)など、複数言語でのパフォーマンスが平均値として示されています。 完全なLUSIFERモデルは、全ての言語で一貫して高いパフォーマンスを示し、特にフランス語とフィンランド語でのスコアが高いです。各コンポーネントのみを使用したモデルと比較して、フルモデルは全体的に優れた性能を発揮しています。特に、Representation Finetuningの効果が大きく、これが全体の性能向上に寄与していることがわかります。この結果から、全てのコンポーネントがLUSIFERの多言語表現能力向上に重要であることが示されています。

図6は、SIB200データセットから200のランダムなサンプルをt-SNEで可視化したものです。言語別に色分けされたポイントが表示されています。左側の「E5-Mistral」は、言語ごとにより明確なクラスター分離を示し、各言語が異なるクラスターとして存在しています。一方、右側の「LUSIFER」は、異なる言語が重なり合って分布しており、言語に依存しない表現空間を示しています。この結果は、LUSIFERが異なる言語間の意味を効果的に理解し、ゼロショットで多言語の転移を可能にすることを示しています。これは、LUSIFERのアルゴリズムが、言語に依存しない統合スペースを作り出し、異なる言語間でのセマンティックな理解を可能にする仕組みを示唆しています。

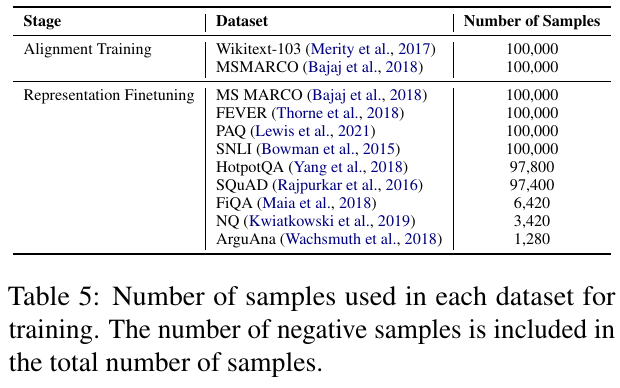

この表は、LUSIFERモデルのトレーニングに使用されたデータセットとサンプル数を示しています。トレーニングは2つの段階から成り、最初に「アライメントトレーニング」として、Wikitext-103とMSMARCOを使用し、それぞれ10万サンプルを活用しています。次に、表現を微調整する「リプレゼンテーションファインチューニング」段階では、多数のデータセットが用いられ、例えばMS MARCOやFEVERは共に10万サンプル、SQuADは97,400サンプルが使われています。この表は、負のサンプル数も含めた合計サンプル数である点が特徴です。これにより、LUSIFERは多言語の埋め込みタスクにおいて優れた性能を示すことができます。

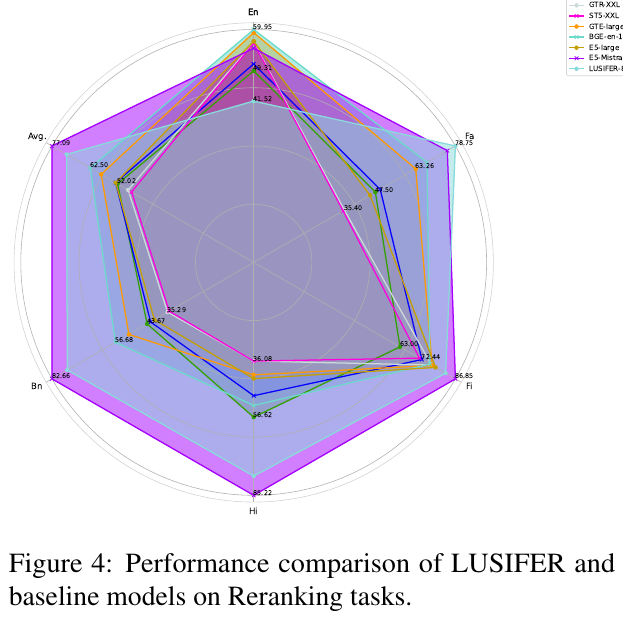

この図は、LUSIFERとベースラインモデルの再ランク付けタスクにおける性能比較を示しています。図は各モデルの異なる言語における性能を六角形のグラフで表しており、英語(En)やベンガル語(Bn)などの言語で評価されています。LUSIFERは、これらの言語間での性能が均一であり、高い性能指標を示していることがわかります。ベースラインモデルに比べて、特に中程度と低資源の言語で、LUSIFERが優れていることが示されています。また、全体平均でも他のモデルを上回っており、言語間のパフォーマンス向上が評価されています。これにより、LUSIFERは多言語対応が必要なタスクにおいて有効であると結論づけられます。

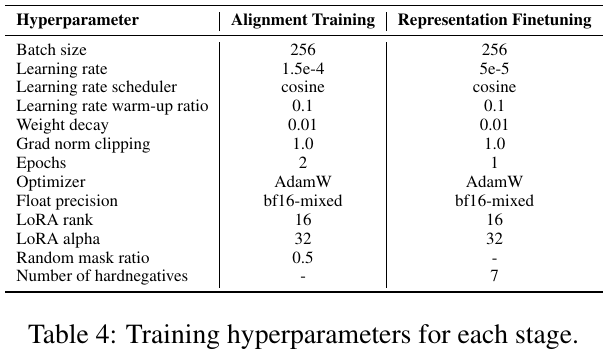

この表は、「LUSIFER」と呼ばれる多言語埋め込みモデルのトレーニングにおけるハイパーパラメータを示しています。モデルのトレーニングは、「アライメントトレーニング」と「表現ファインチューニング」という2段階から成り立っています。 アライメントトレーニングでは、バッチサイズ256、学習率1.5e-4を用い、重み減衰や学習率スケジューラー(コサイン)を活用しています。学習はAdamWオプティマイザーと混合浮動小数点精度で行われます。 一方、表現ファインチューニングでは、学習率を5e-5に調整し、アライメントトレーニングと同様の他の設定で実施されます。ただし、こちらの段階ではハードネガティブを7個使用しています。 これらの設定は、各段階でモデルの適切な学習を進めるために調整されています。