この論文では、モバイルデバイス向けに最適化された小型の大規模言語モデル「MobileLLM」を提案しています。従来の大規模モデルの高コストと遅延を克服し、低リソース環境でも高い精度を維持できる設計が可能となりました。

論文:MobileLLM: Optimizing Sub-billion Parameter Language Models for On-Device Use Cases

GitHub:https://github.com/facebookresearch/mobilellm

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

この研究のポイントは?

本論文は、モバイルデバイス上で効率的に動作する小規模の言語モデル「MobileLLM」を提案しています。

本研究のポイントは、以下の通りです。

つまりMobileLLMは、スマホなどのモバイル環境でのAI活用を現実的にした研究です。

背景

従来のLLMは、多くのパラメータを持ち、クラウド上で動作することが一般的でした。しかし、クラウドベースの運用には、データ処理の遅延やコストの増加といった問題があります。また、日常的に使用するには、エネルギー消費や環境への負担も無視できません。このような課題がある中、モバイルデバイス上で直接実行できる、小型かつ効率的なLLMのニーズが高まっています。

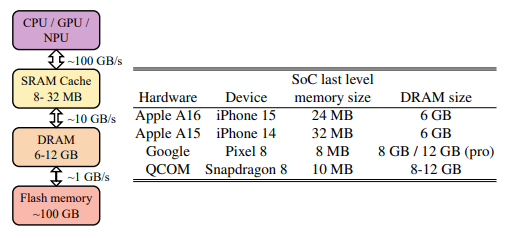

特に、現在のスマートフォンやタブレットのようなモバイルデバイスは、メモリ容量や計算能力に制約があり、大規模なモデルをそのまま実装することは困難です。例えば、最新のスマートフォンでは6GBから12GBのDRAMが一般的であり、このメモリをモデルが占有しすぎると、他のアプリケーションとの競合が発生します。また、電力消費も問題であり、通常の大規模モデルではバッテリーを短時間で消耗してしまいます。

この背景から、パラメータ数が1億から3億5千万程度の「サブビリオン」モデルに注目が集まっています。これらのモデルは、モバイルデバイス上で効率的に動作し、ユーザーの指示にリアルタイムで応答できる性能を持ちながら、消費エネルギーを抑えることができます。

MobileLLMは、こうした小型モデルの設計を最適化するために、特に深さと薄さを重視したアーキテクチャを採用し、重み共有やグループ化アテンションの技術を組み込んでいます。

提案手法

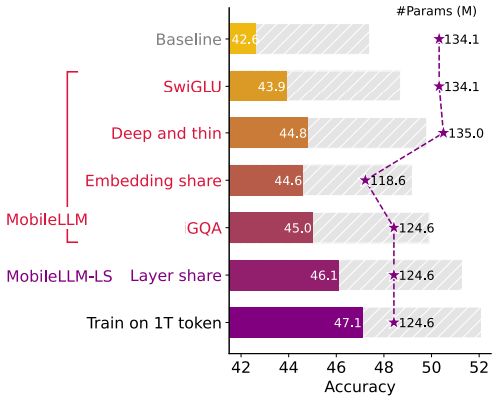

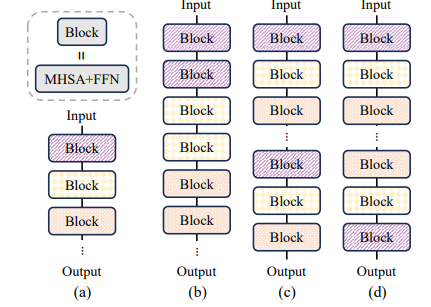

MobileLLMの設計では、主に「深くて薄いアーキテクチャ」と「重み共有」を活用しています。具体的には、モデルの深さ(レイヤーの数)を増やし、幅(各レイヤーのパラメータ数)を減らすことで、計算効率を高めています。このアプローチにより、モデルは限られたパラメータ内でより抽象的な特徴を捉えやすくなり、小型モデルでも高い精度を実現しています。

さらに、MobileLLMは「重み共有」と呼ばれる技術を導入することで、隣接するレイヤー間で重みを共有し、メモリの使用量を増やさずにレイヤー数を増やすことに成功。その結果、計算効率が向上し、実行時のレイテンシーも低減します。特に、MobileLLM-LSと呼ばれるバリエーションでは、重みを即時に再利用するブロック単位の共有手法を採用し、さらなる性能向上を図っています。

これらの設計により、MobileLLMは既存のサブビリオンモデルと比較して、ゼロショットタスクやAPI呼び出しなどの応用においても優れたパフォーマンスを発揮します。また、エンベディングの共有やグループ化クエリアテンションといった他の最適化技術も組み合わせて、モデルの重量を増やさずに精度を高めることに成功しています。

実験

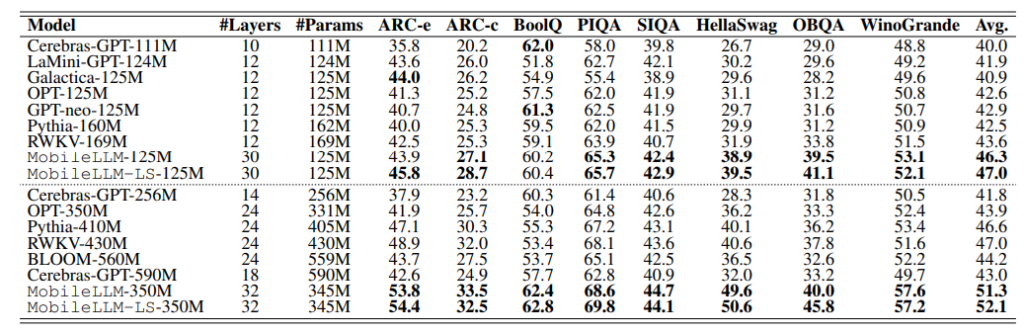

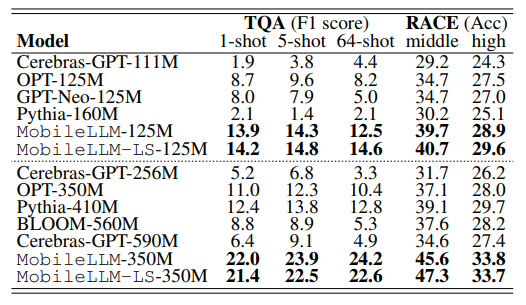

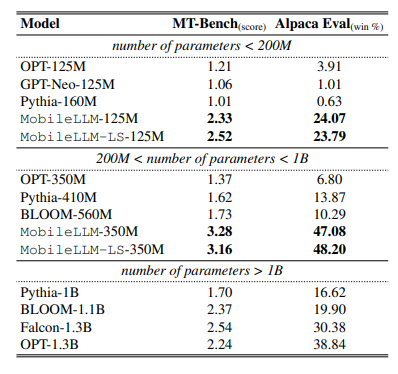

この論文の実験では、ゼロショットの常識推論タスクや質問応答、読解タスクなど、多岐にわたるベンチマークで行われました。

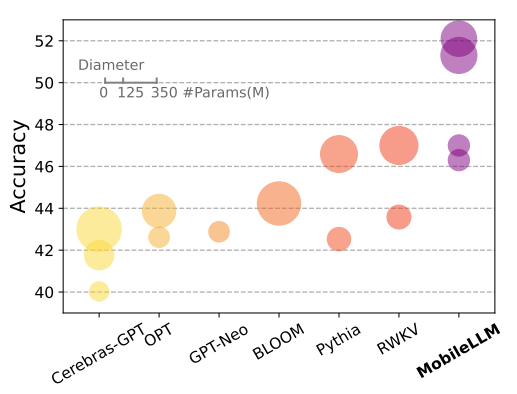

まず、MobileLLMは125Mおよび350Mパラメータのサイズで実験され、従来のモデルと比較して高い精度を示しました。特に、MobileLLMは、他の同規模のモデル(例えば、OPT-125MやGPT-Neo-125M)に対しても大幅な精度向上を実現しました。

深くて薄いアーキテクチャの有効性が実証され、重み共有の技術がモデルのパフォーマンスをさらに高めることを示しています。

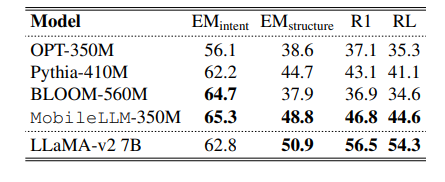

次に、API呼び出しやチャットといった具体的なオンデバイスの応用においても評価が行われました。MobileLLM-350Mは、7Bパラメータを持つ大規模モデルLLaMA-v2と比較しても、非常に近い精度でAPIの呼び出しを正確に行うことができることが示されています。

この結果は、従来は高コストな大規模モデルでしか達成できなかったタスクを、小型で効率的なモデルでも実現できる可能性を示しています。

結論

従来の大規模言語モデルは多くの計算リソースとエネルギーを消費し、モバイルデバイス上での運用には不向きでしたが、MobileLLMはこれらの問題を解決するために設計されています。

MobileLLMの最大の成果は、限られたパラメータ数でも高いパフォーマンスを発揮できるように、深くて薄いアーキテクチャを採用し、重み共有やグループ化クエリアテンションといった技術を活用している点です。この設計により、モデルの計算効率が向上し、オンデバイスでの利用に最適化された性能を発揮します。

実験結果から、MobileLLMはゼロショットタスク、質問応答、API呼び出しといった多様な応用シナリオで、従来のモデルを上回る性能を示しました。また、レイヤーの重みを共有することで、メモリ使用量を増やさずにモデルの深さを増やし、実行時の遅延もほぼ増加しないことが確認されました。

この研究の意義は、小型のLLMがオンデバイスでの実用的なソリューションとして十分な性能を持つことを示した点にあります。

今後、クラウドに依存しない形でのAIの利用が広がる可能性があり、今後のモバイルアプリケーションの発展に大きな影響を与えることが期待されます。