この論文では、大規模言語モデル(LLM)に「新しい科学研究のアイデアを生み出す能力があるのか」を評価しています。その結果、LLMが新規アイデアを生成できる可能性を示唆していますが、同時にその限界も明らかされました。

論文タイトル:Can Large Language Models Unlock Novel Scientific Research Ideas?

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

この研究のポイントは?

この論文は、大規模言語モデル(LLM)が新しい科学研究のアイデアを生み出す可能性について探究しています。

著者らは、

- 化学

- コンピューターサイエンス

- 経済学

- 医学

- 物理学

の5つの分野において、4つのLLM

- Claude-2

- GPT-4

- GPT-3.5

- Gemini

の能力を詳細に調査しました。

背景

近年、大規模言語モデル(LLMs)は自然言語処理分野で顕著な進歩を遂げ、様々なタスクで優れた性能を発揮しています。特に、ChatGPTのような一般公開されたモデルの普及により、AIの活用が日常生活に深く浸透してきました。

これに伴い、LLMsが単に文章を理解するだけでなく、創造的な発想や新しいアイデアを生成する能力についての関心が高まっています。科学研究において、革新的なアイデアの生成は非常に重要であり、これまでは人間の知識と創造力に依存していました。

しかし、技術の進歩により、AIが新しい研究の方向性やアイデアを提示できるかという問いが浮上しました。

提案手法

提案手法は、LLMによって生成された研究アイデアが、論文著者の視点とどれほど一致しているかを測るというもの。

具体的には、LLMsが生成したアイデアと、論文内で著者が提示した将来の研究アイデアとの一致度を数値化します。この一致度を測ることで、LLMsが著者の意図に近いアイデアを生成しているかどうかを評価します。

1. アイデアアラインメントスコア(IAScore)

IAScoreは、まず各論文の生成アイデアのアラインメントスコアを算出し、それを平均して全体のスコアを求める手順を取ります。具体的には、以下のようなステップで計算されます:

- それぞれの論文におけるアイデア生成の一致度を測るために、「IdeaMatcher」というモデルを使い、論文の著者が提案した将来の研究アイデアとLLMsが生成したアイデアを比較します。

- 各論文のアイデアの平均スコアを算出し(AvgScore)、その後、全論文のスコアを合計して特定分野全体の平均スコアを算出します。

2. IdeaMatcher モデル

アイデアを評価するために、「IdeaMatcher」と呼ばれるモデルを使用しています。このモデルは、自然言語推論(NLI)に似たアプローチで、生成されたアイデアが元の論文の将来の研究アイデアとどれだけ一致するかを判断します。

具体的には、RoBERTaやBERTなどの事前学習済みモデルを使って、生成されたアイデアと論文のアイデアを比較します。

3. Idea Distinctness Index(IDI)

さらに、生成されたアイデアの「独自性」を評価するために「Idea Distinctness Index(IDI)」という別の指標も導入しています。この指標は、生成されたアイデア同士がどれだけ異なっているか(重複がないか)を測るためのもので、アイデアの多様性や新規性を評価します。

実験

この論文の実験内容について説明します。

具体的には、異なる言語モデルが各分野(化学、物理学、コンピュータサイエンス、経済学、医学)で生成したFRIsの「新規性」や「多様性」を定量的に評価しています。

評価手法

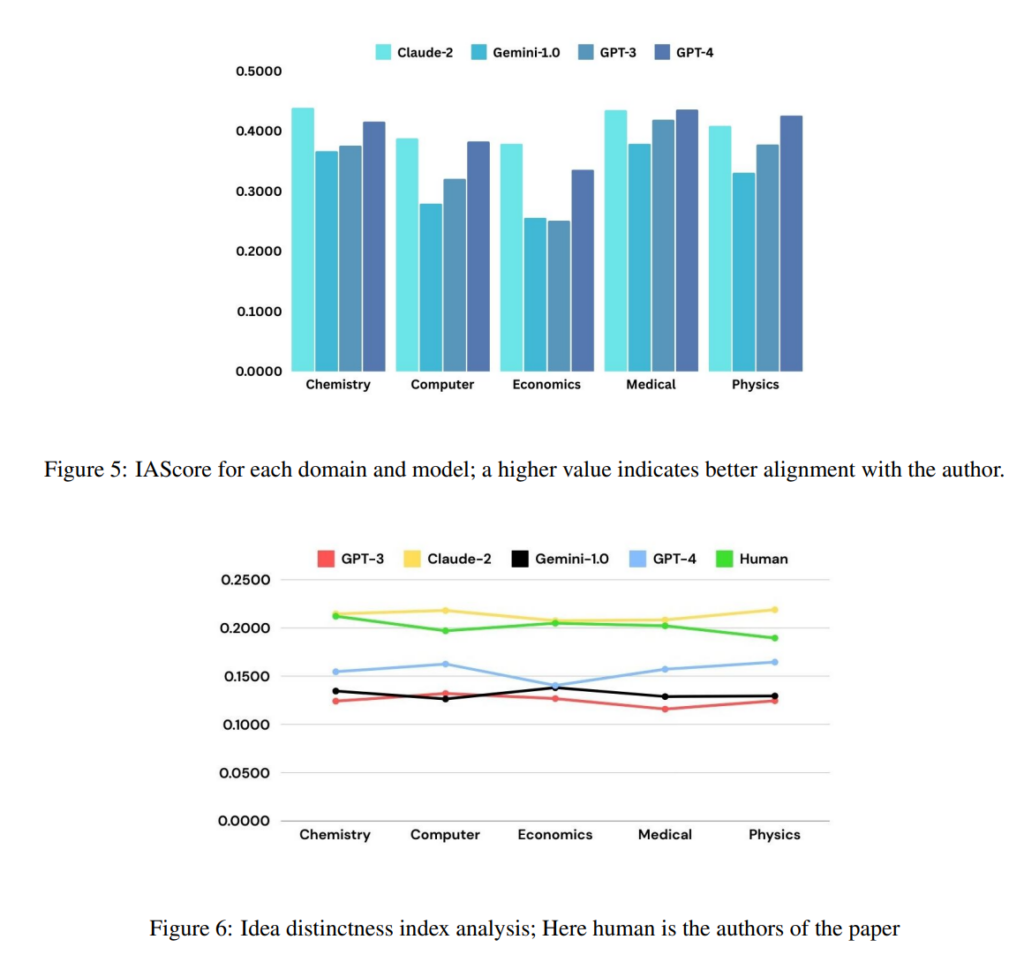

実験では、Claude-2、GPT-4、GPT-3.5、Gemini 1.0という4つの異なる大規模言語モデルが使われ、これらのモデルによって生成されたアイデアが比較されています。

- アイデアアラインメントスコア(IAScore):

このスコアは、生成されたアイデアが論文著者の意図にどれほど一致しているかを評価するものです。LLMsが生成したアイデアと、著者が論文で提示した未来の研究アイデア(FRI)を比較し、一致度を計算します。 - アイデア独自性指数(Idea Distinctness Index):

生成されたアイデア同士がどれだけ異なっているかを評価します。アイデアの多様性を測るために、アイデア間のコサイン類似度を計算し、その逆数を「独自性」として数値化します。 - 人間による評価:

また、各分野の専門家によって、生成されたアイデアの「関連性」「実現可能性」「新規性」が評価されました。これにより、モデルがどれだけ有用なアイデアを生成できるかを確認しています。

実験結果

- アイデアの一致度: GPT-4とClaude-2は、ほとんどの分野で最も高いIAScoreを示しました。特に経済学や化学分野で高い一致度が確認され、他のモデル(GPT-3.5、Gemini)よりも優れていることが分かりました。

- アイデアの独自性: Claude-2はアイデアの独自性においても最も高いスコアを示し、特にコンピュータサイエンスと物理学分野で人間が生成したアイデアに匹敵する、あるいはそれ以上の独自性を持つアイデアを生成しました。

- 人間評価: GPT-4とClaude-2は関連性と実現可能性において高い評価を得ており、生成されたアイデアの大部分が実用的で、実現可能であるとされました。GPT-4は、より「非常に新規な」アイデアを多く生成しましたが、Claude-2は「一般的な」アイデアも多く生成しました。

これらの結果から、LLMsが未来の研究アイデアを生成する能力において、一定の成功を収めていることが確認されました 。

結論

この論文では、大規模言語モデル(LLMs)が未来の研究アイデアを生成する能力を評価しています。実験の結果、LLMsは、特にClaude-2とGPT-4が、著者の提案する未来の研究アイデアと強く一致し、また多様性のあるアイデアを生成できることが示されました。

特に、Claude-2はGPT-4に比べてより独自性のあるアイデアを生み出すことがわかりましたが、GPT-4もまた非常に斬新なアイデアを生成する能力を持っていると評価されました。

今後の研究では、複数の論文から知識を統合するより効果的な方法を探ることで、LLMsが生成するアイデアの新規性をさらに高めることが目標とされています。また、現在のLLMsがしばしば生成する一般的で既存のアイデアを防ぐための手法の開発も重要な課題として挙げられています