画像編集の新しい手法である「InstantDrag」を提案しています。この手法は、ユーザーが指定したドラッグ操作に基づいて、画像をインタラクティブかつ高速に編集できる技術です。

論文タイトル:InstantDrag: Improving Interactivity in Drag-based Image Editing

プロジェクトページ:https://joonghyuk.com/instantdrag-web/

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

この研究のポイントは?

本論文では、InstantDragという新しいアプローチを導入し、次の特徴を持つ効率的な画像編集を可能にしています。

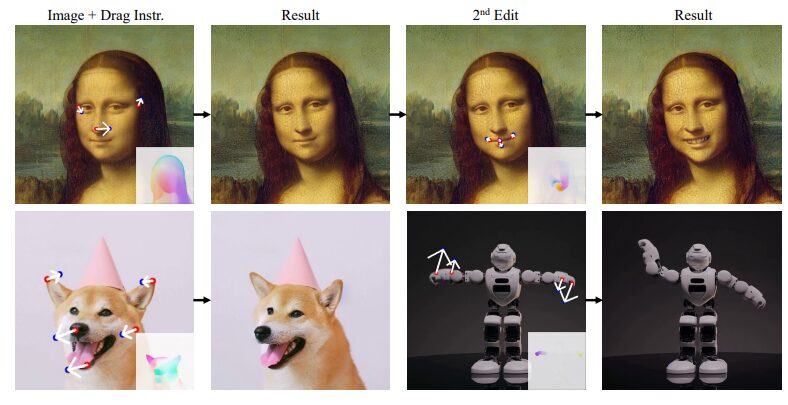

例えば、InstantDragを用いることで、以下のような画像修正が可能になります。

かなり直感的に、画像を微調整できていますね。

背景

従来の画像生成モデルは、テキスト入力やマスクを使って画像を編集することが一般的でしたが、それらには限界がありました。特に、ユーザーがリアルタイムに編集操作を行いたい場合、従来の手法は計算コストが高く、処理が遅いという問題がありました。

例えば、テキストを使った画像生成では、ユーザーが画像の特定の部分を細かく操作することは難しく、全体的な雰囲気を変える程度に留まることが多かったのです。

一方、ドラッグ操作を使った編集方法では、ユーザーが画像の中の特定の場所を指定し、その部分を自由に動かしたり変形させたりできるため、より詳細な操作が可能になります。

既存研究には、「DragGAN」や「DragDiffusion」といった技術があり、これらはユーザーがポイントをドラッグしてその場所を編集できます。しかし、これらの手法は編集に時間がかかり、特にリアルタイムでの操作には向いていませんでした。たとえば、編集の精度を上げるために最適化処理が必要であり、それによって処理時間を大幅に増幅していました。

そこで、この論文では、リアルタイムに近い形で画像を素早く編集できる新しい手法として「InstantDrag」を提案しています。

この手法は、従来のモデルのようにテキストやマスクに頼らず、画像とドラッグ操作だけで高品質な編集を実現します。

提案手法

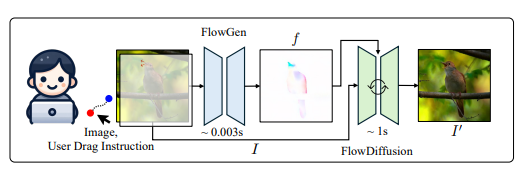

InstantDragは2つの主要なネットワークを組み合わせて動作します。

FlowGenとFlowDiffusionの2つのネットワークを連携させることで、InstantDragはユーザーの指示に素早く反応し、画像をリアルタイムで編集できるようになります。

FlowGen

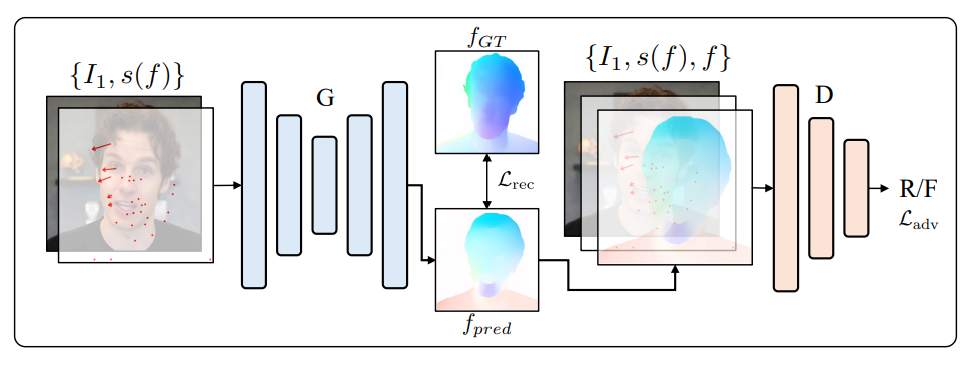

FlowGenは、ユーザーがドラッグした動きに基づいて、画像の中でどのように物体が移動するかを計算します。

仕組みは以下の通り。

- 入力画像とドラッグ指示(疎な流れ)を受け取り、密な光学フローを出力

- GANベースのアーキテクチャを採用しており、生成器と識別器から構成されている

- Pix2Pixに似た構造を持つが、より深い構造と最適化された設計

特徴は以下の通り。

- 1回の処理で光学フローを生成するため、非常に高速です。

- 顔の動きだけでなく、一般的な物体の動きにも対応できるよう学習されています。

- 様々な入力パターンに対応できるよう、複数の疎な流れから学習を行います。

FlowDiffusion

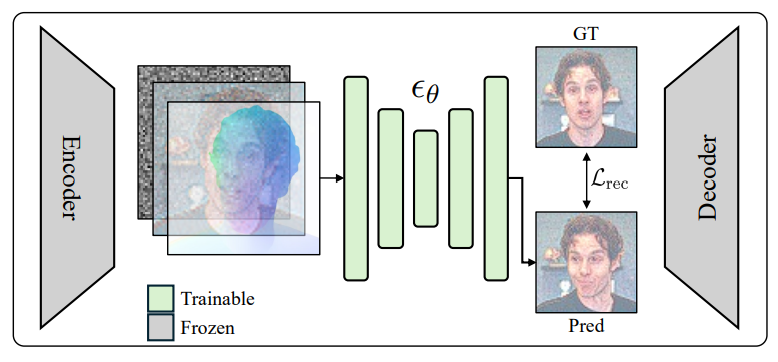

FlowDiffusionは、FlowGenによって得られた動きの情報を基に、実際に画像のピクセルを編集します。

仕組みは以下の通り。

- 拡散モデルをベースにしており、Stable Diffusionを改良したアーキテクチャを採用

- 入力画像、ノイズ、そしてFlowGenが生成した光学フローを条件として受け取る

- これらの情報を基に、ステップバイステップで画像を生成・編集

特徴は以下の通り。

- テキストプロンプトを必要とせず、光学フローのみを条件として使用します。

- 画像の一貫性を保ちつつ、指定された部分のみを自然に動かすことができます。

- 従来の拡散モデルと比べて、より少ないステップ数で高品質な編集が可能です。

実験

訓練データと設定

顔の編集に関しては、CelebV-Textという大規模な動画データセットを使用しています。このデータセットには、70,000本の高品質なビデオクリップが含まれており、これをもとに10フレーム/秒の間隔で画像を抽出して使用しています。

また、一般的なシーン編集では、短い動画(10〜60秒)のシーンに関連する動作を学習するため、2段階のファインチューニング戦略を採用しています。これにより、顔以外の画像編集も可能にしています。

モデルと計算資源

実験は、NVIDIAのA6000 GPUを用いて行われ、FlowGenとFlowDiffusionの2つのモデルが訓練されました。FlowGenは256ピクセルの画像を1台のGPUで約3日間訓練し、FlowDiffusionは512ピクセルの画像を8台のGPUで5日間かけて訓練しています。

顔の編集では、8Mペアのデータを使用し、特に人間の顔に対する過学習を防ぐために、データセットサイズのアブレーション実験も行われました。

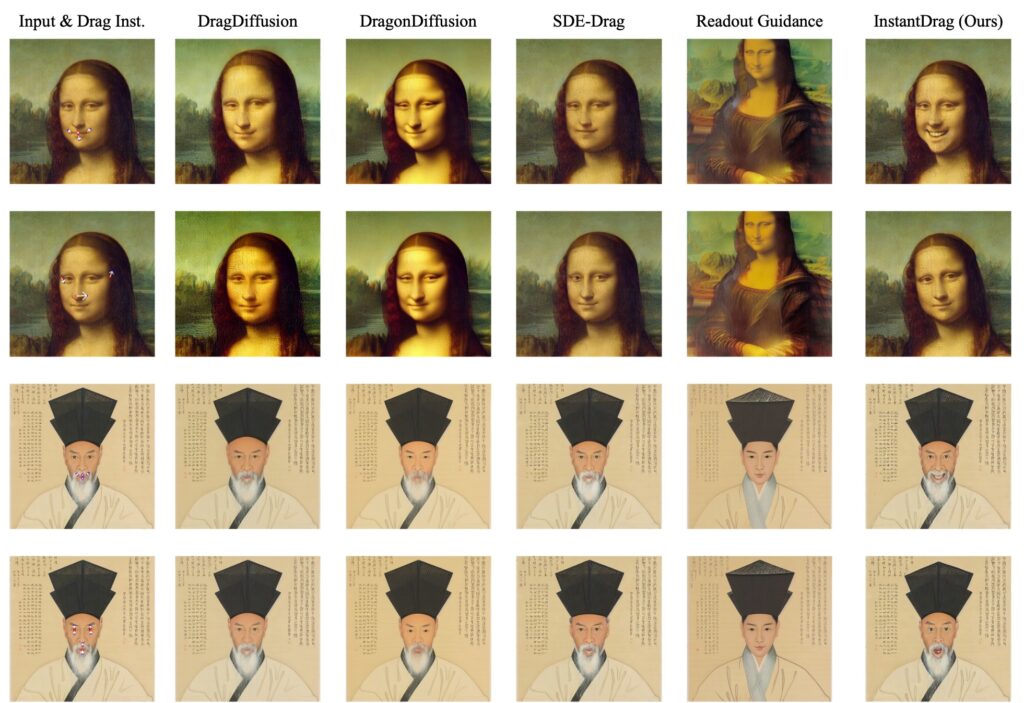

定性的評価

他の手法との比較として、DragGANやDragDiffusionなどの手法とInstantDragを比較しています。その結果、InstantDragは編集速度の点で非常に優れており、約1秒で編集が完了します。

さらに、テキスト入力やマスクを使用せずに高品質な画像編集を実現している点が確認されています。特に、顔の細かな表情や動きの編集において高い精度が示されています。

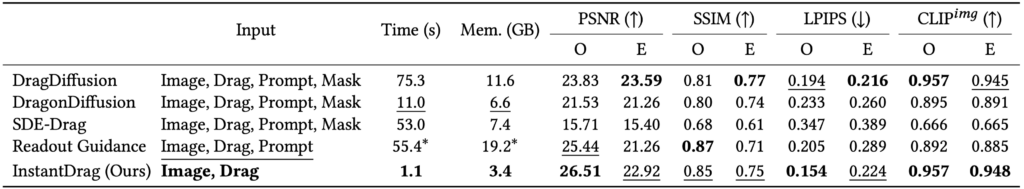

定量的評価

定量的な評価では、主にTalkingHead-1KHデータセットを使用し、PSNRやSSIM、LPIPS、CLIPイメージ類似度などの指標を用いて比較が行われました。

InstantDragは、特にPSNRやSSIMにおいて優れた結果を示し、他の手法と比べて精度が高く、かつ処理速度が大幅に向上していることが確認されています。

ユーザースタディ

ユーザーのフィードバックをもとに、InstantDragの操作性や編集結果に対する評価も行われました。

ユーザーは、指示に従った編集の精度、対象物の識別保持、および全体的な編集品質を評価し、InstantDragが他の手法と比べて総合的に優れていると判断されました。

結論

この論文の結論は、提案された「InstantDrag」が、ドラッグ操作による画像編集において、インタラクティブ性と効率性を大幅に向上させた点にあります。

ただし、限界もあり、特に光学フローを利用する手法のため、大きな動きに対しては対応が難しいことや、顔以外のシーンではファインチューニングなしでは精度が低くなる場合がある点が指摘されています。これらの課題を解決するために、より多様なデータセットでの訓練を行うことで、さらなるパフォーマンス向上が期待されています。

最終的に、InstantDragは、ドラッグベースの画像編集技術における新しい方向性を示し、リアルタイムでのインタラクティブな編集を幅広いデバイスで実現する可能性を広げています。