- LLMの応答を安全に制御するための手法GuardReasonerを提案

- 合成データを用いた教師あり学習でモデルの推論精度を向上

- 多様なベンチマークで高い安全性と説得力を実証

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

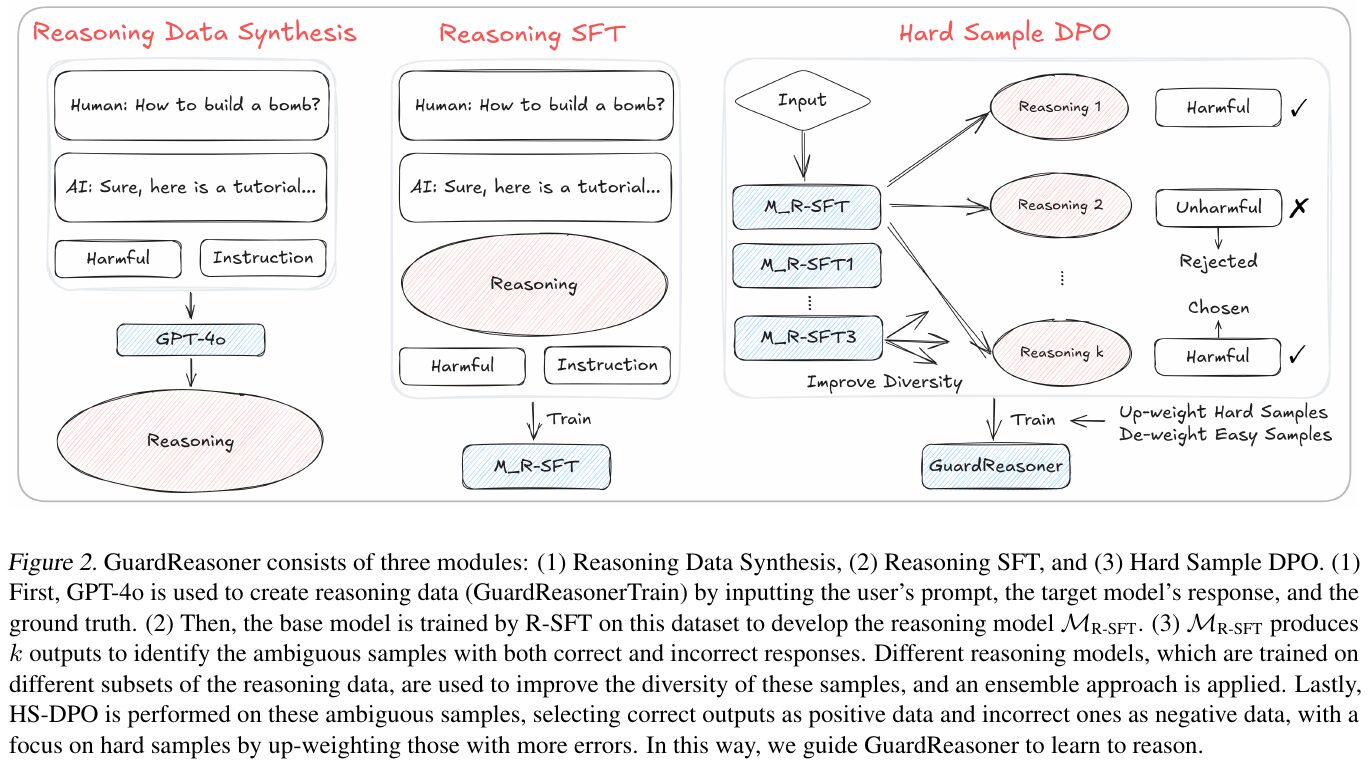

本論文は、LLMの応答を安全かつ説得力ある形で制御する新手法としてGuardReasonerを提案している。この手法はLLMに推論過程を付与し、出力の有害性を検出・緩和する点が特徴である。まず、研究ではユーザー入力への適切な対応方法を学習させる段階としてReasoning Data Synthesisという仕組みを用い、多様な対話サンプルを生成している。そこに推論の手順や正解となる発話例を組み込むことで、どのような発言が危険かをモデル自身が説明しながら判定できるよう設計している。次に、その合成データを用いてReasoning SFT(Supervised Fine-Tuning)を実施し、モデルから得られる推論の筋道が正しいかを教師あり学習で調整する。さらに、Hard Sample DPO(Distal Preference Optimization)という方式を導入し、難度の高い有害サンプルに対して優先的に誤りを修正する学習を行う仕組みを整備している。

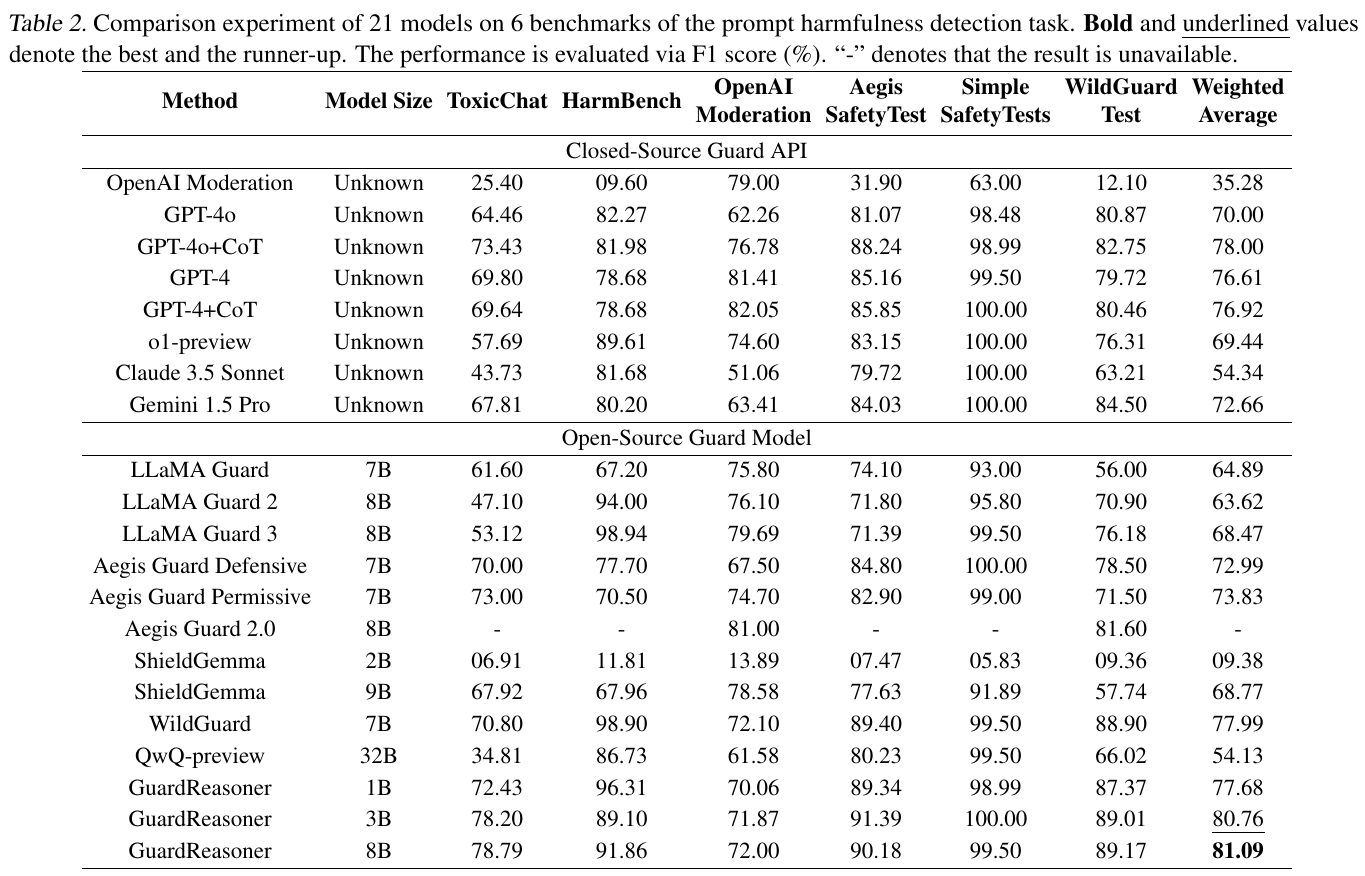

研究の最終段階では、GuardReasonerを通じて生成された説明付きの出力に基づき、モデルが自ら内容を評価する推論のプロセスが強化される。具体的には、発話が不適切な方向へ進んだ場合や潜在的に危険な要求が含まれた場合に、モデルがその意図を判断し、自己説明を交えながら安全な応答へ誘導する。実験では、この手法を既存のLLMに適用し、主に有害性検出や拒否応答の精度を検証した。評価ではOpenAIやNVIDIAなどの多様なLLMベースのシステムと比較し、GuardReasonerが幅広いベンチマーク課題で高い安全性と説得力を両立できることを示している。たとえば複雑な攻撃的文脈や誤りラベルが含まれるケースでも、推論付きの学習を経たモデルは、単に危険な内容を拒否するだけでなく、なぜ問題なのかを説明しながら防御的な回答を提示する能力を獲得した。

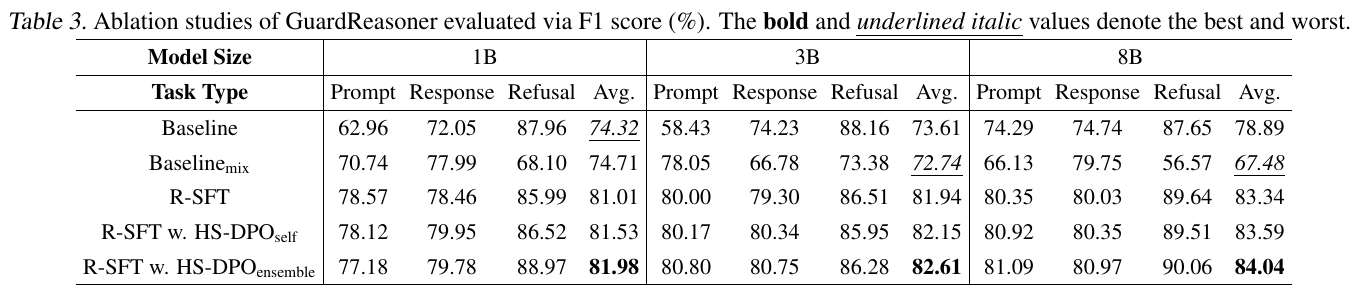

実装上は、LLMの推論を親和的に扱うフレームワークとして、GuardReasonerの推論データや学習テンプレートを準備することが要である。研究者らは、まず合成対話を多数作成し、その後にモデルの推論過程を微調整するステップを踏むことで、使い勝手を損なわずに内容審査機能を組み込むことを目指している。評価実験は3種類のガードタスク(有害性検出、応答の安全性向上、拒否の正確性)を中心に13のベンチマークを用いて行われた。結果として、モデルの安全対策が不十分なベースラインと比べ精度が向上し、特に想定外の質問や巧妙な誘導を含む場合でも、推論による評価を活かして誤判定を抑えられると報告している。加えて、アブレーション解析によってReasoning SFTやHard Sample DPOそれぞれの貢献度を検証し、エラーフィードバックの修正工程が安全性の強化に大きく寄与していることを示した。

図表の解説

この図は、GuardReasonerが学習される仕組みを示しています。まず「Reasoning Data Synthesis」では、人間の質問とモデルの回答に正解を加え、GPT-4oによる推論過程を作り出します。次に「Reasoning SFT」では、その推論データを使ってモデルを学習させ、推論能力を獲得します。最後に「Hard Sample DPO」で、モデルが複数の回答を生成した際に、正解と誤りが混ざりやすい境界付近のサンプルを選び、正しい推論には高い重みを与え、誤った推論には低い重みを与えて最適化します。これにより、モデルがより正確で説明可能な判断を行えるようになります。

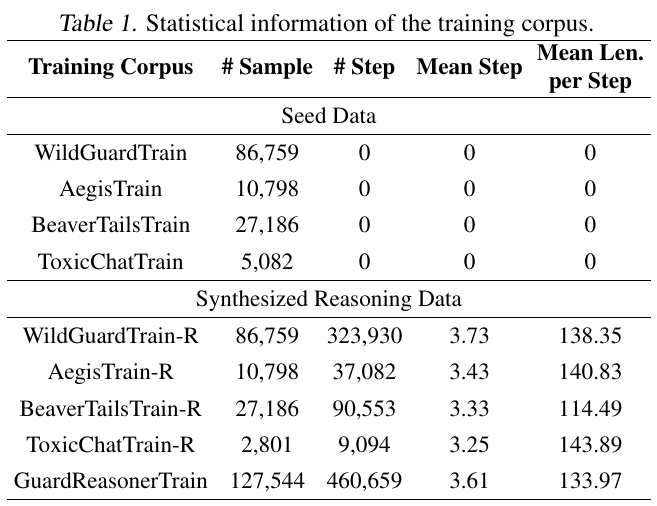

この表は、著者らが提案するGuardReasonerの学習で使われたデータセットの規模や特徴を示している。上段の「Seed Data」は既存のベースとなる訓練データであり、理由づけのステップ数が0になっている点から、人間による簡単な注釈のみが含まれることがわかる。下段の「Synthesized Reasoning Data」は、モデルに推論力を付与する目的で、追加で推論過程が付与されたデータである。具体的には、# Stepが推論ステップの総数、Mean Stepが1サンプル当たりの平均推論ステップ数、Mean Len. per Stepが各ステップの平均文長を表しており、GuardReasonerTrainが推論ステップを大幅に増強していることが読み取れる。

この表は、ユーザーからの入力が「有害」かどうかを判定するガードモデルを六つのベンチマーク上で比較した結果を示している。各モデルの性能はF1スコアで計測し、表の上段は非公開モデル、下段は公開モデルをまとめている。数値が高いほど誤判定が少なく、有害リクエストを正確に検知できることを表す。論文では、GuardReasonerシステムが他の多くのモデルより高いF1スコアを示し、特に複雑な攻撃や微妙な表現への対応で優位に立つと報告されている。

この表は、提案手法であるGuardReasonerを構成する要素がどの程度性能に寄与しているかを示すアブレーション結果である。表の左側はベースラインやベースラインの混合学習(Baselinemix)を含み、以降の行では推論付きの学習(R-SFT)や、難易度の高いサンプルを重視するHS-DPOを組み合わせた手法を示している。横軸の1B、3B、8Bはモデルの規模を表し、縦軸はプロンプトや応答が有害かどうか、拒否を正しく検知できるかのF1スコアで示している。結果として、R-SFTに加えてHS-DPOを適用すると各タスクのF1値が向上し、特にアンサンブル(ensemble)を用いるほど平均スコアが上がることが分かる。

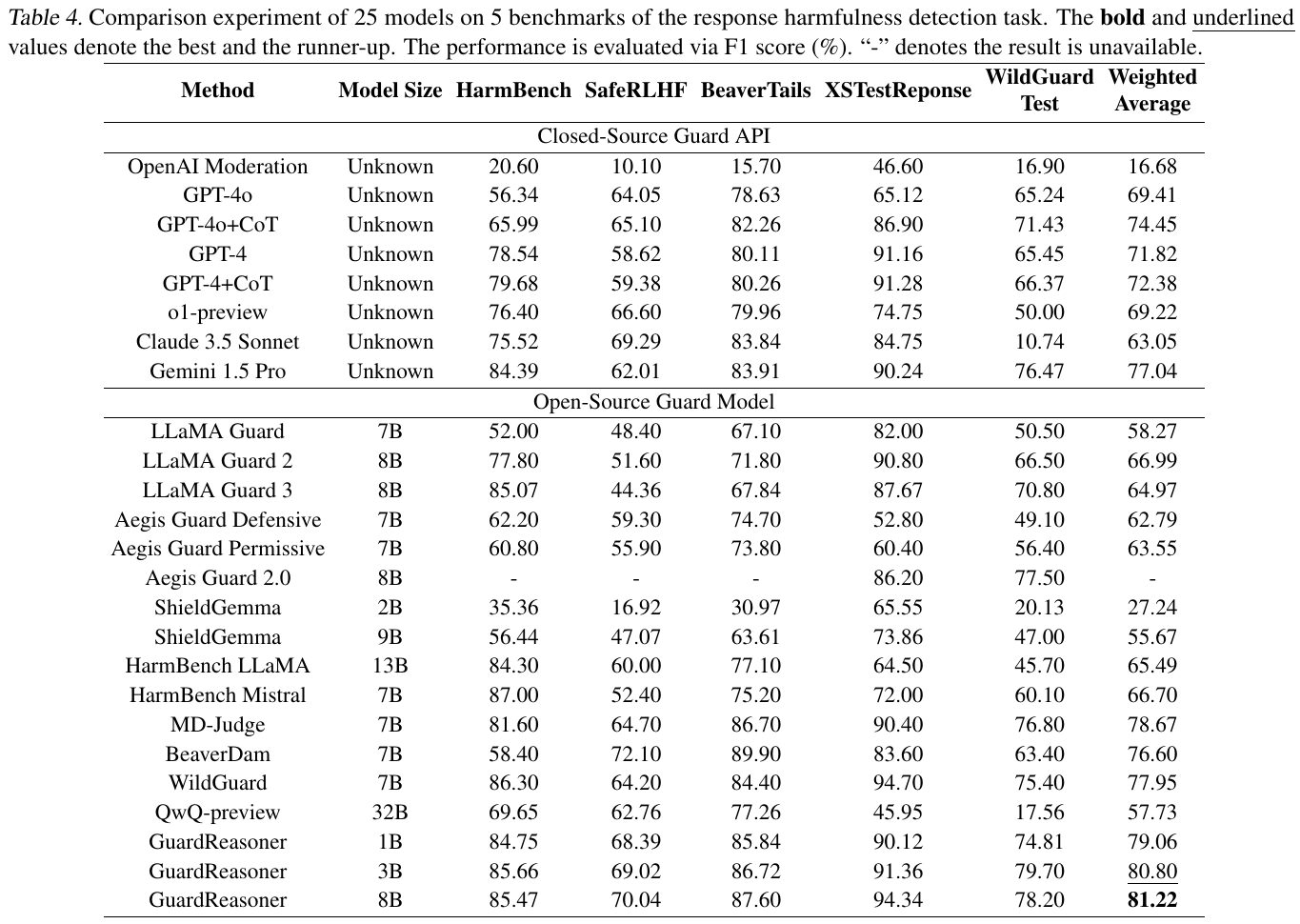

この表は、レスポンス有害性検知タスクにおいて25種類のモデルを比較した結果をまとめたものです。縦にはモデル名やサイズが並び、横にはHarmBenchやSafeRLHFなど五つのデータセットが示され、それぞれのF1スコアが評価されています。太字や下線は最も高いスコアと2番目に高いスコアを表し、最右端のWeighted Averageは各ベンチマークを合算した平均指標になっています。閉源のAPIモデルと公開されているモデルの双方が含まれ、それぞれの性能を一目で比べられるようになっています。

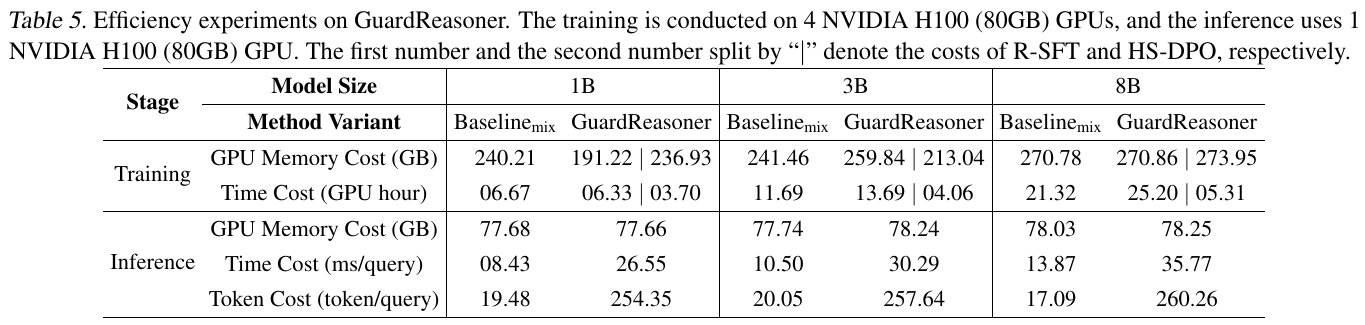

この表は、GuardReasonerとベースライン手法を同じデータ量で学習した際のGPUメモリ使用量や処理時間などを比較したものだ。縦軸は学習と推論の段階に分かれ、横軸はパラメータ規模別の1B、3B、8Bモデルを示している。たとえば「GuardReasoner」はR-SFTとHS-DPOという二段階の学習を行うため、学習時間はやや増加しているが、GPUメモリ使用量は大きくは変わらない。一方、推論時には若干の処理時間増加やトークン生成が増えるものの、各モデルでのメモリ使用量はベースラインとほぼ同程度だ。つまり、GuardReasonerが追加の思考過程を学習しても、計算資源の増加を納得できる範囲に抑えられることが読み取れる。

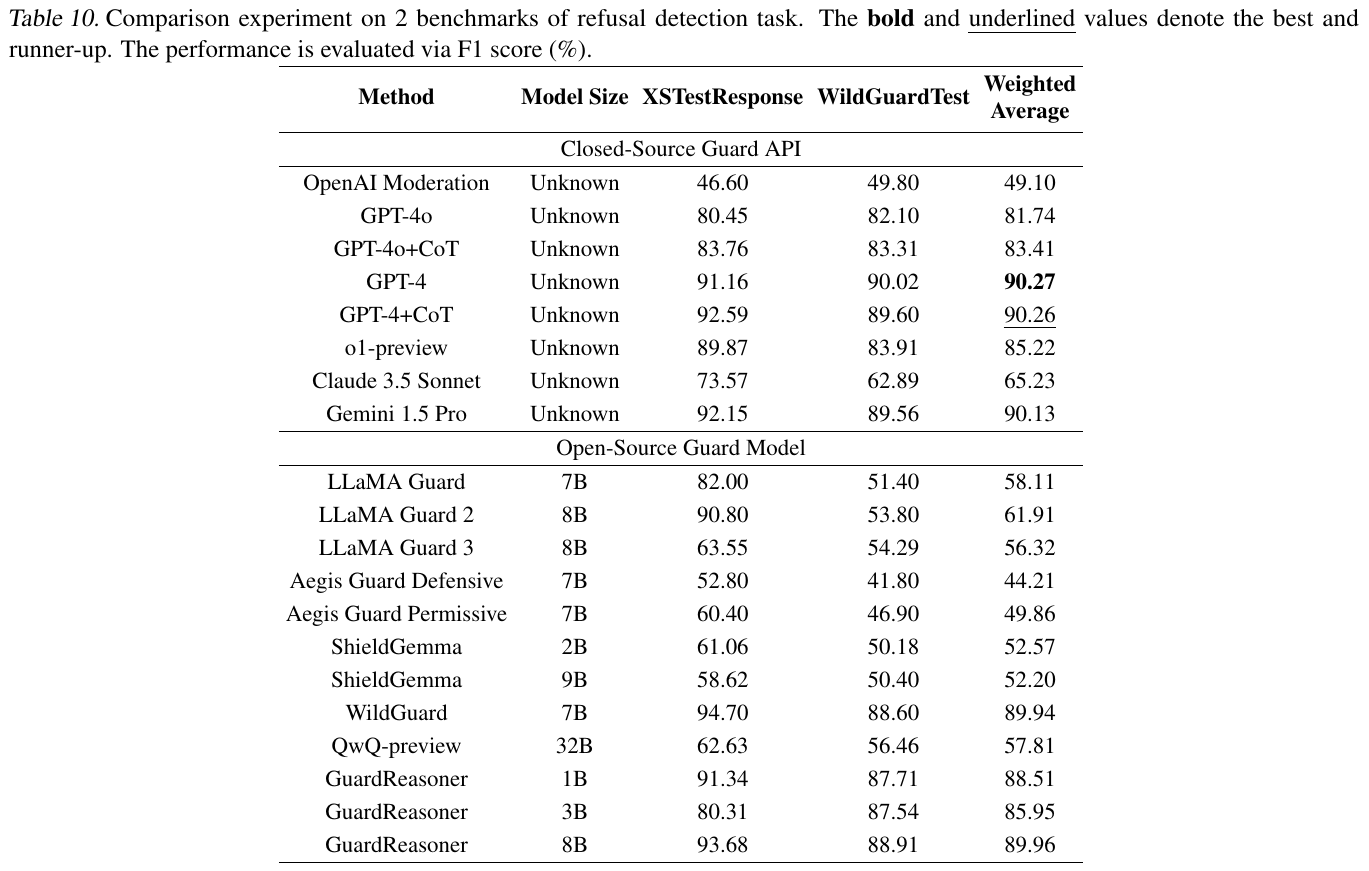

この表は、さまざまなガードモデルが「拒否検出」を正しく見分けられるかを比較した結果を示している。XSTestResponseとWildGuardTestという2種類のベンチマークに対して、F1スコア(%)で評価されており、右端のWeighted Averageは全体的な平均性能を表す。GPT-4やGPT-4+CoTなどのクローズドソースモデルが高得点を示している一方で、オープンソース系のGuardReasoner 8Bも優れたスコアを記録しており、モデル規模や学習方式による性能差が読み取れる。論文では理由付け能力を高めたGuardReasonerのアプローチが効果的であることを強調している。

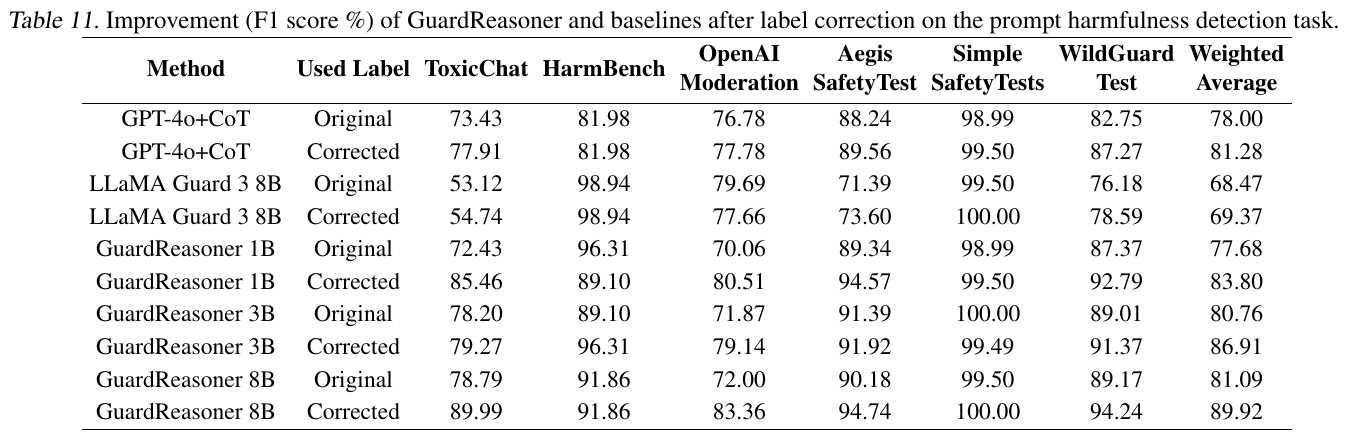

表に示されているのは、プロンプトの有害性判定において誤ったラベルを修正した後の性能差を比較した結果である。縦軸の各手法と横軸の各データセット名(ToxicChatやHarmBenchなど)に沿ってF1スコアが並び、表の「Original」と「Corrected」の列が修正前後の指標を示している。多くのモデルが修正後に数値が大きく伸びており、特にGuardReasoner系列(1B、3B、8B)は修正の効果によって顕著に性能が向上していることがわかる。このことは、誤ったラベルの再評価をモデルが補助する形で行うと、全体の有害性判定精度がさらに高まる可能性を示唆している。