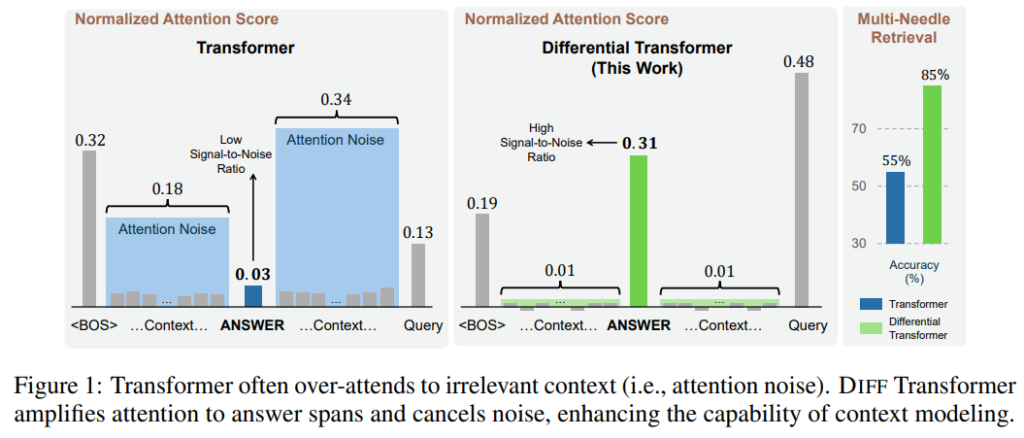

この論文では、従来のTransformerが不要な文脈に過剰に注意を向けてしまう問題を解決する「Differential Transformer」を提案しています。2つの異なる注意マップの差分を取ることでノイズを相殺し、重要な情報により注意を向けられるようになりました。その結果、長文の理解や質問応答、要約生成などの性能が向上し、同じ性能を得るために必要なパラメータ数や学習データを35%削減できました。

論文:Differential Transformer

GitHub:https://github.com/microsoft/unilm/tree/master/Diff-Transformer

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

この研究のポイントは?

本論文は、Transformerモデルが不要な文脈に過剰に注意を向けてしまう問題に着目し、新しい「Differential Transformer」アーキテクチャを提案しています。

概要

この論文では、Transformerモデルが抱える「不要な文脈に過剰に注意を向けてしまう」という問題に着目し、新しい解決策を提案しています。

従来のTransformerは、入力された文章の中で本当に重要な情報とそうでない情報を適切に区別できず、結果として正確な情報抽出や要約生成などのタスクで性能が低下していました。この問題を解決するために、研究チームは「Differential Transformer」という新しいアーキテクチャを開発しました。

このモデルは、2つの異なる注意マップの差分を取ることで、共通のノイズを相殺し、重要な情報により注意を向けられる仕組みを実現しています。これはノイズキャンセリングヘッドホンの原理に似た考え方です。

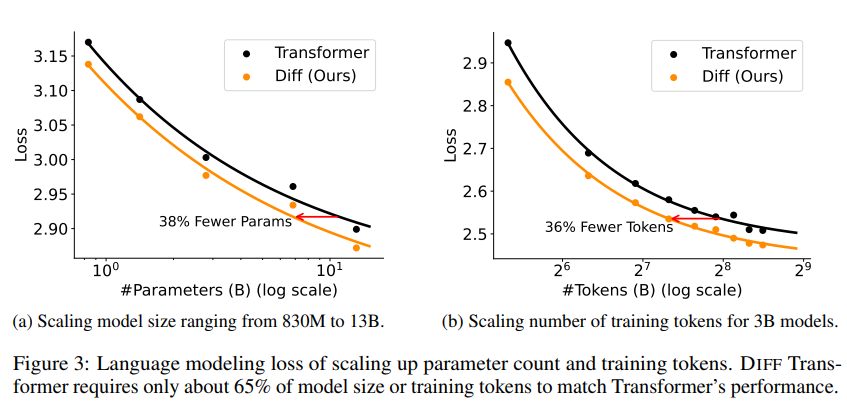

実験結果では、同じ性能を得るために必要なパラメータ数や学習データを約35%削減できただけでなく、長文の理解や質問応答、要約生成などの様々なタスクで性能が向上しました。特に文脈からの重要な情報抽出と幻覚の抑制に大きな効果を示しています。

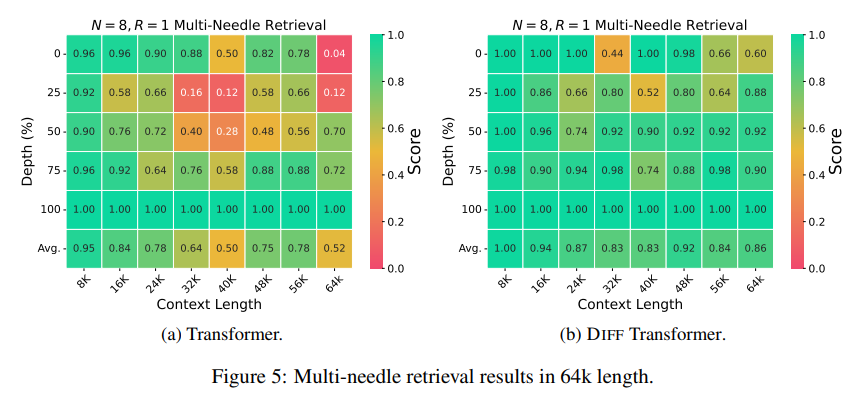

また、64,000トークンまでの長い文章でも安定した性能を維持できることや、学習時のメモリ使用量も効率化されるなど、実用面でも優れた特徴を持っています。

提案手法

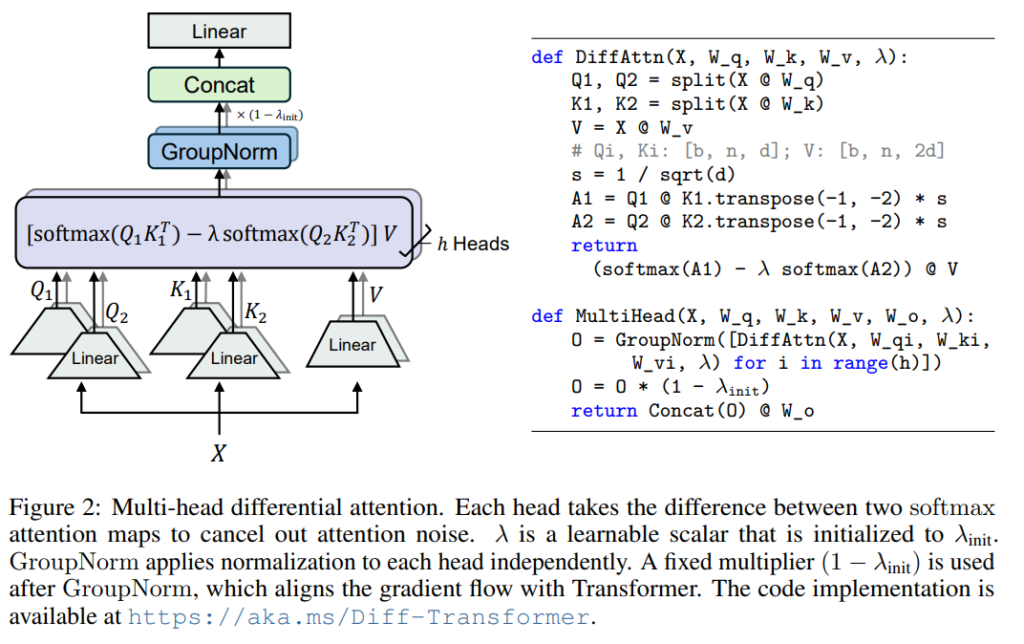

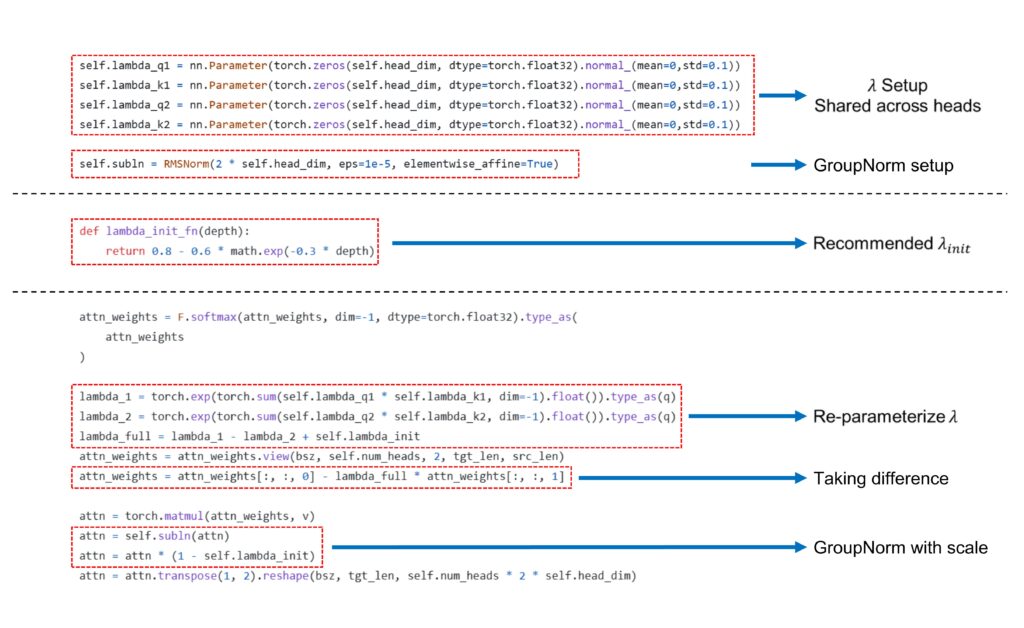

提案手法では、2つの異なる注意マップを計算し、その差分を取ることで不要な注意(ノイズ)を相殺します。具体的には、クエリとキーベクトルを2つのグループに分割し、それぞれで注意スコアを計算した後、その差分を最終的な注意スコアとして使用します。

この手法により、モデルは重要な情報により注意を向けられるようになり、以下のような利点が得られました:

- 同じ性能を得るために必要なパラメータ数や学習データを約35%削減

- 長文の理解や質問応答、要約生成などの性能が向上

- 64,000トークンまでの長い文章でも安定した性能を維持

- 文脈からの重要な情報抽出と幻覚の抑制に効果を発揮

- 学習時のメモリ使用量が効率化

さらに、モデルの活性化値の外れ値が減少し、量子化にも有利な特性を持っています。

Core Code:

実験

この論文では、3つの主要な実験を行って提案手法の有効性を検証しています。

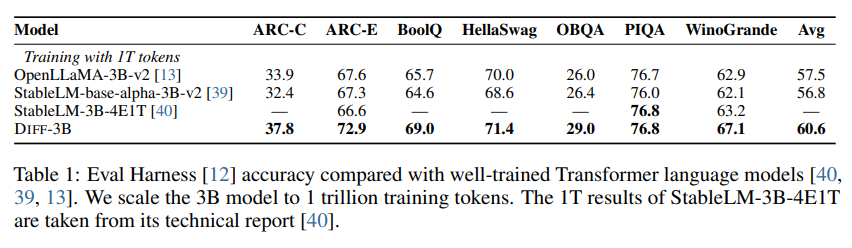

まず、言語モデリングの評価実験では、3Bパラメータのモデルを1兆トークンで学習し、既存のTransformerベースのモデルと比較しました。その結果、提案手法は従来手法を上回る性能を示しています。

次に、スケーラビリティの実験では、モデルサイズと学習トークン数を変えて性能を比較しました。提案手法は従来のTransformerと比べて、同等の性能を得るために必要なパラメータ数や学習データを約65%削減できることが分かりました。

さらに、長文脈の理解に関する実験では、64,000トークンまでの長い文章での性能を評価しました。提案手法は文章の長さが増えても安定した性能を維持し、特に重要な情報の抽出と幻覚の抑制において優れた結果を示しています。

また、質問応答や要約生成などの実用的なタスクでも評価を行い、提案手法が一貫して優れた性能を発揮することを確認しました。特に、文脈からの重要な情報抽出において、従来手法と比べて30%以上の精度向上を達成しています。

結論

この論文では、Transformerモデルの注意機構を改良した「Differential Transformer」を提案しています。従来のTransformerは不要な文脈に過剰に注意を向けてしまう問題がありましたが、新しいアーキテクチャはこの問題を解決し、重要な情報により注目できるようになりました。

特筆すべき点として、Differential Transformerは文脈内学習の精度を向上させただけでなく、従来のTransformerで問題となっていた順序変更に対する頑健性も大幅に改善しました。さらに、モデルの活性化値の外れ値を減少させることで、量子化にも有利な特性を持っています。

これらの結果は、Differential Transformerが大規模言語モデルの基盤アーキテクチャとして非常に有効で将来性のあるものであることを示しています。今後の研究では、この新しいアーキテクチャを活用して、より効率的な低ビット注意機構の開発や、キー・バリューキャッシュの圧縮などが期待されています。