- コード生成モデルの評価を改善するための新手法CodeRM-88を提案

- ユニットテストの自動生成と動的スケーリングで、評価精度を向上

- 難易度の高い問題でも優れた性能を示し、既存手法より大幅に改善した評価結果

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

この論文では、コード生成モデルの評価における課題を克服するため、CodeRM-88という新たな手法が提案されています。現在のLLM(大規模言語モデル)を用いたコード生成においては、モデルの品質評価が難しい点が課題となっています。特に、ユニットテストを用いたコードの評価は広く利用されていますが、その適用範囲や精度に限界があり、難易度の高いコード問題では依然として十分なパフォーマンスが得られていません。

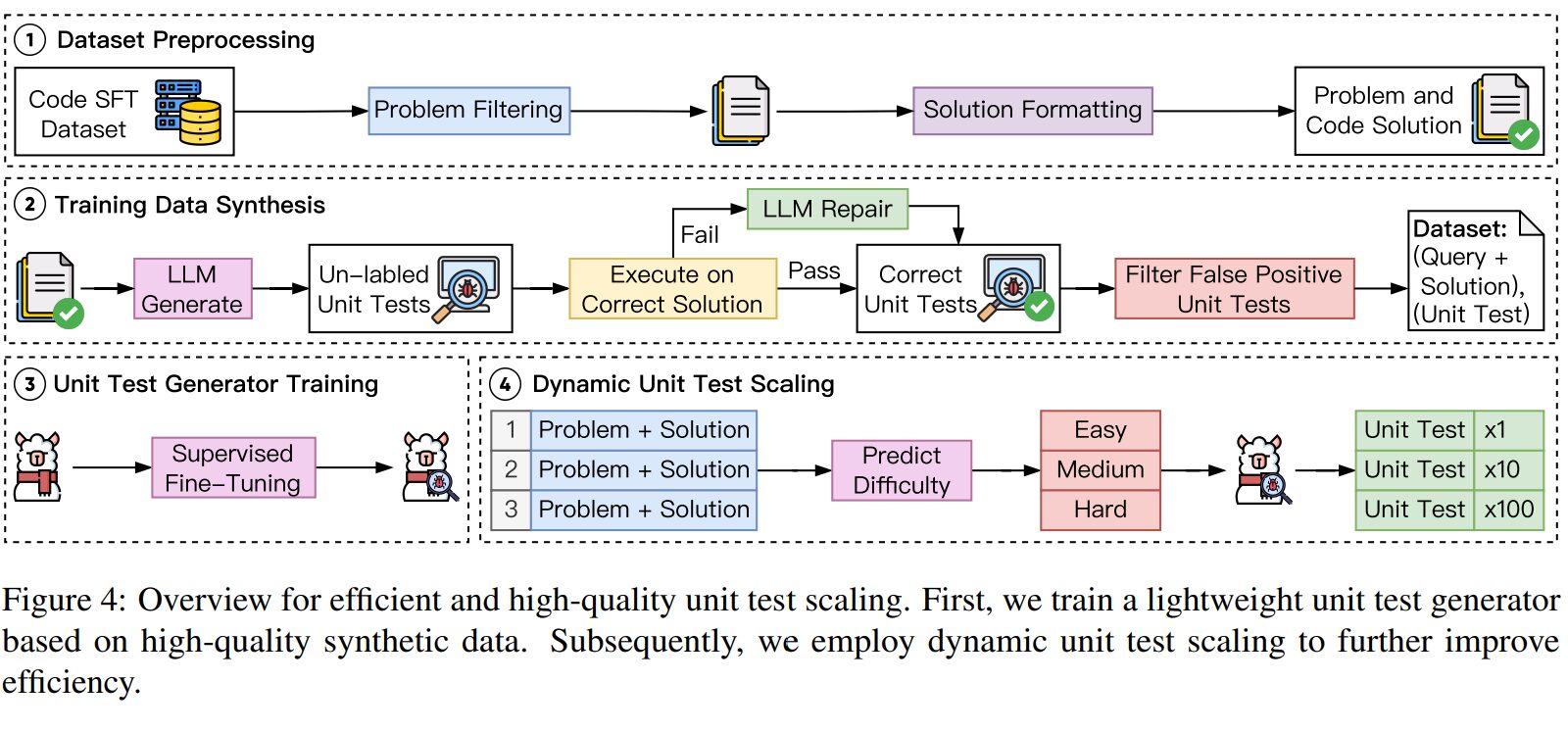

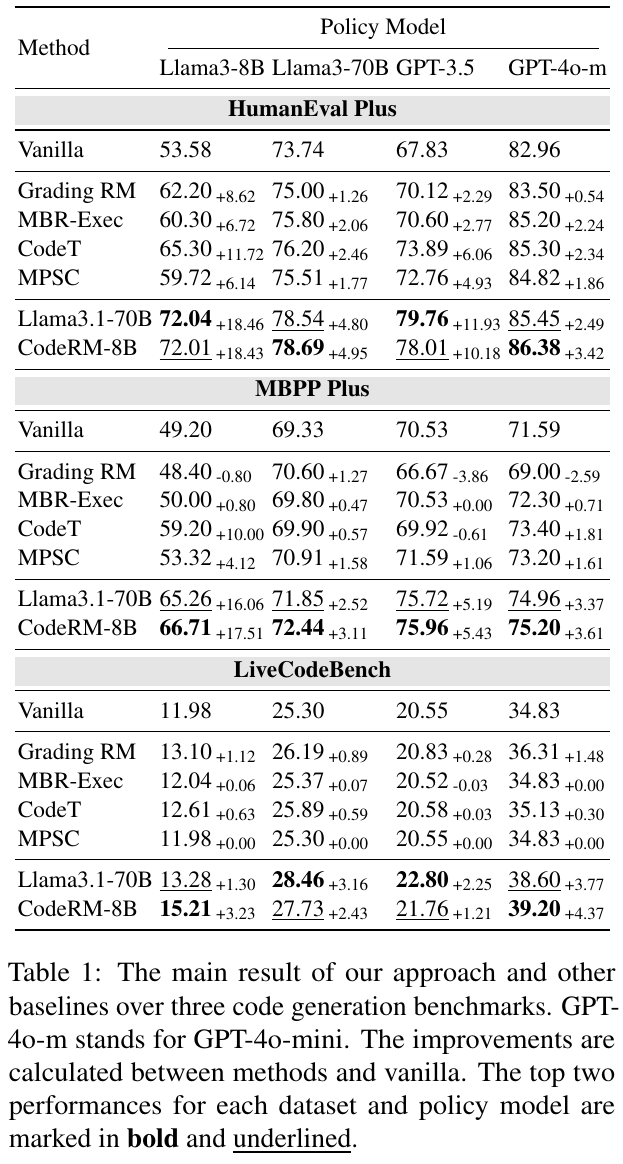

提案されたCodeRM-88は、モデルの評価精度を高めるため、より効率的かつ高い品質のユニットテストを生成・拡張する新しい方法を導入しています。具体的には、まずデータ合成パイプラインを使用して多様性のあるユニットテストを作成します。この手法では問題難易度に基づいてパラメータを動的に調整する仕組みを採用し、計算資源を効率的に活用します。さらに、「動的スケーリング戦略」を導入し、問題の難易度に応じてテストの規模を調整することで、正確な評価を可能にしています。

実験では、CodeRM-88が従来の手法よりも難易度の高い問題においても高い性能を示すことが確認されました。特に、「Pass@k」や「False Rejection Rate」などの評価指標で優れた結果を達成しており、Humaneval PlusやMBPP Plusのベンチマーク上で約45%から84%の性能向上が見られました。また、訓練されたモデルが生成したコード解の品質を効果的に向上させていることが示されています。

図表の解説

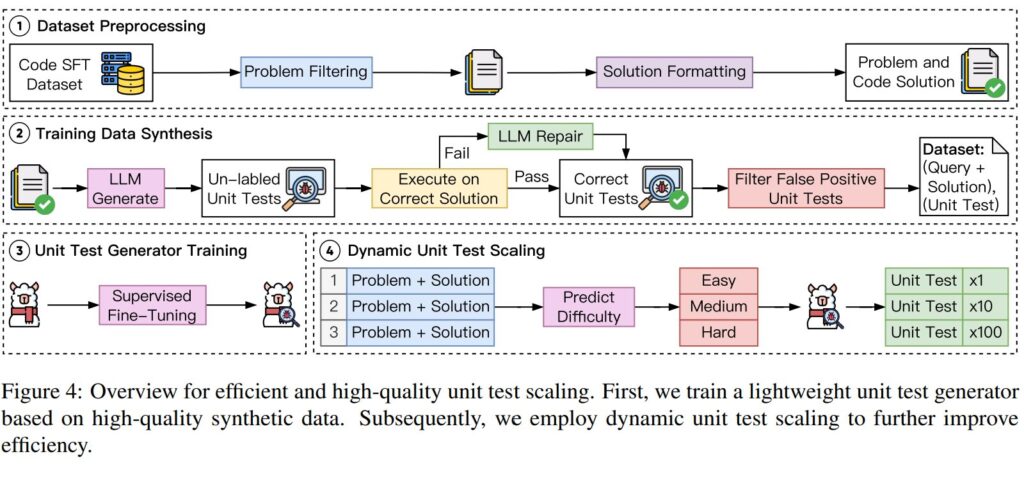

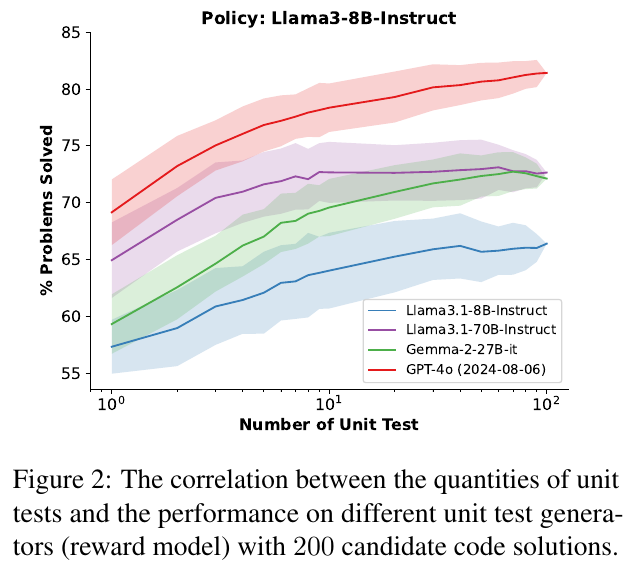

図1は、多数決のためのユニットテストの量を増やすと、さまざまなポリシーモデルと報酬モデルで性能が向上することを示しています。ポリシーモデルはコードのソリューションを生成するモデルを指し、報酬モデルはユニットテストを生成するモデルを指します。ユニットテストの数を増やすと、全体の性能が高まり、特に複雑な問題でより顕著な改善が見られます。これは、最良の解決策を見つけやすくするための効果的なアプローチです。

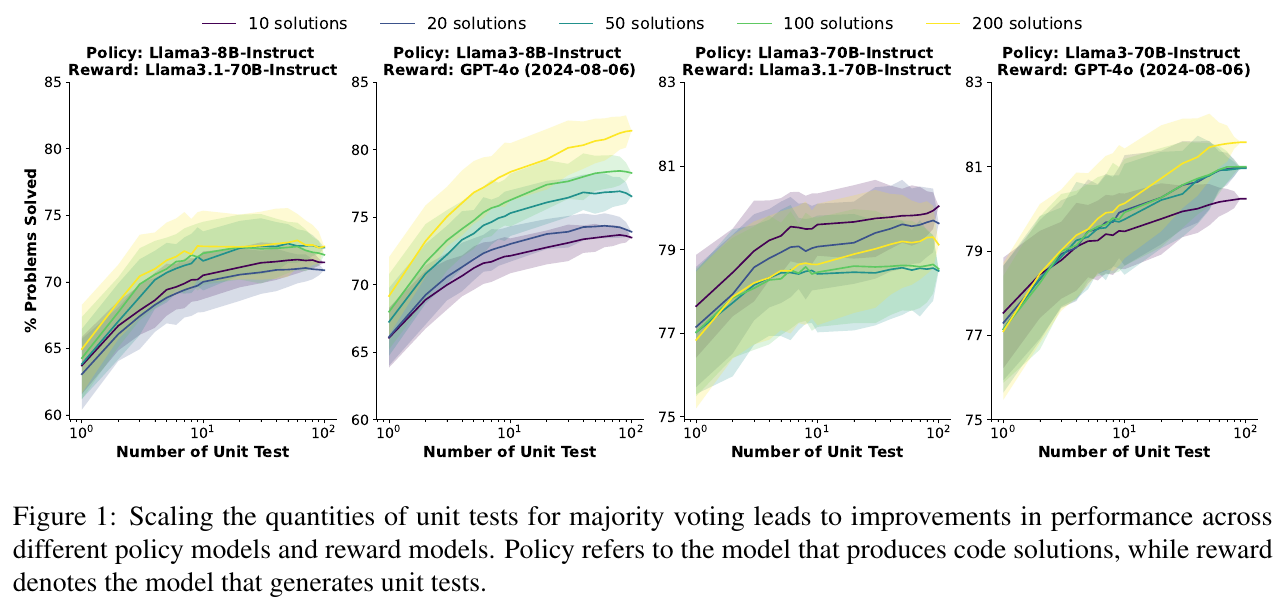

この表は、「HumanEval Plus」「MBPP Plus」「LiveCodeBench」という3つのコード生成ベンチマークでの主要な結果を示しており、異なる「ポリシーモデル」と「メソッド」の性能を比較しています。ここでは特に、さまざまな手法が「バニラ」状態、つまり標準的なモデルに対してどの程度性能が向上するかを示しています。表の太字と下線は、各データセットとモデルにおけるトップ2の性能を示し、特に「CodeRM-8B」が多くのケースで高い性能を発揮していることが分かります。

図2は、モデルがユニットテストの数を増やすことで問題解決能力が向上する様子を示しています。特に、Llama3.1-70B-InstructとGPT-4oが用いられると、他のモデルよりも高い性能を達成しています。この図から分かるのは、ユニットテストが多いほど、より多くの問題を解決できる可能性が高まるということです。特に困難な問題では、ユニットテストの数を増やすことで、性能の向上がより顕著に現れます。

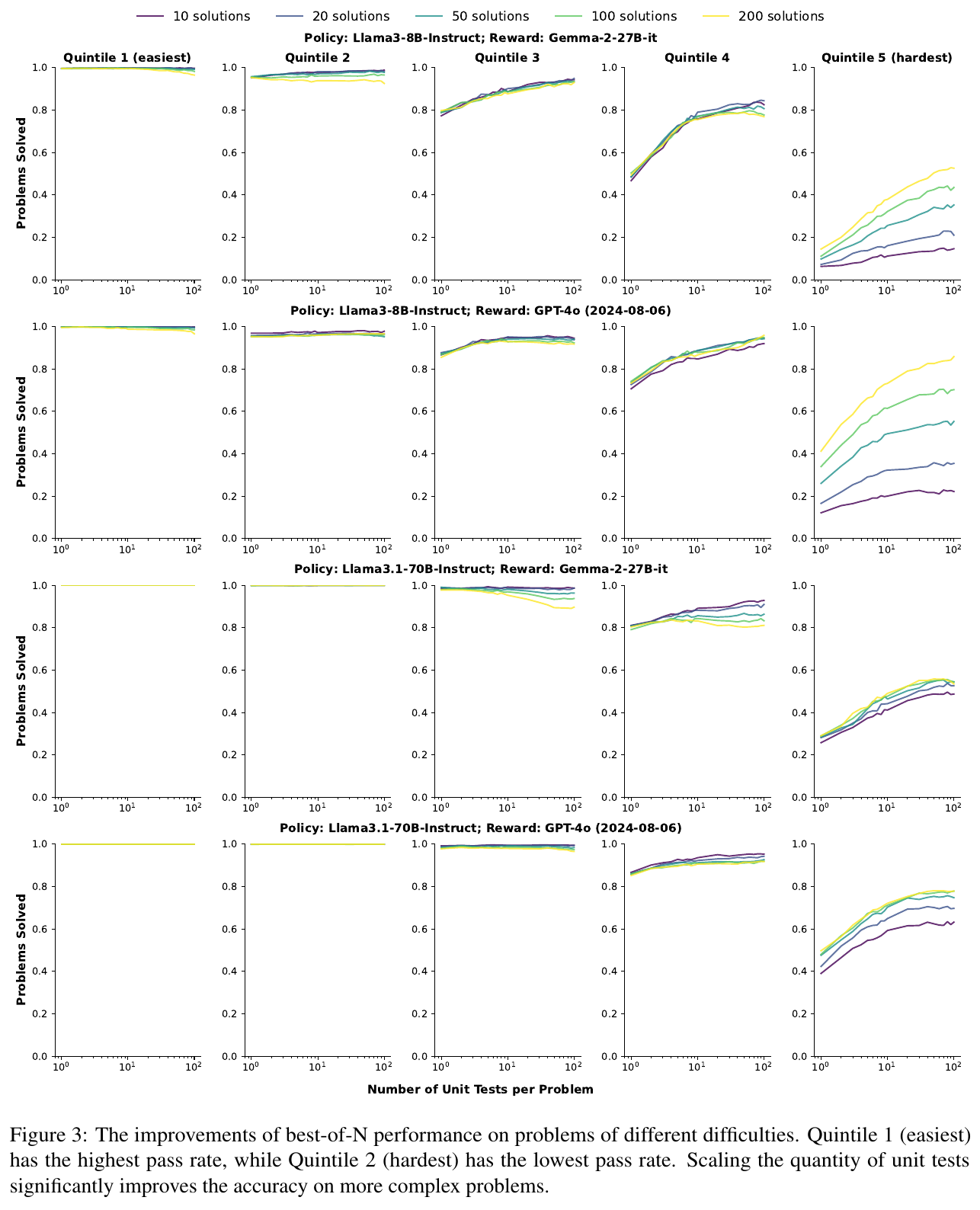

この図は、異なる困難度の問題に対するベスト・オブ・Nアプローチの性能向上を示しています。図では、最も簡単な「クインタイル1」から最も難しい「クインタイル5」までの5つのカテゴリーに分類されています。単体テストの数を増やすと、特に難しい「クインタイル5」で問題解決率が向上します。このことは複雑な問題に対してテストを増やすことが有効であることを示唆しています。

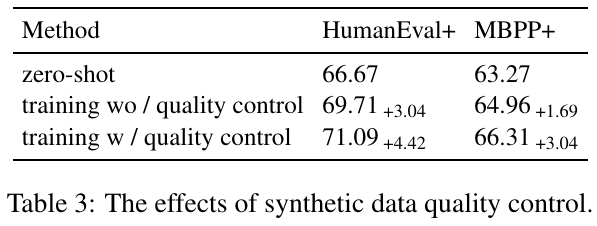

表3は、合成データの品質管理がユニットテストの効果にどのように影響するかを示しています。「zero-shot」は事前に訓練されていないモデルの性能を表し、「training wo / quality control」は品質管理なしで訓練されたモデル、「training w / quality control」は品質管理付きで訓練されたモデルです。結果として、品質管理を導入すると、「HumanEval+」と「MBPP+」の評価指標でのモデル性能が向上しています。これにより、データ品質の向上がコード生成モデルの精度に寄与することが示されています。

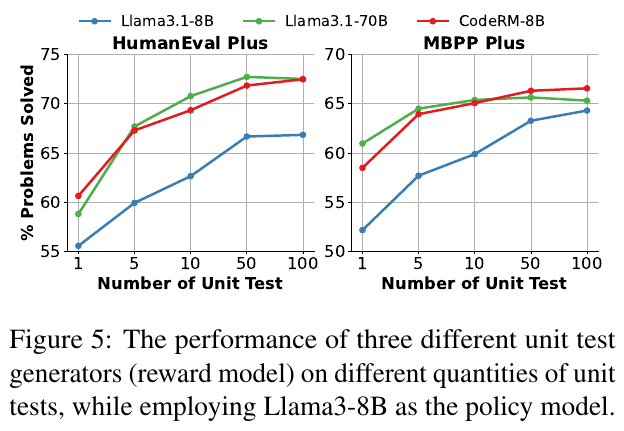

この図は、Llama3-8Bをポリシーモデルとして使用し、異なる数のユニットテストを生成する3つの異なるユニットテスト生成モデル(リワードモデル)の性能を示しています。グラフからわかるように、ユニットテストの数が増えるにつれて、解決できる問題の割合が増加します。特にCodeRM-8Bのリワードモデルは、他のモデルと比較して高いパフォーマンスを示しています。これは、より多くのユニットテストを生成することが、結果の精度を高めることを示唆しています。

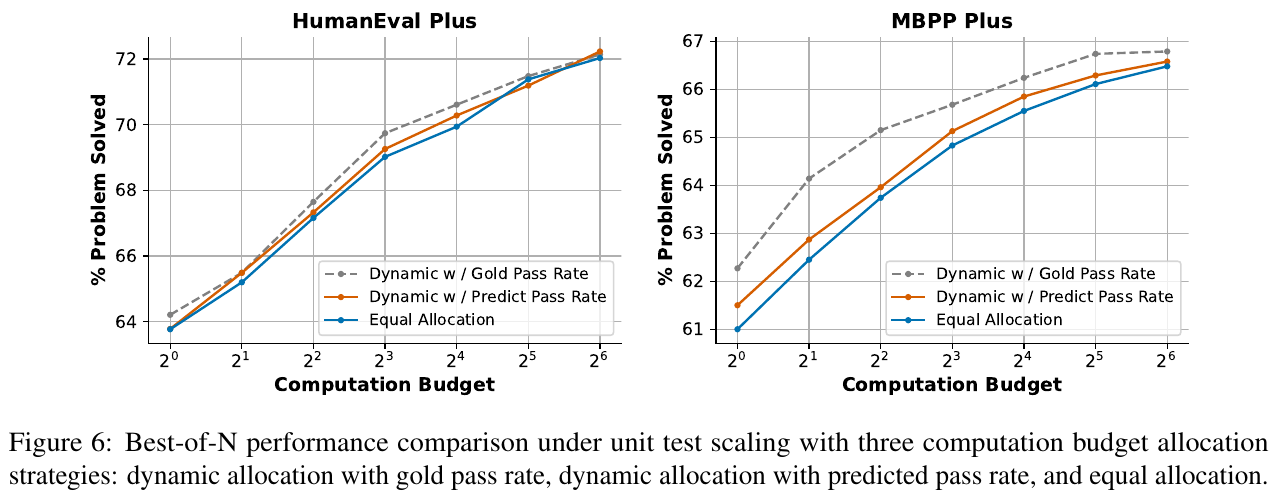

この図は、コード生成のユニットテスト割り当て方法の効果を示しています。図の左側は「HumanEval Plus」、右側は「MBPP Plus」の結果を表しています。3つの異なる戦略が比較されており、ゴールドパスレートを用いた動的割り当て、予測パスレートを用いた動的割り当て、そして均等割り当てがあります。結果は、動的なユニットテストの割り当てが特に固定された計算コストで性能を向上させることを示しています。

画像は、異なるモデルによって生成された単位テストの品質を示しています。表の上半分は個々の単位テストの結果、下半分は複数の単位テストを組み合わせた結果を示しています。精度(Acc)やF1スコア(F1)は高いほど良く、偽陽性率(FAR)や偽陰性率(FRR)は低いほど良い指標です。CodeRM-8Bモデルは、特に複数の単位テストで高い性能を示しており、既存のLlama3モデルと比較して優れた結果を達成しています。これにより、CodeRM-8Bが多様な視点からの評価を提供し、より高品質な評価信号を生成していることが示唆されます。