- 数学的な推論能力を高める新手法「BoostStep」の提案

- 推論プロセスを細かく分解し、各ステップで適切な例を示す学習法

- 複数の数学ベンチマークで優れた性能を確認し、誤り率を低下

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

本論文では、LLM(大規模言語モデル)の数学的推論能力を向上させる新しいアプローチ「BoostStep」が提案されています。数学的推論はモデルにとって特に困難な課題であり、多くの場合で誤りが生じる背景には、問題へのアプローチを誤ることや過程での間違いが含まれています。本研究では、推論過程をより細かい単位(ステップレベル)に分解し、逐次的な修正を可能にすることで、LLMの性能を向上させる方法論を探究しました。

本手法の中核となるのが「ステップレベルでのインコンテキスト学習」です。従来の問題全体を単位とした学習方法とは異なり、本手法では解決プロセスをステップごとに分解し、各ステップにおける適切な例を提示してモデルの推論を誘導します。さらに、これを補完する目的で「ステップレベルの例題バンク」を構築しました。このバンクには適切な具体例が収録されており、モデルが個々のステップでの最適な推論につながるよう設計されています。

実験では、MATHEQAやGSM8kなどの複数の数学ベンチマークデータセットを用いて評価を行いました。評価の結果、本手法は従来の問題単位での学習方法や一般的なRetriever戦略よりも優れた性能を示しました。特に、問題の誤り率を著しく低下させ、プロセス全体を通じてより正確な数学的推論能力を実現することが確認されました。このように、BoostStepはモデルの能力を細分化された単位で逐次的に向上させ、従来の手法の限界を克服する効果的なアプローチであると結論付けられます。

図表の解説

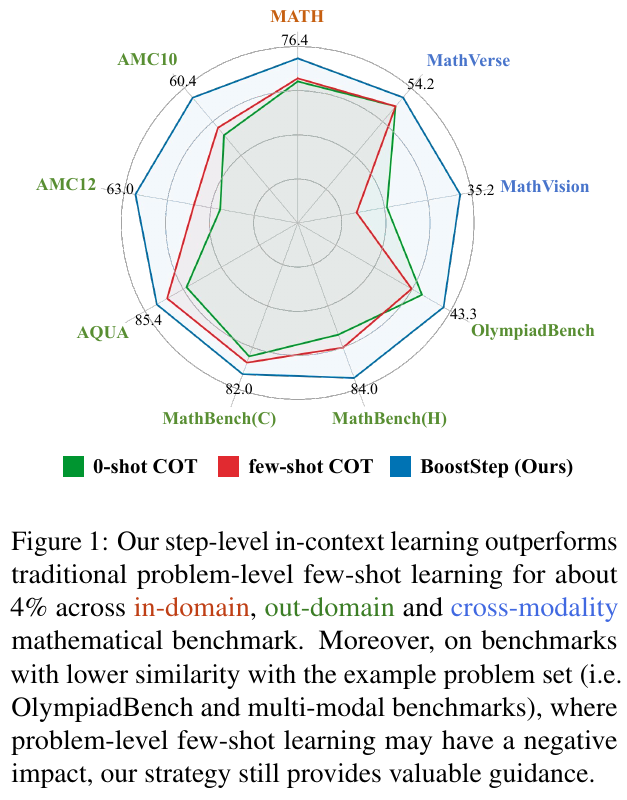

この図は、数学的推論の性能を比較したものです。緑の線は「0-shot COT」、赤の線は「few-shot COT」、青の線は「BoostStep(提案手法)」を示しています。このレーダーチャートは、様々な数学のベンチマークにおける異なる手法の性能を視覚化しています。 BoostStepは、伝統的な問題レベルのfew-shot学習よりも約4%優れた結果を示しています。特に、OlympiadBenchなどの類似性が低いベンチマークでも、提案手法は有用な指針を提供します。提案手法の優位性は、ステップごとの詳細な例を提供することによって、モデルの推論能力を向上させ、一般化可能性を高めている点にあります。

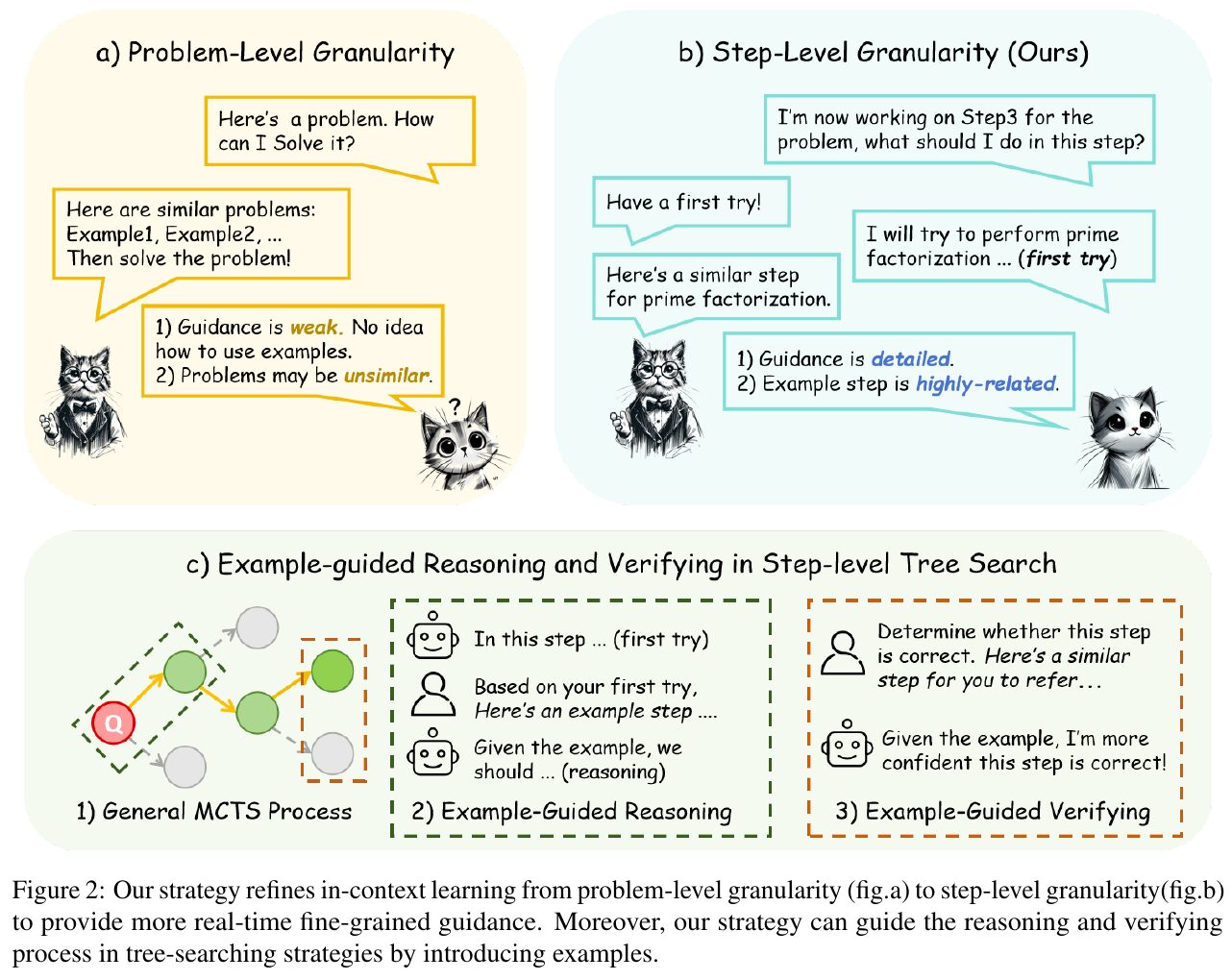

この図は、大規模言語モデルのための「BoostStep」という方法について説明しています。まず、問題レベルの粒度(a)は、類似の問題を挙げて解くやり方で、ガイダンスが弱く問題が不類似である可能性があると指摘されています。これに対し、ステップレベルの粒度(b)は、特定のステップに対して詳細で関連性の高いガイダンスを提供する方法です。最後に、例に基づく推論と検証(c)では、モンテカルロ木探索の手法を用いて、推論および検証の過程で例を取り入れることにより、モデルの推論の質を向上させることを示しています。これにより、ステップごとの具体的なガイダンスが得られ、推論の正確性が向上します。

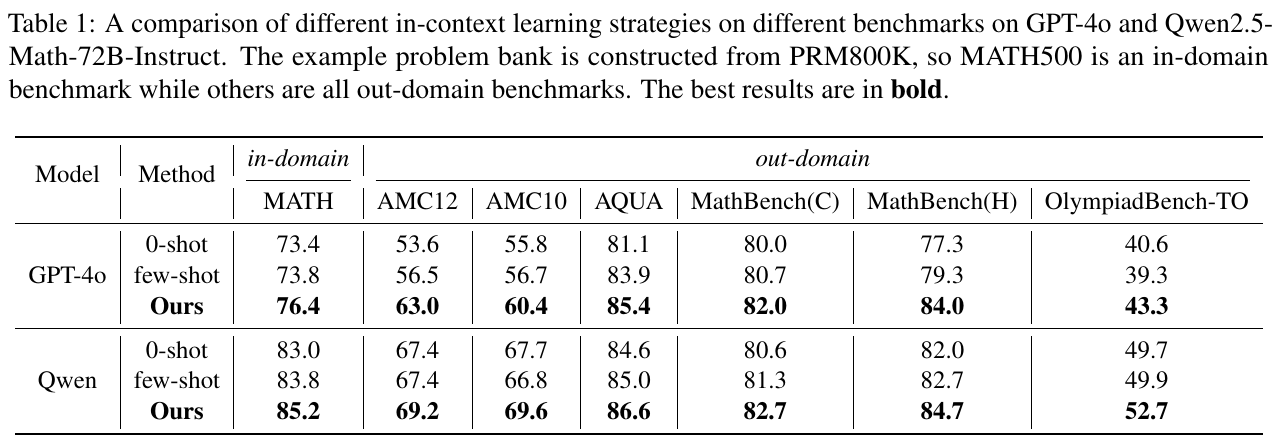

この表は、GPT-4oとQwen2.5-Math-72B-Instructというモデルに対し、異なるベンチマークでのインコンテキスト学習戦略を比較しています。具体的には、0-shot、few-shot、および提案された手法(Ours)の3つの方法で行われています。「in-domain」のMATHは、例の問題バンクで訓練されたものである一方、他のベンチマークは「out-domain」に分類されています。結果は、提案された手法(Ours)が全体的に最も高い得点を示し、特にAMC12やOlympiadBench-TOなどで顕著な向上を見せています。このことから、提案された手法が従来の方法よりも優れたパフォーマンスを発揮することがわかります。

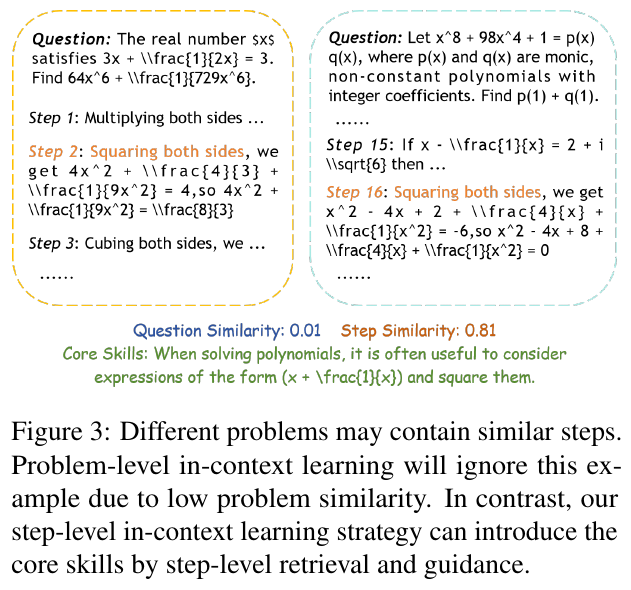

この図は、異なる数学の問題が似たようなステップを含むことを示しています。左側の問題と右側の問題は、表面的には異なる課題ですが、重要な計算ステップが類似しています。このような場合、従来の問題レベルの学習では、問題の類似性が低いために例を無視するかもしれません。しかし、ステップレベルでの学習では、個々のステップの類似性に基づいて例を活用し、類似のステップを見つけ出して正しい導き方を学び、問題解決に役立てることができます。この方法は、問題全体での学習に依存せず、特定の計算ステップのスキル向上を目指しています。

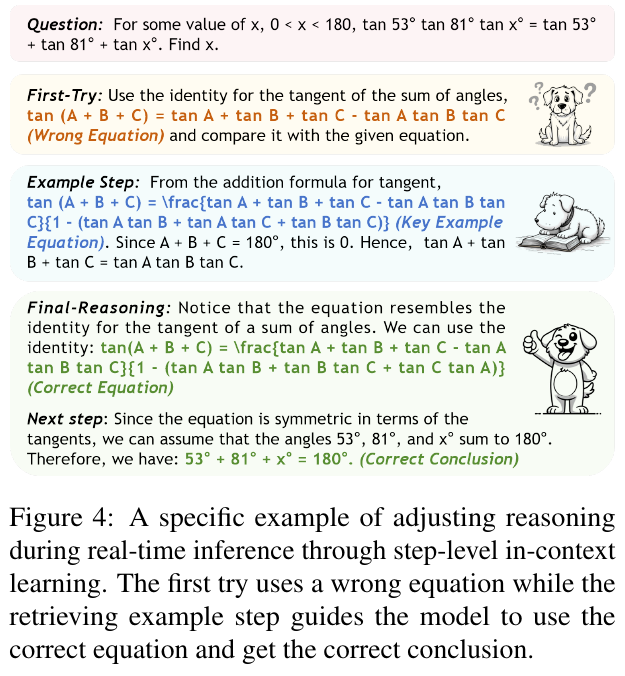

この画像は、数学問題を解く際に行う「逐次推論」の調整例を示しています。最初の試みでは、誤った方程式が使用されており、正しい例のステップを取り出すことで正しい結論に導かれます。具体的には、与えられた角の公式に誤った式を使ってしまいますが、例示されたステップを用いることで正しい方程式を適用し、角度の和が180度であることに気づきます。このプロセスは、論理モデルがステップごとの文脈に基づく学習を通じてリアルタイムに推論を調整し、最終的に正解にたどり着く能力を向上させることを示しています。

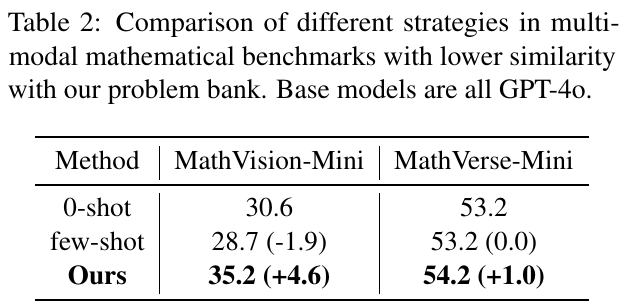

この表は、さまざまな戦略の効果をマルチモーダルな数学的ベンチマークで比較したものです。ベースモデルとしてはすべてGPT-4oが使われています。表には「0-shot」「few-shot」「Ours」の3つの手法が示されています。 1. **0-shotとfew-shot**: これらは、特定のコンテキストなしで問題を解く方法です。0-shotは事前の例を与えず、few-shotは少量の例を与えて解く方法です。例えば、MathVision-Miniでは、0-shotのスコアが30.6で、few-shotは28.7と少し減少しています。 2. **Ours(我々の手法)**: 改善された手法で、例えばMathVision-Miniではスコアが35.2と、既存手法と比べて4.6ポイント上昇しています。MathVerse-Miniでも若干の向上(+1.0)が見られます。 これにより、提案されたアプローチがより効果的であることが示されています。最小の問題セットとの類似性でパフォーマンスの向上が見られ、特に指定されたベンチマークで有意な改善が得られたことが強調されています。

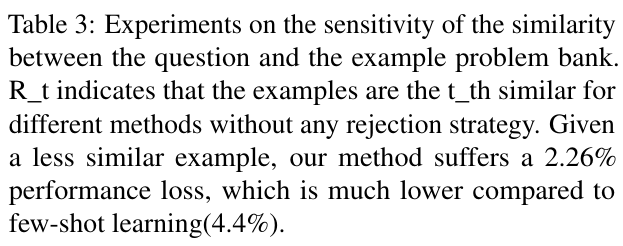

この表は、質問と例の問題バンクとの類似性に対する感度実験を示しています。具体的には、R_tが異なる方法で類似するt番目の例を示し、拒絶戦略なしで使用されています。この実験では、類似性が低い例を使用した場合、提案する方法では2.26%の性能低下が見られるのに対し、従来の少数ショット学習では4.4%も性能が低下します。したがって、提案する方法は少数ショット学習よりも性能低下が小さく、類似性が低い状況でもより優れた結果を示しています。これは、ステップごとの類似性に基づく方法が問題解決に有効であることを示唆しています。

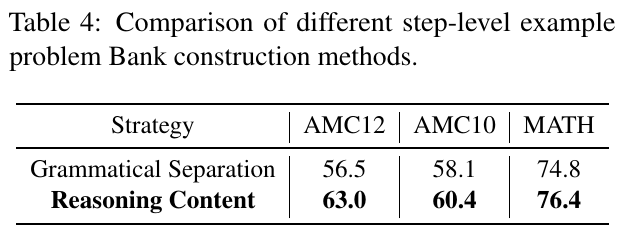

この表は、数学の問題解決におけるステップレベルの例題作成方法を比較したものです。表では、”Grammatical Separation”(文法的区切り)と”Reasoning Content”(推論内容)の二つの戦略が比較されています。AMC12、AMC10、MATHという異なる問題セットで、それぞれの戦略の効果が示されています。 “Reasoning Content”の方が、すべてのカテゴリでより高いスコアを示しており、特に数学において76.4と最も高い結果を得ています。このことは、推論内容に基づいてステップを作成する方法が、文法的な区切りによる方法よりも、モデルが問題をより正確に解決するのに役立つことを示唆しています。