この論文では、ロボットが目標の画像が撮影された場所へ自律的に到達するための新しい手法「BEINGS」を提案しています。BEINGSは3Dガウススプラッティングを用いて未来の視点を予測し、ベイズ更新を組み合わせることで、データに依存せず複雑な環境でも効率的なナビゲーションを可能にしました。

論文:BEINGS: Bayesian Embodied Image-goal Navigation with Gaussian Splatting

GitHub:https://github.com/guaMass/BEINGS

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

この研究のポイントは?

本論文の内容は、ロボットが目標の画像が撮影された場所に到達するための、ナビゲーション手法「BEINGS」を提案するものです。

本研究のポイントは、以下の通りです。

つまり、BEINGSは効率的なロボットナビゲーションを実現し、複雑な環境での自律的な探索を可能にする研究です。

背景

従来のナビゲーション手法では、データ依存や計算コストが高く、複雑な環境での探索が非効率的になるという課題がありました。

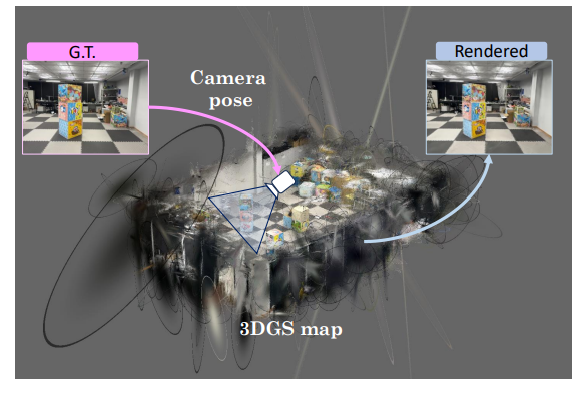

BEINGSはこれを解決するために、画像ゴールナビゲーションを最適制御問題として定式化し、3Dガウススプラッティング(3DGS)をシーンの事前情報として利用することで、ロボットが未来の観測を予測し、効率的にリアルタイムでナビゲーションを行うことを可能にしています。

この手法は、特に視覚的に複雑なシナリオでのロボットナビゲーションにおいて有効であり、探索とナビゲーションの戦略を動的に調整する能力を持つため、現実の環境でも高い適応力を示します。

提案手法

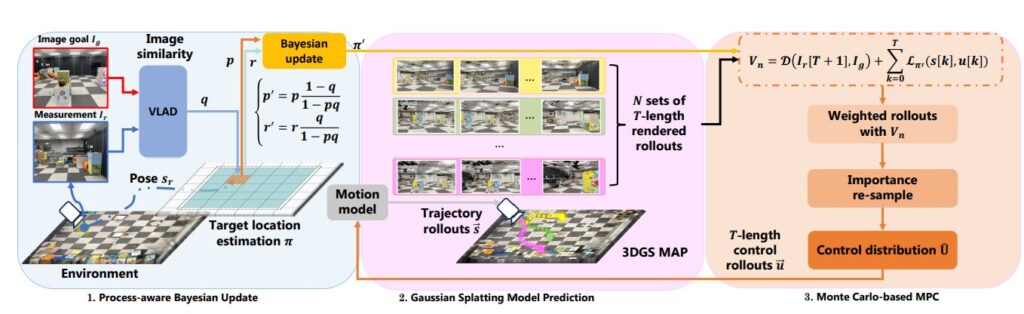

この論文では、ロボットが目標の画像が撮影された位置に到達するための「画像ゴールナビゲーション」を実現するために、「BEINGS(Bayesian Embodied Image-goal Navigation Using Gaussian Splatting)」という新しい手法が提案されています。

BEINGSは、画像ゴールナビゲーションを最適な制御問題として再定式化し、ナビゲーションの効率と適応性を向上させています。

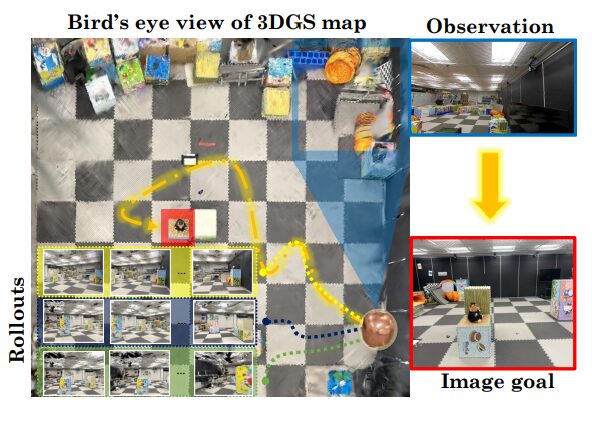

BEINGSの特徴は、3Dガウススプラッティング(3DGS)という技術をシーンの事前情報として活用する点です。この技術を使うことで、ロボットが将来の観測画像をリアルタイムで予測し、その情報を元に最適な行動を選択できるようになります。

さらに、ベイズ更新を組み合わせて、観測データに基づきナビゲーション戦略を動的に修正し、探索効率を高めます。

BEINGSは、まずロボットが新しい観測を得るたびに、目標位置の確率分布をベイズ理論に基づいて更新します。

また、3DGSを用いてカメラの位置から予測される画像を生成し、ナビゲーション戦略の選択に利用します。この方法は、人間の「想像力」や「記憶」に似たプロセスであり、ロボットが視覚的なフィードバックを基にして動的に判断を下すことを可能にしています。

さらに、モンテカルロ法に基づくモデル予測制御(MPC)を取り入れることで、複数の予測軌道をシミュレーションし、その中から最もコストが低い経路を選択します。

実験

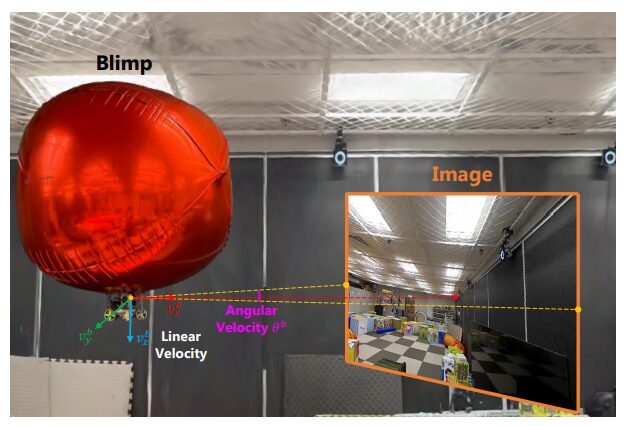

実験はシミュレーションと物理的な環境の両方で実施され、主に探索効率やナビゲーション精度を評価しています。

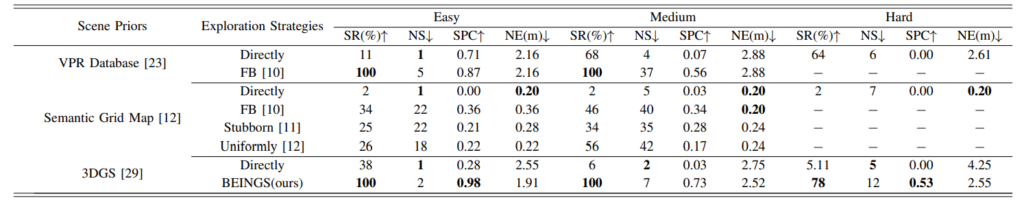

まず、シミュレーション環境において、BEINGSは異なる難易度のシナリオでテストされました。シナリオは簡単なものから難しいものまで設定されており、障害物の数や配置によって複雑さが増していきます。例えば、簡単なシナリオでは障害物がなく、ロボットは単に方向調整だけで目標に到達できますが、難しいシナリオでは複数の障害物を回避しながら目標に到達する必要があります。

BEINGSはこれらのシナリオ全てで高い成功率と効率的なナビゲーションを示しました。

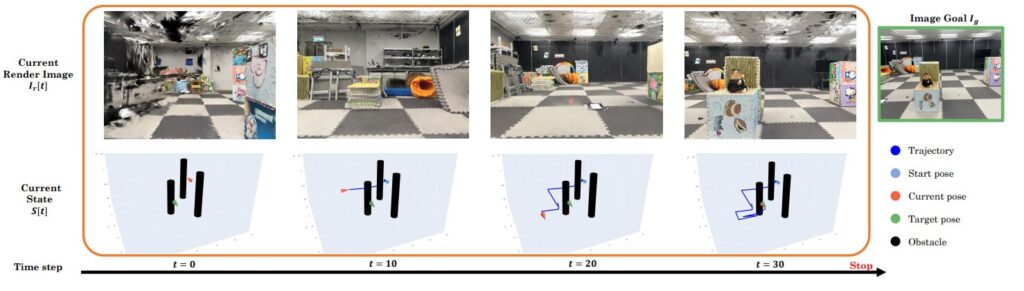

ロボットには、観測カメラと画像送信装置が搭載されており、現実世界での動作も評価されました。実験では、ロボットが室内テストフィールドで飛行し、目標画像の位置を探索する様子が観察されました。3Dガウススプラッティングに基づくシーン予測によって、ロボットは未来の視点をシミュレートしながら最適な経路を選択し、効率よく目標に近づきました。

さらに、提案手法の効果を比較するために、他の探索手法との比較実験も行われました。従来の手法では、学習に大量のデータを必要とするか、または事前に定義された探索戦略に依存していましたが、BEINGSはこれらの欠点を克服し、探索効率と適応性のバランスが取れた結果を示しました。難しいシナリオにおいても、従来手法よりも高い成功率を保ちつつ、移動コストを低く抑えることができました。

実験結果から、BEINGSは探索型と学習型のアプローチを効果的に統合し、視覚的に複雑な環境でも迅速かつ正確にナビゲーションを行えることが示されました。シミュレーションと実際のロボット環境での検証を通じて、その実用性が確認され、将来的にはさらに複雑な環境への適用も期待されています。

結論

この論文では、BEINGS(Bayesian Embodied Image-goal Navigation Using Gaussian Splatting)が画像ゴールナビゲーションにおいて新たな可能性を示したと結論づけています。従来の手法は、データに大きく依存し、計算コストが高いため、リアルな環境での適応性に限界がありました。

一方、BEINGSは3Dガウススプラッティングとベイズ理論を組み合わせることで、現実の環境でも柔軟に対応できるナビゲーションを実現しました。

この研究の成果は、特に視覚的に複雑な環境や変化の激しい状況において、ロボットが自律的に判断を下し、迅速かつ正確に行動できる新しいナビゲーション戦略の基盤を提供するものであり、今後はさらに高度な環境や屋外での応用も視野に入れた発展が期待されます。