- 離散トークンをビット単位で段階的に予測する「Masked Bit Modeling」により、コードブック規模の制約を解消

- ImageNet-256でgFID 0.99を達成し、DiffusionモデルやMARなど従来手法を上回る新たな最高性能を記録

- 従来手法比で最大20倍高速なサンプリングを実現し、品質と速度のトレードオフを大幅に改善

論文:https://arxiv.org/abs/2602.09024

研究の背景

画像生成AIの分野では、Diffusionモデルに代表される「連続値ベース」のアプローチが長らく主流でした。一方、言語モデルのようにトークンを1つずつ予測する「離散的な自己回帰型」のアプローチも研究されてきましたが、生成品質で連続値手法に及ばないとされてきました。

しかし、この性能差は離散化そのものの限界ではなく、トークン化の際の「圧縮率」の違いに起因するのではないか——そんな仮説のもとに行われたのが本研究です。離散トークンのコードブック(語彙)を大きくすれば連続値と同等以上の表現力が得られるはずですが、従来の手法ではコードブックサイズが大きくなると予測ヘッドのメモリ消費が爆発的に増加するという技術的課題がありました。

具体的には、コードブックサイズCに対して線形予測ヘッドのメモリ量はO(C)で増加するため、数万を超える語彙を持つ大規模コードブックの利用は現実的ではありませんでした。本論文では、この根本的なボトルネックを解消する新しいフレームワーク「BAR(masked Bit AutoRegressive modeling)」を提案しています。

提案手法

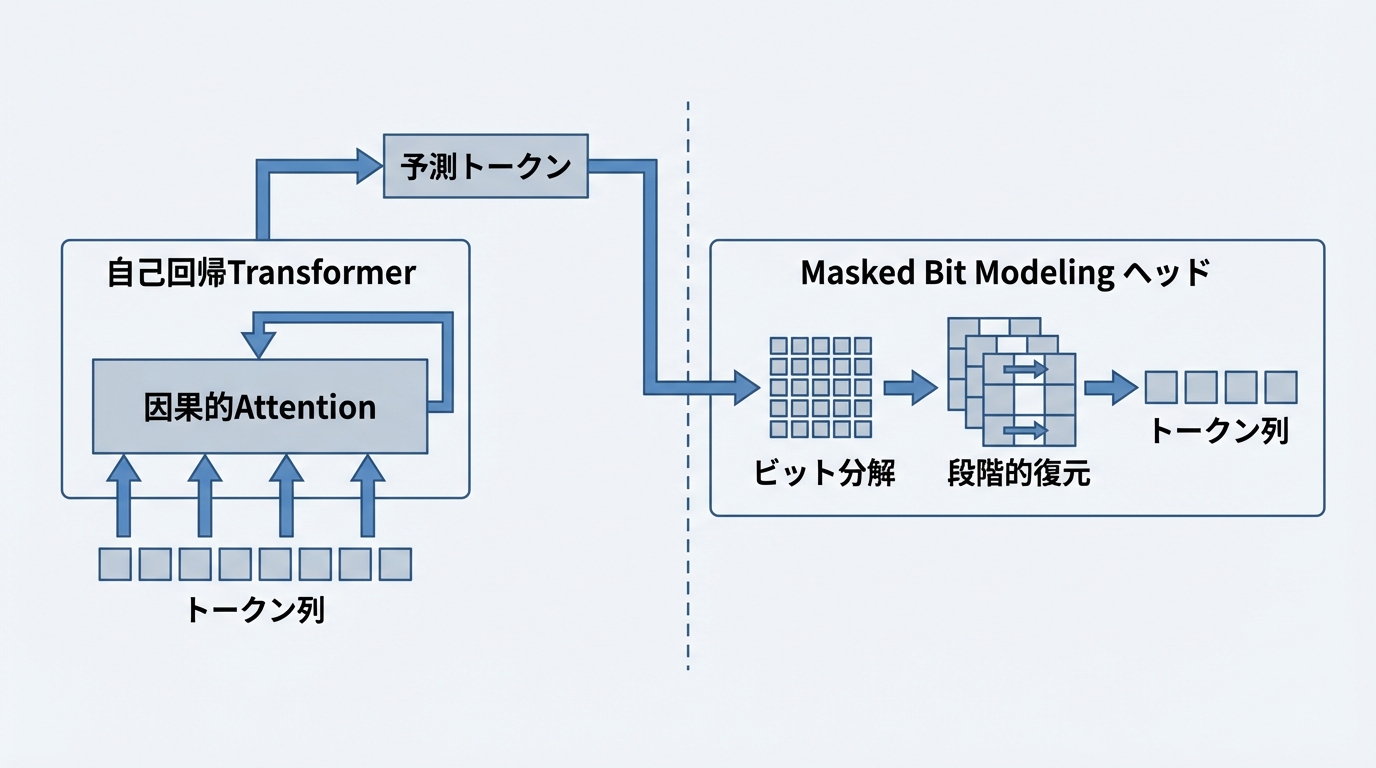

BARフレームワークは、大きく分けて2つのステージで構成されます。第1ステージの「コンテキストモデリング」では、自己回帰型Transformerが因果的Attention(過去のトークンだけを参照する仕組み)を用いて入力画像のトークン列を処理します。第2ステージでは、本研究の核となる「Masked Bit Modeling(MBM)ヘッド」がトークンの予測を担当します。

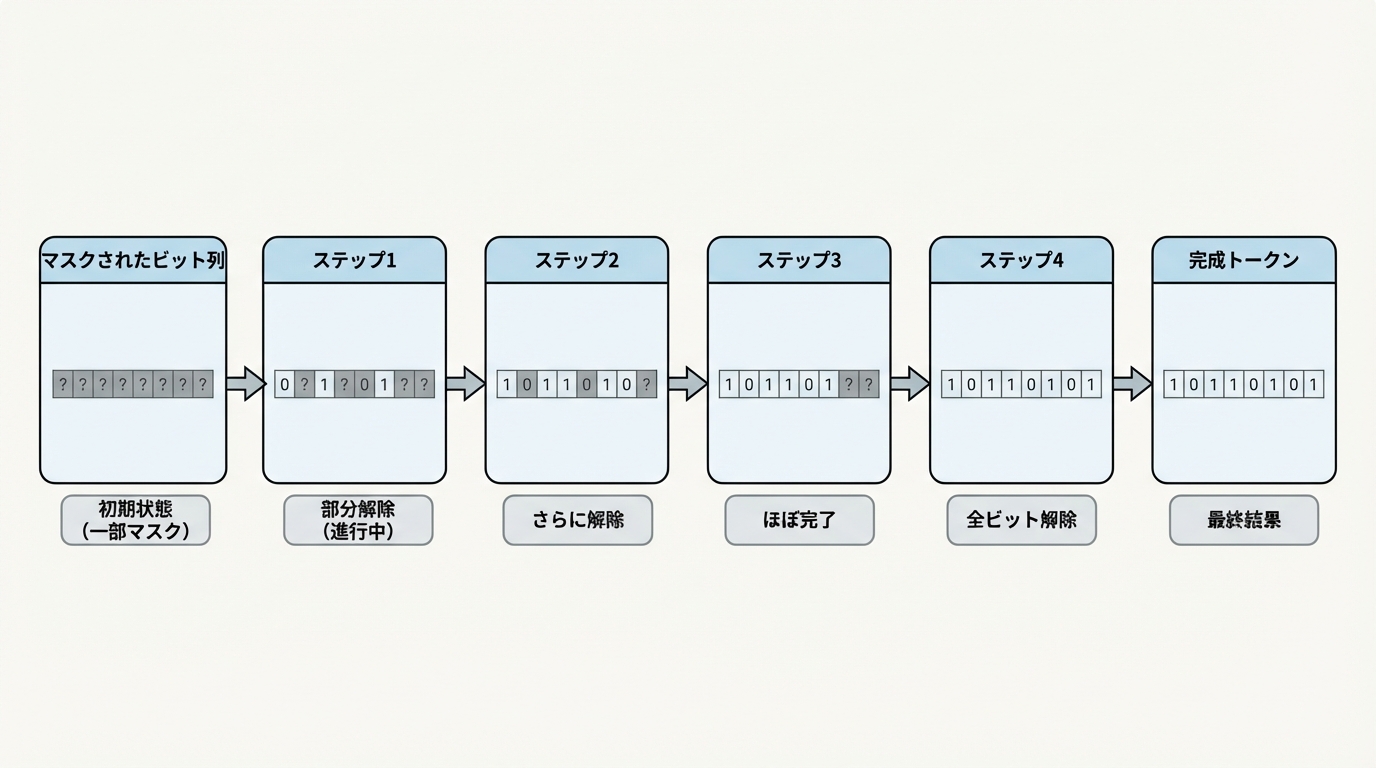

MBMヘッドの革新的なポイントは、コードブックのインデックスを丸ごと予測するのではなく、トークンを構成する「ビット」の単位で段階的に予測する点にあります。学習時には、トークンのビット列の一部をランダムにマスクし、残りのビットからマスクされた部分を復元するよう訓練されます。推論時には数ステップ(通常4回)のアンマスキングを経て、すべてのビットを確定させます。

この設計により、メモリ消費量がO(C)からO(log₂C)へと劇的に削減されます。たとえば従来手法では32ビットのコードブック(約43億語彙)を使おうとするとメモリ不足になりますが、BARでは2の256乗という天文学的なサイズのコードブックすら理論上扱えるようになりました。

トークナイザーにはFSQ(Fixed-Size Quantizer)と呼ばれる学習不要な量子化器を採用し、10ビットから256ビットまでの柔軟な設定が可能です。エンコーダーはSigLIP2モデルから初期化し、CLIP特徴量とのアライメントによって意味的な整合性を確保しています。Transformer本体にはRoPE(回転位置埋め込み)やSwiGLU活性化関数、RMSNormといった最新の技術が取り入れられています。

実験結果

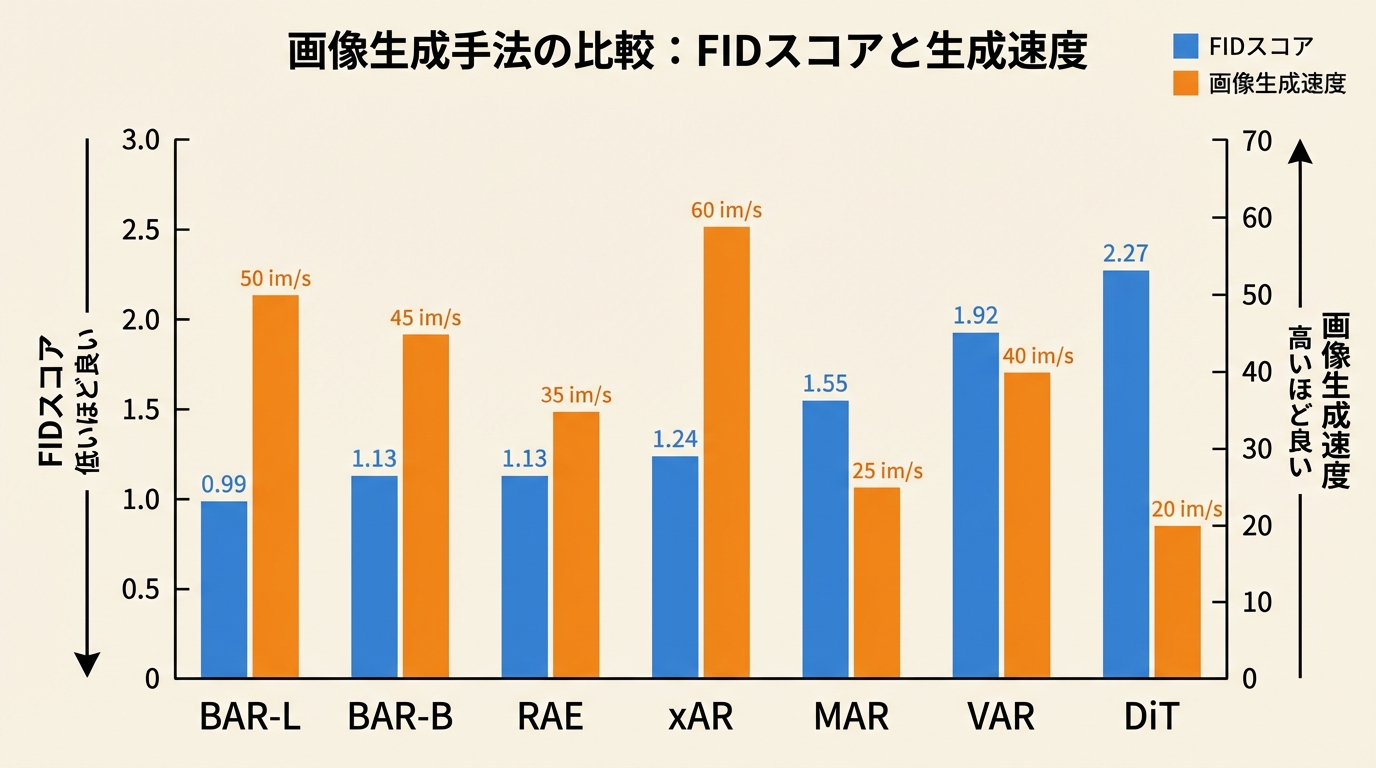

ImageNet-256×256ベンチマークにおいて、BAR-L(11億パラメータ)はClassifier-Free Guidance(CFG)適用時にgFID 0.99を達成しました。これはDiffusionモデルのDiT(FID 2.27)やMasked Autoregressive ModelのMAR(FID 1.55)、さらには従来の離散型最高性能であったRAE(FID 1.13)をも大幅に上回る数値です。

速度面での優位性も顕著でしょう。BAR-B(4.15億パラメータ)はMARと比較して約20倍高速なサンプリングを実現しながら、FIDスコアでもMARを凌駕しています。さらに高速なバリエーションであるBAR-B/4はパッチサイズ4の設定で毎秒445枚という驚異的なスループットを達成し、最近注目を集めるフローベース手法MeanFlowの約3倍の速度で動作します。

予測ヘッドの比較実験では、MBMヘッドの優位性が明確に示されました。16ビットコードブックにおいて、線形ヘッドのFIDが1.63、単純なビット予測が3.83であるのに対し、MBMは1.19を記録しています。32ビットコードブックでは線形ヘッドがメモリ不足で動作不能になる一方、MBMは1.37という良好なスコアを維持しました。

モデル | パラメータ数 | FID(CFGあり) | 生成速度(枚/秒) |

|---|---|---|---|

BAR-L | 11億 | 0.99 | 10.65 |

BAR-B | 4.15億 | 1.13 | 24.33 |

RAE | 8.39億 | 1.13 | 6.62 |

MAR | 9.43億 | 1.55 | 1.19 |

DiT | 6.75億 | 2.27 | — |

離散トークナイザーと連続トークナイザーの公平な比較も興味深い結果を示しています。「ビットバジェット」という統一的な指標で比較すると、十分なビット数を割り当てた離散トークナイザーは連続トークナイザーと同等以上の再構成品質を実現できることが確認されました。64ビットのコードブックではrFID 0.50と、連続手法を上回る再構成精度を達成しています。

まとめと今後の展望

BARは「離散的アプローチは連続値手法に劣る」という通念を覆した画期的な研究といえます。ビット単位の段階的予測というシンプルかつ強力なアイデアにより、コードブックサイズの制約を取り除き、品質と効率の両面で新たな最高水準を打ち立てました。

一方で、いくつかの課題も残されています。各トークンの予測に複数回のフォワードパスが必要な点は、さらなる高速化の余地を示唆しています。また、学習コストは依然として大きく、トークナイザーの品質にも依存するという制約があるでしょう。

それでも本研究の意義は非常に大きいものです。言語モデルと同じ離散的な枠組みで画像を高品質に生成できることは、テキストと画像を統一的に扱うマルチモーダルAIの発展に大きく貢献する可能性を秘めています。今後、動画生成や3D生成など、より高次元のデータへの応用が期待されます。