- Baichuan-Omni-1.5は画像・音声・テキストを統合的に扱うモデル

- モデルはVisual BranchとAudio Branchを活用し、多様なデータ形式を高精度に処理

- 実験結果で従来モデルを上回る性能を多様なベンチマークで示した

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

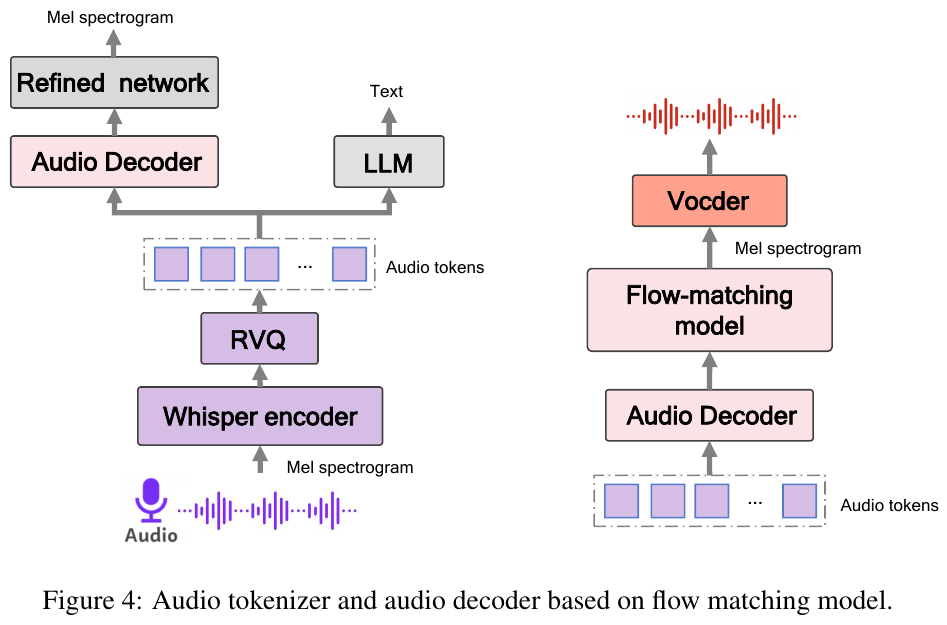

Baichuan-Omni-1.5は、画像と音声、そしてテキストを処理するために統合的なアーキテクチャを用いたモデルとして提案されている。視覚情報を扱うVisual Branchと音声情報を扱うAudio Branch、そしてテキストを処理するLLMを結びつけることで、多様な入力形式から学習しやすくしている。入力データは大規模に収集され、画像・音声・テキストという三つの要素が重なり合う状況でも対応可能なように加工と品質管理が施されている。これらのデータをもとに段階的な事前学習プロセスが組まれており、それぞれのモーダル単独での学習から、最終的に複数モーダルを同時に扱う段階に至るよう設計されている。同モデルは、まず画像と言語の組み合わせを学習し、次のステップで音声を含む複数のモーダルへ拡張し、最終的に三つのモーダルすべてを包含した最適なパラメータを獲得する流れをとっている。

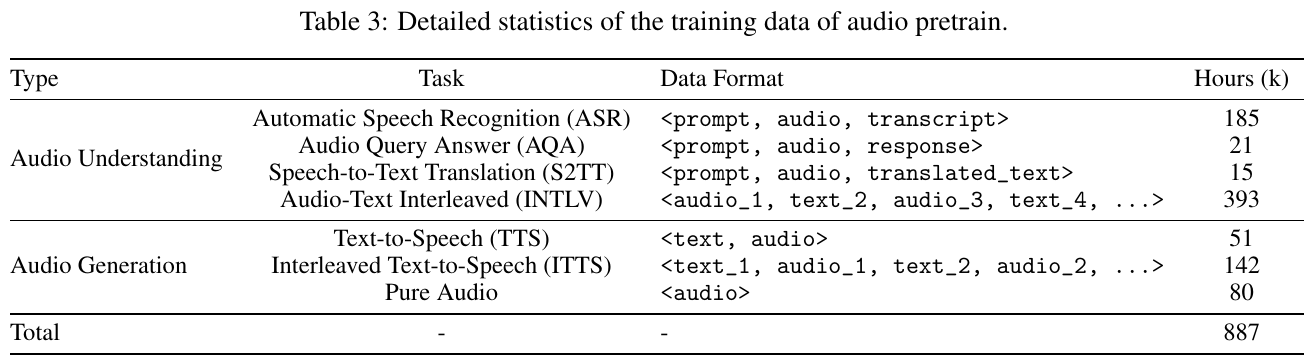

内部構造としては、Visual Branchで入力された画像を処理し、Audio BranchではBaichuan-Audio-Tokenizerという手法を用いて音声特徴をコード化する。そこから得られた情報をLLMへ渡し、総合的な理解や生成を行う仕組みになっている。Audio Branchの学習には音声スペクトルや特徴抽出を組み合わせており、ビジュアル側と同様に段階的な事前学習を通じて性能を高めている。また、LLMで得られた推論結果はテキスト出力として直接得られるだけでなく、画像や音声と再度結合して多様な応用シナリオを想定した試験が可能になっている。学習中にはクロスモーダルの情報伝達や単一モーダルの高精度化などに配慮し、高効率な重み調整を実現している。

実験結果として、複数のベンチマークで他のモデルと比較を行い、総合的なタスクにおいて高いスコアを示している。画像理解のタスクでは画像キャプション生成とVQA(Visual Question Answering)で評価され、オープンソースの従来手法を上回る成績を示した。音声理解ではASRや音声からの情報抽出タスクを対象とし、拡張的な学習により高い認識精度を実現している。さらに、動画の情報を扱うVideo Question Answeringにおいても、画像と音声を組み合わせた総合的な理解を強みに、非常に良好な結果が報告されている。これらの成果から、単一モーダルに特化したモデルを上回るパフォーマンスを示しながら、マルチモーダルな入力に対する汎用的な応用力を確認している。

医療系のタスクでも一定の評価が行われており、医療画像と音声情報、テキスト質問を組み合わせた場面で回答精度を高めている。医用データはプライバシーや専門性の問題から一般的に扱いが難しいが、このモデルでは安全に配慮したデータ拡張や事前学習方針を導入し、実用に近いかたちでの応答能力を示している。加えて、増分的な学習過程で画像や音声のエンコード部を段階的に高度化させている点が大きく寄与していると述べられている。総合的に見ると、Baichuan-Omni-1.5は画像・音声・テキストを単一のフレームワーク上で扱い、雑多な入力を結合して高精度の応答や推論を可能にする仕組みを提示しており、実験段階でも多様なタスクに対して優れた性能を示したと報告されている。

図表の解説

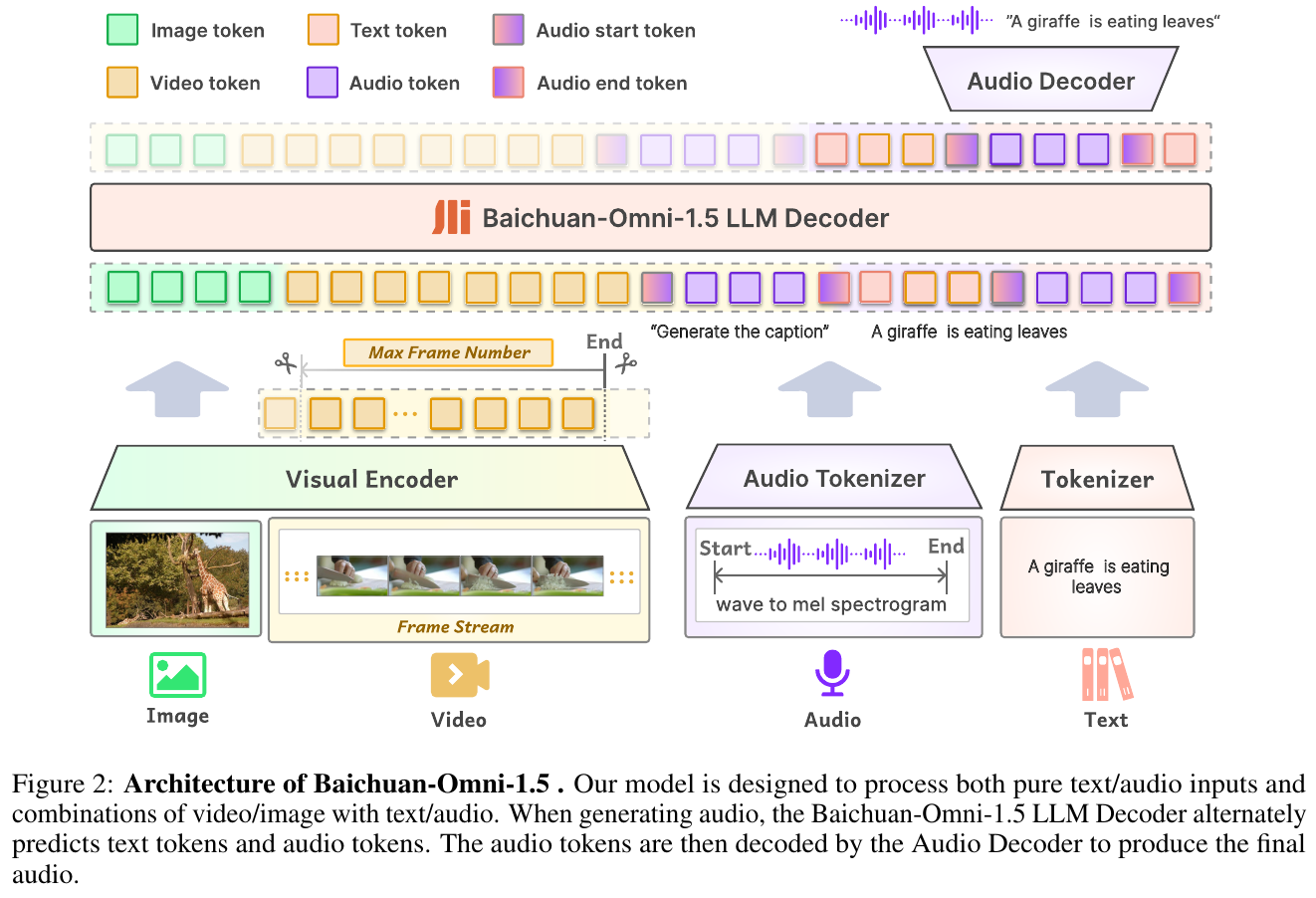

図ではBaichuan-Omni-1.5が、画像や動画を取り込むVisual Encoderと、音声をトークン化するAudio Tokenizer、そしてそれらを統合して推論するLLM Decoderを備えている様子が示されている。画像や動画はフレーム単位で符号化され、LLM Decoderに送られた後、テキストトークンと組み合わされて意味を理解する仕組みだ。音声はAudio Tokenizerによって変換され、LLM Decoder内でテキストと交互に予測される。最終的に生成された音声トークンはAudio Decoderで再度音声化され、テキストと音声の両方を出力できるようになっている。

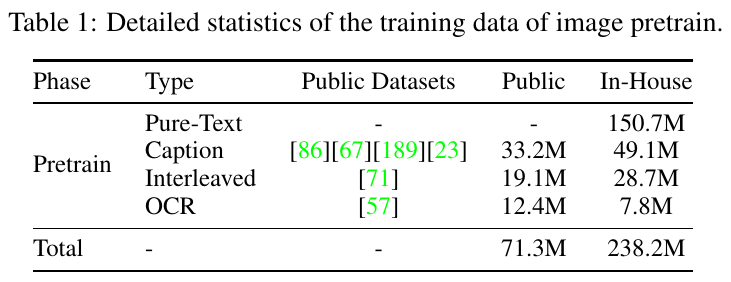

この表は、Baichuan-Omni-1.5の画像事前学習で使われたデータの内訳と規模を示している。表の列「Public」には公開リソースから得られたデータ数が、「In-House」には独自で収集あるいは生成したデータ数が示されている。たとえばPure-Textはすべて独自データから成り、CaptionやInterleaved、OCRといった複数の種類がそれぞれ公開データと独自データを組み合わせて利用されている。最終行の合計欄から、画像まわりの大規模データが幅広い手法で集約されていることがわかる。

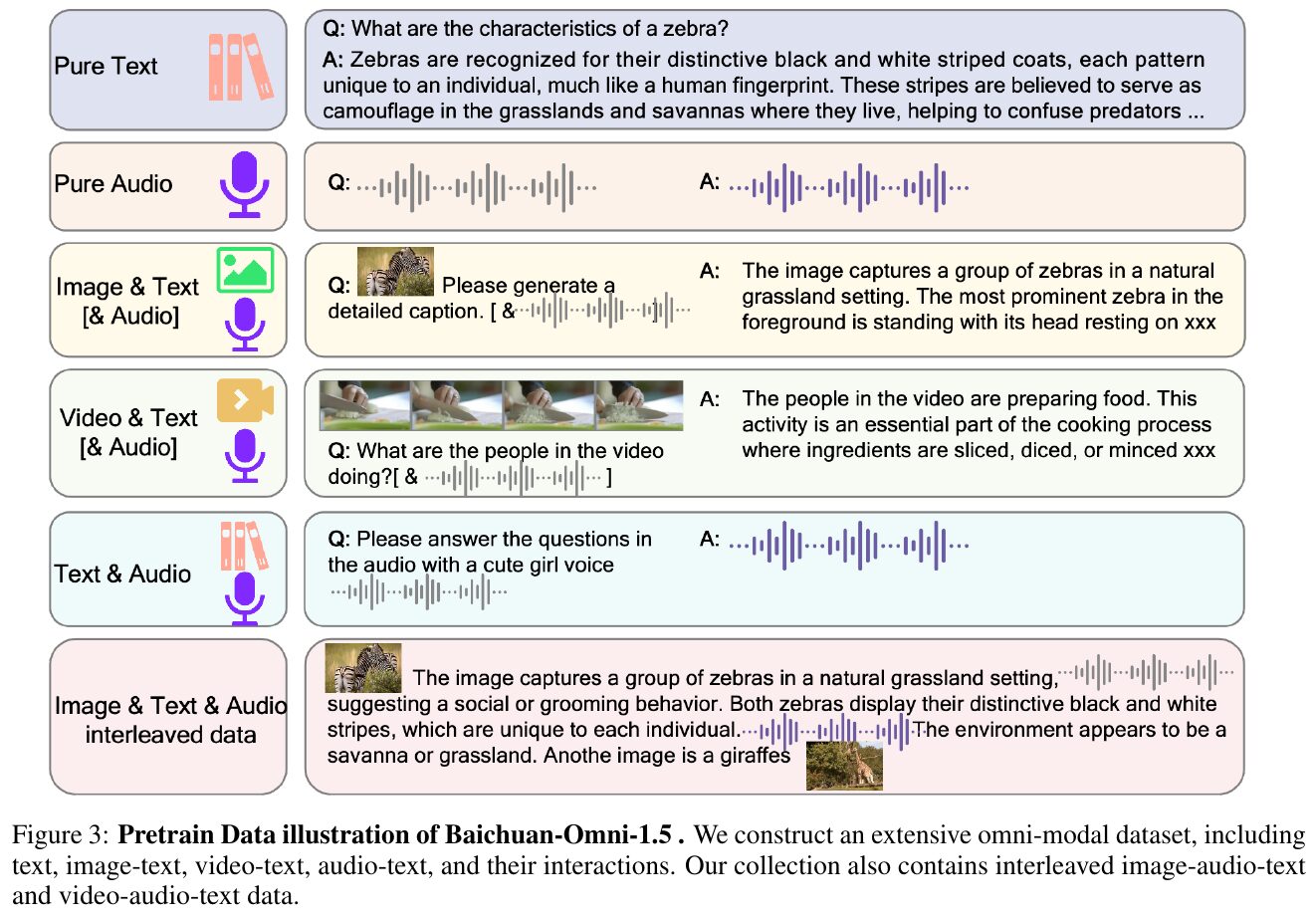

図中では、Baichuan-Omni-1.5の事前学習で使用される多彩なデータ形式を例示しています。純粋なテキストや音声だけでなく、画像・テキストの組み合わせ、さらに動画・テキストや音声・テキストなどが示され、実際の学習ではこれらが相互に組み合わされています。それぞれの吹き出しでは「画像とそれに対応する質問」「音声の問いかけと応答」「動画の内容理解」などが対話形式で表現され、モデルが幅広いモードのデータを統合的に処理できることを強調しているのです。これにより、テキストだけでなく多様なメディア情報を取り込んだ総合的な理解や生成が可能になることを示しています。

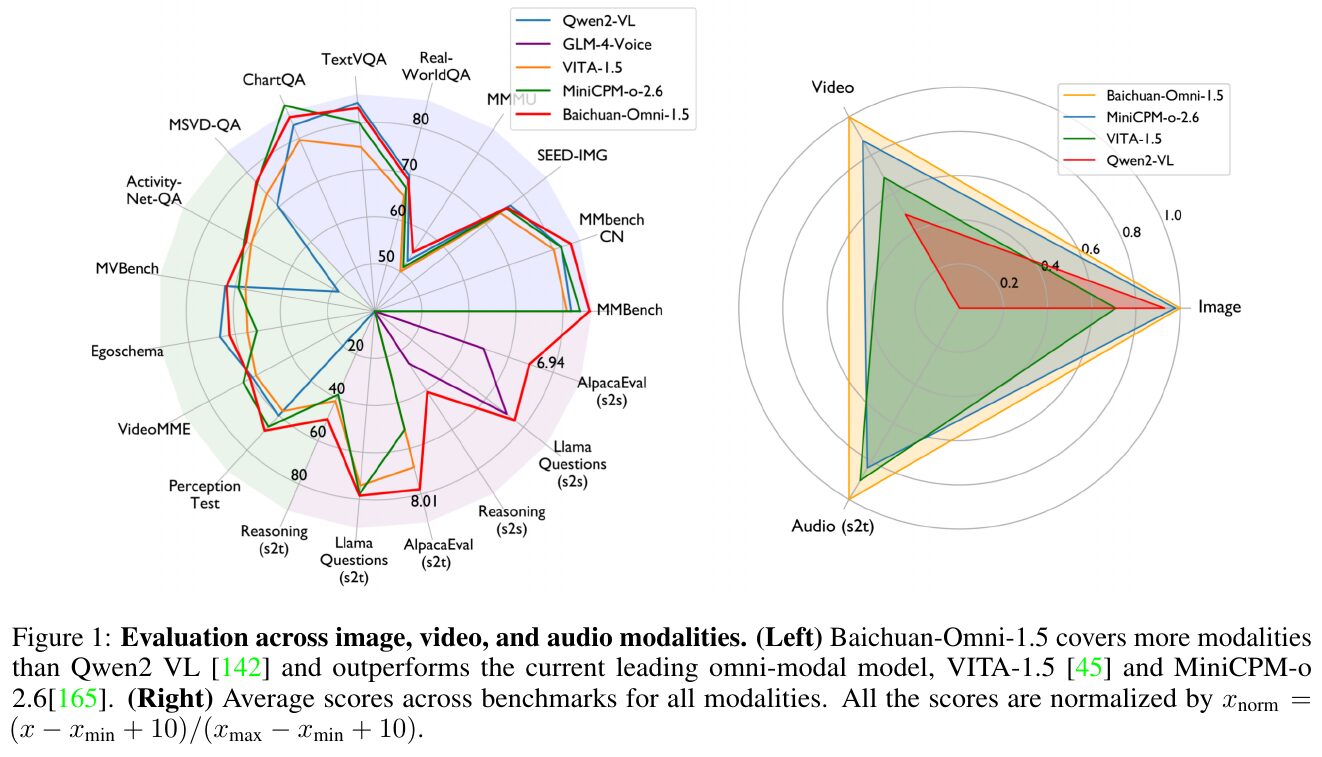

左のレーダーチャートは、各モデルが画像や動画、音声などの多様なベンチマークでどれだけ高い性能を示すかを一目で比較している。たとえばTextVQAやActivity-Net-QAなど、視覚と言語や聴覚情報の統合能力が問われるタスクが含まれる。Baichuan-Omni-1.5は他のモデルより扱えるモダリティが幅広く、スコアも高水準に達している。右の三角形グラフは画像、動画、音声タスクの平均的な評価を示し、それぞれのモデルが総合的にどの程度バランスよく優れているかを可視化している。

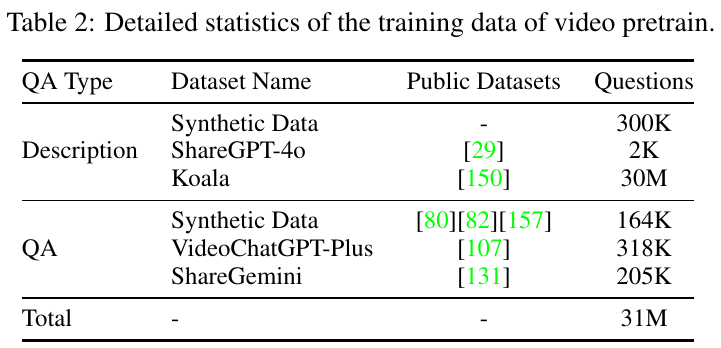

この表はBaichuan-Omni-1.5の動画事前学習で使われたデータ統計をまとめている。Descriptionの欄には動画内容の説明に用いるデータセットが並び、Synthetic DataやShareGPT-4oなどから約30Mもの質問が含まれている。QAの欄は動画上での質問応答を扱い、VideoChatGPT-PlusやShareGeminiなどを合わせて最終的に31M規模のデータがそろう点が特徴である。こうした幅広い動画キャプションとQAデータを組み合わせることで、多様な動画理解能力を強化する土台となっている。

本論文では音声に関する学習データを大きく「音声理解」と「音声生成」に分けて用いている。表では各作業が示す内容やデータ形式、そして総学習時間が示されている。たとえば音声認識(ASR)や音声質問応答(AQA)などは、音声とテキストの対を使って言語理解を高める目的で実施され、翻訳や発話内容の書き起こし、音声とテキストの交互提示など多彩な形式が含まれる。また音声生成は音声合成(TTS)やテキストと音声が交互に続く形式、純粋な音声のみで構成されるデータなども取り入れている。こうして合計約887時間分の音声関連データを使い、モデルが幅広い音声処理能力を獲得できるように設計されている。

図中では、まずマイクからの音声がメルスペクトログラムに変換され、Whisperベースのエンコーダで特徴を抽出し、RVQ(Residual Vector Quantization)によって離散的なオーディオトークンが生成される。これらのトークンは言語モデル(LLM)にも入力され、テキストとの対応づけを学習する。一方、そのオーディオトークンをもとにメルスペクトログラムを再構成するため、対称構造のオーディオデコーダが用いられる。さらに、フローマッチング方式のデコーダを追加で用いることで音質を高め、最終的にHiFi-GANボコーダにより波形を生成し、自然な音声再生を実現している点が示されている。

この図はBaichuan-Omni-1.5が多段階で学習される過程を表しています。まず画像と言語の対応づけから始めることで視覚情報を理解する基盤を作り、次に音声情報を組み込んでテキストと音声の相互学習を行います。さらに画像・音声・テキストを組み合わせた大規模なデータで事前学習を進めることで、長い音声や動画の処理にも対応できるようになります。最後に指示への応答精度や音声生成力を高めるための教師あり微調整を行い、多様な場面での高度なマルチモーダル理解と音声応答を実現しています。