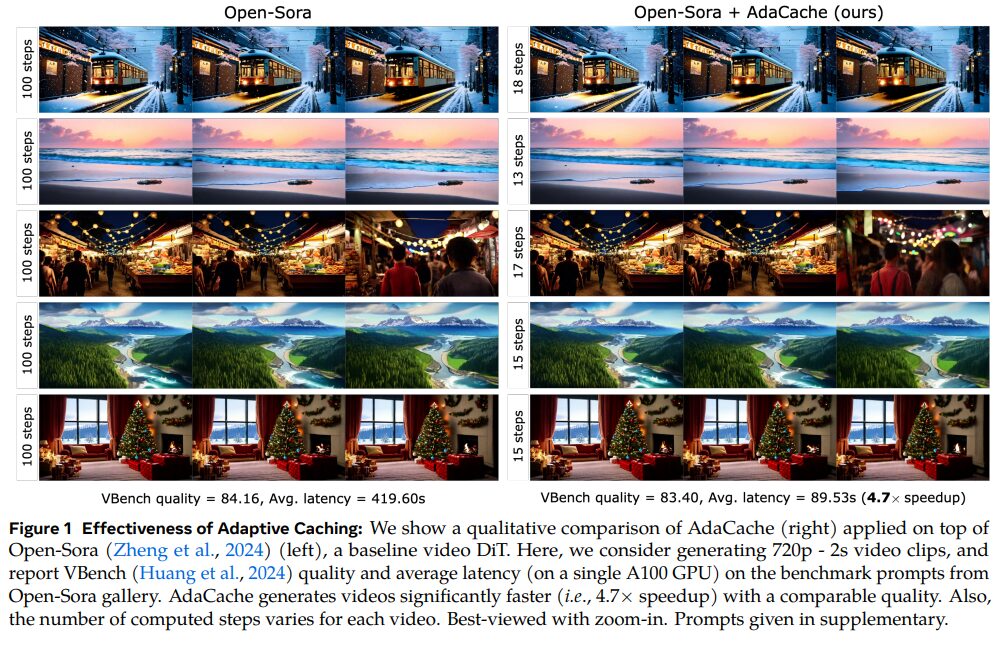

Metaが、動画生成AIの処理速度を向上させる新手法「AdaCache」を提案しています。動画の内容に応じて必要な計算量を動的に調整し、キャッシュを活用することで、画質を維持したまま最大4.7倍の高速化を実現しました。

論文:Adaptive Caching for Faster Video Generation with Diffusion Transformers

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

この研究のポイントは?

本論文は、動画生成AIの処理速度を改善する「AdaCache」という新手法を提案しています。

背景

近年、動画生成AIの性能は飛躍的に向上していますが、高品質な動画を生成するためには膨大な計算コストと時間がかかるという課題があります。特に、最新のDiffusion Transformerと呼ばれるモデルは、高品質な動画生成を実現する一方で、大規模なモデルと複雑な注意機構を使用するため、処理速度が遅いという問題を抱えています。

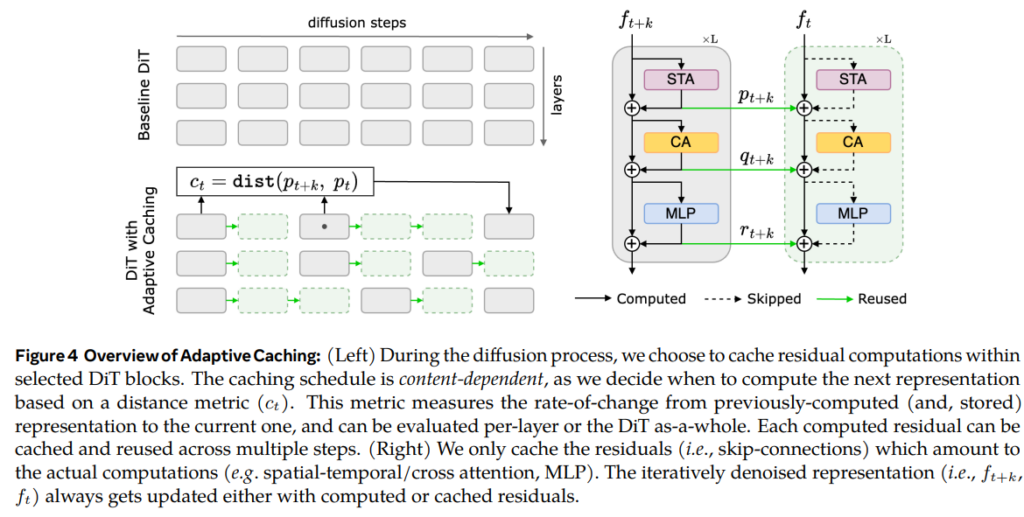

この研究では、「全ての動画が同じではない」という洞察に基づいて、動画の内容に応じて必要な計算量を動的に調整する「AdaCache」という手法を提案しています。具体的には、動画内の動きの量や複雑さに基づいて、計算結果の再利用(キャッシュ)範囲を自動的に決定します。

また、動画の動きの度合いに基づいて計算リソースを配分する「Motion Regularization」という仕組みも導入しています。動きの少ない部分では計算を効率化し、動きの多い部分では精密な計算を行うことで、動画の品質と生成速度の最適なバランスを実現しています。この手法により、既存の動画生成モデルに対して追加の学習なしで適用でき、画質を維持したまま最大4.7倍の高速化を達成しました。

提案手法

本研究では、動画生成AIの高速化を実現する「AdaCache」という新しい手法を提案しています。この手法の核となるのは、「全ての動画が同じではない」という考え方です。

動画の内容に応じて必要な計算量が異なるため、各動画の特性に合わせて計算リソースを最適に配分する仕組みを導入しました。具体的には、2つの重要な技術を組み合わせています。

1つ目は「適応的キャッシング」で、動画生成の過程で計算された中間結果を保存し再利用する際、その再利用範囲を動画の複雑さに応じて動的に調整します。

2つ目は「動き正則化」で、動画内の動きの量を検出し、動きの多い部分には より多くの計算リソースを割り当てる仕組みです。また、この手法は既存の動画生成モデルに追加の学習なしで適用できる点が特徴的です。

実験

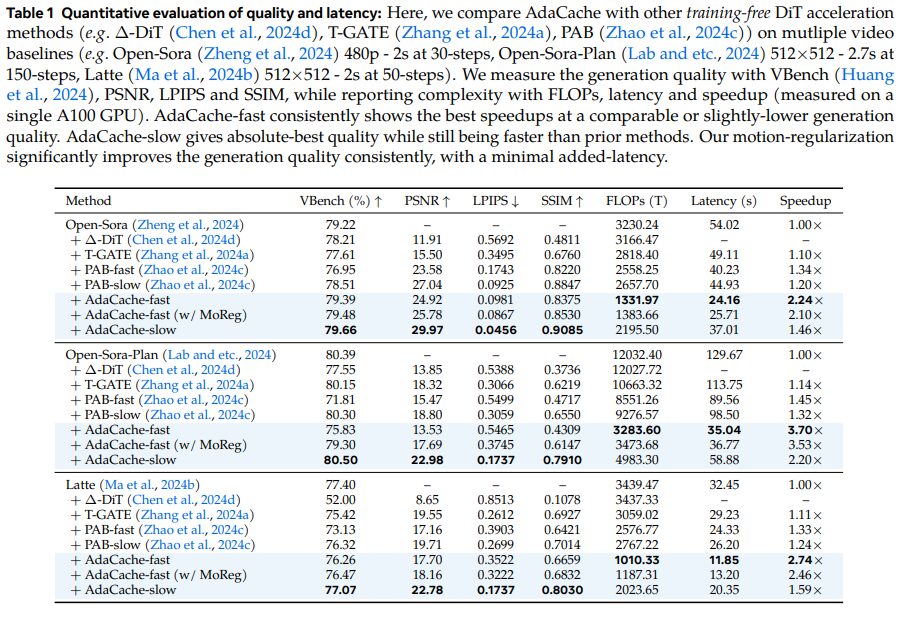

本研究では、提案手法「AdaCache」の有効性を複数の実験で検証しています。主な実験として、Open-Sora、Open-Sora-Plan、Latteという3つの代表的な動画生成AIモデルを用いて評価を行いました。

900以上の動画を生成し、品質指標としてVBench、PSNR、SSIM、LPIPSを、計算コスト指標としてFLOPs、処理時間、高速化率を測定しました。

実験結果では、AdaCacheの2つのバリエーション(高速版と低速版)を既存の高速化手法と比較しています。高速版は最大4.7倍の処理速度向上を達成し、低速版は品質を重視しながらも1.46倍の高速化を実現しました。さらに、動画の動きに基づいて計算リソースを調整する「動き正則化」を導入した実験も実施しました。

この機能により、わずかな処理時間の増加で生成品質が大幅に向上することが示されました。また、異なるフレームレートや解像度での実験も行い、提案手法が様々な設定で効果的に機能することを確認しています。特に720p・2秒の高解像度動画生成でも安定した性能を発揮し、実用性の高さを実証しました。

結論

本研究では、動画生成AIの処理速度を大幅に向上させる「AdaCache」という新手法を提案し、その有効性を実証しました。従来の動画生成AIは高品質な動画を生成できるものの、計算コストが高く処理速度が遅いという課題がありました。AdaCacheは、動画の内容に応じて必要な計算量を動的に調整し、計算結果を効率的に再利用することで、この課題を解決しています。

本研究の成果は、高品質な動画生成AIの実用化に向けた重要な一歩となり、今後の動画生成技術の発展に大きく貢献することが期待されます。