- YouTubeの教育動画から9つの学問分野をカバーするマルチモーダルデータセットを構築

- 動画のクリップから音声認識や字幕同期などを経て説明文を生成するパイプラインを開発

- 提案したデータセットにより視覚質問応答タスクでの性能向上を達成

論文:2.5 Years in Class: A Multimodal Textbook for Vision-Language Pretraining

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

本論文の概要

この研究では、視覚と言語の統合された事前学習を可能にする「Multimodal-Textboo」と呼ばれる新しいデータセットの構築とそれを用いた手法を提案しています。この教科書型データセットは、YouTubeの教育的な動画を元に構成されており、数学、物理、化学、生物学、地理学など、9つの学問分野を取り扱っています。動画から抽出した主要映像フレームに関連する字幕や音声情報を結びつけることで、画像と言語の高度な関係を捉える学習が可能になります。

研究チームは「Video-to-Textbook Pipeline」というデータ生成手法を開発しました。このパイプラインは、音声認識、キーフレーム抽出、字幕と映像の同期付け、各フレームの説明の生成など、多段階の処理を含みます。動画を短いクリップに分割することで、効率的に情報を整理。さらにGPT-4を活用して説明文を作成し、包括的な知識表現を実現しています。

評価実験では、既存の大規模データセット(例えばMMICやOBELICS)より高い一貫性と説明能力を示しました。例えば、MLLM(多モーダル言語モデル)の事前学習において、提案した教科書データセットを用いることで、視覚質問応答(VQA)や画像テキスト一致タスクでの性能が向上しました。また、キーフレーム間の類似性を最適化した新しい指標(InSIT-SIM)を提案し、より高精度なデータ選択も可能にしました。

この研究は、視覚と言語の密接な関連を捉えることが難しかった従来の手法の課題を克服し、教育の現場での応用だけでなく、将来的にはAIによる知識学習の進化にも寄与する可能性を持っています。

図表の解説

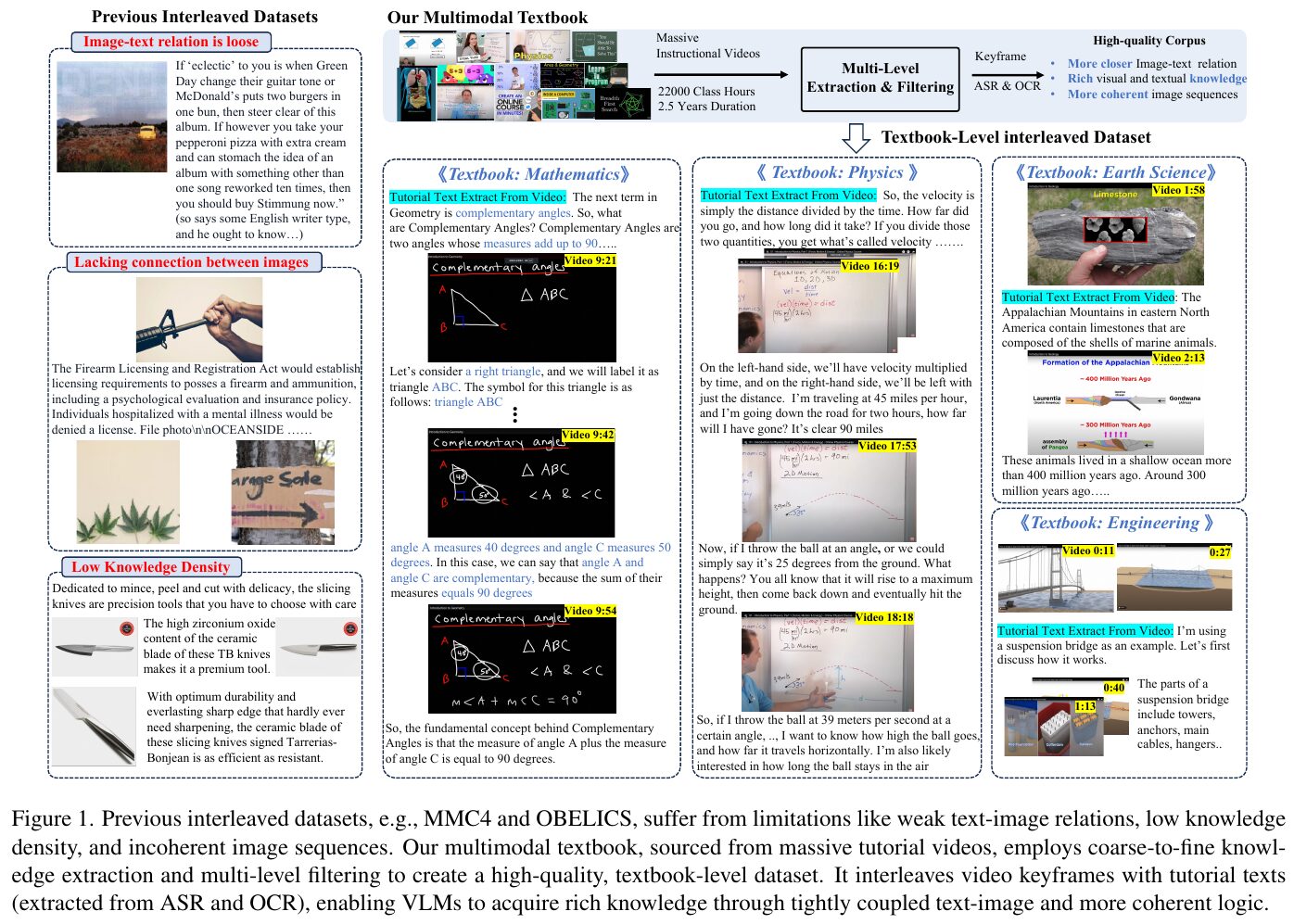

この図は、以前のデータセットの限界と新しいマルチモーダル教科書の利点を比較しています。従来のデータセットは画像とテキストの関連性が弱く、知識密度が低く、画像の順序が無秩序です。新しいデータセットは、ビデオからのフレームとテキストを組み合わせて、学問的な知識を論理的に整理しています。これにより、視覚と言語のモデルが、より自然で豊かな知識を獲得できるようになります。

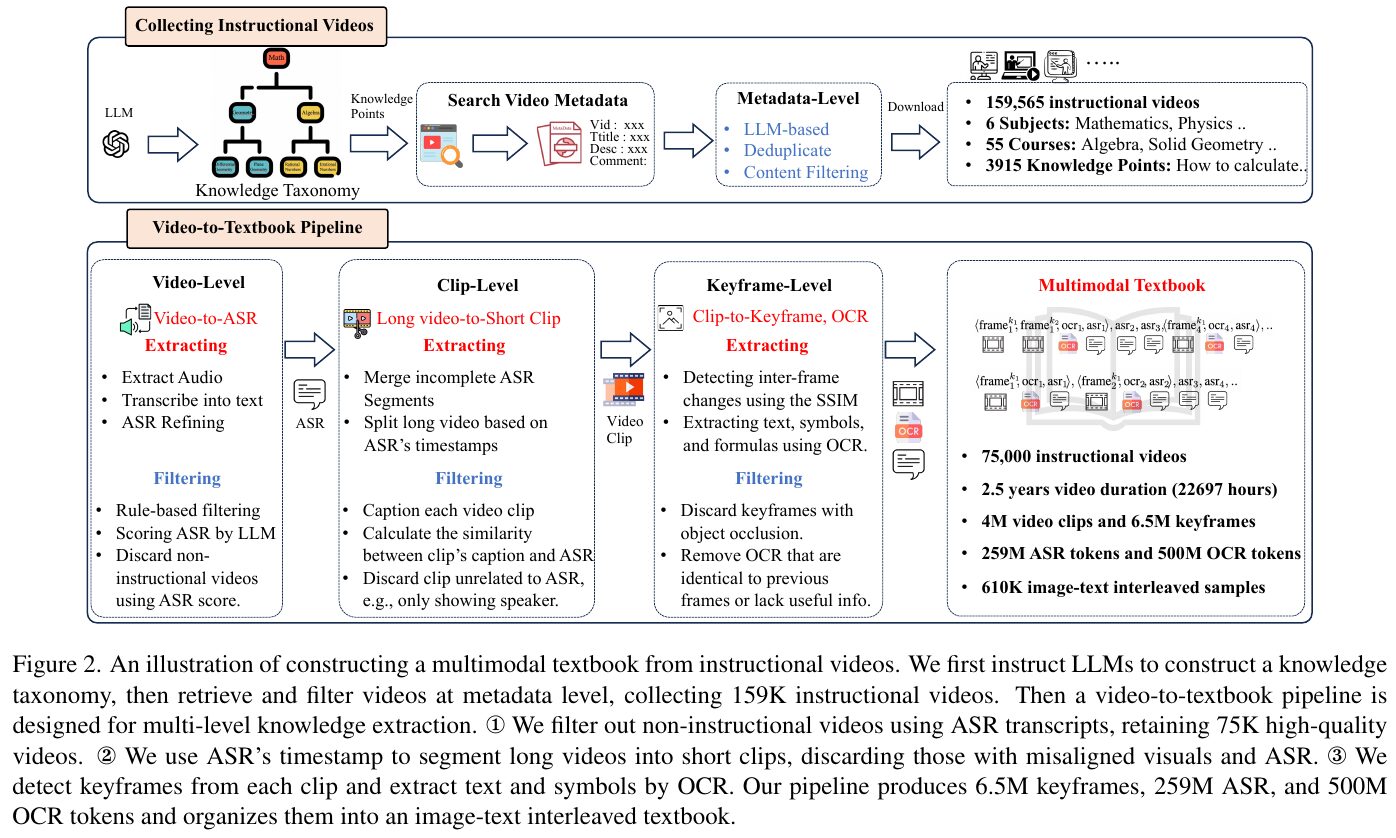

この図は、ビジョンと言語を統合するためのマルチモーダル教科書を構築する過程を示しています。まず、LLMが知識分類を作成し、関連する教育用動画を収集します。動画内の音声をテキストに変換し、重要なシーンを切り出して、さらにテキストと画像の情報を抽出・整理します。この結果、視覚とテキストが連携した教科書を作成し、多くの高品質な学習データを提供します。

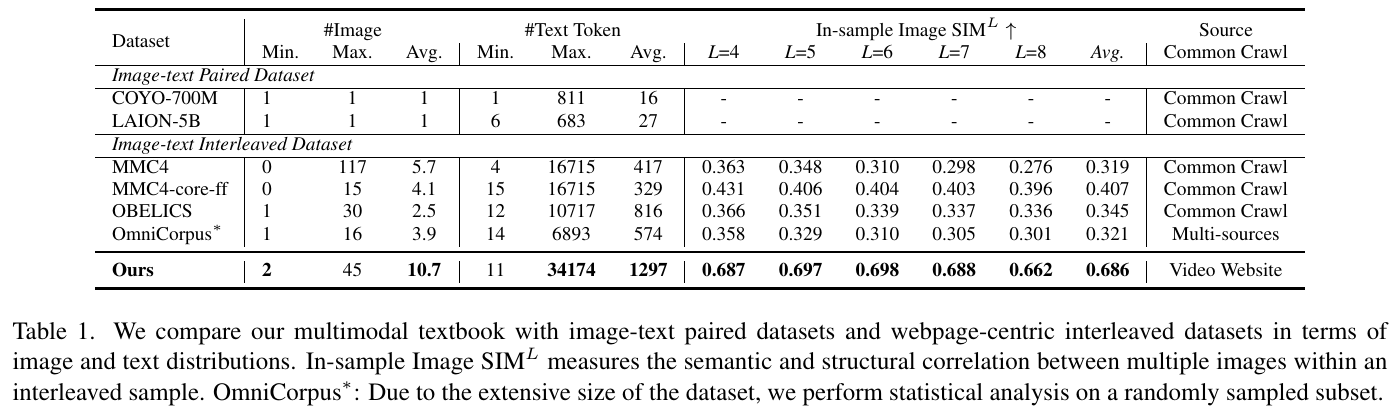

この表は、画像とテキストがどのように分布しているかを示し、複数のデータセットとの比較をしています。対象のデータセット「Ours」は、教育用動画から得られたもので、他のデータセットよりも平均画像数やテキストトークン数が多くなっています。「In-sample Image SIM」列は、サンプル内の画像間の意味的および構造的な類似性を計測しています。特に、「Ours」は他のデータセットに比べて画像間の関連性が高いことを示しています。

図は地下水の貯蔵場所である帯水層を示しています。帯水層には地表から水が自由に出入りできる「被圧帯水層」と、その動きが不透水層によって制約される「不動帯水層」があります。この違いは、地下の水の貯蔵と利用法を理解する上で重要な要素です。この図解は、地球科学における水循環の一部として紹介されています。

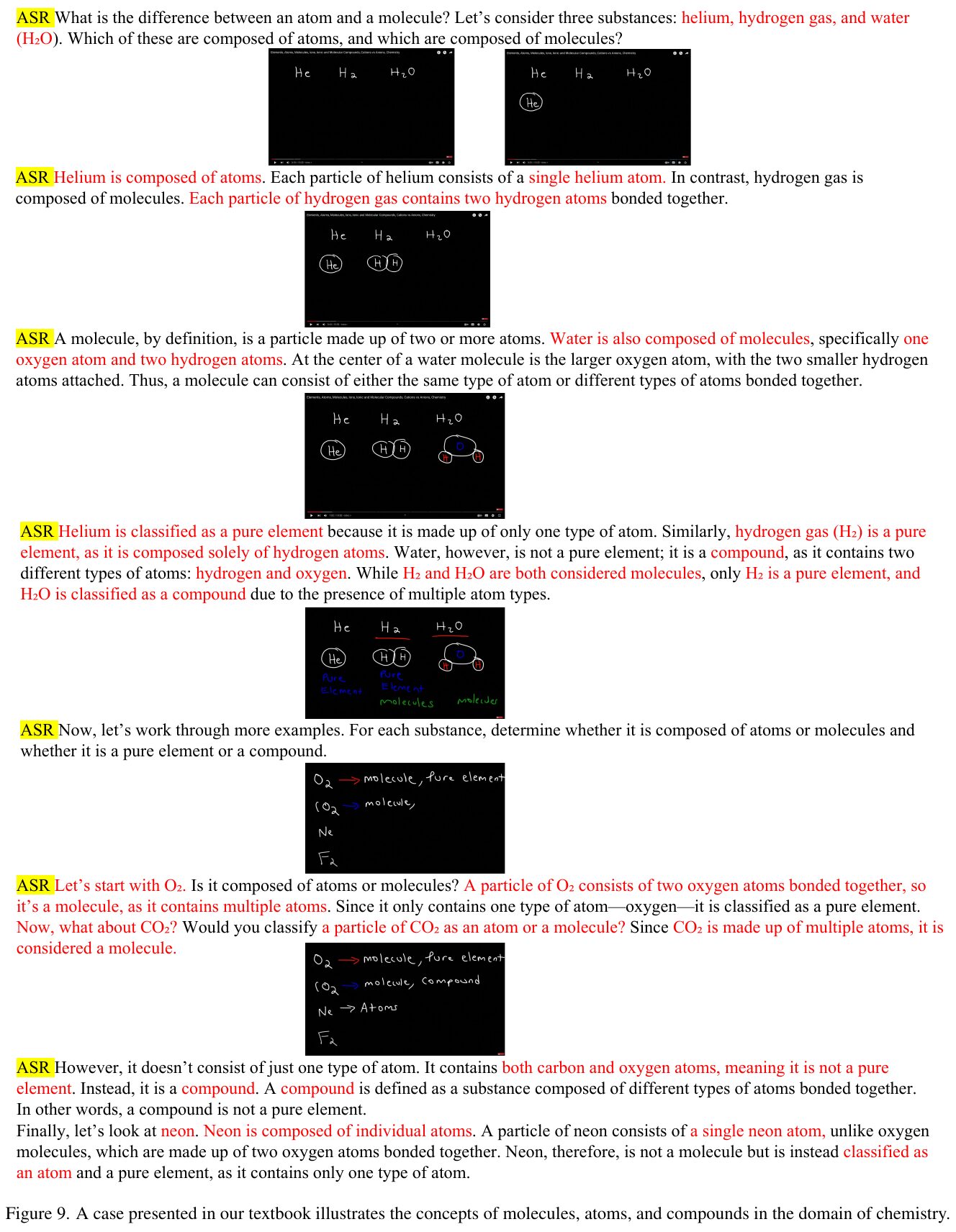

この画像は、基本的な化学の概念である「原子」と「分子」の違いを説明しています。ヘリウムは単一の原子で構成されており、純粋な元素です。一方、水素ガスと水は分子で、それぞれ2つまたは3つの原子からなります。水素ガスは純粋な元素ですが、水は異なる原子から構成されるため、化合物とされます。これにより、物質の分類法が示されています。

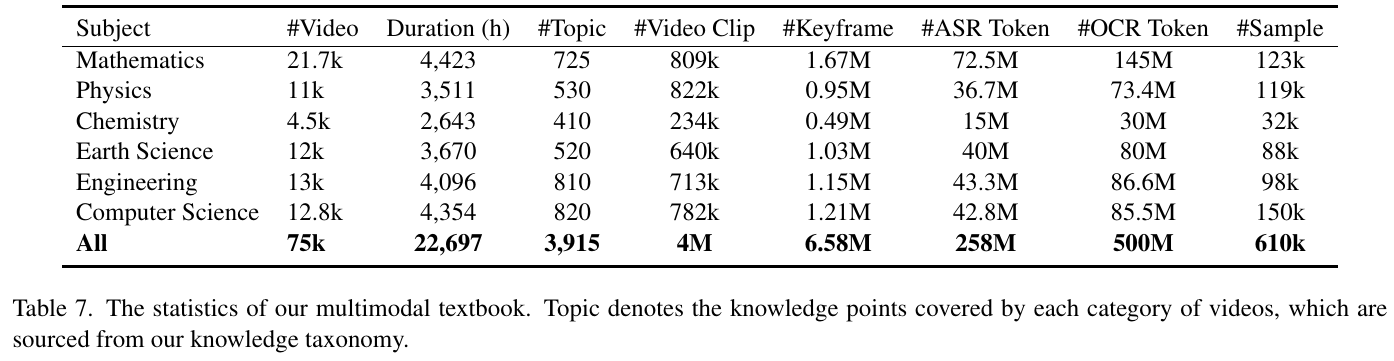

この表は、マルチモーダル教科書のデータ統計を示しています。教科ごとのビデオ本数や総時間、トピック数、ビデオクリップ数、キーフレーム数、音声認識および光学文字認識トークン数、サンプル数が記されています。たとえば、数学では約21,700本のビデオが4,423時間にわたって収録され、725のトピックが含まれています。全体として、75,000本のビデオが22,697時間に及び、約4百万のビデオクリップと6.58百万のキーフレームが含まれています。このデータは、ビジョンと言語の事前学習に活用されており、教材の構築に用いられる豊富な情報を提供しています。

図3では、データセットからランダムに20%、50%、100%のサンプルを選んでシャッフルした際の画像順序の影響を測定しています。これらのシャッフルされたデータセットを使用して事前トレーニングを実施しました。赤、青、黒の線はそれぞれ異なるデータセット(Textbook-6.5M、MMC4-Core-ff、OBELICS)での0ショットおよび2ショットの精度を示し、シャッフル率の増加に伴う精度の変化を表しています。結果から、画像の並びの一貫性が重要であることが示唆されています。

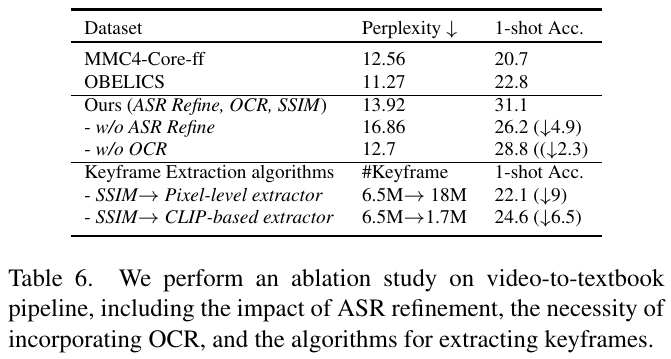

この図は、ビデオからテキストブックへのデータ変換プロセスの評価結果を示しています。テーブル6では、異なる手法やアルゴリズムが、モデルの複雑さ(Perplexity)や精度(一致率)に与える影響を調査しています。 まず、「ASR Refine(自動音声認識の改善)」なしでは、精度が低下し、Perplexityが増加していることから、ASRのテキスト改善がモデルの理解を向上させることが分かります。また、OCR(光学文字認識)なしの結果でも精度が下がっており、ビデオの映像から取得されるテキストも有用であることが示唆されています。 さらに、キー・フレーム抽出アルゴリズムの効果も検討されています。SSIMに基づくピクセルレベルとCLIPベースの抽出器が比較され、CLIPベースでは抽出するキー・フレームの数が減る一方で、精度が若干改善されていることが見て取れます。これは、より意味に基づいたフレーム抽出が、より一定した結果をもたらす可能性があることを示しています。 この研究は、異なる技術要素がどのようにビジョン・ランゲージ・モデルの生成に貢献するかを示し、改良の余地がある領域を明らかにしています。