- 解説付きのビジョンタスクデータセットを生成する手法を提案

- モデルのゼロショット一般化性能を向上させるため、複数の視覚タスクを統一したフレームワークを活用

- 統一されたタスク理解と性能向上が達成でき、複雑な視覚タスクの汎化能力が強化

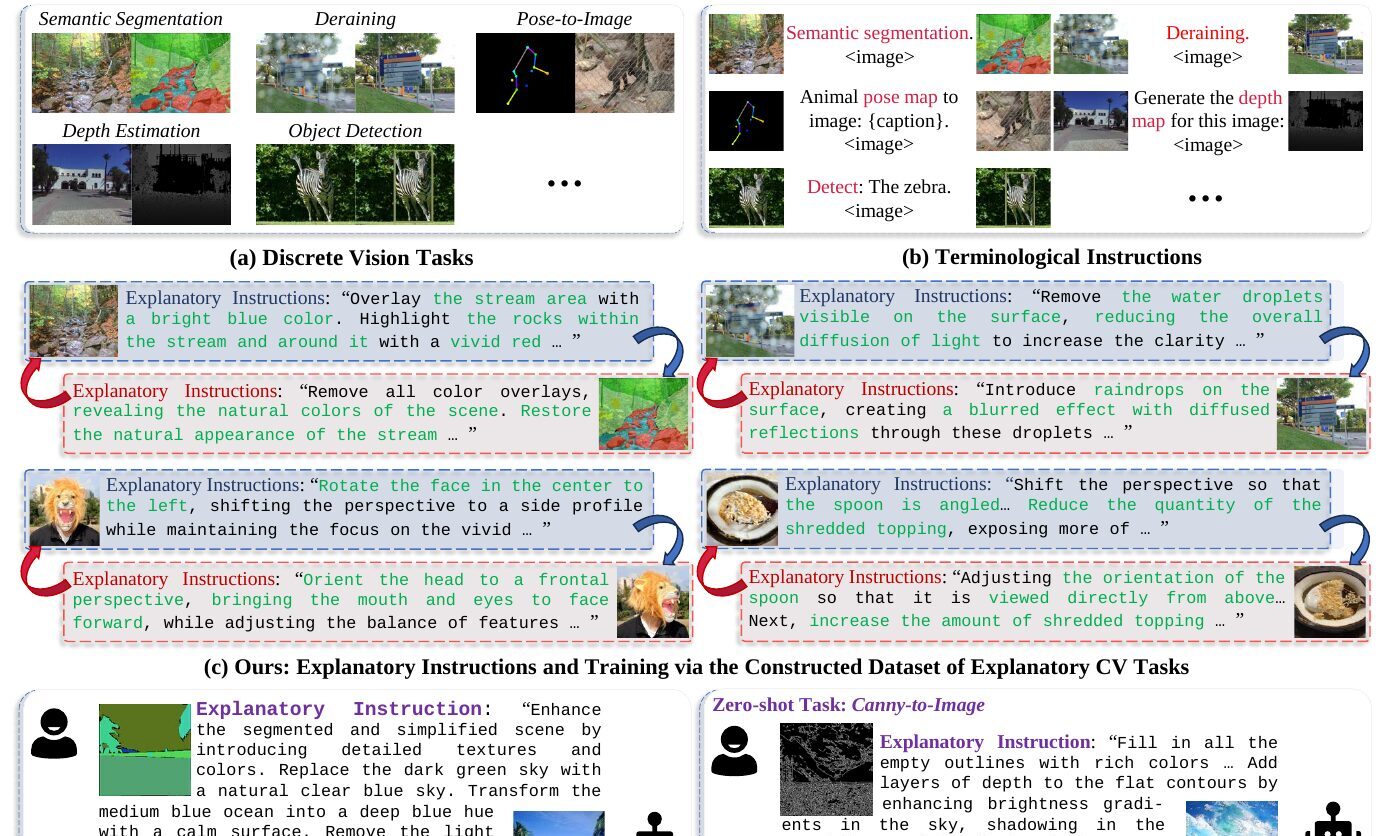

論文:Explanatory Instructions: Towards Unified Vision Tasks Understanding and Zero-shot Generalization

本記事で使用している画像は論文中の図表、またはそれを参考に作成した画像を使用しております。

概要

この論文は、視覚タスクの理解とゼロショット一般化を目指した「Explanatory Instructions」というアプローチを紹介しています。これにより、コンピュータビジョン(CV)においても、言語モデル同様にモデルがゼロショット能力を発揮できるようになることを目指しています。

まず、視覚データセットに説明的指示(Explanatory Instructions)を付加し、モデルにタスクの目的を明示的に説明します。これにより、モデルは視覚タスクを一般化しやすくなります。具体的には、既存の視覚データセットを用い、そのマージンを強調するためにデータサンプルを生成する方法を採用しています。例えば、画像境界検出やテキストと画像のペアを生成することで、より精緻なタスク理解を促進します。

実験では、既存のLLMと新たに開発したモデルを比較し、提案手法の有効性を確認しました。結果として、このアプローチが特定のタスクにおいて、ゼロショットでの一般化能力を持つことが示されています。しかし、リソースの制約から、提案手法の全範囲をカバーするには至らず、さらなる研究が必要であるとしています。

研究背景

この論文では、視覚タスクの統一理解とゼロショット一般化を目指し、””Explanatory Instructions””(説明指示)の効果を探求しています。まず、異なる視覚タスクに適用するために、明確な指示を与えることでモデルの汎用性を高める手法を開発しました。これにより、新しいタスクでも適切に動作するモデルの構築を目指しています。

論文で取り上げられている具体的な手法は、様々な視覚的データやタスクに関して説明可能な指示を生成し、それをモデルが学ぶことで、より一般化された知識を獲得するというものです。この方法は、あらかじめ多くのタスクをこなすことなく、モデルが新しい条件下でも適応できる可能性を示しています。

特に注目されるのは、異なるタスクに対しても柔軟に対応できる能力を持つモデルを作ることにより、少ないデータでのトレーニングでも多様なタスクに強くなる点です。このアプローチは、LLMのような大規模モデルが持つ可能性をさらに引き出し、多様な視覚タスクでの応用を広げることを目指しています。

提案手法

この論文では、視覚タスク全般にわたるゼロショット能力を増強するための「説明付き命令」というアプローチを提案しています。これにより、モデルが視覚情報を直接的に操作・利用する能力を高め、多様な視覚タスクを高精度で処理できるようにします。

具体的には、視覚タスクにおけるモデルの能力を拡張するために、視覚タスクの命令に補足説明を加えています。この説明は、タスクの目的や期待される出力についての詳細な指示を提供し、モデルがより正確に指示に従えるようにします。これにより、特定のデータセットに依存することなく、モデルがさまざまなタスクに対して汎用的に優れたパフォーマンスを発揮することを目指しています。

さらに、この手法はシンプルな実装でありつつ、既存の大規模視覚言語モデル(VLM)の能力を広げることを確認しています。これにより、追加の学習データを必要とせず、高度な視覚タスクでのゼロショット学習を後押しします。この手法の成功は、モデルの多様なタスクに対する適応能力を強化する可能性を示しています。

全体として、この研究は視覚タスクにおける命令指示を詳細化することで、より精緻なモデルのパフォーマンスを引き出す手法を提案しており、特に時間がない中で多くのタスクを効率的に処理したい研究者に役立つと考えられます。

実験

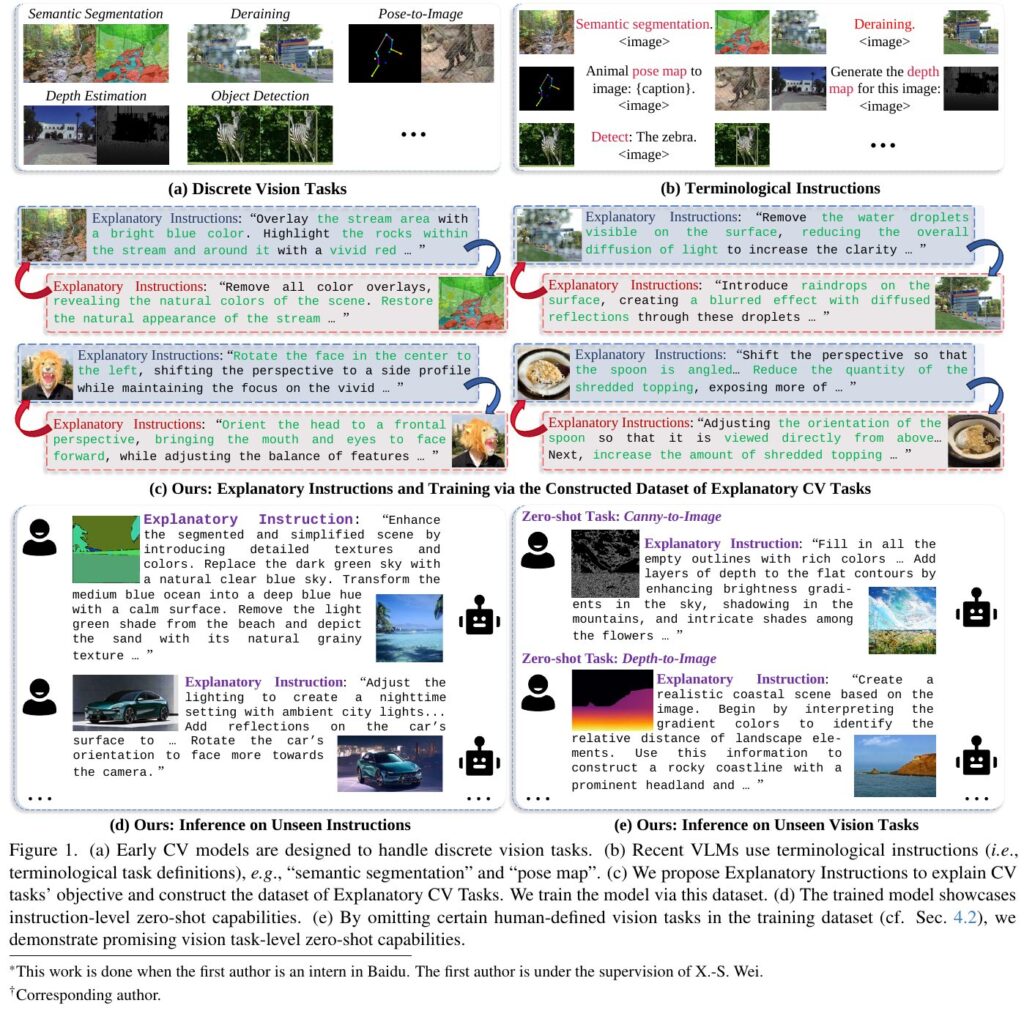

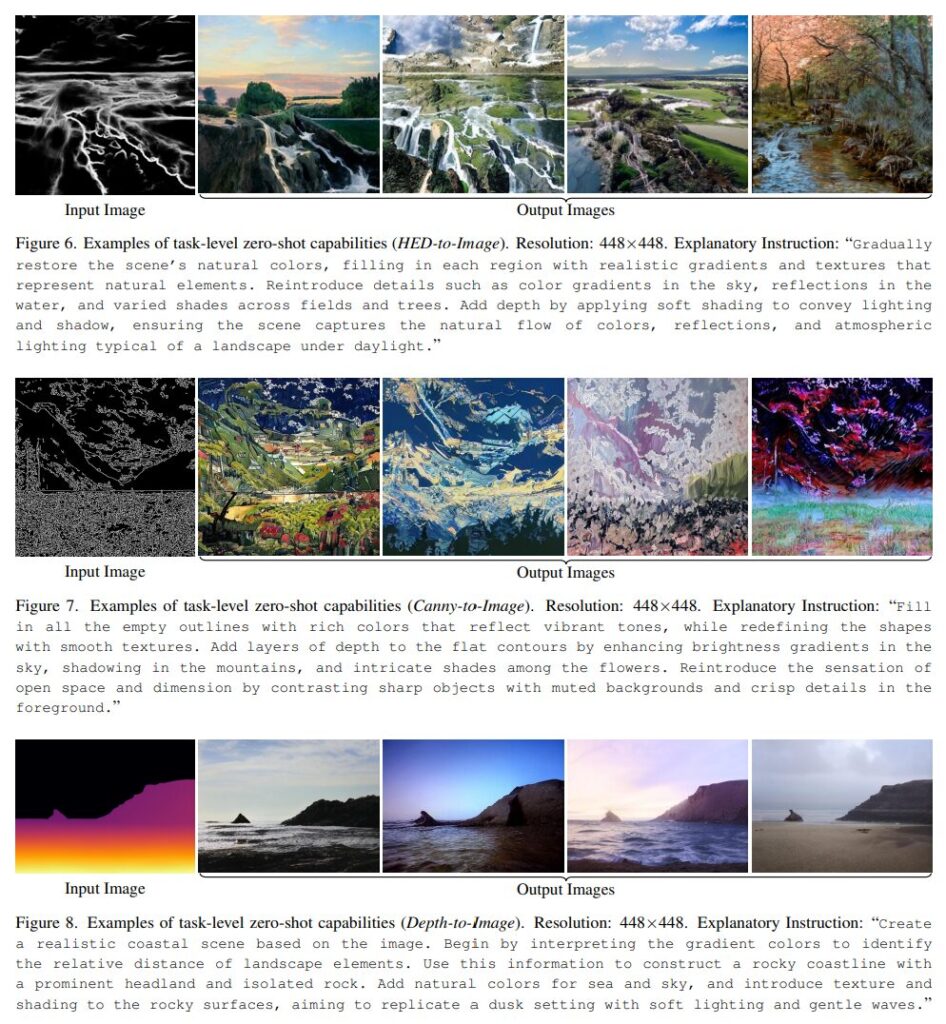

論文では、視覚タスクを統一して理解し、ゼロショット汎化を目指すモデルが提案されています。実験では、さまざまな視覚タスクに対するモデルのゼロショット能力を検証しています。このモデルは、指示に従って異なるタスクを実行できるように設計されており、指示をテキストとして利用し、音声や画像を処理します。

実験では、画像の鮮明化や詳細の強調といった視覚タスクに対して、指示によるタスク遂行を確認しました。さらに、他の複雑なタスクでもゼロショットでの対応力をテストしています。たとえば、画像のカラー調整や解像度変更を具体例として挙げ、指示がどのように視覚タスクの精度向上に寄与するかを示しています。

このアプローチでは、指示の形でモデルに新しいタスクを提示可能になるため、より柔軟かつ効率的な機械学習モデルの開発が期待されます。このようにして、モデルの適応力を活かし、さまざまな状況下でのタスク処理能力が向上しています。

まとめ

この論文では、視覚タスクの一般化能力を高めるための新しいアプローチについて紹介しています。視覚タスクでは、現在、説明付き方法の有効性が注目されています。このアプローチでは、タスクの目的を伝えるテキスト説明を用意し、モデルにその目的を理解させることを目指しています。

論文では、テキスト説明を視覚タスクに組み込むことで、ゼロショット学習の可能性を探求しています。具体的には、視覚とテキストのデータを組み合わせて学習を行い、新しいタスクに対しても適応可能なモデルを構築しています。この方法では約150万の説明付きデータペアを使用し、モデルに新しい能力を付与しています。

説明付きデータは、タスクの目的を明確にし、モデルがより柔軟に新しいタスクに対応できるようにする効果があります。また、説明による視覚タスクのゼロショット学習を可能にすることで、人間の指示により近い形でモデルを利用することが期待されています。

この研究により、テキストと視覚情報を効果的に組み合わせることで、視覚タスクの一般化能力と適応性を大幅に向上させる可能性が示唆されています。これにより、さまざまな視覚タスクにおけるモデルの汎用性が改善されることが期待されます。